作者简介:

张婉绮,硕士研究生,主要研究方向为人机智能交互系统、人体骨架抽取及动作分割.E-mail:sissi_sjtu@sjtu.edu.cn.

张婉绮,硕士研究生,主要研究方向为人机智能交互系统、人体骨架抽取及动作分割.E-mail:sissi_sjtu@sjtu.edu.cn.

王志永,博士研究生,主要研究方向为图像处理、面部特征点检测、凝视估计.E-mail:yzwang_sjtu@sjtu.edu.cn.

王志永,博士研究生,主要研究方向为图像处理、面部特征点检测、凝视估计.E-mail:yzwang_sjtu@sjtu.edu.cn.

刘洪海,博士,教授,主要研究方向为生物机电一体化、模式识别、智能视频分析、智能机器人.E-mail:honghai.liu@sjtu.edu.cn.

刘洪海,博士,教授,主要研究方向为生物机电一体化、模式识别、智能视频分析、智能机器人.E-mail:honghai.liu@sjtu.edu.cn.

眼睛中心定位技术无法摆脱图像分辨率较低、光照条件较差、侧脸及眼睛状态不定等问题对定位精度的影响.为了解决这一问题,文中提出改进的支持向量回归(SVR)的眼睛中心定位方法,基于面部特征定位中心,同时尝试几种图像预处理技术,用于提高定位精度.实验表明,结合高斯滤波器的SVR可以获得较好的中心定位精度.

About the Author:ZHANG Wanqi, master student. Her research interests include human-machine inte-lligent system, skeleton extraction and action segmentation.

WANG Zhiyong, Ph.D candidate. His research interests include image processing, facial feature points detection and gaze estimation.

The accuracy of eye center localization is reduced due to the low resolution of input image, poor lighting condition, side face and eyes status. To handle this issue, an improved support vector regression (SVR) method is proposed to detect the eye center based on the facial feature localization. Several image processing techniques are tried to improve the accuracy. Results show that the SVR combining a Gaussian filter achieves a better accuracy.

视线估计可描述人的注意力或传达意图, 在人类相互交流中的作用至关重要.视线估计技术在人机接口、虚拟现实等多个领域的应用前景非常广阔.准确的虹膜中心定位是进行视线估计的基础.

虹膜中心定位的方法通常分为两类:基于模型的方法和基于形状的方法.

基于模型的方法, 也称为基于特征的方法, 原理是使用眼睛的一些特点检测眼睛中心, 如虹膜的几何形状特征及其边缘处亮度的显著变化.Daugman[1]提出积分微分算子(Integro-Differential Operator, IDO), 利用虹膜和巩膜之间的像素突变进行瞳孔中心定位, 对高分辨率的图像具有良好的虹膜中心定位结果.Cai等[2]通过优化内核数量修改IDO, 在对低分辨率脸部图像进行眼睛中心定位时获得较理想的准确度.针对虹膜的形状, 霍夫变换算法也常应用于眼睛中心定位技术[3].Timm等[4]通过计算图像中每个点梯度的平均值, 得到简单有效的眼睛中心定位方法.此外, 瞳孔的颜色、镜像对称性等特征均可用于定位虹膜中心[5, 6].大多数基于模型的瞳孔中心定位方法在处理高分辨率图像时性能良好, 但图像质量降低对结果影响较大, 复杂环境、不良光照、头部姿态、闭眼等导致精度显著下降.

基于形状的方法在瞳孔中心定位中侧重考虑眼睛整体外观和眼部周围结构, 这就要求使用大量数据训练模型以达到良好的瞳孔中心定位效果.机器学习算法在瞳孔中心定位技术中使用广泛, Markuš 等[7]将一组随机回归树用于瞳孔中心定位.Everingham等[8]使用贝叶斯模型定位瞳孔中心.考虑到实际生活中眼睛多种多样的状态, Gou等[9]提出级联回归框架, 实现眼睛状态多变下的眼睛中心定位.基于外观的瞳孔中心定位方法需要大量的数据用于模型训练, 但在应用阶段即使图像处于低分辨率状态也能获得良好的定位结果.

尽管在过去的几年中虹膜中心定位技术取得一定进展, 但在自然光条件下, 图像分辨率较低、光照变化、眼部遮挡或闭眼等复杂情况一直是虹膜中心定位技术的重大挑战, 严重影响定位的精确度.如今, 人脸检测和面部特征点定位技术已成熟, 可基于人面部特征点提取眼睛区域并分析, 以提高虹膜中心定位的准确性和速度.如何在图像质量一般、人眼状态复杂的情况下对人眼中心快速准确定位仍是当前研究的一个难点.

针对这一问题, 本文提出结合高斯滤波和眼睛状态判断策略的改进支持向量回归(Support Vector Regression, SVR)方法, 试图提高虹膜中心定位方法的准确性和鲁棒性.目前, SVR[10, 11]已成功应用于面部特征点的检测[12], 并在OpenFace上已公开大量的源代码[13], 可有效抑制图像分辨率、光照和脸部朝向变化对定位结果准确度的影响, 提高定位鲁棒性.线性回归(Linear Regression, LR)是一种常用的回归方法, 可消除线性误差并提高精度.本文通过应用LR进一步提高眼睛中心定位模板的稳定性.

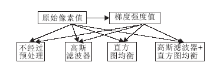

本文提出结合经典图像处理方法和机器学习算法定位眼睛虹膜中心的方法, 使用LFPW数据集[14]和HELEN数据集[15]训练基于人眼图像像素分布特点的模型.为了提高原始图像质量, 在训练支持向量回归模型和线性回归模型之前, 对图像进行预处理, 如高斯滤波、直方图均衡、梯度处理等.具体框架如图1所示.

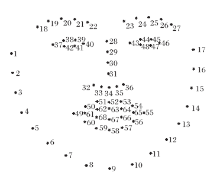

本文使用LFPW、HELEN数据集训练瞳孔定位模型.LFPW的训练集包含811幅格式为PNG的人脸图像, 测试集包含224幅PNG人脸图像.HELEN数据集包含2 000幅格式为JPG的图像和330幅测试图像.这两个数据集公认为是人脸特征点定位模型训练最全面的数据集, 因为其提供的训练数据中人脸具有不同肤色、种族、年龄、状态、背景外, 图像本身质量也是大不相同.同时, 数据集也提供面部的68个特征点, 它们的分布如图2所示.

为了收集对人眼中心定位的训练数据, 手动标记2个数据集中每幅图像的瞳孔中心, 获取二维坐标.为了便于后续的操作, 将所有图像通过双线性插值统一为400× 400大小, 并转换为灰度图像.另外, 还通过镜像操作使所有图像增加训练数据.

1.2.1 提取训练样本

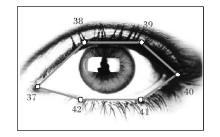

读取数据集中灰度图像和面部68个特征点数据, 从面部特征点可容易得到眼睛所在区域, 如右眼巩膜可见区域与点37~42相对应.37为内眼角特征点, 40为内眼角特征点, 38和39为上眼睑边缘点, 41和42为下眼睑边缘点, 具体分布如图3所示.同理点43~48为左眼巩膜区域对应的特征点.巩膜边缘的六边形区域是眼睛中心定位的目标区域, 下面以右眼为例解释这种定位方法.

首先获取兴趣区域.使用点37和点40的水平坐标计算内外眼角之间的距离.为了便于处理, 提取正方形区域为兴趣区域, 边长等于内外眼角的距离, 中心为点37和点40的中点, 正方形区域大小通常为27× 27.为了更好地提取不同状态下人眼虹膜的特征, 使用双线性插值法将兴趣区域放大至51× 51, 放大后的虹膜半径为约10~12像素.为了使搜索模板完全包含虹膜, 使用25× 25的模板对51× 51的区域进行采样, 可提取总共27× 27个样本.对于训练标签, 如果把眼睛中心定位作为一个分类问题, 则真正的瞳孔中心将会是唯一的正样本, 其余的位置都是负样本, 训练数据严重不均衡, 不利于模型的训练.针对这一问题, 本文使用高斯分布生成训练样本的标签.

将高斯分布的中心(0, 0)定为虹膜的实际中心, 该点的方差等于1.将高斯分布的响应值作为样本标签, 样本的中点距离虹膜中心越远则其标签越接近0, 相反地, 样本的中心靠近虹膜中心时其标签接近1.此时二元分类问题转化为一种模糊问题, 即解决正样本和负样本不平衡的问题.由于已获得眼睛周围6个特征点的实际坐标, 虹膜中心只可能存在于六边形内, 因此可使用以6个特征点为顶点的六边形, 缩小采样范围, 仅保留六边形内部坐标点的标签, 将所有外部坐标点的标签都设置为0, 最后丢弃标签为0的样本, 进一步提高样本的相关性.完成此步骤后, 获得用于训练模型的样本数据集.

用于训练模型的输入特征有两种:原始像素值和通过与Soble算子卷积计算得到的梯度强度值.为了简化计算并提高速度, 使用绝对值相加策略以近似梯度.具体计算方法如下:

Gx=

Gy=

G=

同时, 本文尝试两种经典的图像处理方法, 即高斯模糊和直方图平衡, 用于提高原始图像的质量.高斯滤波器用于平滑感兴趣区域, 消除高斯噪声并忽略一些细节.直方图均衡有利于改善图像的对比度, 尤其是集中像素分布特点的图像.本文共尝试4种方法:不经过预处理、高斯滤波、直方图均衡、高斯滤波和直方图均衡, 如图4所示.相应地, 处理后的眼部周围区域如图5所示, 在图5中, 左图为原始图像, 右图为梯度图像.

1.2.2 训练模型

将样本数据分为如下3部分.

1)80%用于训练SVR模型, 输入为样本及标签, 可获得625维的SVR模型ω .

2)为了进一步提高模型的准确性, 将10%的样本数据用于训练LR模型, 输入数据为训练好的SVR模型ω 、样本patch和标签label, 输出拟合参数a和b.具体计算方法如下.令

y=ax+b,

其中

x=ω · patch, y=label,

结合SVR和LR, 拟合得到参数a和b, 即得到一个627维的模型.

3)剩余的10%样本数据集用于计算模型的误差和相关性:

response=-

其中, x为625个维度中样本的像素值, 响应在0~1内.通过标签和响应可计算均方根误差(Root Mean Square Error, RMSE)和相关性.

为了评估1.2节得到的模型, 使用2个用于测试虹膜中心定位常用的公开数据库Gi4e[16]和BioID[17], 对基于本文算法训练的模型进行瞳孔中心测试评估.

Gi4e数据库包含1 236个样本, 涵盖103个对象及12个视线方向, 图像的分辨率为800× 600.BioID数据库在定位瞳孔中心时具有一定的挑战性, 因为图像的分辨率仅为384× 288, 相对较低.BioID库包含1 521幅灰度图像, 涵盖多种实际情况, 如较差的光照条件、配戴眼镜、闭眼等.

基于人脸特征点提取兴趣区域并放大到51× 51, 之后通过训练好的模型(25× 25)去卷积兴趣区域, 计算729个测试样本的所有响应.由于输入图像的质量存在差异, 并且人眼的状态不明(睁眼和闭眼), 设定一个默认的阈值γ =0.15.如果最大响应大于γ , 选择具有最大响应的位置作为检测到的眼睛瞳孔中心.相反, 如果最大响应小于γ , 取一个预设的位置作为眼睛中心, 这里预设的中心位置与6个眼部特征点位置相关.

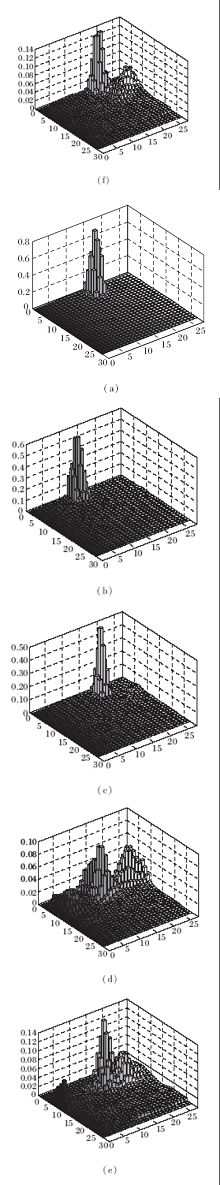

图6为一些测试图像的响应分布图.

图6(a)~(c)有明显的响应突变点, 因此将该最大响应所处的位置定为眼睛瞳孔中心, 而(d)~(f)中的最大响应值较小, 响应分布不够集中, 此时, 将预设位置作为瞳孔中心.

Jesorsky等[17]提出虹膜中心定位的精度计算方法, 后默认为标准计算方式以衡量算法的精度.考虑到不同个体之间两只眼睛的差异, 将归一化误差设定为评估标准, 计算方法如下:

e=

其中, dl和dr分别为检测到的虹膜中心与左眼和右眼的实际虹膜中心之间的欧氏距离, d为两只眼睛实际虹膜中心之间的欧氏距离.

对图像预处理可有效改善图像质量, 如高斯滤波器可消除高斯噪声, 直方图均衡可提高图像对比度.本文使用这两种方法, 试图提高瞳孔中心定位的精度.此外, 梯度特征通常用于寻找物体边界, 由于虹膜区域内外之间的明显差异, 利用梯度特征为检测虹膜边界的合理方法.

表1显示在Gi4e数据库中使用多种图像处理方法分别得到的定位结果.可发现, 无论使用哪种图像处理方法, 使用原始像素得到的定位结果都优于使用梯度信息, 只有使用高斯滤波器才能获得比使用原始像素值更好的定位精度.虽然直方图均衡可以改善图像对比度, 但对于本文使用的定位方法直方图均衡对结果没有产生任何改善.

实验结果同时表明, 在图像分辨率较高时, 本文使用的任何方法都能准确定位眼睛瞳孔中心, 使用经过高斯滤波器的样本数据得到的精度最佳.在BioID数据集中也可得到类似的结论.在Gi4e的数据集中, 眼球中心定位的准确度达到96.84%, 可以满足视线估计和眼球追踪等应用的要求.图7给出一些眼睛中心定位的结果.

| 表1 Gi4e数据库中使用多种图像处理方法得到的最大标准误差 Table 1 Maximum standard errors obtained by multiple image processing methods on Gi4e database |

表2显示相同评估标准下各方法的定位结果准确度.

| 表2 相同评估标准下各方法的定位结果准确度对比 Table 2 Accuracy comparison of positioning results of different methods under the same evaluation criteria |

当误差小于0.05时, 本文方法的定位准确度虽然不高, 但也与其它结果相差无几.在误差小于0.1的前提下, 本文方法定位精度达到98.7%, 在目前精度最高.

为了验证本文方法的泛化能力及图像质量、人脸状态等的鲁棒性, 在LFPW数据集上进行测试, 定位结果如表3所示.相比文献[6]、文献[18]~文献[22]中提到的研究结果, 尽管此结果不是很理想, 但在可接受的定位准确度下具有鲁棒性.

| 表3 在LFPW数据集中测试所得结果 Table 3 Results of testing on LFPW dataset |

本文提出基于外观的使用改进SVR的眼睛中心定位方法.虽然在当前的研究中无法获得最高的准确度, 但对于眼部状态多变及质量较低的测试图像仍具有可靠的定位精度.另外, 本文尝试使用高斯滤波和直方图均衡化以提高定位的准确性.结果表明, 像素梯度特征的使用和直方图处理对基于SVR的定位方法无任何改进, 但使用高斯滤波器可以较好提高基于SVR的眼睛中心定位的准确性.今后将进行更准确的眼睛状态检测, 改进定位算法, 提高特殊眼睛状态下的定位准确度.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|