通讯作者:

王延召,博士研究生,主要研究方向为计算机视觉、显著性目标检测.E-mail:wangyznwpu@163.com.

王延召,博士研究生,主要研究方向为计算机视觉、显著性目标检测.E-mail:wangyznwpu@163.com.

作者简介:

彭国华,博士,教授,主要研究方向为图形图像处理、计算机辅助几何设计.E-mail:penggh@nwpu.edu.cn.

彭国华,博士,教授,主要研究方向为图形图像处理、计算机辅助几何设计.E-mail:penggh@nwpu.edu.cn.

延伟东,博士,副教授,主要研究方向为遥感图像的配准、分类及变化检测等.E-mail:yanweidong@nwpu.edu.cn.

延伟东,博士,副教授,主要研究方向为遥感图像的配准、分类及变化检测等.E-mail:yanweidong@nwpu.edu.cn.

为了进一步提高显著性目标检测的准确性,提出基于不同特征流形排序和联合连通性先验的显著性检测算法.针对现有基于流形排序的算法在图的构建中存在的边权重计算和顶点的连接问题,使用不同种特征计算顶点间边的权重,并且改进顶点的连接方式,得到流形排序显著图.同时结合边界连通性先验和前景连通性先验得到联合连通性先验显著图.在不同尺度下进一步融合两种显著性结果,得到最终的显著图.通过与16种算法在4种数据集上的对比表明,文中算法可以得到更清晰、准确的检测结果.

About the Author: PENG Guohua, Ph.D., professor. His research interests include image processing and computer aided geometric design.

YAN Weidong, Ph.D., associate professor. His research interests include image registration, classification and change detection of remote sensing image.

To improve the performance of saliency detection, a bottom-up saliency object detection model is proposed by integrating different features based manifold ranking and co-connectivity. Aiming at the calculation on edge and connection bewteen nodes of the graph in most manifold ranking based models, a manifold ranking based salient map is produced via different features to calculate the weight of edges and modified connection to construct the graph. Simultaneously, the co-connectivity based salient map is obtained by incorporating boundary connectivity and foreground connectivity. The final saliency map is achieved through fusing these two salient results with different scales. Compared with 16 state-of-the-art methods on four public benchmark datasets, the proposed algorithm performs better.

随着科技的快速发展, 人们在生活中需要处理大量的视觉信息.视觉注意机制能够快速过滤冗余信息并抓住主要目标.为了使计算机也具备这种处理能力, 学者们提出显著性检测研究.由于能够模拟人类视觉注意机制, 近年来, 显著性检测成为计算机视觉领域的热点问题.

显著性检测模型通常可分为视觉注视点(Eye Fixation)检测[1, 2]和显著性目标(Salient Object)检测两种[3, 4, 5, 6, 7, 8, 9].前者主要预测人眼观察图像时注视点的坐标, 对于理解人类注意机制具有重要作用.后者主要预测显著性目标整体, 即图像中显著目标所在区域, 已用于图像分割、目标识别、图像压缩和图像检索等领域.显著性目标检测又可分为自底向上、数据驱动型[1, 3, 5, 6, 8]和自顶向下、目标驱动型[7, 9].本文主要研究自底向上、数据驱动型的显著性目标检测.

近年来, 国内外研究者提出许多视觉显著性目标检测方法.受早期视觉系统神经元结构的启发, Itti等[1]将视觉显著性定义为局部中心与周边的差异, 提出基于多尺度图像特征融合的显著性模型, 融合不同尺度下颜色、亮度、方向等特征.自此以后, 显著性检测研究得到快速发展.Goferman等[10]基于心理学四条准则, 提出基于上下文的显著性检测方法.Achanta等[11]假设目标尺度, 通过变换中心-周边滤波的带宽以检测显著性目标.上述模型大多基于单个像素进行计算, 计算量较大, 容易使检测结果只突出目标边缘而造成目标中心空洞等问题.

为了减少算法计算量并提高显著性目标检测的效果, 基于超像素的检测模型得到广泛关注.Jiang等[12]结合目标形状和人眼激励等先验信息, 提出基于迭代的能量最小化的显著性检测模型.Duan等[13]通过减少区域的特征维数, 并结合中心先验及图像区域的空间距离和相似度以估计目标的显著度.Cheng等[8]通过对整个图像超像素间的特征相似性和空间一致性进行估计, 得到显著性计算结果.由于显著性目标区域与背景区域在色彩上存在差异, Kim等[14]通过对高维色彩空间进行线性组合的方式得到显著图.Jiang等[15]通过结合独特性(Uniqueness)、聚焦性(Focusness)和目标性(Objectness)进行显著性目标检测.上述方法在背景较统一的图像中表现较好, 但当图像背景较复杂时, 检测结果较差.

另外, 一些模型利用其它算法进行显著性目标检测.Lu等[16]提出基于编码的显著性测量方法, 首先通过全局对比底层特征得到自底向上的显著图, 然后利用局部限制性线性编码算法得到自顶向下的显著图, 最后将两种显著图融合得到最终的显著性测量.基于背景先验方法, Wei等[17]将显著值的计算表示为图像某个超像素与边界超像素的最小测地线距离.Wang等[18]通过选择背景和前景节点得到不同检测结果, 然后将两者融合得到最终的显著图.这些基于背景先验的检测方法能够检测大多数图像中的显著性目标, 但对于目标区域与边界相连的图像检测效果较差.为了解决这个问题, Zhu等[19]提出边界联通性(Boundary Connectivity)先验, 并结合其它显著性特征, 通过优化算法得到显著图.在流形排序(Manifold Ranking, MR)算法基础上, Wang等[20]在不同尺度上通过结合紧致性先验、对比先验和边界连通性先验得到显著性检测结果.

尽管学者们已提出大量的显著性目标检测模型, 但是检测的准确性仍需提高.本文提出基于不同特征流形排序和联合连通性先验的显著性目标检测算法.给定一幅图像, 首先应用简单线性迭代聚类(Simple Linear Iterative Cluster, SLIC)算法[21]对其进行不同尺度的分割.再利用多种特征和改进的连接方式构建无向加权图, 经过流形排序得到基于不同特征的显著图.然后融合边界连通性和前景连通性先验得到新的联合连通性先验.最后在四种尺度下进一步融合两种显著性结果, 得到最终的显著图.实验表明本文算法性能较优.

Zhou等[22]提出流形排序算法.Yang等[23]将流形排序算法应用于显著性检测之中.流形排序主要是通过构建一个图模型, 选择一部分节点作为查询节点, 然后根据某个节点与这些查询节点的关系进行排序, 从而探究整个数据的结构.

在显著性目标检测中, 对于一幅图像, 首先利用SLIC[21]分割为N个超像素V=

然后基于这些超像素建立一个无向加权图G(V, E).在图G的构建中, 对于每个超像素i, 连接其邻接超像素及与这些邻接超像素共享边界的超像素, 并将与图像边缘邻接的超像素也相互连接, 从而得到邻接矩阵(Adjacent Matrix)M:

mij=

其中Ni表示与超像素i相连的超像素集合.现有的基于流形排序的显著性检测方法大多使用超像素的均值颜色向量作为特征进行相似度权重矩阵A的计算, 即

aij=exp(-

其中, σ 为尺度参数, dij为区域i和区域j间颜色距离.因此, 区域间的关联矩阵W可表示为

wij=mij· aij.

在图的构建过程中存在2个问题.一方面, 在对超像素进行特征描述时常使用单一的颜色描述子, 当目标和背景在颜色空间上区别较大时检测效果较好, 但当目标和背景在颜色空间上较相似时检测效果较差.另一方面, 关联矩阵连接时常不加区分地使某个超像素与其邻接超像素相连.当这个超像素处在目标或背景区域中间时可以较好反映超像素之间的关系, 但当该超像素处在目标和背景边界时, 就会出现目标上的超像素与背景上的超像素相连接的现象, 不能较好表示超像素之间的空间关系.

针对上述问题, 本文提出基于不同特征流形排序的显著性检测算法.不同于文献[23]中方法MR, 本文在MR的基础上, 通过增加特征描述子和改进关联矩阵的连接方式解决上述问题.首先, 选择CIELab颜色值距离及其直方图距离构建新的权重矩阵A':

a'ij=exp(-

其中

dcij=

为欧氏距离,

dhij=χ 2(h1, h2)=

为χ 2距离, ci和cj分别对应超像素i和j的CIELab均值, bin为直方图的维数, 在本文中设定为bin=256(3个通道分别是L∶ 4, a∶ 8, b∶ 8).

和文献[24]的连接方式不同, 对于超像素i, 根据与之相连的超像素间的相似度权重改进邻接矩阵.首先求得均值:

ma'i=

其中n(Ni)表示与超像素i连接的超像素的个数.然后根据均值得到改进后的邻接矩阵M':

m'ij=

最后, 新的关联矩阵(Affinity Matirx)W'可以表示为

w'ij=m'ij· a'ij.

本文分别以图像四条边界作为查询节点, 通过关联矩阵W'进行流形排序, 得到各自对应的显著图, 然后通过进一步相乘得到基于不同特征流形排序的显著性检测结果.以图像上边界为例, 设定与之相连的超像素标签值li=1, 而图像中其它超像素的标签值lj=0, 得到相应的N维标签向量

L=[l1, l2, …, lN].

通过最优化下式进行流形排序:

E=arg

其中μ 用于平衡光滑项(第1项)和约束项(第2项).最小化上式, 可得

f=(D-α W')-1L, (1)

其中

α =

为W'的度矩阵,

di=

根据式(1)得到流形排序向量f, 元素值大小反映对应的超像素与上边界超像素的相似度.对f进行归一化, 则基于上边界超像素的显著图BSt为

BSt(i)=1-f(i), i=1, 2, …, N.

按照上述方式, 得到其它基于底边界、左边界和右边界超像素的显著图:BSb, BSl, BSr.通过进一步整合得到最终的显著性检测结果MR1:

MR1(i)=BSt(i)· BSb(i)· BSl(i)· BSr(i).

为了能够描述超像素间相似性及空间上的紧凑性(Compactness), 选择CIELab颜色距离和超像素空间距离, 按照MR1构建方式, 得到新的显著性检测结果MR2, 其中权重矩阵定义为

a″ij=exp(-

其中, dcij同上述定义,

dsij=

ri、rj分别表示超像素i、 j的均值坐标.通过融合MR1和MR2, 可以得到基于不同特征的流形排序显著图:

MMR(i)=MR1(i)· MR2(i).

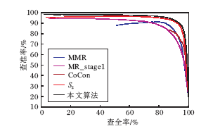

多特征流行排序(Multi-feature Based Manifold Ranking, MMR)与文献[23]方法MR_stage1都利用基于四条边界的流形排序方法, 不同的是MMR采用多种特征, 而MR_stage1采用单一特征.

Zhu等[19]提出的边界连通性(Boundary Conne-

ctivity)先验能够解决图像边界区域被显著性目标遮挡的情况, 进一步提高基于边界的显著性检测效果.通过连接相邻超像素(p, q)建立无向加权图, 权值定义为CIELab空间的欧氏距离dapp(p, q).超像素p和q间的测地线距离(Geodesic Distance)定义为p到q的最短路径:

dgeo(p, q)=

其中dapp(p, p)=0.原始的边界连通性定义为目标和边界重合的长度与目标面积开方的比值.然而重合的长度和目标面积未知, 因此, 为了简化计算, 在文献[19]中, 超像素p的面积近似为

Area(p)=

其中尺度参数设定为δ =10.超像素p与边界连接的长度近似为

Lenbnd(p)=

其中, 当超像素pi与边界连接时η (pi)=1, 其它情况下为0.因此, 超像素p的边界连通性先验定义为

BndCon(p)=

基于边界连通性先验, 本文提出与之对应的前景连通性先验(Foreground Connectivity).首先根据边界连通先验得到显著图

Sb(i)=1-BndCon(i),

并对其求均值, 得到阈值

m_Sb=

然后选择大于阈值m_Sb的超像素作为种子节点, 代替边界连通性先验(BndCon)中边界节点进行连通性先验计算, 得到基于前景的连通性先验ForgCon.最后, 通过融合边界连通性先验和前景连通性先验, 得到基于联合连通性先验的显著图CoCon:

CoCon(i)=(1-BndCon(i))· ForgCon(i).

为了进一步融合2种显著图, 提高显著性检测的准确性, 本节对上述2种显著图进行均值化处理:

R(i)=

其中

S1(j)=MMR(j)· CoCon(j).

然后对R进行截断以减少嘈杂背景的影响:

R(i)=

最后与中心先验(Center Prior, CE)结合并进行流形排序, 得到改进后的显著图:

S2=(D-α W)-1(R(i)(1-CE)),

其中

CE(i)=‖ meanPos(i)-c‖ 2,

meanPos(i)表示超像素i的均值坐标(由区域内像素坐标求均值得到), c为图像中心坐标.

图1为算法各部分对比.

从图1中可以看出, MMR通常情况下能够突出目标, 但是当目标和背景相连时会让检测结果出错.CoCon能够较好地检测目标区域, 但同时也会突出背景中的一些区域.相反, S2能够较好抑制背景区域, 但对目标区域的检测结果差于CoCon.

如图1所示, 三者具有互补性, 因此整合三者可以得到更好的显著图:

F(i)=exp(MMR(i))· exp(CoCon(i))· S2(i).

图2为算法各部分在ASD数据集上的对比.由图可知, MMR的检测性能优于MR_stage1, 相比MMR和CoCon, 改进后的显著图S2在检测准确性上具有较大幅度提升.

另一方面, 不同图像中目标形状不同, 大小不统一, 单一尺度的模型不能完整检测各种显著目标.为了提高显著性检测的鲁棒性, 将算法应用于不同的尺度进行融合.经过多次对比测试, 最终确定将上述算法应用于4个不同分割尺度

N* ={200, 150, 100, 50},

得到4个不同的检测结果{

F=

图3为不同尺度在ASD数据集上的对比, 由图可以看出, 经过多尺度融合, 显著性检测的准确性具有进一步提升.

实验平台系统为Windows10, 软件为Matlab2014a, 内存为4 GB, 处理器为Intel(R) Core(TM) i5, 主频为3.2 GHz.

为了验证算法有效性, 在MSRA10k[8]、ASD[25]、DUT_OMRON[23]和ECSSD[26]4个数据集上进行对比.实验对比算法包括基于区域的对比模型(Region Based Contrast, RC)[8], 基于直方图的对比模型(Histogram Based Contrast, HC)[8], 情景感知模型(Context-Aware, CA)[10], 最大对称环绕模型(Maximum Symmetric Surround, MSS)[11], 上下文和目标级形状先验模型(Context and Object-Level Shape Prior, CB)[12], 空间加权不相似性模型(Spatially Weighted Dissimilarity, SWD)[13], 基于全局和局部线索的显著性目标检测(Salient Object Detection via Global and Local Cues, SDGL)[16], 基于测地线距离的显著性检测模型(Geodesic Saliency, GS)[17], 鲁棒的背景检测模型(Robust Background Detection, RBD)[19], 显著性滤波模型(Saliency Filters, SF)[27], MR[23], 最小障碍物距离显著性目标检测(Minimum Barrier Salient Object Detection, MBD)[28], 稠密与稀疏重建误差模型(Dense and Sparse Reconstruction Error, DSR)[29], 基于扩散的紧致度和局部对比度模型(Diffusion-Based Compactness and Local Contrast, DCLC)[30], 结构化分解模型(Structured Matrix Decomposition, SMD)[31]和基于紧致性和前景连通性的显著性目标检测(Salient Object Detection Based on Compactness and Foreground Connectivity,SDCF)[32].

MSRA10k数据集包含10 000幅图像, 图像种类较多, 大多数的显著性检测算法都采用此数据集进行对比.ASD数据集包含1 000幅图像, 为MSRA10k数据集的子集, 在本文中用作算法自身各部分的对比.DUT-OMRON数据集中的图像包含不同数量和不同尺度的目标, 相比ASD和MSRA10k更丰富.ECSSD数据集包含1 000幅语义丰富但结构复杂的图像, 在4个数据集中最具挑战性.这些数据集中的

所有图像都由人工标注显著性区域, 以便客观评价算法性能.

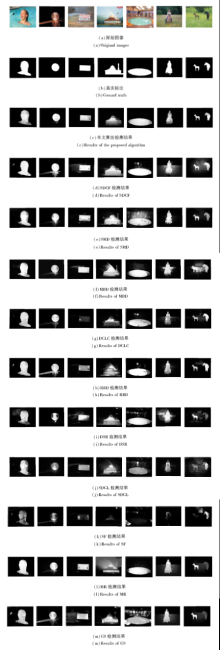

为了从视觉上验证算法的有效性, 本文算法与近年来提出的10种算法进行对比, 结果如图4所示.第1~3幅图像来自MSRA10k数据集, 从对比结果可以看出, 本文算法可以较好地检测目标和抑制背景.第4、5幅图像来自DUT-OMRON数据集, 虽然本文算法检测的目标不太完整且存在对背景的误检, 但优于其它算法的检测结果.第6、7幅图像来自ECSSD数据集.从结果可以看出, 相比其它算法, 本文算法能更好地抑制背景的伪影, 检测较完整的目标.

| 图4 11种算法在不同数据集上的检测结果对比Fig.4 Comparison of the proposed model and 10 state-of-the-art models on different datasets |

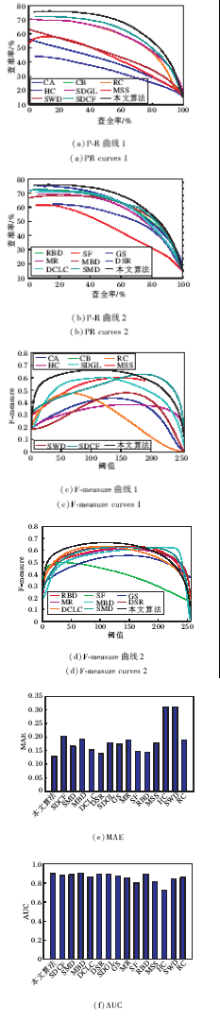

为了对实验结果进行定量对比, 本文采用查准率-查全率(Precision-Recall, PR)曲线、平均绝对误差值(Mean Absolute Deviation, MAE)、F值(F-measure)、受试者工作特征曲线下面积(Area Under Curve, AUC)和耗时5种评价指标.

PR 曲线首先将显著性检测结果F(i)转化到[0, 255]的范围, 然后在[0, 255]的范围内取不同的阈值, 得到在不同阈值下的掩膜, 并与真实二值图像对比, 得到各自的查准率和查全率.通过在不同阈值下求得所有图像查准率和查全率值的均值, 并以查全率为横坐标、查准率为纵坐标得到这些均值的连接曲线.

MAE计算F(i)中每个像素与真实二值图像G相应像素误差的均值:

MAE=

其中W、H分别表示图像的宽、高.

MAE主要衡量F(i)与真实二值图像的相似度, 对于图像分割和裁剪都具有意义, 也是对P-R曲线的有效补充.

F-measure定义为

Fβ =

其中β 2通常取值为0.3 [12, 14, 24].F-Measure是查准率和查全率的调和, 也是P-R曲线的一种互补评价标准.

较好的检测结果中AUC值接近1, 而随机赋值的结果中AUC值趋向0.5.

图5为17种对比算法在MSRA10k数据集上的对比结果.从图中可以看出, 本文算法的P-R曲线与SDCF几乎重合, 优于其余算法, 尤其是近年来的一些算法, 如RBD、MBD、DCLC和SMD.从F-measure曲线可以看出, 相比其它16种算法, 本文算法在[0, 100]区间上能够取得较好结果.本文算法的MAE值稍差于RB、SDCF和SMD, 但优于其它算法.本文算法的AUC值在对比算法中能够取得最大值, 优于其它算法.

图6为17种算法在DUT-OMRON数据集上的对比结果.从图中可以看出, 本文算法的P-R曲线和F-measure曲线几乎都在其它算法的曲线之上, 由此说明本文算法在这两种评价指标上明显优于其它算法.同样, 在AUC值上, 本文算法也优于其它算法.虽然在MAE值上, 本文算法稍差于DSR, 但在其它3项指标上都优于DSR.

图7为17种算法在ECSSD数据集上的对比结果.

与在MSRA10k数据集上的结果类似, 本文算法除了在MAE指标上稍差于DSR和RBD, 在其它评价指标上都能取得较好结果.

表1为8种算法在ASD数据集上关于单幅图像的平均运行时间对比.本文算法因为融合不同尺度下的结果, 耗时增加.对比SDCF、SMD、DCLC、RBD和MR, 本文算法耗时较长, 但本文算法结果优于这些算法.对比SDGL和DSR, 本文算法在检测准确性和时间上都优于两者.

| 表1 8种算法的平均运行时间对比 Table 1 Comparison of average running time of 8 algorithms |

总之, 在5种指标上, 本文算法在4个数据集上都能取得较好结果, 由此证明本文算法在显著性目标检测上的有效性.

现有基于流形排序的显著性检测算法在图的构建中存在使用单一特征构建权重矩阵、使用简单连接构建邻接矩阵等问题, 通过应用不同特征及改进的连接方式, 得到基于不同特征的流形排序显著性检测结果, 同时联合边界连通性及前景连通性两种先验得到基于联合连通性的显著性检测结果.另一方面, 在不同尺度下, 通过增加中心先验融合两种显著性检测结果, 进一步提升算法的检测准确性.在4个数据集上的测试结果表明本文算法的鲁棒性.好的先验特征能够进一步提高显著性目标检测的准确性, 因此, 构造更具鲁棒性的先验特征将是未来研究的重点.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|