通讯作者:

王飞跃,博士,研究员,主要研究方向为智能系统和复杂系统的建模、分析与控制.E-mail:feiyue.wang@ia.ac.cn

作者简介:

苟超,博士, 助理研究员,主要研究方向为计算机视觉、模式识别、机器学习.E-mail: chao.gou@ia.ac.cn.

王建功,博士研究生,主要研究方向为计算机图形学、医学图像处理、机器学习.E-mail:wangjiangong2018@ia.ac.cn.

沈甜雨,博士研究生,主要研究方向为计算机视觉、医学图像处理、机器学习.E-mail:shentianyu2016@ia.ac.cn.

郑文博,博士研究生,主要研究方向为计算机视觉、医学图像处理、机器学习.E-mail:zwb2017@stu.xjtu.edu.cn.

于慧,博士,教授,主要研究方向为人脸分析、人体运动分析、人机交互.E-mail:hui.yu@port.ac.uk.

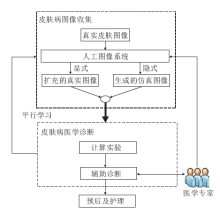

随着计算机与人工智能的快速发展,基于图像感知的皮肤病分析方法取得一些成果.然而,以深度学习为主的计算机辅助分析方法依赖于领域专家标注的医学大数据,诊断结果缺乏医学可解释性.为此,文中提出基于视觉的皮肤病分析统一框架——平行皮肤.启发于ACP方法与平行医学图像分析框架,通过构建人工皮肤图像系统实现数据选择与生成,通过预测学习的计算实验完成诊断分析模型构建与评估,并利用描述学习与指示学习融合专家知识,引导人工图像系统数据生成与选择,从而实现闭环诊断分析模型优化.

Corresponding author:WANG Fei-Yue,Ph.D., professor. His research interests include modeling, analysis, and control of intelligent systems and complex systems.

About the Author:GOU Chao, Ph.D., assistant professor. His research interests include computer vision, pattern recognition and machine learning.

WANG Jiangong, Ph.D. candidate. His research interests include computer graphics, medical image processing and machine lear-ning.

SHEN Tianyu, Ph.D. candidate. Her research interests include computer vision, medical image processing and machine lear-ning.

ZHENG Wenbo, Ph.D. candidate. His research interests include computer vision, medical image processing and machine lear-ning.

YU Hui, Ph.D., professor. His research interests include face analysis, human motion analysis and human-computer interaction.

With the rapid development of computer and artificial intelligence, image-based methods for skin analysis have achieved preferable results. However, the performance of computer aided diagnosis systems based on deep learning methods relies on big medical data labeled by domain experts. In addition, there is limitation of interpretability for the diagnosis results. To address aforementioned problems, a vision-based unified framework for dermatological analysis termed as parallel skin is proposed. Inspired by the ACP method and the parallel medical image analysis framework, the artificial skin image system to perform data selection and generation is constructed. Then, computational experiments are conducted with predictive learning for model building and evaluation. Descriptive and prescriptive learning to leverage the power of domain knowledge to guide data selection and generation are further introduced. In the proposed parallel-skin framework, the closed-loop diagnostic analysis model can be optimized.

皮肤病是发生在皮肤和皮肤附属器官疾病的总称.皮肤病病种繁多, 目前已知超过2000种皮肤病[1, 2], 很多皮肤病种之间及其相似, 即使有经验的专家也无法准确辨别.皮肤病的病因也较复杂, 外部环境、食物结构、遗传等都是致病因素.皮肤癌是皮肤病中危害尤为严重的一种常见恶性肿瘤, 它发生于头部、面部、颈部、下肢等部位, 多见于老年患者, 在美国每年就有540余万新增皮肤癌患者[3].黑色素瘤是一种致命皮肤癌, 虽然在美国皮肤癌患者中仅有大约5%的患者是黑色素瘤, 但是它造成皮肤癌致死人数的75%[1], 在欧洲每年有超过10万人被诊断为黑色素瘤, 有大约2.2万致死病例[4].我国虽为黑色素瘤低发区, 但随着环境污染加重与人们健康意识的增强, 确诊病例以每年3%至8%的速度增长.黑色素瘤在皮肤表面表现为色素性病变, 可以通过专家视觉检测进行早期检测, 但是易与黑色素痣等良性皮肤病混淆.皮肤病的早期诊断、早期治疗尤为重要, 特别是针对黑色素瘤的早期诊断治疗, 5年存活率可以由14%提高到99%左右[5].当前我国皮肤病诊断面临着病种繁多、病因复杂、皮肤科专家医生短缺的问题.

随着计算机普及与人工智能技术的快速发展, 以深度学习为核心的人工智能方法在图像分析、语音识别、自然语言处理等领域取得突破性成果[6].近年来, 深度神经网络方法逐步应用于医疗领域, 尤其在图像分析、电子病历管理、移动医疗等应用上取得开创性成果[7, 8].目前, 基于深度学习方法的皮肤病智能诊断是智能医疗的重要研究方向[1, 9, 10, 11].由于深度神经网络需要大量皮肤图像标注数据, 同时需要具有医学知识的皮肤科医生来标注, 因此, 对于医学皮肤数据采集及标注都是目前基于深度学习辅助皮肤诊断研究的难点问题.此外, 深度神经网络模型是一个“ 黑盒” 模型, 给定皮肤数据, 输出良恶性分类结果不具有医学可解释性.

2004年王飞跃[12]提出平行智能方法论, 核心是通过计算实验, 描述、预测并引导复杂系统现象, 通过整合人工社会、计算实验和平行执行(Artificial Societies, Computational Experiments, and Parallel Execution)的方法解决实际系统中不可预测、难以拆分、无法重复实验的复杂系统问题.经过10多年的发展, 平行智能的计算研究体系不断丰富和完善, 并在智能交通[13, 14, 15, 16, 17]、社会计算[18, 19, 20, 21, 22]、视觉感知[23, 24]、智慧医疗[25, 26, 27, 28]、智慧教育[29, 30]等领域取得良好效果.针对目前基于计算机皮肤智能诊断领域存在的难点问题, 本文提出基于平行智能方法的皮肤病智能分析框架, 为皮肤病诊断应用实现可解释性推理问题提供一个统一的解决框架.

基于ACP的平行智能方法[12]最早由王飞跃提出, 试图解决复杂系统的建模与控制问题, 分为人工社会(Artificial Societies)、计算实验(Computational Experiments)、平行执行(Parallel Execution)三部分.它进一步定义为一种基于真实与虚拟系统交互并执行的智能方法, 可以实现描述、预测与引导智能[18, 19].本文将ACP方法进一步推广于视觉感知领域[23], 提出平行视觉方法[23, 31, 32], 通过人工场景、计算实验、平行执行以实现基于视觉的复杂场景感知与理解.而已有的基于虚拟图像的学习方法[33, 34, 35]为平行视觉的虚拟人工场景与计算实验部分.平行执行的目的是构建一个闭环, 实现虚实互动在线模型优化[15].

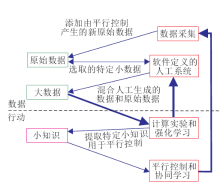

平行学习是一个新型机器学习框架, 在描述、预测与指示学习基础上, 将数据、知识、行动整合于一个闭环系统, 目的是解决目前机器学习方法中数据收集、策略选择受限的问题[36].平行学习大致可以分为描述学习(Descriptive Learning)、 预测学习(Pre-dictive Learning)、指示学习(Prescriptive Learning)三个互相耦合关联的阶段.平行学习通过描述学习得到与真实数据分布一致的生成模型, 通过预测学习从数据中蒸馏知识, 通过指示学习根据不断增长的知识引导系统训练与测试评估, 从而实现优化.对抗学习是平行学习一种特殊实现形式[36].平行学习已在自动泊车规划等领域得到应用[36, 37].

| 图1 平行学习框架[36]Fig.1 Framework of parallel learning |

平行医学图像是最近提出的一种医学图像分析框架[38].与传统自然图像分析不同, 医学图像分析需要融合专家领域知识, 由此, 平行医学图像将医学图像数据、专家领域知识整合于一个系统中, 提出“ 数据驱动+知识驱动” 的双向平行进化优化, 从而解决医学影像数据收集耗时费力且不具有可解释性的难点问题.从数据驱动角度出发[39], 该框架提出从实际临床医学场景中获取特定的医疗图像“ 小数据” , 输入构建的人工医学图像系统, 生成大量人工图像数据.原始特定的图像“ 小数据” 与生成的数据构成解决复杂医疗图像分析问题所需的“ 大数据” 集合, 用于诊断模型的学习与评估, 从而实现医学“ 小知识” 的提取.反之, 从知识驱动角度出发, 启发于人在环路的混合增强智能[40, 41], 提出将提取的医学“ 小知识” 与医生专家先验知识被解码为模型可识别的描述, 由顶向下指导数据收集与生成, 由此得到数据知识具有解释性, 从而有利于构建可解释诊断模型, 并提高可解释性[38].

医疗数据, 特别是皮肤病图像数据难以获取, 一方面是由于我国医疗机构的封闭运行及隐私保护, 另一方面我国皮肤病病症相对较少.启发于基于ACP思想的平行医学图像分析框架, 本文提出平行皮肤分析框架, 为基于视觉感知方法的皮肤病智能诊断分析提供一种解决方法.具体框架如图2所示.

本文提出构建人工图像系统, 实现基于真实皮肤图像分布的数据扩充与生成, 并开展基于数据驱动的计算实验.与基于视觉的分析方法不同, 引入平行学习, 融合医学专家知识, 实现闭环反馈系统优化.

目前已有的皮肤病图像分析方法大多基于模型学习, 需要准确的标注信息, 而皮肤病类别繁多且需要领域医学知识才能标注, 因此, 对于数据驱动的皮肤诊断模型学习而言, 收集大规模有效训练样本图像耗时费力, 皮肤图像数据收集仍然是一个具有挑战性的问题.

本文提出构建一个人工图像系统, 由系统实现特定数据删选及生成, 从而实现有效皮肤数据收集.人工图像系统的目的是实现数据收集, 具体实现是通过得到真实图像的分布模型, 并根据真实皮肤数据分布选择与生成与真实分布一致的数据.本文将人工图像系统的实现方法分为显式真实图像扩充和隐式仿真图像生成两类方法.

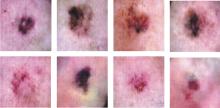

1)真实数据扩充.具体显式的方法可以为传统图像扩充方法, 包含旋转、加噪、缩放等操作, 如图3所示.

| 图3 人工皮肤图像系统显式扩充真实图像示例Fig.3 Example of explicitly generated skin images by artificial skin image system |

通过传统仿射变化, 如旋转、缩放等及扭曲、加噪等操作, 依然保持原皮肤病理特性, 从而有效实现真实数据扩充.类似的方法[1, 42]用于解决数据平衡, 为深度网络模型提供更多样数据.此外, 也可以根据临床病理检测结果有监督地删选特定病种的皮肤影像, 如选择特定患癌样本图像, 用于后续总结分析癌变图像特征.

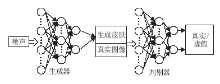

2)仿真数据生成.隐式的方法主要基于模型学习数据分布, 得到生成模型, 用于生成分布一致的仿真数据.生成对抗网络(Generative Adversanal Networks, GANs)[43, 44]广泛应用于隐式图像生成.如图4所示, 构建一个生成器

G和一个判别器D, G和D一般是可微分的深度神经网络, 它们的输入分别为随机变量z和真实皮肤图像数据x, G(z)为由G生成的尽量服从真实皮肤图像分布p_data 的样本.D输出的输入数据来源于真实图像的概率, 其优化目标是实现对数据来源的二分类判别:来源于真实图像还是生成的仿真皮肤图像.而G的目标是使自己生成的数据G(z)在D上的表现D(G(z))和真实数据x在其上的表现D(x)一致.二者对抗优化, 损失函数定义如下:

在已有工作[45]中, 已提出利用深度卷积生成式对抗网络(Deep Convolutional GAN, DCGAN)[46]和拉普拉斯金字塔生成式对抗网络(Laplacian Pyramid of GAN, LAPGAN)[47]生成高清(256× 256)皮肤病图像, 实验部分作者仅使用训练和验证损失作为生成图像的评价标准.Bissoto等[48]利用pix2pixHD[49]生成更高清(1024× 512)皮肤图像, 生成的图像直观上部分不真实, 但是包含病症信息, 通过生成图像数据扩充后, 分类模型效果也有所提升.风格转换方法也常用于数据生成[50], 如图5所示, 利用良性原图结构, 融合特定病种(恶性)皮肤特性生成仿真图像.该类方法可以解决恶性皮肤少的数据不平衡问题.

| 图5 基于风格转换的皮肤图像生成[50]Fig.5 Skin-image generation based on style conversion |

除了利用GANs得到生成模型外, Galdran等[51]提出从已有数据中学习得到光照分布, 并将该部分作用于颜色归一化后的皮肤图像, 从而生成新的皮肤数据, 在ISIC2017数据集上的分割和分类效果均证明其基于颜色信息扩充数据的有效性.此外, 还有部分工作基于专家领域知识, 在图像获取端进行颜色处理[11, 52, 53], 这类方法比对获取图像进行归一化后处理更有效.

3)开源皮肤数据.本节总结目前已有的开源皮肤镜及临床医学图像数据集, 如表1所示, 为基于数据驱动的皮肤病分析提供更多真实数据源.

| 表1 开源皮肤图像数据集 Table 1 Open source skin image datasets |

Interactive Atlas数据集由Argenziano等[54]于2000年出版的《Interactive Atlas of Dermoscopy》的附赠光盘里1024张皮肤镜图像组成, 具有7种皮肤病的分类标签, 大致可以分为167张非黑色素瘤图、857张痣和黑色素瘤图.虽然这是一个涵盖病种数最多的可用数据集之一, 但由于可访问性较低, 数据获取较困难.

PH2数据集是Mendonÿ a等[55]在2013年公布, 一共有200张皮肤镜图, 包括160张痣图、40张黑色素瘤图.其中黑色素瘤图均已经过病理学验证, 但是大多数的痣并不适于用病理学的方法验证.由于数据是公开的, 而且包括较全面的疾病图像, 因此PH2数据集一直被用于黑色素瘤的计算机诊断研究.

SD198由Sun等[56]公布于2016年, 是当时用于皮肤病视觉识别最大的数据集, 包括根据规模、颜色、形状和结构分为198类的6 584张图像, 同时也可以使用不同的分类标准, 得到更少的类别数, 使每类有更多的样本数量.

7-Point是2018年Kawahara等[57]在研究多任务神经网络对皮肤病图像7-Point标准分类时使用的数据集.共有2 045张彩色临床和皮肤镜图像, 有标注信息的有效数据为1 011张, 这些图像具有多种分类标准下的类别标签, 其中有252张黑色素瘤图, 759张非黑色素瘤图.

Hyperspectral数据集是由Gu等[58]于2018年公开的第一个高光谱皮肤镜数据集, 包括330张16个可见光波段的高光谱皮肤镜图像, 共有80张黑色素癌图、180张异常痣图及70张其它种类皮肤病的图像, 一共分成6种类别.同时所有图像都经过病理学验证.

ISIC2017是收集、整理多个数据库后的一个公开数据集[59].截止2018年2月12日, 包含13 786张皮肤镜图, 主要由黑素细胞病变图像组成, 13 786张图像中有多达12 893张图像是痣或黑色素瘤.就目前而言, ISIC2017数据集易于获取, 数据量大, 是皮肤镜图像分析研究的标准数据源.

HAM10000是Tschandl等[60]从奥地利维也纳医科大学的皮肤病学系和澳大利亚昆士兰大学Cliff Rosendahl的皮肤癌研究中收集20年内的10 015张不同人群的皮肤镜图, 病例基本包括色素病变领域中所有重要的诊断类别, 其中53.3%都得到病理学验证.

通过人工皮肤图像系统实现数据增广扩充后, 进一步完成计算实验, 从而实现医学诊断.从影像组学[61]的角度来说, 通过开展计算实验从皮肤图像中高通量地提取影像信息, 实现病灶分割、特征提取与预测模型建立, 凭借对海量图像数据信息进行更深层次的挖掘、预测和分析以辅助医师做出最准确的诊断.平行医学图像分析框架[38]指出预测学习可用于挖掘医学知识, 实现辅助诊断.

在计算实验步骤, 利用预测学习方法得到鲁棒有效的诊断模型.基于数据驱动的方法, 如深度模型等, 可以在本文框架中通过预测学习得到有效鲁棒的皮肤病诊断模型.传统目标检测、分割、分类等基于视觉的分析方法均可以用于计算实验.在一个基于深度学习的黑色素瘤分类方法中[9], 首先利用一个自生成神经网络提取病灶区域, 然后提取一些人工特征表征病灶的颜色、纹理与边界信息, 最后通过集成神经网络方法实现分类.Yang等[62]提出融合皮肤专家知识, 在皮肤诊断准则ABCD(Asymmetry, Border, Color, Diameter)指导下, 提取人工特征(非对称、边界、颜色、直径), 并融合特征实现皮肤病诊断, 在SD198数据集[56]上的198类分类识别准确率达到56.47%.Esteva等[1]利用GoogleNet[63]网络结构, 在ImageNet数据集合上预训练一个大概具有128万个参数的深度网络, 网络结构如图6所示, 在近13万张皮肤病变数据集上进行迁移学习优化, 这些皮肤图像覆盖2 032种不同的皮肤疾病, 分为757个大类进行实验.实验结果显示模型敏感特异性AUC为91%, 达到媲美专业皮肤科医生水平.

| 图6 基于GoogleNet实现皮肤分类的网络结构[1]Fig.6 Network structure for skin classification based on googleNet |

平行学习框架通过整合预测、描述、指示学习实现数据、知识与决策的系统优化, 基于平行学习[36, 37]框架如图2所示, 从数据角度, 利用描述、指示学习方法融合医学专家知识, 实现整个系统闭环优化.与传统方法不同, 通过预测学习得到诊断模型后, 提出通过描述与指示学习反馈优化指导皮肤数据收集与生成.

描述学习的目的是构建模型并对预测结果进行描述解释[64].本文提出基于描述学习在人工图像系统中得到已有数据的分布模型, 可以有效表征已有数据分布.描述学习可以通过半监督或无监督的学习.而指示学习的目的是引导系统下一步行动生成特定输出[64].在基于图像的皮肤病分析框架中, 提出利用指示学习实现特定样本的删选与生成.特别地, 可以根据医学专家常识删选无效皮肤图像数据, 减小外点数据对模型训练的干扰.同时, 利用预测学习得到模型分析结果或医学专家领域知识以指导数据生成.例如需要大量黑色素瘤的恶性皮肤数据, 可以利用生成对抗等方法在恶性皮肤数据上进行数据分布学习, 并根据领域知识(恶性皮肤通常含有支路条纹、呈片块状或束状排列[50])设定数据分布条件限制, 从而生成特定类别的肿瘤图像[38].

通过上述平行学习方法, 平行皮肤框架可以不断优化系统模型, 采集并生成更有效多样的皮肤图像数据, 提取更精准有效知识, 实现更准确的皮肤病辅助诊断及分析.

以皮肤病分类实现辅助诊断为例, 在平行皮肤框架下, 本文利用生成对抗方法对HAM10000数据集[60]中部分样本数量较少的类别进行显式和隐式的增广扩充, 生成仿真皮肤图像, 然后使用混合人工生成数据及原始数据的新数据集进行基于预测学习的皮肤分类对比实验, 相比直接利用原始数据集进行分类, 本文方法可以得到更准确的结果, 有效提高辅助诊断效果.

首先进行翻转、裁剪、缩放等显式数据扩充.在此基础上, 利用DCGAN网络模型[46]预测真实皮肤图像分布, 实现预测学习, 从而利用得到的生成器模型生成仿真皮肤图像.生成器网络结构如图7所示.

为了解决训练数据平衡问题, 在平行皮肤框架下, 利用指示学习方法, 在医学专家标注的标签特定类别下进行生成, 从而实现医学专家知识的融合与引导.具体地, 有监督地对HAM10000数据集中医生标注数量较少的4类图像进行4个不同的DCGAN训练, 原则上对应的DCGAN生成对应的类别图像, 从而实现数据特定扩充, 扩充前后各类图像数量如表2所示.生成的仿真皮肤图像如图8所示, 相比真实图像, 这些仿真图像有类似的外观和纹理.

| 表2 HAM10000 数据集扩充前后各类图像数量 Table 2 Number of pictures before and after the expansion of the HAM10000 dataset |

预测学习旨在挖掘医学影像深层病理特征并实现分类预测.本文利用ResNet[65]对HAM10000数据集进行预测分类实验, 然后加入生成的仿真皮肤图像后进行对比, 可以验证依据平行皮肤框架的思想对于计算机辅助皮肤病医学诊断的有效性.本文使用的验证实验流程如图9所示.在原始数据集的实验中, 本文使用共9 017张各类的皮肤病图像作为训练集, 并在998张图像上进行测试.基于平行皮肤方法优化后的训练图像数量为13 017, 并在相同的测试数据集中完成对比实验.

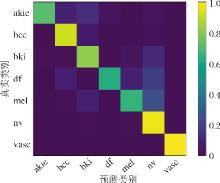

表3和表4分别给出平行皮肤优化前后在各类指标下的实验效果.优化后的归一化混淆矩阵如图10所示.

| 表3 真实皮肤图像分类结果 Table 3 Real skin image classification results % |

| 表4 基于平行皮肤优化后的分类结果 Table 4 Classification results based on parallel skin optimization % |

通过对比可以发现, 分类的平均准确度、召回率、精确度和F1值等各项指标都有1%~2%的提升, 这说明平行皮肤框架确实有助于皮肤病的计算机辅助医学诊断.值得注意的是, 在种类vasc上, 通过平行学习引导生成实现数据扩充后, F1值达到100%.这说明融合领域知识实现特定类别数据生成扩充后, 可以提高模型泛化能力.由于文章篇幅有限, 只简单进行一步优化, 基于平行学习的迭代优化将在后续工作中展开.同时, 进一步融合领域专家知识, 将医学知识转为计算模型可识别认知的条件也将是今后工作的一部分.

皮肤作为人体最大的器官, 直接与外界环境接触, 具有调节体温、排泄与感受外界刺激的作用.针对皮肤的相关研究正受到广泛关注, 本文从视觉感知角度提出平行皮肤框架, 并概述已有的研究成果.而在皮肤相关研究的领域, 还有很多开放的研究方向.

尽管目前基于深度网络方法的皮肤病诊断达到甚至超过皮肤科专家的水平[1, 10, 66], 但是这类方法缺乏医学可解释性.尽管平行皮肤框架通过平行学习选择与生成特定数据, 通过明确数据构成及来源一定程度上可以增加模型的可解释性, 但是仍具有一定局限性.例如无法将医学领域知识输出, 并给出判断具体依据.特别是在医学皮肤图像分析领域, 计算机给出医疗诊断结果时, 患者及医生都有必要知道计算机提取的语义特征, 以及做出判断的医学依据[67, 68].作者建议深入了解皮肤病理学及生物解剖学, 与临床医生开展跨领域深入合作, 将领域知识转化为计算机可识别的语言表征, 从而设计可解释诊断模型.Maibach等[69]详细介绍皮肤病学的基本原理, 如临床研究的可解释性、疾病导向的证据与病人的护理证据等, 可以为基于深度网络进行辅助诊断提供可解释性.作者认为可解释的智能诊断方法可以增加辅助诊断的透明度与可信性, 在基于视觉分析的皮肤病分析应用领域, 可解释性将是医学教育和临床诊断等领域最亟需解决的问题之一.

深入了解皮肤的解剖组织特性, 从护理及保养的角度研究皮肤病问题受到越来越多的关注.基于皮肤影像分析广泛应用于皮肤病的诊断, 也可以应用于医学美容治疗前后的效果评估.所以, 平行皮肤可以实现皮肤病的智能诊断, 同样可以推广应用于美容皮肤学(Cosmetic Dermatology)[70, 71, 72].目前较少的工作利用人工智能方法应用于皮肤美容学.针对皮肤术前术后恢复情况、动态检测皮肤病发展状态、准确计算评估预后情况等领域, 平行皮肤分析方法具有无创、实时及动态的特定, 一定会日渐受到广泛关注.

从生物医学角度而言, Naik等[73]的研究表明皮肤能够形成对皮肤炎症的记忆.具体地, 伤口或其它触发炎症的有害经历会使驻留在皮肤中的上皮干细胞带来持久记忆, 教导它们更快愈合.他们在实验中证明, 一个被称作Aim2的基因尤为重要, 这个基因编码一种“ 损伤与危险” 的感知蛋白, 最初的炎症促进它的表达持续增加.炎症再次来临会迅速激活这种蛋白, 从而导致一种炎性信号产生, 而且这种信号增强这些干细胞迁移到伤口中的能力.针对皮肤损伤自我修复能力有限的问题, Kurita等[74]介绍将开放性伤口中的细胞直接转化为新皮肤细胞的方法, 依赖于将细胞重新编程为干细胞样状态, 并且可用于治疗皮肤损伤、抗衰老, 也能进一步理解皮肤癌.启发于人体皮肤特性, Lai等[75]利用摩擦纳米发电机, 开发第一个可自驱动、自主感知并响应内部运动和外部刺激的软体机器人皮肤.

本文提出平行皮肤的概念及框架, 为基于皮肤影像数据分析的视觉感知问题提出一种新的基于数据驱动的分析方法.基于ACP方法及平行医学图像框架, 提出构建人工皮肤图像系统以选择与生成数据, 并通过平行学习实现诊断分析系统的闭环优化的统一框架.本文概述系统构成环节中已有相关工作, 并通过对已有工作调研分析给出具体思考与该领域未来研究展望.同时, 还开展初步应用实例研究.需要指出的是, 细节之处还需要进一步完善, 在皮肤影像分析领域的平行学习理论还需要进一步研究.作者相信, 整合“ 描述智能-预测智能-指示智能” 的平行皮肤方法一定会受到更广泛的关注, 并实际应用于皮肤相关的各个领域.

致 谢 本文是王飞跃教授与美国加州大学旧金山分校资深皮肤学专家Howard Maibach教授探讨后确立的研究课题及内容, 在此对Howard Maibach教授的指导及其助手翟洪波先生的帮助表示衷心感谢.

The authors have declared that no competing interests exist.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|

| [43] |

|

| [44] |

|

| [45] |

|

| [46] |

|

| [47] |

|

| [48] |

|

| [49] |

|

| [50] |

|

| [51] |

|

| [52] |

|

| [53] |

|

| [54] |

|

| [55] |

|

| [56] |

|

| [57] |

|

| [58] |

|

| [59] |

|

| [60] |

|

| [61] |

|

| [62] |

|

| [63] |

|

| [64] |

|

| [65] |

|

| [66] |

|

| [67] |

|

| [68] |

|

| [69] |

|

| [70] |

|

| [71] |

|

| [72] |

|

| [73] |

|

| [74] |

|

| [75] |

|