江 波,博士,副教授,主要研究方向为图像匹配、图匹配.E-mail:jiangbo@ahu.edu.cn.

作者简介:

郑爱华,博士,副教授,主要研究方向为行人、车辆重识别、音视频计算.E-mail:ahzheng214@ahu.edu.cn.

曾小强,硕士研究生,主要研究方向为跨模态行人重识别.E-mail:xqzeng136@foxmail.com.

黄 岩,博士,副教授,主要研究方向为机器学习、模式识别.E-mail:yhuang@nlpr.ia.ac.cn.

汤 进,博士,教授,主要研究方向为计算机视觉、模式识别.E-mail:tj@ahu.edu.cn.

针对现有跨模态行人重识别方法忽略行人的局部特征及模态间的相互协同的问题,文中提出基于局部异质协同双路网络的跨模态行人重识别方法.首先,通过双路网络提取不同模态的全局特征进行局部精细化,挖掘行人的结构化局部信息.然后,通过标签和预测信息建立跨模态局部信息之间的关联,进行协同自适应的跨模态融合,使不同模态的特征之间相互补充,获得富有判别力的特征.在RegDB、SYSU-MM01跨模态行人重识别数据集上的实验验证文中方法的有效性.

JIANG Bo, Ph.D., associate professor. His research interests include image matching and graph matching.

AboutAuthor:

ZHENG Aihua, Ph.D., associate profe-ssor. Her research interests include person/vehicle re-identification and audio visual computing.

ZENG Xiaoqiang, master student. His research interests include cross-modal person re-identification.

HUANG Yan, Ph.D., associate professor. His research interests include machine lear-ning and pattern recognition.

TANG Jin, Ph.D., professor. His research interests include computer vision and pattern recognition.

The coordinating fusion between modalities is ignored in the existing cross-modal person re-identification methods in the learning process. In this paper, a strategy for cross-modal person re-identification(Re-ID) based on local heterogeneous collaborative dual-path network is proposed. Firstly, the global features of each modality are extracted by the dual-path network for local refinement, and the structured local information of pedestrians is mined. Then, the local information of different modalities is correlated with the label and prediction information to achieve cooperative adaptive fusion and learn more discriminative features. The effectiveness of the proposed method is demonstrated through comprehensive

本文责任编委 兰旭光

Recommended by Associate Editor LAN Xuguang

给定一幅特定摄像机拍摄的行人图像, 行人重识别需要在其它相机拍摄的图像中检索该行人.由于行人重识别在实际的监控场景和智能安全等领域中具有广泛的应用前景[1, 2], 因此一直受到学术界和工业界的关注.

传统的行人重识别方法利用手工提取的特征, 在应对光照、视角变化上取得一定效果[3, 4, 5, 6, 7, 8, 9], 但距在实际场景中应用仍有差距.近年来, 随着深度卷积神经网络的广泛应用, 研究者们除提出一系列现实场景下的数据[10, 11, 12, 13]外, 同时提出深度神经网络特征提取方法.基于深度卷积神经网络的行人重识别模型包括:分类模型[14, 15, 16, 17, 18, 19, 20, 21]、验证模型[10, 22, 23, 24, 25]和深度度量学习模型[18, 19, 20, 21, 26, 27, 28, 29, 30, 31].分类模型将行人看成独立的身份标签, 通过多分类任务完成行人分类识别.验证模型判别输入的行人图像对的相似性得分, 判断其是否为同一行人.深度度量学习模型使用度量损失函数作为代价函数, 引导模型进行训练, 如常用的三元组损失函数.上述方法可归纳为单模态(基于可见光图像的)行人重识别.

单模态行人重识别在弱光照和雾霾情况下难以满足现实应用的需求, 而在实际监控场景中, 很多监控摄像头在光照不足时可自动转换到红外模式, 因此基于可见光和红外图像的跨模态行人重识别得到广泛关注[32, 33, 34].

跨模态行人重识别是一项具有挑战性的工作, 原因在于其不仅要面临单模态行人重识别中行人姿势、相机视角、背景等不同因素带来的问题, 同时要解决可见光和红外两种不同模态的异质数据的融合难题.在此之前, 研究者提出一系列的解决方案.Wu等[32]使用深度零填充网络, 针对性地学习特定模态的结构信息.Ye等[33]采用基于度量学习的方法, 让网络提取的不同模态下的特征表达尽可能相似.

在此基础上, 学者们提出双向限定的排序损失, 进一步增进不同模态特征之间的相似性[34, 35].Dai等[36]使用度量学习和生成对抗的策略学习模态之间共有的特征表达.Hao等[37]提出超球面流形嵌入模型, 解决跨模态行人重识别问题.Wang等[38]采用分步策略, 将不同模态的图像空间映射至同一图像空间后, 再嵌入特征空间中, 学习模态共有的特征表达, 实现跨模态行人重识别.Liu等[39]将中间网络层的特征融入行人特征, 加强行人的特征表达, 通过身份损失和双模态的三元组损失引导不同模态的特征融合.Wang等[40, 41]将生成的内容对齐的跨模态图像对输入网络中学习共享特征, 图像内容对齐使学习模态更容易共享特征.Lu等[42]分离模态独有信息, 同时挖掘模态独有信息和共有信息间的联系, 进行模态融合.Zhu等[43]提出异质中心损失函数, 计算拉近模态间的样本中心特征, 促进模态特征间的融合.

综上所述, 将不同模态下的异质性数据高效融合并提升不同模态数据之间的相似性是解决跨模态行人重识别问题的一种重要方法.然而, 现有的方法仅使用身份损失或三元组损失作为学习目标解决模态融合问题, 其中身份损失只引导不同模态特征朝同个类中心聚集, 三元组损失仅减小不同模态特征在空间上的距离, 两者都只是单方面地从空间层面上拉近不同模态特征的距离, 模态信息本身未发生变化, 这导致在学习过程中忽视不同模态特征之间的协同交流及不同模态信息之间的互补, 限制现有方法的有效性.

在跨模态行人重识别任务中, 不同模态的行人信息尽管分布在不同的特征空间中, 但依旧享有共同的信息, 如身份标签、行人的语义内容等.协同学习[44, 45, 46, 47]强调各个网络之间通过共有的信息引导进行交流通信, 最终达到网络之间信息互补的目的.在跨模态行人重识别任务中, 行人图像的可见光信息和红外信息享有共同的身份标签和视觉语义等信息, 它们之间可相互交流进行协同学习.

除了面临不同模态数据如何进行融合的难题, 跨模态行人重识别还需要解决模态内部行人姿势、相机视角等问题.针对这些问题, 基于可见光图像的行人重识别使用特征精细化的方法[48, 49, 50], 取得较优效果.

基于上述分析, 本文提出基于局部异质协同双路网络的跨模态行人重识别方法, 方法包含3步:1)双路提取.使用预训练好的网络分别提取行人的可见光图像和红外图像的特征.2)特征精细化.通过特征精细化挖掘不同模态特征的局部信息.3)协同融合.将不同局部的模态特征进行协同融合.在这一过程中, 先将不同模态的局部特征通过共享参数的分类器映射至相同的特征子空间, 减小不同模态特征间的距离.再经过Softmax函数, 得到各个局部特征的概率向量, 通过交叉熵损失引导特征与标签之间建立关联.进一步协同损失引导网络进行学习, 促进每一个局部特征与另一个模态所有局部特征相互交流, 在学习过程中达到信息互补的目的.相比先前的跨模态行人重识别方法, 本文方法不仅可学习更精细的模态特征信息, 同时协同融合过程可进一步自适应融合跨模态异质性信息.在现有的2个数据集上的实验验证本文方法的有效性.

本文提出基于局部异质协同双路网络的跨模态行人重识别方法, 方法整体网络框架如图1所示.首先采用双路网络两个分支提取可见光图像和红外图像特征.然后将深度网络提取的行人特征进行特征精细化, 即划分成多个局部细节特征.最后进行协同融合, 分为2步:1)网络阶段的融合, 表现在不同模态特征下相同位置的局部特征输入共享参数的分类器中.2)目标阶段的融合, 表现在损失函数引导同一身份下不同模态的局部特征相互补充信息.

本文使用预训练好的残差网络(ResNet50)[51]提取不同模态特征.同样其它的深度网络也可用于提取特征, 如密集连接的卷积网络(DenseNet)[52]、VGG[53]等.本文使用的ResNet50网络[51]和原始的残差网络(Residual Network, ResNet)有所区别:ResNet整体分为4个模块, 本文使用网络的前3个模块提取图像特征.输出特征的通道数减少为原始网络的1/2, 既可节省计算量, 又能避免因数据集过小网络过深而造成的过拟合.

受文献[48]启发, 本文将单模态下的特征精细化技术扩展至跨模态行人重识别, 在获取更鲁棒的特征的同时, 为后续的协同融合提供更精细的特征.首先, 专注于学习行人不同位置的局部特征, 再采用全局最大池化(Global Max Pooling, GMP)提取行人局部的精细特征.与单模态行人提取特征的方法[48]类似, 特征精细化如图1中对应部分所示.具体过程如下.

1)特征提取.将N对可见光和红外图像通过深度网络得到2个大小为N× H× W× C 的特征张量, 其中, H、W表示特征张量的高、宽, C表示通道数.

2)特征池化.将1)中提取的行人特征张量通过全局最大池化得到具有区分度的特征, 特征张量的大小变成N× H× 1× C.

3)特征细化.将2)获取高度为 H 的特征平均分割成 m 份大小为 N×

跨模态行人重识别中的关键问题是可见光图像和红外图像两种异质数据如何进行融合.受协同学习[4]的启发, 本文提出协同融合策略, 解决不同模态数据的融合问题.不同于文献[47]中使用多个分类器协同学习同一数据, 本文提出的协同融合策略先将不同模态的特征投射至相同的特征空间, 然后让一个模态中不同局部的特征向另一个模态的所有特征相互补充信息, 使不同模态信息之间的相似度更高, 提升重识别的效果.

本文的协同融合过程如图1中的对应部分所示.首先将不同模态相同位置的局部特征输入由2个全连接层组合的分类器中:第1个全连接层单元包含512个神经元, 在其后添加BN(Batch Normali-zation)层和ReLU激活函数, 第2个全连接层单元的神经元数目和训练样本中的类别数相同.注意到不同位置的局部特征使用不同的分类器.上述过程是网络阶段的融合, 目的是为了让不同模态的特征通过一系列转换后映射至相同的特征空间.经过上述过程得到各模态不同位置的局部特征信息对应的类别向量.再进行学习目标阶段的融合, 在此阶段学习目标不关注特征属于哪个局部位置, 也不关注它们分布在哪个特征空间, 只关注局部特征所属的身份, 让同个身份下不同模态的局部特征交流融合.具体的学习目标函数的定义过程如下.

网络输出的类别概率向量进行Softmax转换, 生成对应的类别概率向量, 假设类别概率向量为

z(r, h)={

其中, k为类别数, h为特征所属的局部位置, r为可见光模态v或红外模态t.带有参数T的Softmax函数定义如下:

δ i(z(r, h); T)=

其中, T值的大小表示概率分布的软化程度, T值越大, 软化程度越高.

再将得到的类别概率向量分两步计算损失.1)分组.一个模态下获得某个局部特征的类别概率向量与另一个模态的所有类别概率向量为一组.2)计算协同损失.以某一个可见光局部特征最终计算得到的类别概率向量和红外图像得到的所有类别概率向量进行组合为例, 协同损失函数如下:

Lv, h=β Jhard(y, z(v, h))+(1-β )Jsoft(q(v, h), z(v, h)).

其中:z(v, h)为当前的可见光图像获得的类别概率向量; v为可见光; β 在(0, 1]之间, 用于平衡

Jhard=-

Jsoft通过拉近跨模态信息的距离学习模态间的协同互补, 这得益于学习标签q(v, h)来源于另一个模态.在可见光模态学习时, q(v, h)等于其它所有红外局部位置的特征对应的类别概率向量的平均值,

q(v, h)=δ (

m为总共的局部特征数量, t为红外.

q(v, h)综合考虑相同标签下同一模态信息的平均情况.携带软标签和 T 值的损失函数[47]如下:

Jsoft(q(v, h); z(v, h))=-

Jsoft度量2个模态输出向量的距离.最小化Jsoft意味着将一个模态的平均信息传递至另一个模态的局部信息, 同时可正则化整个网络.

同理, 根据上述过程得出Lt, h, 最终不同模态的损失函数之和为

Lall=

其中, Lv, h为可见光图像的协同损失函数, Lt, h为红外图像的协同损失函数.

为了验证本文方法的有效性, 在跨模态行人重识别数据集RegDB[54]和SYSU-MM01[32]上和当前主流的跨模态行人重识别的方法进行对比.

RegDB数据集的红外图像由远红外相机拍摄, 共有412个行人, 单个行人包含10幅RGB图像和10幅红外图像.本文采用的评测协议和文献[33]~文献[35]一致:从412人中随机挑选206人用于训练, 另外206人用于测试.在测试阶段, 将其中一个模态的数据当作被检索图像, 另一个模态的数据当作检索图像.最终结果均为10次实验的平均结果.

与RegDB数据集[54]不同, SYSU-MM01数据集的红外图像由近红外相机拍摄, 与RegDB数据集的图像风格差异较大.数据集包含来自于6个相机采集的491个行人图像, 包括4个RGB相机和2个红外相机.训练集包含395个行人, 共22 258幅RGB图像和11 909幅红外图像.测试集包含96个行人, 其中3 803幅红外图像当作被检索图像, 随机抽取的301幅RGB图像当作检索图像.由于随机选择图像当作检索图像的原因, 在测试阶段采用10次随机实验的平均值作为最终结果.同时, 遵循文献[32]的验证协议, 本文分别采用单幅图像命中加全局搜索(Single-Shot All-Search)的评估模式评测方法.

为了评价方法的性能, 本文使用Rank1、Rank10、Rank20和平均精度均值(Mean Average Precision, mAP)作为评估指标.给定一幅被检索的行人图像, Rank 排名反映搜索正确的匹配率, mAP评估算法的平均检索性能.

在训练期间, 批大小设置为32, 取样阶段从训练集中随机各取1幅RGB图像和1幅红外图像, 本文仅使用图像随机水平翻转作为图像增强, 图像初始大小与文献[48]~文献[50]一致, 为384× 128.预训练好的ResNet50网络被用作主体框架, 优化器使用随机梯度下降算法(Stochastic Gradient Descent, SGD), 其中动量(Momentum)等于0.9.预训练网络的初始学习率为0.001, 分类器的初始学习率为0.01, 经过训练迭代30轮以后, 所有网络的学习率降至原来的1/10.在协同融合的过程中, 当数据集为SYSU-MM01时, T=2, β =0.6.数据集为RegDB时, T=2, β =0.5.代码的实现使用pytorch 1.1.0框架, 总共训练50轮, 训练过程使用GTX1080Ti显卡加速.2个数据集的训练过程都遵从上述设定.

实验中选择的对比方法如下:单流网络算法(One-Stream Network, One-Stream)[32], 双流网络算法(Two-Stream Network, Two-Stream)[32], 零填充网络算法(Deep Zero-Padding, Zero-Padding)[32], 双流卷积神经网络算法(Two-Stream CNN Network, TONE)[33], 分层跨模态度量学习算法(Hierarchical Cross-Modality Metric Learning, HCML)[33], 双向跨模态排序算法(Bi-directional Cross-Modality Top-Ranking, BCTR)[34], 双向双重限制的排序算法(Bi-directional Dual-Constrained Top-Ranking, BDTR)[34], 双向中心约束的排序算法(Bi-direc-tional Center-Constrained Top-Ranking, eBDTR)[35], 跨模态生成对抗网络算法(Cross-Modality Gene-rative Adversarial Network, cmGAN)[36], 超球面流形嵌入算法(HyperSphere Manifold Embedding, HSME)[37], 双重差异减小算法(Dual-Level Discre-pancy Reduction Learning, D2RL)[38], 增强辨别性特征学习算法(Enhancing Discriminative Feature Learning, EDFL)[39], 对齐的生成对抗网络算法(Alignment Generative Adversarial Network, AlignGAN)[40], 数据集与实例的联合对齐算法(Joint Set-Level and Instance-Level Alignment Re-ID, JSIA-ReID)[41], 跨模态共享与特异特征变换算法(Cross-Modality Shared-Specific Feature Transfer Algorithm, cm-SSFT)[41], 双流局部特征网络算法(Two-Stream Local Feature Network, TSLFN)[43], 异质中心损失和双流局部特征网络算法(Two-Stream Local Feature Network+Hetero-Center Loss, TSLFN+HC)[43].

在RegDB数据集上, 由于行人数量和图像数量具有较好的对称性, 训练集和测试集可随机分成均等的两份, 因此本文在RegDB数据集上进行2种不同搜索模式下的实验:可见光图像搜索红外图像(Visible to Thermal)模式、红外图像搜索可见光图像(Thermal to Visible)模式.

在RegDB数据集上, 各方法在2种不同的匹配模式下的实验结果如表1所示.

| 表1 各方法在RegDB数据集上的实验结果对比 Table 1 Experimental results comparison of different methods on RegDB dataset % |

由表1可看出, 相比cm-SSFT, 在Visible to Thermal模式中, 本文方法的Rank1值和mAP值达到68.62%和66.27%, 提高各3.22%和0.67%.在Thermal to Visible模式中, 本文方法Rank1值和mAP值达到67.65%和64.49%, 依旧占据优势.在两种模式中, Visible to Thermal模式的结果在各项指标上略高, 原因可能在于三通道的RGB图像比单通道的红外图像携带更丰富的信息, 因此搜索结果更优.

本文方法效果最优的原因如下:

1)本文方法学习不同位置的行人局部信息, 获取不同模态下更精细、更具有区分度的特征, 此种方式在单模态行人重识别任务中被证明是有效的;

2)本文的协同融合策略考虑不同模态之间的局部信息互补, 不仅在空间层面上缩小模态之间的距离, 同时也让模态信息之间相互转换, 最终达到更优的特征融合效果.

为了更好地展示本文方法的有效性, 将RegDB数据集上检索排序结果的前10名与BDTR进行对比, 结果分别包含Visible to Thermal和Thermal to Visible两种模式, 具体如图2所示, 图中绿色框表示匹配正确, 红色框表示匹配错误.由图可看出, 相比BDTR, 无论被检索图像是可见光图像还是红外图像, 本文方法在2种搜索模式下的匹配成功率都较高.

| 图2 本文方法和BDTR在RegDB 数据集上的重识别结果Fig.2 Re-identification results of the proposed method and BDTR on RegDB dataset |

当被检索的图像是可见光图像时, 本文方法可清晰分辨信息量少的红外图像, 如图2(a)所示.BDTR难以完整地识别正确的结果, 而本文方法可全部正确搜索不同行人对应不同姿势的红外图像, 这验证本文方法可提取鲁棒的特征.

当被检索图像是红外图像时, 本文方法依旧可通过较少的行人结构信息检索对应的可见光图像.如图2(b)中Query 2所示, 本文方法检索富含颜色信息(该行人身穿花纹格子衫)的行人可见光图像, 而BDTR检索姿势相似而身份不同的行人图像.这进一步说明本文方法对同一身份的行人在不同模态之间建立的关系更牢固.

SYSU-MM01数据集为一个大型的跨模态行人重识别数据集, 红外图像由近红外相机拍摄, 符合大多数的实际场景条件.与文献[32]的评测协议保持一致, 在此数据集上本文使用行人的红外图像检索可见光图像.

各方法在SYSU-MM01数据集上对比结果如表2所示.

| 表2 各方法在SYSU-MM01数据集上的实验结果对比 Table 2 Experimental results comparison of different methods on SYSU-MM01 dataset % |

相比使用度量学习的方法BDTR、EDFL, 及同时使用度量学习和对抗生成策略的cmGAN、D2RL、AlignGAN和JSIA-ReID, 本文方法具有更高的识别性能, Rank1值和mAP值分别提高33.11%和30.42%(BDTR), 13.18%和9.31%(EDFL), 23.15%和22.28%(cmGAN), 21.22%和20.88%(D2RL), 7.72%和9.38%(AlignGAN), 12.02%和13.18%(JSIA-ReID).同时, 本文方法的Rank1值比cm-SSFT提高3%左右, 也明显优于TSLFN.

由于异质中心(Hetero-Center, HC)度量损失的引用, TSLFN+HC与本文方法相比具有明显优势.为公平起见, 在本文方法上增加HC损失函数的结果进行验证.实验结果如表2最后一行所示.由表可看出, 增加HC度量损失函数后, 本文方法在各个指标上的效果和TSLFN+HC相当(Rank1值略高, mAP值略低).结果再次证实协同学习的有效性, 同时验证HC度量损失的优越性.本文方法优于大部分方法的原因在于它不仅可获取不同模态下更精细的局部特征, 从粒度层面上缩小不同模态特征之间的差异, 同时也让不同模态的局部特征之间进行信息互补、相互转换, 进一步缩小不同模态之间的差异, 所以会有更优的识别效果.

将本文方法在SYSU-MM01数据集上的检索结果和BDTR进行对比.在该数据集的测试阶段只包含Thermal to Visible模式, 随机选取其中的3个示例对比, 如图3所示, 图中绿色框表示匹配正确, 红色框表示匹配错误.

| 图3 本文方法和BDTR在SYSU-MM01数据集上的重识别结果Fig.3 Re-identification results of the proposed method and BDTR on SYSU-MM01 dataset |

由图3可看出, 整体上SYSU-MM01数据集因为行人姿势、光照和背景杂斑等因素影响较大, 挑战难度更大.由于跨模态异质图像中行人外观及跨相机行人姿态的差异, BDTR很难查询到正确结果, 而本文方法可较好地克服这些挑战, 成功匹配正确图像.然而, 本文方法在光线较暗(如Query1的Rank1和Rank4)及有遮挡的场景(如Query2的Rank1), 仍无法查询到正确结果.同时, 对于具有类似姿势的不同行人(如Query3的Rank6和Rank10), 本文方法也表现一般.由此可见, 相比单模态行人重识别任务而言, 跨模态行人重识别存在更严峻的挑战.

为了软化网络输出的概率分布和平衡协同损失与交叉熵损失之间的学习过程, 本文使用超参数β 和T增强最终的学习效果.其中, β 可以平衡损失Jhard和Jsoft, T可以软化输出的概率分布.在SYSU-MM01数据集上重识别检索性能指标Rank1和mAP随超参数β 和T的变化情况如图4所示.

| 图4 在SYSU-MM01数据集上超参数β 和T对模型性能的影响Fig.4 Influence of hyperparameter β and T on Rank1 and mAP on SYSU-MM01 dataset |

在分析β 的影响时, T=2; 在分析T时, β =0.6.图4结果表明, 当β =0.6时, 效果最优, 此时Rank1值为50.12%, mAP值为50.08%. 当T值为较小值(2、3、4、5、6 )时, Rank1值和mAP值相差在 1% 以内, 说明 T 值在小范围内波动对性能的影响不大.而当T值大于6时, Rank1值和mAP值随着T值增大而逐渐减小.本文最终设定T=2.

为了验证本文提出的协同融合方法的关键部分的有效性, 在SYSU-MM01数据集上对不同的网络融合方式、学习目标阶段不同的融合损失函数及不同的局部特征数量进行分析.

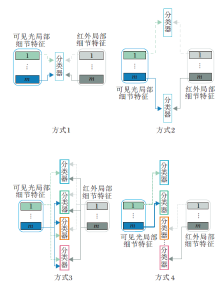

首先分析不同的网络融合方式对不同数量的局部特征的影响.分别得到行人的可见光模态的m个局部特征后, 局部特征的网络融合策略的选择是本文方法的重点.因此本文设计4种不同的网络融合方式进行验证.4种融合方式的具体结构如图5所示, 主要区别在于不同模态的特征共享全连接层参数的方式:方式1中所有局部位置的特征共享同一个分类器的参数; 方式2中不同模态下相同位置的局部特征共享同一个分类器; 方式3中一个模态下各局部的特征与另一个模态所有局部的特征共享分类器; 方式4中各个模态下每个局部特征使用单独的分类器.

在实验中, 将不同模态下的行人全局特征划分成表示不同位置的局部特征进行实验.图6为不同的局部特征数量使用4种不同的网络融合方式在SYSU-MM01数据集上的Rank1值的结果对比.由图可见, 第2种网络融合方式的效果最佳, 原因在于此种方式分类器的职责分工明确, 不同的分类器融合对应的跨模态局部特征, 因此方式2中对齐融合的方式结果最优.第1种融合方式效果次佳, 原因可能在于一个分类器难以支撑多个局部特征进行融合, 因此重识别效果会稍差.第3种网络融合方式使得各个全连接层的学习过程中混杂各个局部特征的信息, 为其它局部的特征学习过程中引入过多的噪音, 因此几乎没有效果.第4种融合方式让不同模态的各局部位置的特征在分离的参数空间中学习, 达不到融合的目的.

| 图6 局部特征数不同时4种网络融合方式的Rank1值对比Fig.6 Rank1 values comparison of different local features using 4 kinds of network fusion |

根据上述实验结果, 本文采用第2种方式作为局部特征的网络融合策略.

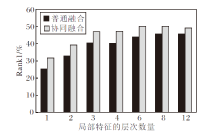

再分析不同的损失融合方式在不同数量的局部特征上的影响.为了验证本文使用的协同融合损失的有效性, 将其与通用的交叉熵损失(普通融合)进行对比.两者都使用身份标签进行引导, 不同之处在于协同融合的损失考虑不同分类器网络之间进行交互学习, 而交叉熵损失只引导单个分类器学习.两种融合损失基于不同数量的局部特征的对比结果如图7所示.

| 图7 局部特征的层次数量不同时2种融合损失的Rank1值对比Fig.7 Rank1 values comparison of 2 kinds of fusion with different numbers of local features |

由图7可看出, 总体而言, 本文采用的协同融合损失在不同数量的局部特征下均优于通用的交叉熵融合, 原因在于, 相比交叉熵损失函数, 协同损失更好地学习各个局部特征间的信息互补, 最终学习的特征更有辨识力.当局部特征的数量在一定范围(普通融合数量为8, 协同融合数量为6)内, 匹配结果随局部特征数量的增加而提升, 说明将特征分成一定数量的局部特征可更有效地挖掘各个模态下的特征信息, 从而为后期的协同融合阶段提供更好的特征表达.当局部特征数量(局部特征数量为1时, 此时只有全局特征)超过一定范围时, 无论是通用的交叉熵损失还是协同融合损失, 匹配结果趋于相对稳定而后下降的情况.原因在于过度地将特征细化, 导致深度网络难以学习更有区分度的特征.同时随着分类器的数目增多, 整个网络的训练参数增加使网络训练难度增加.局部特征的数量为6时的协同融合效果最佳, 因此本文实验的局部特征数量固定为6.

本文提出基于局部异质协同双路网络的跨模态行人重识别方法, 包括特征精细化和协同融合两个过程.特征精细化过程从行人不同位置的局部信息中获取更精细的特征, 协同融合过程让不同模态下同一行人中蕴含不同身体局部信息的特征之间互补信息.实验结果显示本文方法效果较优, 充分验证本文方法的有效性.在跨模态行人重识别中, 提取不同模态的图像特征依旧是研究的重点.凭借使用预训练网络的强大性能, 在单模态行人重识别任务中如何提取可见光图像的特征已经被广泛研究, 并且在各个数据集上已取得较优结果.红外图像和可见光图像两者在本质上结构不同, 如何更有效地提取红外图像特征需要进一步研究.另外, 不同模态特征如何融合一直是跨模态匹配的关键问题, 找到更优的融合方法应对跨模态行人重识别任务依旧需要进一步研究.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|

| [43] |

|

| [44] |

|

| [45] |

|

| [46] |

|

| [47] |

|

| [48] |

|

| [49] |

|

| [50] |

|

| [51] |

|

| [52] |

|

| [53] |

|

| [54] |

|