通信作者:张桂梅,博士,教授,主要研究方向为计算机视觉、图像处理、模式识别.E-mail:

作者简介:鲁飞飞,硕士研究生,主要研究方向为计算机视觉、图像处理、模式识别.E-mail:

龙邦耀,硕士研究生,主要研究方向为计算机视觉、图像处理、模式识别.E-mail:

缪君,博士,教授,主要研究方向为基于图像的三维重建、图像处理、模式识别.E-mail:

针对城市场景标签获取的高额成本问题,文中提出结合自集成和对抗学习的域自适应城市场景语义分割方法.对于源域和目标域的较大域间差异问题,采用风格转换的方法将源域数据集合成具有目标域风格的新数据集,作为新的源域数据集,从而有效减少源域与目标域的域间差异.对于目标域的域内差异问题,引入自集成方法,构造教师网络,利用教师网络在目标域分割图上通过一致性约束监督与指导学生网络,从而减小目标域的域内差异,提高分割精度.采用自训练的方法获得目标域的伪标签,将伪标签加入对抗学习方法中,重新训练网络模型,进一步提高模型的分割能力.在数据集上的分割实验表明文中方法的有效性.

About the Author:LU Feifei, master student. His research interests include computer vision, image processing and pattern recognition.

LONG Bangyao, master student. His research interests include computer vision, image processing and pattern recognition.

MIAO Jun, Ph.D., professor. His research interests include image based 3D reconstruction, image processing and pattern recognition.

图像语义分割是计算机视觉领域的重要研究课题之一, 旨在对输入图像中的每个像素进行精确分类并加以标注.分割结果的准确性对后续的自动驾驶、辅助医疗、行人检测、目标跟踪等场景理解的作用至关重要[1].近年来, 由于深度学习的发展及全卷积神经网络(Fully Convolutional Neural Network, FCN)[2]的出现, 各种算法在大量数据上学习提取图像特征, 大幅提升语义分割的精度, 使语义分割得到快速发展.FCN利用全卷积层代替网络末端的全连接层, 对任意大小的输入图像进行端到端的分割预测, 获得较好的分割结果.此后的语义分割方法大多在FCN的基本结构上进行改进.Lin等[3]和Ronneberger等[4]采用更精细的编码器-解码器(Encoder-Decoder)结构逐步恢复下采样时丢失的空间位置信息, 有效结合浅层细节信息和深层语义特征, 提高网络模型的分割精度.DeepLabv1[5]引入空洞卷积(Atrous Convolution), 在去除池化操作的同时有效扩大感受野.DeepLabv2[6]在DeepLabv1的基础上添加空洞卷积空间金字塔池化模块(Atrous Spatial Pyramid Pooling, ASPP).DeepLabv3[7]将ASPP模块级联, 获得逐渐提高的分割精度.双向注意力网络(Dual Attention Network, DANet)[8]分别引入位置注意力机制和通道注意力机制, 分别捕获空间维度和通道维度上的全局依赖关系, 捕获特征图中任意两个位置的空间关系, 获得更大范围的上下文信息, 使分割结果更精确.

上述各种分割算法中语义分割的精度严重依赖于大量的训练数据集及其精确标注, 而真实场景的精确标注通常需要以昂贵的人工为代价, 如Cityscapes数据集[9]上的单幅图像的标注时间大约为1.5 h, 5 000幅精确标注的图像将要耗费7 000 h.为解决数据集的获取及大量人工标注带来的巨大成本问题, 利用虚拟数据集训练得到分割网络模型, 虚拟数据集的获取及标注是十分廉价的.对于Richter等[10]制作的虚拟城市GTA5数据集, 每幅图像的标注时间仅为7 s.将虚拟数据集称为源域(Source Domain), 真实场景的数据集称为目标域(Target Domain), 源域和目标域在亮度、颜色、纹理等方面均存在一定差异, 称为域差异(Domain Gap).由于域差异的影响, 在带标签源域数据集上训练得到的网络模型很难泛化到无标签的目标域数据集上, 故真实场景的目标域图像的分割结果不够理想.

针对该问题, 学者们提出域自适应(Domain Adaptation)的城市场景语义分割的方法, 利用带标签的源域数据集和未带标签的目标域数据集训练网络模型, 训练目标不仅要在源域数据集上取得较好的分割效果, 而且也要在未带标签的目标域数据集上取得较好的分割效果.自训练(Self-training)方法[11, 12, 13]通过在源域数据集上训练获得的网络模型, 对无标签的目标域数据集生成伪标签, 利用这些伪标签重新训练模型, 提高跨域目标的语义分割精度.自集成(Self-ensembling, SE)[14, 15, 16]要求未带标签数据在不同扰动下可产生一致的预测, 常用于半监督学习与域自适应学习等少样本学习任务中.Mean teacher[14]利用教师(teacher)网络对学生(student)网络的输出结果进行指引与监督, 在半监督分类中获得较好的分类效果.Yu等[15]和Xu等[16]在mean teacher网络基础上添加模块, 分别用于半监督的3D心房分割与域自适应城市场景分割任务, 达到较好的分割效果.

生成对抗网络(Generative Adversarial Networks, GAN)[17]近年来常被用于解决域自适应分割问题.一方面, 基于循环一致性生成对抗网络(Cycle-Consistent GAN, CycleGAN)[18]的风格转换网络, 将源域数据集合成带有目标域风格的新数据集, 可有效减小源域和目标域的域间差异.另一方面, 通过对抗学习方法[19, 20, 21, 22, 23, 24]促使源域和目标域中样本对齐, 取得较好的跨域分割效果.

但是上述方法仍然存在如下问题:1)由于源域和目标域在亮度、颜色、纹理上存在较大的域间差异, 直接在源域和目标域的分割图上进行对抗学习会加大训练的难度, 增加对抗学习训练的不稳定性, 影响域自适应的分割效果.2)域自适应语义分割方法忽视目标域的域内差异, 导致分割精度不够理想.域内差异是指参与协同训练的不同网络对同一目标域进行分割时得到的结果之间的差异.

针对跨域分割存在的问题, 本文提出结合自集成和对抗学习的域自适应城市场景语义分割方法.对于源域和目标域的域间差异问题, 采用风格转换网络合成源域数据集, 得到带有目标域风格的数据集, 将其作为新的源域数据集, 在亮度、颜色、纹理上更接近目标域数据集.在图像层面进行风格转换后, 缩小源域和目标域的域间差异, 增加网络训练的稳定性, 促进后续对抗学习的快速收敛.针对目标域的域内差异问题, 提出结合自集成和对抗学习的方法, 将用于跨域分割的对抗学习主网络称为student网络, 对该网络的参数进行指数移动平均(Exponential Moving Average, EMA)[14], 构造相应的辅助网络, 称为teacher网络.一方面, 由于teacher网络是通过将student网络进行EMA获得, 分割能力得到加强.另一方面, 使用teacher网络指引和约束student网络, 减小目标域的域内差异, 提升student网络的分割性能.两个网络相互协同促进, 提高跨域分割精度和训练的稳定性.针对目标域数据集缺乏标签信息问题, 利用自训练的方法生成目标域的伪标签, 将伪标签加入对抗学习方法中, 重新训练网络模型, 进一步提高分割能力.

结合自集成和对抗学习的域自适应城市场景语义分割方法框架如图1所示.

在图1中, 蓝色箭头表示源域数据集的流向, 绿色箭头表示目标域数据集的流向, 红色实线表示目标域伪标签的获取, 红色虚线表示将获得的伪标签作为目标域的监督信息重新加入到对抗学习中.本文方法主要由风格转换网络、student网络、teacher网络、判别器网络D组成.风格转换网络用于合成带有目标域风格的源域数据集.student网络和判别器网络D用于对源域和目标域的分割图进行对抗训练.teacher网络用于在目标域分割图上对student网络进行进一步的监督与指引.

由于源域和目标域的域间差异问题, 若直接在源域与目标域分割图上进行对抗学习, 将加剧对抗学习训练的不稳定性, 对最终的分割精度产生不利影响.因此, 本文采用对源域数据集进行风格转换的方法, 在图像层面利用GAN对样本进行双向映射, 包括从源域到目标域及从目标域到源域的风格转换, 是对图像进行域自适应.图像层面是指输入图像, 进行风格转换后得到的输出仍为图像.本文风格转换目的是将源域“ 域自适应” 到目标域, 因此只取从源域到目标域风格转换的映射结果用于后续实验.本文的域自适应分割是指在特征层面(即分割图上)进行对抗学习, 使源域的分割图与目标域的分割图靠近.

将源域转换为带有目标域风格的新数据集, 大幅降低源域和目标域的域间差异, 如图1左侧所示.快速图像风格转换(Fast Photo Style Transfer, FastPhotoStyle)[25]在风格转换前后不会扭曲图像, 并保持转换前后图像的空间一致性, 使源域数据集的真实标注(Groundtruth)不会随源域的风格转换而变化, 因此本文采用FastPhotoStyle网络作为本文的风格转化网络.

FastPhotoStyle网络主要包括两个步骤:风格化步骤(Stylization Step)和平滑化步骤(Smoothing Step).传统风格转换网络将指定图像的风格转移到内容图像时, 最大池化操作减少特征图中的空间信息, 在解码器中简单地上采样, 无法有效恢复输入图像的位置信息.受到上池化可有效保留空间信息的启发, 风格化步骤利用上池化替代上采样, 可将丢失的空间信息传递给解码器, 重构丢失的细节信息, 最小化输出图像的结构伪影.平滑化步骤要求在局部邻域中具有相似内容的像素被相似地风格化, 平滑得到的结果不能明显地偏离风格化图像, 通过平滑化步骤使输出的图像看起来更自然.

本文定义域内差异是指分别使用协同训练的student网络和teacher网络分割同一目标域场景时得到的分割图的差异.针对域内差异问题, 本文采用自集成和对抗学习结合的思想, 在源域和目标域的输出分割图(即特征层面)上进行对抗训练, 促使源域分割图与目标域分割图靠近, 达到较好的域自适应分割效果.不同于对抗学习中的单个分割网络, 本文在对抗学习网络的基础上分别构造student网络、teacher网络.将用于跨域分割的对抗学习主网络称为student网络, 对该网络的参数进行EMA, 构造相应的辅助网络称为teacher网络.具体实现细节如下.

在对抗学习网络的基础上分别构造得到student网络(称为Fs网络)、teacher网络(称为Ft网络)和判别网络D, 如图1所示.Fs网络分别对源域和目标域进行分割预测, 判别网络D对源域和目标域的分割图, 做出判别后给出高分或低分, Ft网络仅对目标域进行分割预测.将风格转换后的带标签的源域数据集输入student网络, 得到的预测分割图与其真实标注进行交叉熵损失, 优化student网络对源域数据集的分割, student网络的分割损失函数为

其中,

将student网络得到的源域及目标域分割图分别输入判别网络D中进行对抗训练, 通过对抗学习不断减小源域和目标域之间的域间差异, 优化对目标域的跨域分割.在训练判别器D时, D接受student网络得到的源域S'的分割图, 对其学习并判给高分, 当其接受来自student网络得到的目标域T的分割图时, 对其学习后判给低分.D的判别损失函数为

LD=-

其中, 当z=0时表示采样于目标域, 当z=1时表示采样于源域,

Ladv=-

teacher网络参数是对student网络参数进行EMA得到的, teacher网络参数获取如下:

θ 't=α θ 't-1+(1-α )θ t, (4)

其中, θ 't为当前训练步骤下的teacher网络参数, θ t为当前训练步骤下的student网络参数, θ 't-1为前一训练步骤时teacher网络参数, α 为平滑系数超参数, 依据文献[14]设定, 实验中选定α =0.999.

对student网络进行EMA处理, 使teacher网络也具有分割能力.将未带标签的目标域数据集分别输入student网络和teacher网络, 通过teacher网络的目标域分割图对student网络的目标域分割图进行监督与指引, 此处选用KL散度[23]作为teacher网络和student网络得到的目标域分割图之间的一致性损失函数.依据文献[23]设定, 令

其中,

Lkl=-

一方面, 使用teacher网络约束student网络, 通过分割损失

值得注意的是, teacher网络的分割准确率并不一定都高于student网络, 但通过反复实验及文献[26]、文献[27]可知, 能力较差的teacher网络也可提供student网络必要的辅助信息, 从而提升student网络的分割能力.因此本文将SE应用到图像跨域分割中, 在目标域上利用teacher网络提供的软标签(Soft-Label)对student网络进行监督与指引, 提高student网络的分割稳定性和分割精度.

本文将未带标签的目标域训练集输入训练好的网络模型中, 得到伪标签(Pseudo-Label), 将该伪标签作为新的信息, 与源域数据集及其标签、目标域数据集, 同时重新输入到对抗网络中进行对抗学习, 不同于传统对抗学习方法, 本文增加对目标域训练集的监督训练, 即增加对目标域的监督损失

首先应用1.1节、1.2节方法训练得到网络模型, 对目标域训练集生成置信度掩码(Mask), 方法为:将概率值大于或等于设定阈值yT的像素类别归为预测类别, 小于阈值yT时忽略该预测类别,

M=

实验中阈值大小对伪标签具有关键作用, 数据集阈值yT的选定方法参照文献[13]方法, 对每个像素的预测概率值排序, 得到预测概率值的中间值.为了保证伪标签的准确性, 若此中间值大于或等于0.9时, 将阈值yT设定为0.9.为了保证伪标签不会过于稀疏, 若此中间值小于0.9时, 将阈值yT设定为预测概率值的中间值.经过这样的处理后, 生成的伪标签均较可靠, 对后续的对抗学习具有正面的辅助作用.

将掩码函数M与

PT=M

最终, 在对抗学习的基础上, 利用目标域的伪标签对目标域进行监督训练, 优化分割网络, 以Fs表示分割网络, Fs对目标域的分割损失函数为

在结合SE与对抗学习时, 判别网络的损失函数如式(2)所示, teacher网络参数的获取如式(4)所示, 结合式(1)、式(3)、式(5), 得到student网络的整体损失函数:

L1=λ seg

在结合目标域伪标签与对抗学习进行自监督学习时, 判别网络的损失函数如式(2)所示, 结合式(1)、式(3)和式(6), 得到分割网络的整体损失函数:

L2=λ seg(

其中:λ seg为分割损失系数, 设为1; λ adv为对抗损失系数, 设为0.001; Lkl为teacher网络对student网络的一致性损失函数; λ kl为系数, 通过多次实验设为0.1.

本文方法的时间复杂度主要包括分割网络与判别网络的损失值的计算.设本文算法的总循环次数为n, 分割网络对源域、目标域的分割损失计算的时间复杂度为O(n+n), teacher网络对student网络的一致性损失计算的时间复杂度为O(n), 判别网络对源域、目标域的判别损失计算的时间复杂度为O(n+n), 因此本文方法总的时间复杂度为O(5n), 即本文算法的时间复杂度为O(n).

选用与采用单级对抗训练的域自适应分割网络(Adapt Segment Network, AdaptSegNet)[19]相同的源域和目标域数据集进行实验, 即GTA5数据集[10]和SYNTHIA数据集[28]分别作为源域数据集, Cityscapes数据集作为目标域数据集.其中, GTA5数据集由24 966帧及其像素级标注的图像组成, 这些图像是基于美国洛杉矶和加州南部的视频游戏合成的, 实验中选择与Cityscapes数据集兼容的19个常见类别作为测试类别.SYNTHIA数据集是一个大型的虚拟城市视频序列数据集, 使用SYNTHIA-RA-ND-CITYSCAPES中包含的9 400幅带有像素级标注的图像, 实验中分别选择与Cityscapes数据集兼容的16个或13个常见类别作为测试类别.Cityscapes数据集包含来自德国及周边国家的50个城市的街道街景, 训练集中的2 975幅图像用于训练, 验证集中的500幅图像用于测试.

训练网络模型时, 利用来自GTA5数据集或SYNTHIA数据集的源域图像及其对应的标签, 以及Cityscapes数据集中未带标签的目标域数据集, 将训练得到的网络模型在Cityscapes数据集的验证集上进行测试评估.分别采用交并比(Intersection Over Union, IoU)和平均交并比(Mean IoU, mIoU)作为每个类别与整体性能测试的评价指标.

本文方法框架为PyTorch.相关实验均在基于Ubuntu18.04操作系统的NVIDIA 2080Ti显卡上运行.以残差网络101(Residual Network 101, ResNet-101)为主干的DeepLabv2[6]网络, 在ImageNet数据集上预训练后作为student网络Fs的基础网络, 对student网络Fs的参数进行EMA, 得到teacher网络Ft的参数.对于判别器网络D, 选择与AdaptSegNet相同的网络结构, 共包含5个4× 4的卷积层, 各层的通道数依次为64, 128, 256, 512, 1.在训练过程中, 选用动量为0.9的随机梯度下降法(Stochastic Gradient Descent, SGD)优化student网络Fs, 初始学习率设定为2.5× 10-4, 学习率衰减因子为

power设定为0.9.选用β 1=0.9, β 2=0.99的自适应矩估计算法( Adaptive Moment Estimation, Adam)优化判别网络D, 初始学习率设定为1.0× 10-4.在实验中, teacher网络对student网络的一致性损失函数的系数λ kl均设为0.1.

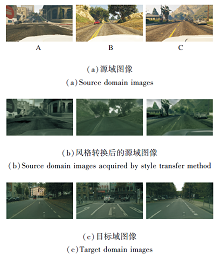

为了验证增加风格化网络转换的有效性, 采用3幅图像进行风格化实验, 对比视觉效果和开展定量分析.定量评价选用结构相似性(Structural Simila-rity Index, SSIM)和颜色直方图[22], 分析对比风格转换前后源域和目标域图像的相似性.转换前后的视觉效果如图2所示.

由图2可看出, 相比无风格转换的源域图像, 经过风格化后的源域图像, 与目标域图像在亮度、颜色及纹理上都更相近.本文方法通过风格化步骤最小化输出图像的结构伪影, 利用平滑化步骤使合成图像具有相似内容的像素被相似风格化, 从而实现源域和目标域的相互“ 靠近” , 有效减小两者的域间差异, 增加网络训练的稳定性, 促进后续对抗学习的快速收敛.

风格转换前后源域和目标域的定量结果如表1所示.由表可看出, 相比风格转换前的源域图像, 风格转换后的源域图像与目标域图像在SSIM和颜色直方图两个评价指标上都取得更高的分数, 表明采用风格转换可有效减小源域和目标域间的差异, 有利于后续的对抗学习, 增加网络训练的稳定性.

| 表1 风格转换前后源域图像与目标域图像的相似性度量对比 Table 1 Comparison of similarity between source and target domains before and after style transfer |

进一步, 将有无风格转换的源域数据集分别与目标域数据集进行域自适应分割实验.从源域数据集GTA5到目标域数据集Cityscapes, 对抗训练(Adversarial Training, AT)的mIoU值为41.4%, 风格转换(Style Transfer, ST)加上AT的mIoU值为45.6%, 提升4.2%.从源域数据集SYNTHIA到目标域数据集Cityscapes, AT的mIoU值为45.9%, ST+AT的mIoU值为47.5%, 提升1.6%.以上结果表明ST的有效性.由源域数据集SYNTHIA向目标域数据集Cityscapes的mIoU值提升较小, 这是因为源域和目标域存在的域差异更大.

为了验证本文方法的有效性, 首先进行由源域数据集GTA5到目标域数据集Cityscapes的域自适应分割实验.对比方法如下:类平衡自训练(Class Balanced Self-training, CBST)[11]、KL散度模型正则化(Model Regularized KL Divergence, MRKLD)[12]、双向学习(Bidirectional Learning, BDL)[13]、Adapt-SegNet[19]、类别级别对抗网络(Category-Level Adver-sarial Network, CLAN)[20]、熵对抗训练(Adversarial Entropy, AdvEnt)[21]、记忆正则化(Memory Regulari-zation, MRNet)[23]、域内适应(Intradomain Adapta-tion, IntraDA)[24].实验结果如表2所示, 表中黑体数字为最优值, No adapt为无域自适应分割方法.

| 表2 GTA5→ Cityscapes上不同方法的分割结果对比 Table 2 Comparison of different segmentation results with GTA5 to Cityscapes |

从表2可看出, 本文方法的mIoU值最高, 达到49.4%, 比No adapt提升12.8%, 比AdaptSegNet提升8%.在sidewalk、wall、fence、pole、bus、bike类别中mIoU值均提升10%以上.

图3给出以GTA5 为源域, 以Cityscapes为目标域的域自适应分割的视觉效果.

| 图3 GTA5→ Cityscapes的域自适应分割结果对比Fig.3 Segmentation results comparison of domain adaptation methods for GTA5 to Cityscapes |

由分割图可直观发现, 本文方法在wall、sidewalk、pole类别上分割准确率明显优于AdaptSegNet.此外, 本文方法取得的分割效果在一定程度上更接近真实标注.

为了进一步验证本文方法的有效性, 再进行由源域数据集SYNTHIA到目标域数据集Cityscapes的域自适应分割实验.对比方法如下:CBST[11]、AdaptSegNet[19]、CLAN[20]、AdvEnt[21]、IntraDA[24].实验结果如表3所示, 表中黑体数字为最优值.在表中, mIoU(16)表示16个类别上的平均交并比, mIoU(13)表示13个类别上的平均平均交并比.

由表3可发现, 相比No adapt, 本文方法mIoU值提升11.6%.相比AdaptSegNet, 本文方法mIoU值提升4.3%.

| 表3 SYNTHIA→ Cityscapes上不同方法的分割结果对比 Table 3 Comparison of different segmentation results with SYNTHIA to Cityscapes |

消融实验的目的是为了验证本文方法每个阶段的作用, 分别由源域数据集GTA5、SYNTHIA到目标域数据集Cityscapes进行跨域实验.

由源域数据集GTA5 到目标域数据集Cityscapes的跨域分割的实验结果如表4所示, 表中SSL表示自监督训练方法(Self-supervised Learning), target only表示在目标域上训练与测试得到的分割结果.从表可看出, 仅在源域数据集训练的No adapt的mIoU值为36.6%, AdaptSegNet在输出分割上加入单极对抗训练, mIoU值达到41.4%, 在AdaptSegNet单级对抗学习的基础上加入SE, 在目标域数据集上利用teacher网络对student网络的监督与指引, 有效降低目标域的域内差异, 经过参数调优后, 在目标域Cityscapes数据集的mIoU值为43.8%, 相比AdaptSegNet, 提升2.4%.在此基础上继续加入ST, 有效缩小源域和目标域之间的差异, mIoU值达到46.3%.利用此方法对目标域生成伪标签, 将伪标签加入模型中重新进行对抗训练, 采用对目标域进行监督训练的方法, mIoU值达到49.4%.通过多次实验, 发现在迭代10 000次之前, 加入teacher网络对student网络的监督与指导, mIoU值基本没有提升, 这是由于teacher网络和student网络的学习能力不足, 此时不需加入teacher网络对student网络进行监督指导.当迭代到10 000次时, 再增加teacher网络对student网络的监督与指导, 实现对student网络的正则化一致性约束.当迭代到30 000次时, Lkl损失趋于收敛, 模型的训练达到收敛.本文在10 000~30 000次迭代之间加入teacher网络对student网络的一致性监督与指导.

| 表4 域自适应分割消融实验结果 Table 4 Ablation experiments of segmentation adapting to Cityscapes |

进一步进行由源域SYNTHIA 到目标域Cityscapes的跨域分割实验, 结果也如表4所示, 与源域GTA5上的实验结果一致.

实验发现, 在开始加入teacher网络对student网络的监督与指导时, Lkl损失值一直趋于降低趋势, 并于100 000次达到稳定.所以本文在0~100 000次迭代之间加入teacher网络对student网络进行一致性监督与指导.

超参数的选定对实验结果具有重要作用, 通过多次实验确定式(7)中的一致性损失函数的系数λ kl的选择.在源域数据集GTA5到目标域数据集Cityscapes的跨域分割实验中, 当λ kl=0.1时, mIoU值达到最高值(43.8%), 比未采用SE(λ kl=0)时mIoU值(41.4%)提升2.4%.当λ kl=0.2时, mIoU值为42.8%, 比λ kl=0时mIoU值提升1.4%.当λ kl=0.05时, mIoU值为42.2%.当λ kl=0.025时, mIoU值为42.0%.当λ kl=0.01时, mIoU值为42.3%.进一步在源域SYNTHIA到目标域Cityscapes的跨域分割实验上进行验证, 结果同样表明当λ kl=0.1时, 取得最高的mIoU值.此外, 在较宽泛的合理系数范围内, SE与对抗学习结合的方法可提高方法的分割精度, 说明本文方法具有较高的鲁棒性.

本文提出结合自集成和对抗学习的域自适应城市场景语义分割方法.对于源域和目标域的域间差异, 采用风格转换网络合成在颜色、亮度和纹理上与目标域更接近的新数据集, 并将其作为网络模型的源域数据集, 有效减小源域和目标域的域间差异, 提高目标域的分割精度.针对目标域的域内差异问题, 在对抗学习的基础上引入SE, 利用teacher网络对student网络在目标域分割上通过一致性约束损失进行约束与监督, 减小目标域数据集的域内差异, 提高跨域分割精度.此外, 利用自训练的方法得到目标域的伪标签, 加入网络模型中重新进行训练, 进一步提高跨域分割能力.实验结果表明本文方法有效缓解域自适应语义分割存在的较大域间差异、对抗训练不稳定等问题, 分割精度较优.为了避免student网络从teacher网络中学习到重复的知识而导致性能下降, 今后考虑在网络训练中增加teacher网络和student网络之间的差异性, 使student网络从能力更强的teacher网络中学习更可靠的知识.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|