杨 勇,博士,教授,主要研究方向为图像处理、深度学习.E-mail:greatyangy@126.com.

作者简介:

黄淑英,博士,副教授,主要研究方向为图像处理、机器学习.E-mail:shuyinghuang2010@126.com.

汪 斌,硕士研究生,主要研究方向为深度学习、低质量图像增强、图像去雾.E-mail:wantbe5@163.com.

李红霞,硕士研究生,主要研究方向为图像去雾、图像亮度增强.E-mail:isabella_oath@163.com.

胡 威,硕士研究生,主要研究方向为图像去雾、图像增强.E-mail:hw_jufer@163.com.

与基于图像增强的去雾算法和基于物理模型的去雾算法相比,基于深度学习的图像去雾方法在一定程度上提高计算效率,但在场景复杂时仍存在去雾不彻底及颜色扭曲的问题.针对人眼对全局特征和局部特征的感受不同这一特性,文中构建基于生成对抗网络的图像去雾算法.首先设计多尺度结构的生成器网络,分别以全尺寸图像和分割后的图像块作为输入,提取图像的全局轮廓信息和局部细节信息.然后设计一个特征融合模块,融合全局信息和局部信息,通过判别网络判断生成无雾图像的真假.为了使生成的去雾图像更接近对应的真实无雾图像,设计多元联合损失函数,结合暗通道先验损失函数、对抗损失函数、结构相似性损失函数及平滑L1损失函数训练网络.在合成数据集和真实图像上与多种算法进行实验对比,结果表明,文中算法的去雾效果较优.

YANG Yong, Ph.D., professor. His research interests include image processing and deep learning.

About Author:

HUANG Shuying, Ph.D., associate professor. Her research interests include image processing and machine learning.

WANG Bin, master student. His research interests include deep learning, low-quality image enhancement and image dehazing.

LI Hongxia, master student. Her research interests include image dehazing and low-light image enhancement.

HU Wei, master student. His research interests include image dehazing and image enhancement.

Compared with the image dehazing methods based on image enhancement or physical model, the current image dehazing methods based on deep learning improve the computational efficiency to a certain extent. Nevertheless, the problems of incomplete dehazing and color distortion still exist in complex scenes. Aiming at the different perceptions of human eyes on global and local features, an algorithm of image dehazing based on generative adversarial networks is proposed. Firstly, a multi-scale generator network is designed. The full-size image and the segmented image block are taken as the input to extract the global contour information and local detail information of the image. Then, a feature fusion module is constructed to fuse the global and local information, and the authenticity of the generated dehazing image is judged by the discriminant network. To make the generated dehazing image closer to the corresponding real haze-free image, a multivariate joint loss function is designed by combining the dark channel prior loss, the adversarial loss, the structural similarity loss and the smooth L1 loss to train the network. Experimental results show that the proposed algorithm is superior to some state-of-the-art dehazing algorithms.

本文责任编委 黄 华

Recommended by Associate Editor HUANG Hua

雾霾天气下户外悬浮着大量的气溶胶粒子, 目标物体辐射的光线在传输到相机设备的过程中会受到这些粒子的折射、散射及吸收等作用, 使相机设备拍摄的图像呈现较低的对比度和饱和度, 导致获取图像丢失大量的细节信息[1].这种类型的图像降质对于图像的后续处理(如目标识别、场景检测、室外监测等)带来极大的困扰, 需要应用图像去雾技术进行处理.图像去雾的主要目的是通过增强图像的对比度, 恢复图像的颜色和细节信息, 消除雾气对图像质量的影响.

目前, 图像去雾算法主要分为三类:基于图像增强的去雾算法、基于物理模型的去雾算法、基于深度学习的去雾算法.基于图像增强的去雾算法是指在去雾过程中不考虑有雾图像形成的物理模型, 只通过一些图像处理技术增强有雾图像的对比度和饱和度, 使图像质量在视觉效果上得到一定提升.这类算法主要包括直方图均衡化算法[2]、基于Retinex理论的图像去雾算法[3]、基于同态滤波的去雾算法[4]、基于小波变换[5]的去雾算法.基于图像增强的去雾算法执行简单、速度较快, 却忽略有雾图像的降质因素, 获得的去雾图像容易出现局部增强过度、颜色失真、光晕伪影等问题, 无法取得令人满意的去雾效果.

大气散射模型的建立为有雾图像的成像过程提供强有力的理论支撑, 使基于物理模型的图像去雾技术取得重大突破.该类去雾技术主要通过合理的假设和先验知识估计模型中的透射率, 进而反演大气散射模型, 得到去雾后的图像.Tan等[6]基于有雾图像的对比度低于无雾图像的特点, 利用马尔科夫随机场(Markov Random Field, MRF), 最大化图像中每个局部块的对比度, 去除图像中的雾, 但在处理深度不连续的区域时容易产生伪影, 会出现去雾图像颜色的过饱和现象.He等[7]提出暗通道先验算法(Dark Channel Prior, DCP), 证明无雾图像非天空区域的图像块中最暗的像素值接近于0.利用这一先验及一个小图像块中透射率是恒定的这一假设, 可估计粗略的透射率图, 再利用软抠图(Soft Matting)操作平滑透射率图, 重建最终的去雾图像.

在DCP的基础上, 后续的一些工作进一步提高暗通道先验去雾算法的质量和效率.Meng等[8]对透射率图执行一个边界约束, 结合该约束和基于上下文正则化的L1范数, 对透射率图进行求解和估计.Zheng等[9]提出基于分块自适应多曝光图像融合的去雾算法(Dehazing Based on Patch Adaptive Multi-exposure Image Fusion, DePAMEF), 通过伽马校正和空间线性调整, 得到一系列有雾图像的欠曝光图像, 再采用自适应结构分解的多曝光图像融合方案得到无雾图像.Ju等[10]提出基于伽马校正先验的图像去雾算法, 利用该先验对有雾图像进行预处理, 再通过全局策略和视觉指导恢复透射率图, 实现图像去雾.

这些去雾算法虽然可恢复良好的图像细节, 但当采用的假设和先验在一些特定场景下不成立时, 会造成去雾后的图像过饱和、颜色失真及处理天空区域困难等问题.此外, 此类算法大多需要繁琐的优化和求解过程, 计算代价昂贵, 不能较好地用于实时设备中.

深度学习拥有的强大特征学习能力, 可提高图像去雾的处理效率及图像的视觉质量.Cai等[11]提出名为DehazeNet的图像去雾网络, 端到端地估计透射率图, 并通过大气散射模型求解无雾图像.Li等[12]重新定义大气散射模型, 在此基础上设计轻量级的一体式除雾网络(All-in-One Dehazing Network, AODNet), 这种轻量级设计使网络可嵌入其它深度模型中, 进一步提高去雾图像在高级别视觉任务中的性能.Chen 等[13]提出门控上下文聚合网络(Gated Context Aggregation Convolution Neural Network, GCA-Net)去雾算法, 利用平滑扩张卷积解决网格伪影问题, 并采用门控融合子网络融合底层信息和高层信息, 增强最终的去雾效果.同样地, Liu等[14]也设计端到端的通用模型无关网络(Generic Model-Agnostic Network, GMAN), 由于不依赖大气散射模型, 可用于其它的图像恢复任务的训练.

生成对抗网络(Generative Adversarial Networks, GAN)现已广泛用于图像生成、恢复及重建.Qu等[15]设计端到端生成对抗网络去雾算法(Enhanced Pix2pix Dehazing Network, EPDN), 利用多分辨率生成器生成一个从粗到细的图像, 通过两个多尺度判别器分别在粗尺度和细尺度上监督生成器生成更真实的无雾图像, 最后由一个增强器重建图像细节.受到可微分方程的启发, Zhu等[16]将大气散射模型重新规划成一个GAN, 通过对抗式的学习获得大气散射模型中的透射率和大气光值, 生成颜色真实和细节丰富的无雾图像.Engin等[17]提出名为Cycle Dehaze的端到端去雾网络, 在循环生成对抗网络(Cycle GAN, CycleGAN)的基础上结合循环一致性损失和感知损失, 提高恢复后的纹理信息的质量, 并生成视觉上更好的无雾图像.Yang等[18]提出端到端的无监督解耦和去雾网络模型, 用于生成无雾图像, 还引入基于物理模型的解耦和重建机制, 克服训练数据不足的约束.

由于在复杂场景下拍摄的图像往往包含丰富的信息, 单尺度的特征提取网络会遗漏一些重要信息, 因此学者们提出一些多尺度网络.Ren等[19]设计多尺度卷积神经网络(Multi-scale Convolutional Neural Network, MSCNN), 学习有雾图像和其对应的透射率图之间的映射关系, 实现图像去雾.该模型虽然利用多尺度的策略, 但对一些密集目标场景的透射率图估计不够准确, 导致去雾不够彻底.Zhang等[20]提出快速准确的多尺度端到端去雾网络(Fast and Accurate Multi-scale End-to-End Dehazing Network, FAMED-Net), 由三个尺度的编码器和一个融合模块组成, 每个编码器通过一个密集连接的机制由级联的点状卷积层和池化层组成.由于充分利用点的结构, 可实现快速高效的图像去雾.Dong等[21]提出基于U型网络(U-Net)结构的具有密集特征融合的多尺度增强去雾网络, 利用不同尺度的特征, 提高网络性能.Yeh等[22]提出基于图像分解的去雾网络, 将图像分解为内容层和细节层, 设计多尺度深度残差网络和简化的U-Net网络, 学习去雾后的内容层.

上述多尺度网络虽然可通过提取不同的特征提高网络性能, 但在一些景深复杂的场景, 大多数算法并未考虑图像的局部信息, 导致去雾后的图像存在细节丢失的问题.由于GAN在图像生成和重建方面的独特优势, 本文提出基于GAN的图像去雾算法.根据人眼对图像的全局场景和局部场景关注点不同这一视觉特性, 构建基于全局特征与局部特征学习的去雾生成网络, 保证生成的去雾图像保留更丰富的细节信息.在生成器网络中, 设计多尺度特征提取网络, 利用不同的网络输入, 学习图像的全局特征与局部特征, 并通过特征融合生成去雾图像.构建一个二分类的判别器, 学习网络的判别损失, 并结合暗通道先验损失、结构相似性(Structure Similarity, SSIM)损失及平滑L1损失, 设计多元联合损失函数, 指导生成器的训练.多个损失函数的联合使用较大程度上避免网络训练时严重依赖有限的合成数据集的问题.最后通过实验验证本文算法的去雾效果.

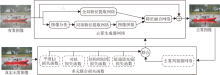

利用GAN在图像风格学习与特征生成方面的优势, 本文将有雾图像和无雾图像视作两种不同风格的图像, 设计基于GAN的图像去雾算法.整个算法框架如图1所示.算法主要包含基于全局特征与局部特征学习的去雾生成网络和去雾判别网络两部分.去雾生成网络由全局特征学习网络、局部特征学习网络和特征融合网络组成.

针对人眼对全局特征和局部特征的感受不同这一特性, 本文在设计生成器网络时, 构建全局特征提取网络和局部特征提取网络两个子模块, 分别提取有雾图像的全局轮廓特征和局部细节特征.两个模块采用同一个多尺度网络结构, 提取图像不同尺度的特征, 匹配全局特征与局部特征变化.本文还设计特征融合网络, 融合提取的全局特征和局部特征, 最后利用一个快捷连接将网络整体的残差和输入的有雾图像进行相加, 得到生成的去雾图像.具体数学公式可定义为

其中,

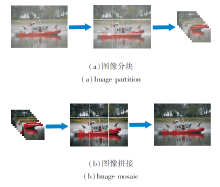

1.1.1 图像分块与拼接

全局特征提取模块的输入是原始尺寸的有雾图像, 而局部特征提取网络的输入是将原始尺寸的有雾图像进行分块操作后的图像块.为了充分利用相邻图像块之间的信息特征, 采用9个图像块之间相邻部分重叠2个像素点(重叠像素点根据全局图像的大小自适应计算)的方式进行分块.局部特征提取网络对有雾图像块进行特征提取, 输出一系列局部特征图, 这些局部特征图通过相邻位置重叠2个像素点、重叠部分取2个图像块对应像素值的平均值作为新的像素值的形式进行拼接, 从而得到和全局特征图尺寸一致的特征图.以拼接后的局部特征图和全局特征图作为特征融合网络的输入, 得到融合特征.图像分块和拼接操作如图2所示.

1.1.2 多尺度特征提取网络

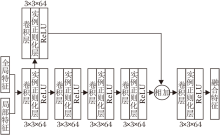

不同尺度下的图像包含的纹理信息不同, 大尺度的特征图包含更多的细节信息, 但语义信息相对较弱; 小尺度的特征图语义信息较强, 但分辨率较低, 对细节的感知能力较差.因此, 为了更好地提取图像的特征, 本文定义多尺度特征提取网络, 提取图像不同尺度的特征, 网络结构如图3所示.

多尺度特征提取网络通过三个分支实现特征提取, 每个分支具有不同尺度.第一个分支是对原尺度图像进行特征提取, 第二个分支是对原尺度特征图降采样一次后的特征图进行特征提取, 第三个分支是对原尺度特征图降采样两次后的特征图进行特征提取.

多尺度特征提取网络的实现过程如下.首先, 有雾图像(或有雾图像块)通过卷积层获得原尺度的特征图, 这些特征图被依次送入三个不同尺度的特征提取模块.每个模块均由四个卷积层构成, 它们的主要区别在于特征图的尺寸依次递减, 而特征图的通道数依次递增.由于不同模块输出的特征图尺寸不同, 因此需要对其进行反卷积操作, 恢复到下采样之前的尺寸.具体地, 第三层特征提取模块通过一个反卷积操作获得上采样后的特征图, 并与第二层特征图合并得到最终的二级尺度特征图, 再将其反卷积获得与原始图像尺寸相同的特征图, 最后与第一层模块输出的特征图合并, 得到一级尺度特征图.为了充分利用网络的浅层信息, 还利用快捷连接将第一个卷积层的特征图与最后的特征图相加, 得到整个特征提取网络的输出特征图.

为了更清晰地展示多尺度特征提取网络细节, 本文构建详细的参数列表, 如表1所示.表中Conv表示卷积层, IN表示实例正则化层, ReLU表示激活函数层, DeConV表示反卷积层, W和H表示图像的宽度和高度.

| 表1 特征提取子网络结构参数表 Table 1 Parameters of feature extraction subnetwork structure |

为了构建多尺度特征网络, 采用步长为2的卷积实现下采样, 提取不同尺度的特征后, 又利用步长为2的反卷积实现上采样.

1.1.3 特征融合网络

分块得到的图像块经过多尺度特征提取网络后再执行一次拼接操作, 得到与原始有雾图像尺寸相同的特征图.该特征图与全局特征网络输出的特征图合并成6个通道, 送入一个特征融合网络, 实现全局特征和局部特征的融合.

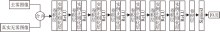

特征融合网络的结构如图4所示.网络主要包含五个卷积层和一个过渡卷积层.

过渡卷积层的主要作用是将网络浅层的特征向深层传递, 并与四个卷积层提取的特征相加, 实现特征的增强.相加后的特征图又经过一个卷积层, 得到融合网络的输出.

在图1所示的网络训练阶段, 去雾判别网络和去雾生成网络之间是相互监督的关系.合并生成网络的去雾结果和真实无雾图像, 送入去雾判别网络中进行软分类, 得到去雾结果接近真实无雾图像的概率值.软分类即判别网络的输出结果并非0或1, 而是一个属于[0, 1]的值, 分数越接近1表示去雾结果越接近真实无雾图像, 否则去雾效果越差.

本文利用判别网络的输出值指导生成网络的训练, 使生成网络下一次迭代的生成图像向更接近真实无雾图像的方向收敛学习, 而判别网络为了提高自身的判断能力, 也在每次的迭代中不断更新网络参数, 区别生成图像和真实无雾图像之间的特征, 如此循环迭代, 直到判别网络无法分辨生成网络生成的去雾图像和真实无雾图像之间的区别时, 训练结束.

去雾判别网络的结构如图5所示, 网络为一个卷积二分类网络, 每个模块仅包含卷积层、实例正则化层和ReLU层.

众所周知, 网络模型最终的测试效果好坏除了取决于训练集和网络框架本身之外, 还在很大程度上受训练时采用的损失函数影响.因此, 急需构建一个更好的与去雾任务匹配的损失函数.目前基于深度学习的图像复原任务多采用通用的平滑L1损失函数、均方误差损失函数及结构相似度(SSIM)损失函数[23], 而这些损失函数并没有专门针对有雾图像和无雾图像之间雾的感知变化的定义.为了使网络在训练时能更稳定快速地收敛并产生更好的去雾效果, 本文定义一个多元联合损失函数:

其中, A_loss表示对抗损失函数, smoothL1_loss表示平滑L1损失函数, ssim_loss表示SSIM损失函数, DCP_loss表示暗通道先验损失函数, α 、β 、λ 、η 表示损失函数对应的权重值.为了保证各项损失值具有相同的数量级, 根据实验将权重值分别设置为α =0.05, β =1, λ =1, η =2.5.

1.3.1 对抗损失函数

令$J_i$(i=1, 2, …, N)表示真实无雾图像, $J_i$(i=1, 2, …, N)表示生成器G输出的去雾图像.在优化生成器时, 本文希望生成器输出的去雾图像$J_i$无限逼近真实无雾图像, 即将$J_i$送入判别器时, 判别器的输出D($J_i$)越大越好, 该过程可用对抗损失表示为

其中N表示网络每次迭代时的样本数量.

优化判别器D时, 如果输入为$J_i$, 判别器的输出D($J_i$)越大越好, 而输入为$J_i$时, 则D($J_i$)越小越好, 即1-D($J_i$)越大越好.因此通过使两项的和最大优化判别器D:

1.3.2 平滑L1损失函数

由于L1损失函数有折点, 容易导致训练的不稳定平滑, 因此本文设计平滑L1损失函数, 衡量去雾图像和真实无雾图像的差异, 通过最小化平滑L1损失函数实现模型的训练, 损失函数定义如下:

令e=$J_i$-$J_i$为两幅图像像素的差值, 函数

1.3.3 结构相似性损失函数

SSIM是衡量两幅图像之间结构相似性的指标, 从亮度、对比度、结构三方面度量图像的相似程度.相比评价图像的另一个指标峰值信噪比(Peak Signal to Noise Ratio, PSNR)[24], 在评价图像质量上更符合人类的视觉特性.因此, 为了使输出的去雾结果更接近真实标准, 本文利用结构相似度构建一个损失函数, 通过最小化结构相似性损失函数优化网络.定义如下:

其中, SSIM为图像a、b之间的结构相似性指标,

其中, $μ _a$、$μ _b$表示两幅图像的均值, $σ _a$、$σ _b$表示两幅图像的标准差, $σ _{ab}$表示两幅图像的协方差, $C_1$、$C_2$为常数, 用于避免分母为0的情况出现.

1.3.4 暗通道先验损失函数

暗通道先验是在对大量室外无雾图像的观察下发现的一种图像像素规律[7].该规律表明, 在大多数的非天空区域图像中, 至少会存在一个颜色通道在某些像素处具有非常低的强度, 而每个位置的最低强度像素构成的通道称为暗通道.当去雾图像和真实无雾图像之间无限接近时, 它们的暗通道也一定越来越接近.基于此推论, 本文设计基于暗通道先验的损失函数, 通过最小化暗通道损失函数优化网络.损失函数定义如下:

其中, $J^{dark}_i$表示去雾图像$J_i$的暗通道图像, $J^{dark}_i$表示真实无雾图像$J_i$的暗通道图像,

其中, Ω (x)表示为以像素索引x为中心的局部图像块, y表示图像块中所有的像素索引, r、g、b表示彩色图像的3个通道.

本文算法基于PyTorch框架进行搭建, 在NVI-DIA 1080Ti的GPU上进行训练和测试.在训练阶段, 采用自适应矩估计(Adaptive Moment Estimation, Adam)优化器, 网络初始学习率设置为0.000 5.由于受到显存大小的限制, 训练的图像批尺寸设置为20, 网络中训练的图像尺寸统一为256× 256.网络内部的卷积层采用ReLU作为激活函数, 输出层的激活函数为Sigmoid, 网络训练到300个迭代周期时收敛并达到理想效果.

本文采用的训练图像库主要为RESIDE数据集[25]上筛选的7 500对有雾图像与无雾图像, 包括7 000幅室内场景图像和500幅室外场景图.用于测试的合成数据集包括200幅室内有雾图像和200幅室外有雾图像.

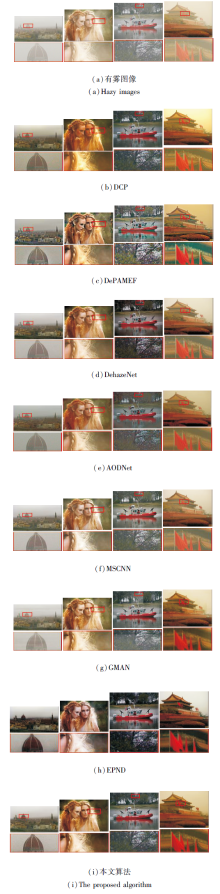

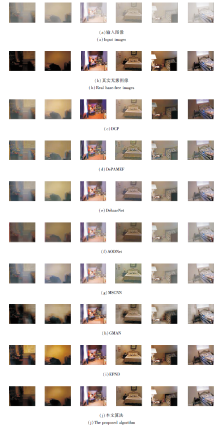

本文在合成有雾数据集和真实场景有雾图像上验证算法的有效性.对比算法如下:DCP[7]、DePAMEF[9]、MSCNN[19]、DehazeNet[11]、AODNet[12]、GMAN[14]、EPDN[15].此外, 为了证实本文算法的性能优势, 采用PSNR、SSIM、CIEDE2000[26]等质量评估指标进行定量评价.

本节利用合成数据集评估算法效果.不同去雾算法在室内合成数据集上的去雾结果如图6所示.图像(b)为真实清新的无雾图像.

由图6可看出, DCP可在一定程度上去除图像中雾的遮罩, 但去雾图像容易出现偏色现象, 如第3列和第6列图像.De-PAMEF在去雾的同时会造成图像风格失真, 产生令人不愉悦的视觉效果.DehazeNet、AODNet、MSCNN去雾并不彻底, 明显还有很多残留的雾, AODNet的去雾结果出现细节被模糊的问题.GMAN去雾较彻底, 但出现严重的块效应, 在大多数去雾结果中都存在严重的块状伪影.EPDN的去雾结果很接近真实无雾图像, 但在去雾过程中引入噪声, 如第2列去雾结果.本文算法的去雾结果既可较好地去除雾的影响, 还在很大程度上恢复图像本来的颜色和细节信息, 更接近真实无雾图像.

| 图6 各算法在室内合成数据集图像上的去雾结果Fig.6 Image dehazing results of different algorithms on indoor synthetic dataset |

不同方法在室外合成数据集上的去雾结果如图7所示, 最后两列为不同算法对浓雾图像去雾的对比结果.由图可看出, DCP可将非天空区域的雾去除干净, 但是由于暗通道先验在非天空区域不成立, 导致透射率估计不准确, 天空区域容易出现伪影和颜色失真等问题.DePAMEF可去除图像中的大部分雾, 但由于锐化过度, 造成一定程度上的风格失真.DehazeNet、AODNet、MSCNN可较好地恢复图像的颜色信息, 但这三种算法去雾都不彻底, 图像中存在雾的残留.GMAN、EPDN对颜色的恢复较好, 能产生接近真实无雾图像的效果, 但容易产生块状伪影, 天空区域尤为严重.本文算法的去雾结果和真实无雾图像更接近, 无论是细节恢复还是颜色保留方面都优于对比算法.

此外, 通过对比最后两列图像的去雾结果可看出, 本文算法也能较好地去除浓雾场景中的雾, 而MSCNN、AODNet去雾不彻底, DCP、DePAMEF去雾结果出现明显的偏色现象.

| 图7 各算法在室外合成数据集图像上的去雾结果Fig.7 Image dehazing results of different algorithms on outdoor synthetic dataset |

为了更客观地验证本文算法的有效性, 各算法的定量评估结果如表2所示, 表中3个质量评价指标的值是取RESIDE仿真数据集中200幅室内图像和200幅室外图像的测试结果的平均值, 黑体数字

| 表2 各算法在RESIDE数据集上的定量评估结果 Table 2 Quantitative evaluation results of different image dehazing algorithms on RESIDE dataset |

表示最优结果.对比表2中的数据可发现, 本文算法在室内数据集和室外数据集上都能得到最高的指标值.基于上述分析可看出, 本文算法在主观评价指标和客观指标上都优于大多数去雾算法.

为了进一步验证本文算法在真实场景上的适用性, 选取4幅典型的真实场景有雾图像, 对比各算法的去雾结果, 具体如图8所示, 图中各子图下面的图像为4组图像中红色框线区域的局部放大图.由图可看出, DCP在处理前景区域的雾时可媲美大多数基于深度学习的图像去雾算法, 在一些非天空区域甚至优于一些基于深度学习的去雾算法, 但在大多数测试结果中的天空区域会出现颜色失真, 在一些边缘区域还会出现光晕伪影, 所以在整体上去雾结果不能达到较好的视觉效果.DePAMEF能去除图像中的大部分雾, 同时增强图像的对比度, 但由于锐化过度, 使图像的风格发生改变, 在图像中一些区域(如第3列图像中船的底部和第4列图像局部放大区域)出现颜色失真现象.

由于对透射率值估计偏高, DehazeNet的去雾结果在一些区域过暗.AODNet去雾时不能较好地恢复图像细节, 容易造成细节模糊和偏色.MSCNN去雾不够彻底, 在大多数去雾结果中仍存在大量的雾.GMAN虽然在合成数据集上能得到较好结果, 但在大多数真实场景下的测试效果并不理想, 图像去雾不够彻底, 在一些区域还产生明显的棋盘状伪影, 很大程度上影响视觉效果.EPDN对图像中的雾去除较干净, 但在去雾过程中造成局部区域模糊和偏色现象.本文算法在去雾效果上最优, 既能去除图像中的雾, 也避免因为去雾过度导致前景区域变暗、细节变得模糊等问题, 在远景区域和近景区域都能产生更好的视觉效果.

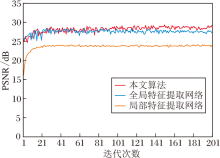

为了验证本文设计的网络结构中各个组件的有效性和合理性, 设计一组在RESIDE室外合成数据集上的消融实验, 分别为:只利用全局特征提取网络进行图像去雾、只利用局部特征提取网络进行图像去雾、结合全局特征提取网络和局部特征提取网络进行图像去雾(即本文算法).

各特征在训练过程中对应的PSNR变化情况如图9所示.由图可看到, 只利用局部特征提取网络的性能远低于只利用全局特征提取网络及本文算法的性能, 而结合两种网络的性能最优, 因此说明本文算法将全局特征和局部特征进行信息整合的方式可达到去雾效果提升的目的.

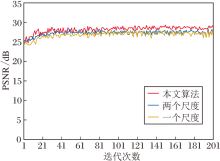

在训练过程中本文算法使用不同尺度的特征提取网络的PSNR值的变化曲线如图10所示.由图可看出, 随着网络尺度的增多, 网络性能也相应有所提升, 这是由于两次降采样后提取的小尺度特征图拥有更精确的语义信息, 增加图像特征的完整性.因此, 相比单尺度的特征提取, 多尺度网络可提取更精细的语义信息, 对细特征进行补充, 在网络性能方面优于单尺度和两个尺度的特征提取网络.

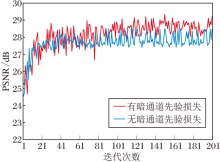

除了验证网络结构和各种组件的必要性外, 本文还设计使用和不使用暗通道先验损失函数的消融实验.暗通道先验损失消融实验在训练过程中对应的PSNR变化曲线如图11所示.由图可看出, 加入暗通道先验损失函数在提升网络性能方面明显优于不使用暗通道先验损失函数.

为了评估本文算法的计算复杂度, 对比各算法在处理单幅512× 512的有雾图像时需要的平均耗时.DehazeNet、MSCNN的运行平台为Matlab, AOD-Net、GMAN、EPDN、本文算法的运行平台为Python.各算法的平均耗时如下:DehazeNet为1.78 s, AOD-Net为0.015 s, MSCNN为1.89 s, GMAN为1.03 s, EPDN为0.201 s, 本文方法为0.176 s.由此可得, 本文算法在时间上也具有很强的竞争性.

本文将有雾图像到无雾图像的映射看作是一种不同图像风格的迁移, 提出基于GAN的图像去雾算法.根据人眼观察事物的视觉特性, 提出基于全局特征与局部特征学习的去雾生成网络, 在生成网络中设计多尺度结构的网络模块进行特征提取.针对网络的训练问题, 本文还设计卷积二分类网络作为GAN的判别网络, 判别去雾图像与真实无雾图像的真假以实现网络的训练.为了使生成的去雾图像更逼近真实的无雾图像, 同时, 使网络训练时不严重依赖有限的合成数据集, 本文设计多元联合损失函数, 结合对抗损失函数、暗通道先验损失函数、结构相似性损失函数及平滑L1损失函数训练网络.最后在合成数据集和真实数据集上通过实验证实本文算法无论在客观指标还是在主观视觉效果上均取得较优结果.由于现有的图像去雾数据集都是基于大气散射模型合成的, 而在现实场景下很多雾霾的形成更复杂, 因此今后还需要扩充不同场景下更贴近现实的数据集.此外, 研究适合移动终端的轻量级图像去雾模型也是未来的方向.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|