赵中英,博士,副教授,主要研究方向为社交网络分析、数据挖掘.E-mail:zzysuin@163.com.

作者简介:

秦海盈,硕士研究生,主要研究方向为异质信息网络表示学习及应用.E-mail:hiayingq@126.com.

李建晖,硕士研究生,主要研究方向为网络表示学习、推荐系统.E-mail:lijianhui0320@foxmail.com.

李 超,博士,副教授,主要研究方向为大数据分析、社交网络分析、数据挖掘.E-mail:1008lichao@163.com.

异质信息网络表示学习在节点分类、链接预测、个性化推荐等多个领域上被广泛应用.现有的异质信息网络表示学习方法大多集中在静态网络,忽略网络中时间属性对节点表示的影响.为了解决该问题,文中提出基于元路径和层次注意力的时序异质信息网络表示学习方法.利用元路径捕获异质信息网络中的结构和语义信息.通过时间衰减注意力层,捕获不同元路径实例在特定时间对目标节点的影响.通过元路径级别注意力,融合不同元路径下的节点表示,得到最终表示.在DBLP、IMDB数据集上的实验表明,文中方法在节点分类和节点聚类任务上均可达到较优效果.

ZHAO Zhongying, Ph.D., associate professor. Her research interests include social network analysis and data mining.

About Author:

QIN Haiying, master student. Her research interests include heterogeneous information network representation learning and application.

LI Jianhui, master student. His research interests include network representation lear-ning and recommendation system.

LI Chao, Ph.D., associate professor. His research interests include big data analysis, social network analysis and data mining.

Heterogeneous information network representation learning is widely applied in many fields including node classification, link prediction and personalized recommendation. The existing heterogeneous information network representation learning methods mainly focus on static networks but ignore the influence of time on node representations. To address this problem, a meta-path and hierarchical attention based temporal heterogeneous network representation learning method is proposed. The meta-paths are utilized to capture the structural and semantic information in heterogeneous information networks. Through the time decay attention layer, the impact of different meta-path instances at a specific time on the target node is captured. Through the meta-path level attention, the node representation under different meta-paths is fused to obtain the final representation. The experiments on DBLP and IMDB datasets show that the proposed method achieves better results on the tasks of node classification and node clustering.

本文责任编委 王立威

Recommended by Associate Editor WANG Liwei

异质信息网络(Heterogeneous Information Net-work, HIN)由多种类型的节点和边组成, 能建模现实世界中复杂的网络应用, 如电子商务网络[1]、交网络[2]等, 因此, HIN分析与挖掘一直是一个热门的研究领域[3, 4].然而, 传统的网络分析方法都是直接在原始网络中进行, 存在耦合紧密、难以并行、效率低下等缺点.网络表示学习旨在将拓扑空间的网络节点转化到低维向量空间, 同时, 最大程度地保持网络的结构特征和语义信息, 为下游任务, 如节点分类[5]、链接预测[6, 7]、个性化推荐[1, 8, 9, 10]等, 提供方便.因此, 网络表示学习成为近年来的研究热点, 而异质信息网络表示学习是其中最具有挑战性的研究课题之一, 引起学者们的广泛关注[11, 12].

现有的HIN表示学习方法[13]可分为基于随机游走为代表的浅层模型与基于图神经网络为代表的深层模型.Dong等[14]提出Metapath2vec, 设计基于元路径的随机游走, 并利用跳字模型(Skip-Gram)学习节点的表示.Fu等[15]提出HIN2vec, 在执行多个预测任务的同时学习节点和元路径的潜在向量.然而, 这两种方法都不支持端到端的训练策略.Shi等[8]提出HERec, 对元路径游走得到的节点进行类型约束和过滤, 获得有意义的节点序列, 利用融合函数, 将学习得到的表示进一步集成到一个扩展的矩阵分解模型中.

上述方法并未充分利用节点特征, 因此, 研究者们将图神经网络(Graph Neural Network, GNN)扩展到HIN中.Zhang等[16]提出异质图神经网络(Heterogeneous GNN, HetGNN), 同时考虑图结构的异质性和节点内容的异质性, 针对不同的节点类型采用不同的递归神经网络, 融合多模态特征.Wang等[17]提出异质图注意力网络(Heterogeneous Graph Atten-tion Network, HAN), 使用节点级注意力和语义级注意力学习多条元路径引导下的节点表示.Fu等[18]提出元路径聚合图神经网络(Metapath Aggregate Graph Neural Network, MAGNN), 对元路径实例进行编码, 提取实例中的结构和语义信息.上述方法都是基于元路径进行学习的, 需要专业的领域知识预先定义元路径.Hong等[19]提出异质图结构注意力神经网络(Heterogeneous Graph Structural Attention Neural Network, HetSANN), 设计基于注意力机制的图卷积神经网络, 对异质信息网络进行嵌入式表示学习.Hu等[20]提出HeGAN, 设计有效的广义生成器, 将对抗学习用于HIN表示.然而, 这些方法仅针对静态HIN, 忽略网络随时间的变化的情况.

在现实世界中, 网络会随着时间发生变化.以引文数据集为例, 学者之间每年都会有新的合作, 产出新的论文, 使合著关系和论文集合不断发生变化.现有的静态网络表示方法不能捕获时间信息带来的结构和语义变化.因此, 不少研究者开始关注时序动态网络的表示[21].时序动态网络表示大致可分为基于网络快照和对时间演化进行建模.Zhu等[22]提出基于因式分解的动态表示算法.Zhou等[23]提出DynamicTriad, 引入三个顶点组成的一个网络基本单元, 作为网络动态变化的基本机制, 使模型能捕捉网络动态, 并在不同的时间点学习每个顶点的向量表示.同样, 适用于HIN的基于层次结构的动态异质图嵌入(Dynamic Heterogeneous Graph Embedding Using Hierarchical Attentions, DyHAN)[24]按时间对网络进行划分, 对每个子网络使用HAN, 利用注意力机制聚合每个子网络.上述方法都是基于网络快照, 根据时间线对网络进行切片, 学习的表示向量只能反映特殊时间点的网络状态, 忽视网络的动态演化特征.Zuo等[25]提出基于霍克斯过程的时序网络嵌入方法(A Hawkes Process Based Temporal Network Embedding Method, HTNE), 对邻域形成序列进行建模.Lu等[26]提出M2DNE, 从微观网络结构的形成过程和宏观网络规模的演化过程两方面共同学习时间网络表示.然而这些方法并不能捕获网络中的语义信息.

综上所述, 时序异质信息网络表示学习是一个具有挑战性的研究课题.挑战性主要体现在以下两点:充分考虑网络中的结构和语义信息; 将不同时间出现的边和节点看作一个整体, 考虑网络的整体性.

在HIN中, 元路径蕴含丰富的语义信息, 一个元路径实例往往对应现实世界中在某个时间发生的具体事件.探究不同时间生成的元路径实例对目标节点产生的影响具有现实意义.

针对上述问题和背景, 本文提出基于元路径和层次注意力的时序异质信息网络表示学习方法(Meta-Path and Hierarchical Attention Based Temporal Heterogeneous Information Network Representation Lear-ning, MA-THNRL), 将时序异质信息网络作为整体结构, 通过元路径学习丰富的结构和语义信息.充分考虑网络中时间属性的影响, 提出时间衰减注意力层(Time Decay Attention Layer, TDA), 增强实例对目标节点影响的表现力, 利用元路径级注意力学习不同元路径的重要性.在真实数据集上进行节点分类和节点聚类实验, 结果表明MA-THNRL的有效性.

定义1 异质信息网络[27] 给定有向图G=(V, E), V表示节点集合, E表示边集合.存在节点类型映射函数ϕ :V→  , 存在边类型映射函数φ :E→

, 存在边类型映射函数φ :E→  , 其中,

, 其中,  表示节点类型, R表示边类型, |

表示节点类型, R表示边类型, | |+|

|+| |> 2.每个节点v∈ V属于特定节点类型ϕ (v)∈

|> 2.每个节点v∈ V属于特定节点类型ϕ (v)∈  , 每条边e∈ E属于特定边类型φ (e)∈

, 每条边e∈ E属于特定边类型φ (e)∈  , 则称这样的网络为异质信息网络, 称S={

, 则称这样的网络为异质信息网络, 称S={ ,

,  }为网络模式.

}为网络模式.

定义2 时序异质信息网络[28] 包含时间属性的异质信息网络GT=(V, E; T), T表示时间属性集合, 对于连接u、v节点每条边e=(u, v, t), 有时间戳t∈ T.

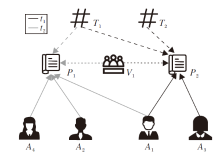

图1将引文数据集建模为时序异质信息网络.节点类型分别为论文(Paper, P)、作者(Author, A)、关键字(Term, T)、论文出处(Venue, V).边类型包括作者与文章之间关系AP、论文与关键字之间关系PT、论文与论文出处之间关系PV.各边时间属性均表示作者完成该论文并发表的时间.

定义3 元路径及元路径实例[27] 路径ρ 在网络模式S={ ,

,  }中具有形式

}中具有形式

A1$→ ^{R_1}$A2$→ ^{R_2}$…$→ ^{R_1}$Al+1,

可缩写为A1A2…Al+1, 其中, Ai(i=1, 2, …, l+1)表示特定类型的节点, Ri(i=1, 2, …, l)表示2个节点之间的连接关系, 称路径ρ 为元路径.遵循元路径ρ 定义的节点序列(a1a2…al+1)称为元路径实例.

定义4 基于元路径的邻居[17] 通过元路径ρ 与节点i相连的节点集合定义为节点i基于元路径的邻居N

在图1中, A1P1A2为元路径APA引导的一个实例. A1基于元路径APA的邻居为{A1, A2, A3, A4}, A2的邻居为{A1, A2, A4}.

序异质信息网络表示学习方法

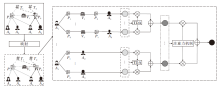

本文提出基于元路径与层次注意力的时序异质信息网络表示学习方法(MA-THNRL), 总体框架如图2所示.

MA-THNRL主要包括3个模块:特定类型节点映射、时间衰减注意力层、元路径级注意力聚合.首先, 通过特定类型节点映射模块将不同类型的节点特征映射到相同的特征空间中.然后, 学习不同元路径下每个元路径实例的表示, 通过时间衰减注意力探索不同元路径实例对目标节点的影响, 获得不同元路径下的节点表示.最后, 使用元路径级别的注意力机制, 聚合不同元路径下的节点表示, 得到最终表示.

本文使用的主要符号及相关说明如表1所示.

| 表1 主要符号及相关说明 Table 1 Notations and explanations |

HIN中不同类型节点有不同的特征空间和维度, 难于在一个统一的框架中处理这些节点.因此, 需要进行特定类型节点映射, 将不同类型节点特征映射到相同的向量空间中.根据文献[29], 给定类型为A∈  的节点v∈ V, 具体操作如下:

的节点v∈ V, 具体操作如下:

h'v=P(hv)=MA· hv+bA,

其中, P(· )表示节点映射函数, hv∈

本文提出时间衰减注意力层(TDA), 学习不同元路径实例在不同时间对目标节点的影响.

给定元路径实例ρ (v, u), v表示目标节点, u∈ N

{mρ (v, u)}=ρ (v, u)\{v, u}.

将元路径实例中所有节点的特征编码成向量:

hρ (v, u)=f(ρ (v, u))=f(h'v, h'u, {h'i, ∀ i∈ {mρ (v, u)}})∈ Rd',

其中f(· )表示元路径实例编码方式.

为了充分挖掘元路径实例中的结构和语义信息, 编码方式需考虑节点本身的特征及节点顺序结构中的关系信息.因此, 本文选择复杂空间中关系旋转的知识图嵌入(Knowledge Graph Embedding by Relational Rotation in Complex Space, RotatE)[30].给定元路径实例ρ (v, u)=(x0, x1, …, xn), 其中x0=v, xn=u, ri为关系节点xi-1与xi之间的关系的向量表示.RotatE具体操作如下:

o0=h'

其中☉表示哈达玛乘积.

给定目标节点v, 存在元路径ρ 引导下的一系列元路径实例及其对应的时间戳, 即

v→ {(ρ (v, u)1, t1), (ρ (v, u)2, t2), …, (ρ (v, u)n, tn)},

实例的时间戳需要根据元路径具体情况分析.

每个实例对目标节点的影响因子表示为

λ i=softmax(

其中:k(· )表示时间衰减函数; t表示当前时间, 当ti接近t时, ρ (v, u)i对v的影响更大; δ i表示可学习的衰减率;

α i=

a表示注意力向量, ⊕表示拼接操作, W表示权重矩阵, σ (· )表示激活函数.

目标节点v在元路径ρ 下的表示

给定元路径集合{ρ 1, ρ 2, …, ρ k}, 经过时间衰减注意力层后, 可得到k组特定语义的节点表示, 分别表示为{

每种元路径只能反映一种结构和语义信息.为了学习更全面的节点表示, 使用元路径级注意力聚合需要多种元路径下的表示, 将最终融合得到的节点表示应用到不同的任务中.具体操作参照文献[17]:

其中, W∈ Rd× d'表示可学习的权重矩阵, b∈ Rd表示可学习的偏置向量, q∈ Rd表示元路径级别的注意力向量.

在获得每条元路径的重要性后, 通过softmax函数对其进行规范化:

zv=

为了得到更有效的节点表示, 在特定任务的半监督环境中学习MA-THNRL的参数.优化目标是最小化真实标签与预测标签之间的交叉熵损失, 损失函数为

Loss=-

其中, VL表示有标签的节点集合, Y

给定部分节点的标签, 使用随机梯度下降和反向传播进行优化.

MA-THNRL具体步骤如下所示.

算法1 MA-THNRL

输入 时序异构网络GT=(V, E; T),

节点特征{hv, v∈ V},

元路径集合{ρ 1, ρ 2, …, ρ k},

节点类型A={A1, A2, …, A|A |}

输出 节点表示Z={zv, ∀ v∈ V}

for A∈ A do:

特定类型节点映射h'v← MAhv+bA

end

for ρ j∈ {ρ 1, ρ 2, …, ρ k} do:

for v∈ V do:

对目标节点为v的元路径实例进行编码, 获得

计算时间衰减注意力权重λ i

计算特定元路径下节点表示

end

end

计算每条元路径的重要性

融合不同元路径表示获得最终节点表示zv

return Z={zv, ∀ v∈ V}

MA-THNRL不仅能捕获异质信息网络中的结构拓扑和语义信息, 而且可捕获时间属性对节点的影响.层次注意力结构能清晰展现不同实例及不同元路径的重要性, 对学习节点表示具有良好的解释性.

MA-THNRL首先对不同类型的节点进行特征映射, 时间复杂度为O(|A|), 其中|A|表示节点类型的数量.然后, 对不同元路径实例进行编码, 并学习特定元路径下的节点表示, 时间复杂度为O(k|V|E), 其中, k表示元路径的数量, |V|表示目标节点的数量, E表示元路径实例的个数.最后, 计算元路径的权重, 并融合不同元路径下的节点表示, 时间复杂度为O(1), 远小于O(k|V|E), 可忽略.因此, MA-THNRL的时间复杂度为

O(|A|+k|V|E).

本文在DBLP[31]、IMDB数据集上进行实验, 验证MA-THNRL的有效性.DBLP数据集是从专门为计算机科学设计的论文查询网站DBLP提取的网络, 包含论文(Paper, P)、作者(Author, A)、关键字(Term, T)和论文出处(Venue, V)4种类型节点.IMDB数据集是从电影评分网站提取的网络, 包含电影(Movie, M)、导演(Director, D)和演员(Actor, A)3种类型节点.具体数据集描述如表2所示, 其中, 元路径中黑体节点为目标节点, 斜体边的时间戳为元路径实例的时间戳.

| 表2 数据集详情 Table 2 Details of datasets |

对比方法包括基于随机游走的方法、基于图神经网络的方法及融合时间属性的网络表示方法等.具体如下所示.

1)Metapath2vec[14].基于元路径的随机游走, 并利用skip-gram对异质信息网络进行表示.

2)HERec[8].设计类型约束过滤节点序列, 同样使用skip-gram对异质信息网络进行表示.

3)图卷积网络(Graph Convolution Network, GCN)[32].基于同质图设计的神经网络, 将卷积网络扩展到图领域.

4)图注意力网络(Graph Attention Network, GAT)[33].同质图神经网络, 在图中进行卷积操作, 融合注意力机制.

5)HetGNN[16].采用重启随机游走机制, 利用神经网络聚合节点属性信息和结构信息.

6)M2DNE[26].从宏观和微观动力学角度建模网络随时间的演变, 学习节点表示.

7)HAN[17].半监督图神经网络, 利用节点级注意力和语义级注意力聚合网络中节点的信息.

8)MAGNN[18].异构图神经网络, 对元路径实例进行编码, 进一步融合结构和语义信息.

对于基于随机游走的Metapath2vec、HERec和HetGNN, 设置窗口大小为5, 游走长度为100, 负采样个数为5.对于融合时间属性的M2DNE, 同样设置负采样数为5.对于基于图神经网路的GCN、GAT、HAN、MAGNN和MA-THNRL, 设置失活率为0.3, 使用Adam优化器, 学习率为0.005, 权重衰减为0.001.采用相同的训练集、验证集和测试集.GAT、HAN和MAGNN中注意力头数设置为8.所有方法最终的表示维度均为64.

在DBLP、IMDB数据集上进行节点分类实验.使用支持向量机(Support Vector Machine, SVM)将得到的表示应用于节点分类任务, 评测方法的有效性.共进行10次实验, 取得平均Macro-F1值和Micro-F1值.具体实验结果如表3所示.

| 表3 各方法在节点分类任务上的指标值对比 Table 3 Index value comparison of different methods on node classification task |

由表3可看出, MA-THNRL在2个评价指标上的效果均最优, 在DBLP数据集上提升0.62%~1.36%, 在IMDB数据集上提升2.06%~5.51%, 可得如下结论.

1)MA-THNRL的性能优于静态的HIN表示方法, 说明时间是不可忽略的属性, 对节点表示具有重要影响.

2)MA-THNRL性能优于MAGNN, 表明MA-THNRL中时间衰减注意力层的有效性.相比M2DNE, MA-THNRL可更好地融合网络中的结构和语义信息, 得到更优表示.

3)由不同比例训练集的结果可得出, 训练集的大小对MA-THNRL效果影响不大, 说明MA-THNRL不需要过多的标记数据即可达到较优效果.

使用K-means执行节点聚类任务评测MA-THNRL的有效性, K值为目标节点的标签数, 评价指标为归一化互信息(Normalized Mutual Informa-tion, NMI)和调整的兰德指数(Adjusted Rand Index, ARI).

各方法在节点聚类任务上的指标值对比如表4所示.由表可知, 基于图神经网络的方法通常可取得较优效果, MA-THNRL在2个数据集上的指标值均最优.在DBLP数据集上, NMI与ARI分别提升2.17%、1.81%; 在IMDB数据集上, NMI与ARI分别提升8.44%、31.35%.

| 表4 各方法在节点聚类任务上的指标值对比 Table 4 Index value comparison of different methods on node clustering task |

由此可见, 在学习网络表示时, 融合时间属性是必要的.相比M2DNE, MA-THNE能聚合更多语义和结构信息, 更适用于聚类任务.

本节通过变体实验进一步验证方法各模块的有效性.定义

1)MA-THNRLfeat表示不使用节点特征.

2)MA-THNRLtranse表示在对元路径实例进行编码时, 选择的编码方式为TransE[34].

3)MA-THNRLavg表示选择的编码方式为对实例中节点向量取平均.

4)MA-THNRLnb表示不考虑元路径实例的中心节点, 仅使用由元路径连接的节点对, 即仅考虑目标节点及其基于元路径的邻居.

5)MA-THNRLatt表示不考虑网络中的时间属性, 仅用注意力机制对元路径实例进行融合, 即MAGNN.

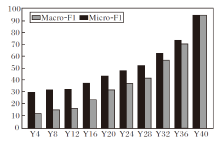

各模块在节点分类任务和节点聚类任务上的指标值如图3所示.

由图3可得如下结论.

1)MA-THNRL性能优于MA-THNRLfeat, 说明节点特征对于节点的表示是重要的.

2)相比MA-THNRLtranse和MA-THNRLavg, MA-THNRL采用的编码方式更能捕获节点特征和节点之间的关系结构.

3)相比MA-THNRLnb, 聚合元路径实例表示不仅关注基于元路径的邻居, 还能提高方法性能.

4)相比MA-THNRLatt, MA-THNRL能捕获网络中的时间属性, 得到更优的节点表示.

为了探索时间变化对网络表示的影响, 将DBLP数据集按照网络形成时间, 每四年为一个时间节点, 记录当前网络状态, 分别记为Y4、Y8、Y12、Y16、Y20、Y24、Y28、Y32、Y36、Y40.对于各个时间点的网络状态, 利用MA-THEN学习节点表示, 将得到的表示用于节点分类实验, 结果如图4所示, 节点分类的效果随着网络的不断发展而逐渐提升.由图可得出如下结论:随着时间推移, 网络中包含越来越多的有效信息, 有利于学习得到更优的节点表示.

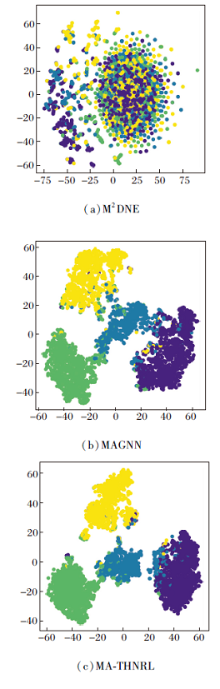

为了更直观地展示MA-THNRL的效果, 执行可视化任务.具体操作是将通过MA-THNRL学习得到的表示投影到二维空间中, 利用t分布随机邻域嵌入(t-Distributed Stochastic Neighbor Embedding, T-SNE)[35]对DBLP数据集上的作者节点进行可视化, 不同颜色表示不同的节点标签.

M2DNE、MAGNN、MA-THNRL在DBLP数据集上的可视化表示如图5所示.

由图5可看出, M2DNE表现并不好, 属于不同类别节点相互交织在一起.MAGNN的性能相对好一些, 但不同类别节点的边界依然模糊.MA-THNRL学习到的表示能使同类别节点更紧密地聚集在一起, 区分不同类别的节点.

本文提出基于元路径和层次注意力的时序异质信息网络表示学习方法(MA-THNRL).使用元路径捕获异构网络中复杂的结构信息和丰富的语义信息.充分考虑网络中的时间属性, 提出时间衰减注意力层, 探索元路径实例在不同时间对目标节点的影响.通过节点分类和聚类实验, 验证MA-THNRL的有效性.通过一系列变体实验, 验证MA-THNRL各模块的必要性.本文方法的不足之处是需要依赖元路径挖掘网络中的信息, 而元路径的定义需要一定的领域知识.因此, 今后考虑通过多种智能算法深入挖掘网络中丰富的异质信息.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|