刘 骊,博士,教授,主要研究方向为计算机辅助设计与图形学、图像处理、计算机视觉.E-mail:kmust_mary@163.com.

作者简介:

周前前,硕士研究生,主要研究方向为计算机视觉、图像处理.E-mail:zhou_qian001@163.com.

付晓东,博士,教授,主要研究方向为服务计算、决策理论与方法.E-mail:xiaodong_fu@hotmail.com.

刘利军,博士,副教授,主要研究方向为图像处理、云计算、信息检索.E-mail:cloneiq@126.com.

黄青松,硕士,教授,主要研究方向为机器学习、数据挖掘、智能信息系统.E-mail:1912443688@qq.com.

民族服饰图像具有不同民族风格的服装款式、配饰和图案,导致民族服饰图像细粒度检索准确率较低.因此,文中提出细粒度民族服饰图像检索的全局-局部特征提取方法.首先,基于自定义的民族服饰语义标注,对输入图像进行区域检测,分别获得前景、款式、图案和配饰图像.然后在全卷积网络结构的基础上构建多分支的全局-局部特征提取模型,对不同区域的服饰图像进行特征提取,分别获得全局、款式、图案和配饰的卷积特征.最后,先对全局特征进行相似性度量,得到初步检索结果,再使用Top-50检索结果的局部特征与查询图像的局部特征进行重排序,优化排序并输出最终的检索结果.在构建的民族服饰图像数据集上的实验表明,文中方法有效提高民族服饰图像检索的准确率.

LIU Li, Ph.D., professor. Her research interests include computer-aided design and computer graphics, image processing and computer vision.

AboutAuthor:

ZHOU Qianqian, master student. His research interests include computer vision and image processing.

FU Xiaodong, Ph.D., professor. His research interests include services computing and decision theory and technology.

LIU Lijun, Ph.D., associate professor. His research interests include image proce-ssing, cloud computing and information retrieval.

HUANG Qingsong, master, professor. His research interests include machine learning, data mining and intelligent information system.

The low accuracy of fine-grained retrieval of national clothing images is caused by different clothing styles, accessories and patterns of national clothing. To address is problem, a global-local feature extraction method for fine-grained clothing image retrieval is proposed. Firstly, the input image is detected to obtain the foreground, styles, accessories and patterns images based on semantic labels of national clothing. Secondly, a multi-branch feature extraction model based on fully convolutional network is constructed to extract features from clothing images in different regions and obtain convolutional features of global, styles, accessories and patterns. Finally, the preliminary retrieval results are obtained by applying a similarity measure to the global features. Then,re-ranking of the result is performed by the local features of top 50 retrieval results and the query image. The final retrieval results are output by the result of re-ranking. The experimental results on the constructed national clothing image dataset show that the proposed method improves the accuracy of national clothing image retrieval effectively.

本文责任编委 张军平

Recommended by Associate Editor ZHANG Junping

传统的服饰图像检索方法大多基于粗粒度特征.Wang等[1]计算图像底层视觉特征之间的距离, 判断服饰图像的相似性.黄冬艳等[2]提出联合使用尺度不变特征变换(Scale-Invariant Feature Trans-form, SIFT)和方向梯度直方图(Histogram of Orient-ed Gradient, HOG)等多种局部特征进行图像检索.Li等[3]提出结合全局特征与局部特征的图像检索方法, 但提取特征属于粗粒度特征.此外, 由于底层特征提取受到背景、曝光度和遮挡等干扰, 存在检索准确率不高等问题.目前, 卷积神经网络(Convolutional Neural Network, CNN)因能提取图像深层语义特征, 被广泛应用于服饰图像检索任务中.Kiapour 等[4]使用AlexNet网络提取图像的全连接特征, 利用余弦相似度完成图像检索任务, 却忽略服饰图像中的细粒度属性.而目前商业领域的应用对服饰图像的细粒度特征识别和检索提出更高要求, 需考虑服饰的细粒度属性才能提高检索准确率.

细粒度服饰图像检索是对服饰图像中能分辨服饰图像的细粒度特征进行识别和检索.Wang等[5]基于视觉词袋模型, 使用图像的底层视觉特征, 结合服饰属性对服饰图像进行细粒度检索.目前细粒度服饰图像检索的难点在于:1)图像的类别及类间划分细微, 导致提取的局部特征不能有效表示服饰的细粒度特征; 2)属于相同子类的细粒度属性也会因为服饰图像本身的变形和遮挡导致较大差异, 检索性能不佳.鉴于此种情况, Huang等[6]针对服饰的跨域检索问题, 提出双重属性感知排名网络(Dual Attribute-Aware Ranking Network, DARN), 进行服饰图像跨域的检索.Liu等[7]提出时尚服饰网络(FashionNet)和关键点标注, 对服饰图像进行分类和检索.Cheng等[8]使用检测和跟踪算法提取视频中服饰的细粒度特征, 进行相似度计算排序, 实现检索.Wang等[9]从服饰图像中提取注意力图, 获得注意力特征, 融合注意力特征图与特征图, 进行服饰图像检索.Kuang等[10]提出基于相似度金字塔图模型网络, 提取多个不同尺度下的全局特征和局部特征, 对时尚服饰图像进行细粒度检索.王志伟等[11]提取多级尺度特征, 结合传统视觉特征对服饰图像进行检索.林计文等[12]提出汉明嵌入哈希的方法, 对图像进行检索.Luo等[13]提出深度多哈希模型, 能同时对跨域嵌入和顺序属性学习进行建模, 识别服饰的细粒度属性.上述方法都是针对时尚服饰, 现有方法难以对民族服饰图像中细粒度属性特征进行分类和检索, 需要结合重排序以完成细粒度检索任务.

区别于时尚服饰, 民族服饰是在文化发展过程中形成的具有民族特色的文化代表之一, 具有如下特点:民族服装款式较多, 组成结构复杂, 颜色繁多; 配饰、纹理图案等细粒度属性较多.Huo等[14]针对民族服饰图像分类, 提出基于部件检测和特征融合的方法, 提取民族服饰图像的4种底层特征, 实现对蒙古族等11个民族服饰图像的分类.Sun等[15]使用目标检测方法对民族服饰图像进行人体和属性检测.此外, 许多工作使用重排序方法提高检索准确率, Pedronette等[16]引入最短路径算法, 根据检索列表的相似性, 在每个步骤中更新图像之间的距离, 完成图像重排序.Yang等[17]从图像中提取大量不同的局部特征, 表示不同的视觉特征, 融合全局特征进行重排序.Yu等[18]直接融合全局特征和局部特征进行相似度计算, 得到重排序结果, 未考虑到可分辨的细粒度特征在特征融合过程中不能得到较好表现, 导致检索准确率不高.

目前民族服饰细粒度图像检索研究仍存在如下问题:1)民族服饰款式种类繁多, 配饰和图案具有民族特色, 难于有效划分和定义不同民族服饰的细粒度属性.2)传统的特征提取及基于深度学习的方式难以准确描述民族服饰的局部图案、款式样式和配饰种类等信息, 仍需有效融合民族服饰的局部特征与全局特征, 这是提高后续检索精度的关键.3)现有的图像检索框架大多分别利用全局特征或局部特征进行检索, 导致在检索性能上难以体现全面效果.如何结合提取的全局特征和局部特征, 优化排序结果, 成为提升检索准确率的关键.

针对上述问题, 本文提出细粒度服饰图像检索的全局-局部特征提取方法.首先, 基于自定义的民族服饰语义标注, 对输入图像进行区域检测, 分别获得前景、款式、图案和配饰图像.然后, 在全卷积网络结构的基础上构建多分支的全局-局部特征提取模型, 对不同区域的服饰图像进行特征提取, 分别获得全局、款式、图案和配饰的卷积特征.最后, 先对全局特征进行相似性度量, 得到初步检索结果, 使用Top-50检索结果的局部特征与查询图像的局部特征进行重排序, 优化排序并输出最终的检索结果.在构建的民族服饰图像数据集上的实验表明, 本文方法有效提高民族服饰图像检索准确率.

民族服饰具有如下特点:服饰结构复杂, 服装款式较多, 颜色鲜艳分明, 配饰繁多, 图案丰富, 局部纹理细节具有民族特色.民族服饰图像的细粒度属性特征差异体现在不同的服装款式、配饰和图案等局部区域.服饰图像本身存在身体部位的遮挡和服饰变形等问题, 导致特征提取不准确.

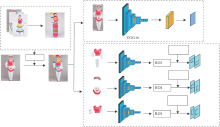

为此, 本文提出全局-局部特征提取方法, 具体框图如图1所示.使用训练好的Faster R-CNN(Faster Region-CNN)[19]对输入图像进行区域检测, 识别并提取输入图像的前景、款式、图案和配饰部件区域.分别按分割结果提取各区域的卷积特征, 作为输入图像的全局特征和款式、配饰和图案局部特征.

根据民族服饰[20]的款式结构, 使用标注工具Lableme[21]对本文收集的民族服饰图像数据集上的人体区域进行人工手动标注.标注的类别体现民族服饰图像具有相同的基本服饰结构.

标注区域分为全局和局部两部分, 全局标注为图像的全身部分, 全局特征是为了去除复杂背景, 保留完整的服饰和人体区域, 完成检索任务的初步筛选.局部标注分为服装款式、配饰和图案3个部分.本文在文献[22]的基础上, 对民族服饰中常出现的细粒度区域进行归纳, 按照人体部位自定义局部标注, 具体属性值标注如表1所示.

| 表1 民族服饰语义标注 Table 1 Semantic labels of national clothing |

将不同的服装款式、配饰和图案视为不同的细粒度属性, 每个民族都有较多且能体现民族特征的语义属性, 通过自定义与之对应的语义属性, 提升特征提取的准确率.款式属性分为领口、前胸、衣袖和腿部4个区域, 包含20个属性值.配饰属性分为头部、前胸、腰部和腿部4个区域, 包含15个属性值.图案属性分为前胸、衣袖和腿部3个区域, 包含4个属性值, 共40个.

为了实现对服饰图像的全局特征和局部特征的有效提取, 同时满足检索任务的需求, 本文采用Faster R-CNN网络进行区域检测.如图2所示, 民族服饰图像有较多细粒度属性特征, 占图像区域较小, 使用该网络模型能有效进行检测和识别, 同时针对由于姿势和服饰变形导致的遮挡问题也有较强的鲁棒性.首先将图像输入到网络模型的卷积网络中, 经过CNN得到卷积特征图, 将卷积特征输入区域推荐网络, 区域推荐网络是Faster R-CNN在原有方法上增加的一个网络, 显著增强对区域特征检测和识别的准确率, 对小目标也具有较好的识别和检测效果, 将结果输入感兴趣区域(Region of Interest, ROI)池化层, 得到输入图像的分类检测结果图像.分割得到的检测结果, 用于后续特征提取步骤.

1.2.1 全局特征提取

全局特征提取分支使用VGG16网络作为主干网络, 相比其它卷积神经网络, 整个网络使用同样大小的卷积核尺寸和最大池化层尺寸, 降低网络模型的参数量, 同时具有较优性能.如图1所示, 将VGG16网络作为分支提取主干网络, 去除VGG16的FC6和FC7层, 为了节约时间, 将网络中的前面2层的卷积层的学习率设置为0, 从VGG16网络的第3层卷积层开始, 将学习率设置为1, 步长为2.从卷积网络的conv5_3得到卷积特征图, 输入最大池化层中得到特征图, 作为输入图像的全局特征.

输出全局特征为12× 15× 512的特征图, 其中输出特征图的宽和高为2和15, 特征图的维数为512, 将查询图像的全局特征表示为

1.2.2 局部特征提取

由于全局特征不能较好体现民族服饰图像的细粒度属性, 在进行特征匹配时, 不能较好地对关键区域中的细粒度属性进行匹配, 导致检索准确率不高, 而局部特征能够较好地弥补此问题.局部特征能准确提取含有细粒度属性的区域, 这成为民族服饰图像细粒度检索的关键.因此, 将局部特征提取分支划分成能描述民族服饰图像细粒度属性的款式、配饰和图案3个分支, 分别提取民族服饰图像中的服装款式、配饰和图案等局部特征.

网络结构与全局特征提取分支类似, 将VGG16网络作为分支提取主干网络, 从conv5_3中得到输入图像的卷积特征, 输入ROI池化层, 提取ROI特征, 联合本文定义的款式预测损失函数、配饰预测损失函数和图案预测损失函数, 输出基于款式、配饰和图案的局部特征, 利用插值算法转为固定尺寸(3× 3× 512), 维度与全局特征相同.

在局部特征提取分支定义3个损失函数, 即款式预测损失函数、配饰预测损失函数和标注位置预测损失函数, 分别在提取服装款式、配饰和图案特征时进行约束.为了学习服装款式局部的特征描述, 使用triplet loss计算增强服饰中正负样本训练图像的距离约束, 定义如下:

${{L}_{style}}=\overset{\left| N \right|}{\mathop{\underset{i=1}{\mathop{\sum }}\, }}\, max\left\{ 0, m+d(Ii, I_{i}^{+})-d(Ii, I_{i}^{-}) \right\}.$

其中:N表示训练样本数; d(· , · )表示距离函数;

由于不同民族出现的配饰语义标注不同, 同一区域的语义属性差距也会较大, 如满族的头部是大拉翅(帽子), 苗族的头饰是银冠, 通过对语义属性的学习能提升特征提取结果的准确率, 因此采用交叉熵损失定义配饰预测损失函数:

${{L}_{attributes}}=\overset{\left| N \right|}{\mathop{\underset{i=1}{\mathop{\sum }}\, }}\, ~({{\sigma }_{positive}}{{t}_{i}}lo{{g}_{2}}p({{t}_{i}}\text{ }\!\!|\!\!\text{ }{{I}_{i}})+{{\sigma }_{n}}_{egative}(1-{{t}_{i}})lo{{g}_{2}}(1-p({{t}_{i}}\text{ }\!\!|\!\!\text{ }{{\text{I}}_{i}}))).$

其中:σ positive、σ negative分别表示由正样本和负样本数量比率确定的系数, 属于同一个语义属性定义为正样本, 否则, 定义为负样本; Ii表示第i幅图像; ti表示第i幅图像对应的语义属性标注.

图案语义属性具有大量相同标注, 但由于出现在服饰图像中不同区域, 可通过定义基于IOU loss的标注位置预测损失对民族服饰图像中的图案语义属性的位置进行定位:

${{L}_{pattern}}=\overset{m}{\mathop{\underset{x=1}{\mathop{\sum }}\, }}\, \overset{n}{\mathop{\underset{y=1}{\mathop{\sum }}\, }}\, {{({{I}_{\text{ideal}}}\left( x, y \right)-{{I}_{\text{actual}}}\left( x, y \right))}^{2}}, $

其中, m、n表示通过卷积神经网络得到的卷积特征图的长和宽, Iideal(x, y)表示网络模型的预测值, Iactual(x, y)表示标注的真实值.

以苗族成年女性服饰为例, 苗族服饰含有多个细粒度属性的局部特征, 服装款式为圆领、长袖和短裙, 配饰包含银冠、项圈、下摆, 图案有绣花图案和花边.首先将苗族成年女性服饰输入到全局-局部特征提取模型中, 基于识别为人物前景的结果图, 通过全局特征提取分支, 提取得到全局特征I1.再利用局部特征提取分支, 将识别为服装款式、配饰和图案的结果图分别输入局部特征提取分支中对应的服装款式、配饰和图案特征提取分支, 输出的局部特征表示为{I2, I3, …, In}.

提取得到的查询图像特征为{I1, I2, …, Im}, 其中, I1为查询图像的全局特征, 其余为查询图像的局部特征.将对民族服饰图像数据集提取的特征放入特征库L中, 表示为{

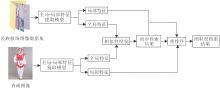

结合全局特征和局部特征完成民族服饰图像的细粒度检索任务, 整个流程如图3所示.首先, 使用全局-局部特征提取模型分别对查询图像和民族服饰图像数据集中的图像提取全局特征和局部特征.再使用查询图像与数据集中提取的全局特征进行相似性度量, 得到初步检索结果.然后通过初步检索结果的Top-50对应的局部特征与查询图像的局部特征进行相似性度量, 加权融合两次相似性结果, 对初步检索结果进行重新排序, 输出最终优化排序结果.

使用全局-局部特征提取模型对民族服饰图像数据集提取特征, 得到民族服饰图像特征库L, 包含从全局特征提取分支的全局特征和从局部特征中提取分支得到的局部特征, 每幅图像的全局特征对应该幅图像的多个局部特征.本文对特征图进行量化, 使用欧氏距离计算特征之间的相似度.使用欧氏距离计算查询图像全局特征I1与特征库L中全部图像的全局特征{

$\alpha (I)=\overset{\text{H}}{\mathop{\underset{\text{y}=1}{\mathop{\sum }}\, }}\, \overset{\text{W}}{\mathop{\underset{\text{x}=1}{\mathop{\sum }}\, }}\, \beta (x, y)f(x, y), $ (1)

其中, α 表示图像经过池化层下采样得到的量化结果, f(x, y)表示经过网络输出的卷积特征, β (x, y)表示C维特征的位置系数, (x, y)表示图像通道为H× W的空间坐标, H表示特征图的高, W表示特征图的宽.

全局特征的相似度度量得分为

$Sim({{I}^{1}}, \text{L}_{\text{n}}^{1})=(\alpha ({{I}^{1}}), \alpha (\text{L}_{\text{n}}^{1})), $ (2)

其中, α (I1)表示查询图像全局特征的量化结果, α (

对全局特征的度量结果进行排序, 输出初步的检索结果.考虑到民族服饰图像含有较多的款式、配饰和图案等细粒度属性, 在全局特征提取的过程中, 不能较好地表示有分辨性的局部特征, 导致检索结果准确率不高, 因此, 需要对初步的检索结果进行优化.

为了提高细粒度图像检索的性能, 取初步检索结果的前50幅图像, 然后在特征库中, 找到对应图像的局部特征, 使用查询图像的局部特征I分别与初步检索结果中对应的局部特征L进行相似度度量, 计算查询图像与前50幅图像中第x幅图像的局部特征相似度度量结果:

${{S}_{x}}(I, {{L}_{x}})=\underset{i}{\mathop{\sum }}\, {{\omega }^{i}}\alpha ({{I}^{i}}, \text{L}_{\text{x}}^{\text{i}}), $ (3)

其中, ω 表示根据人体部位分布的局部特征表示的权重, α 表示局部特征经过ROI池化层下采样得到的量化结果, i表示第i个局部特征.对I内所有的局部特征分别与L内对应特征进行度量, 并进行加权表示, 即

$\psi =\underset{i}{\mathop{\sum }}\, {{\omega }^{i}}\alpha ({{I}^{i}}, \text{L}_{\text{x}}^{\text{i}})+\underset{{{\text{f}}_{\text{i}}}\in \text{I}_{1}^{1}}{\mathop{\sum }}\, \underset{{{\text{f}}_{\text{j}}}\in \text{L}_{\text{n}}^{1}}{\mathop{\sum }}\, ({{f}_{i}}, {{f}_{j}}), $ (4)

其中, ψ 表示将数据集与查询图像的全局特征和局部特征进行加权计算得到的一个相似度结果, 最终的检索序列根据ψ 值决定.

民族服饰图像细粒度检索步骤如下.

1)全局-局部特征提取.

1.1)民族服饰图像数据集的特征提取.将民族服饰图像数据集中的图像输入全局-局部特征提取模型, 从模型的不同分支中提取全局特征和局部特征, 将提取的特征放入特征库中.

1.2)输入查询图像到全局-局部特征提取模型, 提取查询图像的全局特征和不同类别的局部特征.

2)初步检索结果.将查询图像的全局特征和特征库L中的全局特征通过式(1)进行量化, 使用式(2)对量化后的结果进行相似性度量, 根据计算结果, 得到初步的检索结果.

3)重排序.对于初步检索Top-50结果, 使用索引找到特征库中对应的局部特征, 通过式(3)与查询图像的局部特征进行相似性度量, 采用式(4)对全局相似性得分和所有局部特征相似性得分进行加权融合, 优化初步排序结果, 输出最后的检索结果.

实验环境平台如下:Ubuntu18.04, CPU为Inter Core i9-9900K, GPU为GTX2080Ti, 在GPU上开展训练, 使用Tensorflow深度学习框架.

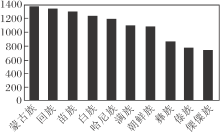

由于现有的民族服饰图像较少, 本文在文献[22]数据集的基础上, 扩充构建一个包含不同分支的民族服饰图像数据集, 图像主要来源于淘宝、京东等网络平台, 还从百度图片、论文及旅行博客等其它途径补充和扩展数据集, 共收集近20 000幅图像, 并在此民族服饰图像数据集上, 验证本文方法.各个民族含有的民族人口数量不同, 导致服饰文化的传承不一, 能收集的民族服饰数量也不同.为了避免因服饰图像质量和数量导致细粒度检索准确率不佳的问题, 选用图像较多和质量较好的民族服饰进行检索, 数据集中数量排名前10的民族如图4所示.

民族服饰图像数据集涉及中国所有的少数民族, 因为女性的民族服装款式和配饰较复杂, 因此大部分是女性服饰图像, 也包含少量的男性和儿童民族服饰图像.本文使用数据集中80%图像作为训练集, 训练集上的民族服饰图像使用图像标注工具按照表1标注人体部位结构, 结合民族服饰特有的款式、配饰和图案等细粒度属性特有的区域.数据集上5%图像用于验证, 15%的图像用于测试, 所有图像大小设置为480× 380, 将格式统一设置为jpg格式.

为了准确学习服饰图像的类别信息, 类内检索约束检索范围, 提高细粒度检索准确率.本文采用准确率作为特征分类的指标, 从预测的所有标签中挑选概率向量最大的几个值, 如果这几个值存在和人工标注类别相同结果, 预测准确, 否则预测错误.

本文采用的VGG16作为主干网络, 用于提取民族服饰图像的卷积特征, 以便后续的图像检索, 由此, 对比VGG16、ResNet-101、Inception-v4三种主干网络, 对民族服饰图像特征提取及分类结果的平均准确率均值(Mean Average Precision, mAP)如下:

VGG16为0.583, ResNet-101为0.576, Inception-v4为0.564.

由上述数据可知, 针对本文使用的民族服饰图像数据集, 相比其它网络, VGG16网络在特征提取及分类结果上具有较好的mAP值.故后续选择VGG16作为实验的主干网络, 对输入图像进行特征提取, 并对比当前常用的服饰图像检索方法, 包括DARN[6]、FashionNet[7]和Match RCNN(Match Re-gion-Convolutional Neural Network)[23].

各方法的mAP值如下:DARN为0.795, FashionNet为0.873, Match RCNN为0.814, 本文方法为0.864.由此可知, 相比Match RCNN、DARN, 本文方法在准确率上有一定优势, 较准确地对特征进行分类并提取卷积特征.本文方法和FashionNet的mAP值相似, 但本文方法不需人工标注大量关键点信息, 也能获得较准确的细粒度属性特征.

本文采用Top-k精度评估检索性能, 其定义如下:

$PK=\frac{1}{\text{Q}}\underset{\text{q}=\text{Q}}{\mathop{\sum }}\, h(q, k).$

其中:Q表示查询图像的总数; q表示查询图像基于欧氏距离在k个邻近的图像中检索, 前k个查询图像中至少包含1个相同的服饰图像.查询图像检索成功, h(q, k)=1; 否则, h(q, k)=0.

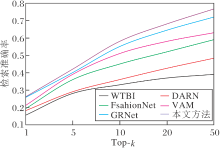

为了评估本文方法的有效性, 对比如下深度学习领域的服饰检索方法:WTBI[4]、DARN[6]、FashionNet[7]、VAM[9]、GRNet[10].利用相关方法的开源代码, 在本文使用的数据集上重新训练, 并在检索准确率上进行量化对比, 用于验证本文方法的有效性.

各方法在民族服饰图像数据集上的Top-k检索准确率如图5所示.由图可知, WTBI的检索准确率最低, 这是由于WTBI直接使用全连接层提取的全局特征进行相似度计算, 使用全局特征进行特征匹配不适用于含有较多细粒度属性的民族服饰图像的检索任务.DARN使用2个分支分别接收不同的数据集信息, 将通过全连接层得到的卷积特征与下采样得到的池化特征进行特征融合, 导致民族服饰图像中具有分辨性的局部特征的丢失.FashionNet使用服饰图像的标注对和局部特征作为检索对象, 检索准确率受到服饰图像本身的姿势和角度等干扰因素的影响, 导致准确率不高.VAM使用注意力特征图与全卷积特征进行融合, 计算融合特征的相似性, 但不能较好体现细粒度属性特征.GRNet提取不同尺度下的图像局部特征, 计算相似性得分, 经过图模型分类检索, 不能准确对服饰图像中的细粒度属性进行特征提取.本文方法根据人体部位区域定义民族服饰的细粒度属性, 提取局部特征, 按照分类结果对局部特征进行相似性度量, 结合全局特征和局部特征进行重排序, 提高民族服饰图像检索的准确率.

使用本文方法得到的特征, 与现有的融合全局和局部特征的图像检索方法进行量化对比, 本文方法的mAP值为0.766, 特征融合中常使用的线性融合方法ImpDrop的mAP值为0.732, 这进一步验证本文方法的有效性.

是否使用重排序的民族服饰图像部分的检索结果如图6所示, (a)中输入具有代表性的查询图像, (b)、(c)中绿框表示检索结果中与查询图像类似的检索结果.对比结果表明, 仅用全局特征进行相似性度量得到的初步检索结果, 虽然也包含一些相似的图像, 但存在大量与查询图像不相似的检索结果, 准确率较低.进一步地, (c)中为使用本文方法初步检索的结果, 经过优化后的检索结果准确率明显提升.

常用的服饰图像检索方法的运行时间如下:WIBI为0.65 s, DARN为0.88 s, FashionNet为1.32 s, VAM为0.93 s, GRNet为0.98 s, 本文方法为0.92 s.相比WTBI、DARN, 本文方法虽然运行时间稍长, 但是准确率更高.相比FashionNet、VAM、GRNet, 本文方法虽然准确率差距不大, 但运行时间更短.由此可见, 本文方法具有一定的适用性.

为了更好地说明本文方法的性能, 采用准确率(Precision, P)、召回率(Recall, R)作为评估标准, 对本文方法的消融实验结果进行评估, 具体公式分别为

其中, ri表示检索到与查询图像相似的图像数量, xi表示检索到民族服饰图像的全部数量, yi表示民族服饰图像数据集中与查询图像相似的图像数量, P表示检索到与查询图像相似的图像数量占全部检索图像的占比, R表示检索到与查询图像相似的图像占数据集上相似图像的占比.

各个部分的PR曲线如图7所示.

在图7中:全局特征是指仅使用查询图像的全局特征与特征库中的全局特征进行相似性计算后输出的初步检索结果; 局部特征是指未结合全局特征返回的初步检索结果, 直接使用查询图像的局部特征与特征库中的全部局部特征表示进行相似性度量后输出的检索结果; 全局-局部特征是指在经过全局特征计算得到的初步检索结果的基础上, 取检索结果排名Top-50的图像, 在特征库中建立索引, 结合多个局部特征与索引的局部特征进行相似性计算, 与全局特征相似度进行加权重排序, 输出最后的检索结果.

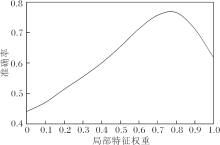

最后进一步验证全局特征和局部特征之间的权重与民族服饰图像检索准确率之间的关系, 具体如图8所示.在局部特征权重为0.8时, 检索准确率最高.

| 图8 全局特征和局部特征权重与检索准确率关系Fig.8 Relationship between global and local feature weights and retrieval accuracy |

实验结果表明, 使用局部特征进行相似度计算能有效提高检索准确率, 但复杂的计算过程会对检索效率产生较大影响.因此, 结合全局特征完成初步检索, 再与初步检索返回结果进行局部特征相似度计算, 能优化计算过程, 有助于提高检索性能.

针对细粒度服饰图像检索问题, 本文以民族服饰图像为例, 基于自定义的民族服饰语义属性, 构建全局-局部特征提取模型, 用于提取输入图像的全局特征和局部特征.进一步提出细粒度民族服饰检索的全局-局部特征提取方法, 实现民族服饰图像的细粒度检索.另外, 在已有民族服饰图像数据集的基础上, 扩充民族服饰图像数据集, 在此数据集上验证本文方法对民族服饰细粒度图像检索的有效性.

虽然本文方法能有效对民族服饰图像进行细粒度检索, 但在提取局部特征时还存在一些问题, 如检测和识别对配饰和图案区域等小目标结果不准确、部分语义属性预测不准确及定义的语义属性还不够完善和精细等.因此, 后续的工作将继续完善数据集, 围绕上述问题进一步展开研究, 提高民族服饰细粒度检索的准确率.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|