李玉芝,硕士,讲师,主要研究方向为机器学习、多媒体处理.E-mail:liyuzhi@tjufe.edu.cn.

作者简介:

盛家川,博士,教授,主要研究方向为数字多媒体处理、模式识别.E-mail:jiachuansheng@tjufe.edu.cn.

董玙璠,硕士研究生,主要研究方向为计算机视觉.E-mail:dongyufan@stu.tjufe.edu.cn.

李小妹,硕士,研究员,主要研究方向为科技创新与管理.E-mail:lixiaomei@tjufe.edu.cn.

风格转移技术能快速生成目标艺术作品,但直接用在中国画上通常会存在特征分布不协调、人脸辨识不一致等问题.针对上述问题,文中提出基于卷积神经网络(CNN)的中国肖像画风格转移算法.首先,针对中国肖像画中写意和工笔两种绘画技法,提出笔触控制约束,指导图像的纹理分布.然后,提出国画特征移动距离,用于度量内容与风格特征,并将参考的中国画风格协调部署在肖像照上.最后,针对中国画的水墨色调和留白特点,提出水墨留白约束改进损失网络.实验表明,文中算法生成的结果不仅保证人脸辨识的一致性,而且在中国画艺术风格上表现更优.

LI Yuzhi, master, lecturer. Her research interests include machine learning and multimedia processing.

About Author:

SHENG Jiachuan, Ph.D., professor. Her research interests include digital multimedia processing and pattern recognition.

DONG Yufan, master student. Her research interests include computer vision.

LI Xiaomei, master, professor. Her research interests include science and technology innovation and management.

Style transfer algorithms can generate target artworks quickly. However, the problems are caused by applying style transfer algorithms directly to Chinese paintings, like uneven feature distribution and inconsistent face recognition. To address these issues, a Chinese portrait painting style transfer algorithm based on convolutional neural network(CNN) is proposed. Firstly, a brushstroke control restriction is proposed to guide the texture distribution of the image for freehand brushwork and fine brushwork of Chinese portrait painting. Then, Chinese painting moving distance is proposed to measure content and style features and transfer the style of Chinese painting to portrait photos harmoniously. Finally, the restriction for improving the loss network is put forward based on the ink tone characteristics and the blank space reservation. Experiments show that the proposed algorithm is superior in Chinese painting style and the results maintain the consistency of face recognition.

本文责任编委 叶东毅

Recommended by Associate Editor YE Dongyi

具有中国画风格的肖像画创作不仅需要画家准确把握人物肖像的比例分配和五官特点, 还需要有深厚的中国画创作功底, 需要倾注艺术家们大量的时间和精力.如果能借助计算机技术快速生成中国肖像画, 将大幅提高现代艺术创作的效率, 这具有理论价值与实际应用价值.

近年来, 风格转移被广泛研究, 其利用算法学习目标风格, 并将此风格应用到另一图像上, 使快速生成指定风格的艺术作品成为可能.风格转移技术主要包含两类算法:基于卷积神经网络(Convolutional Neural Network, CNN)的风格转移算法[1]和基于生成式对抗网络(Generative Adversarial Networks, GAN)的风格转移算法[2, 3].

基于CNN的风格转移算法以提取图像的颜色和纹理特征为主, 适合具有独特纹理的艺术画作, 将其风格转移到内容图像中, 使目标图像具有参考画作的纹理风格.其中, 基于CNN的神经风格转移算法主要包括基于图像优化的在线神经转移算法[4, 5, 6, 7]和基于模型优化的离线神经转移算法[8, 9, 10, 11].图像优化的在线神经转移算法侧重于迭代重建与目标匹配的风格, 计算成本较高.模型优化的离线神经转移算法侧重于为特定风格的图像训练生成网络, 相比图像优化的在线神经转移算法, 计算速度提高两个数量级.基于GAN的风格转移算法又可分为图像的异质转换与非同类属性之间的转换.针对图像的异质转换, 转换结果只能做到与风格图像训练集的整体风格类似, 无法做到精准转移.非同类属性之间的转换能将图像中的老虎转换成猫等.

目前学者们大多选择带有强烈纹理及丰富色彩的西方绘画作为风格转移目标.以线造型的中国画呈现的艺术效果与线条层次不鲜明的西方绘画大相径庭, 因此现有的西方画风格转移算法无法直接应用到中国画的风格转移中.Gatys等[4]提出在自然图像上重建西方油画风格的神经风格转移算法(Neu-ral Style Transfer, NST), 使用CNN分离图像的内容特征表示和风格特征表示, 获得较好的艺术效果, 但侧重于重复转移风格, 不能实时工作.Huang等[8]提出自适应实例规范化算法(Adaptive Instance Norma-lization, ADAIN), 在特征分布图层上改变特征的数据分布, 计算开销和存储开销都较小.Wilmot等[5]提出稳定可控的多尺度纹理合成风格转移算法, 使用直方图损失函数合成纹理, 改善传统算法在稳定性和参数调整等方面的问题.Jing等[9]分析接收场和参考风格图像的尺度, 提出笔划连续可控的快速风格转移算法.Li等[6]提出拉普拉斯损失, 用于引导图像合成, 可更好地保留内容图像的细节结构并消除伪影.Kolkin等[10]提出自相似性风格转移算法, 实现指定区域物体的风格转移.Kim等[12]根据艺术画作的几何形状和纹理两个视觉风格基本要素, 提出变形风格转移算法(Deformable Style Trans-fer, DST).

针对人物肖像的风格转移, Liao等[13]提出深度图像类比技术, 在内容图像与参考风格图像中寻找两者语义对应关系, 最终将参考风格传递到内容图像中.方法要求两幅图像的语义严格对应, 不仅要求人物肖像大小一致, 而且脸部需要处于同样的角度.若两幅图像存在偏差, 则效果不佳.Mechrez等[7]提出基于上下文语义的损失, 在对比具有相似语义区域的同时关注整幅图像的内容, 无需对齐语义也能完成风格转移.Khan等[11]通过颜色分布施加空间约束, 保持面部结构的完整性, 减少人脸的变形问题.Yao等[14]提出基于注意力图的多笔画风格转移算法(Attention-Aware Multi-stroke Style Transfer, AAMS), 较好地解决人脸五官分布不协调的问题.施荣晓等[15]提出基于GAN的写实类人物肖像插画转换算法, 引入梯度控制和鉴别特征, 解决人脸变形和面部结构坍塌问题.

目前针对中国画的研究[16, 17, 18, 19, 20, 21]主要集中在图像检索、分类与仿真上, 中国画的风格转移算法[3, 22, 23], 特别是针对中国人物画的研究少之又少.He等[3]提出基于GAN的中国水墨画风格转移算法, 实现动物、山水题材的中国画风格转移, 但需要准备大量相同语义的国画数据制作成对的数据集, 生成结果仅能保证与参考国画数据集的整体风格相似, 不能精确到某一幅国画风格.Sheng等[22]提出基于CNN的中国画风格转移算法(Chinese Painting Style Transfer, CPST), 适用于花鸟鱼虫、山水等非人物的题材, 但运用于人物画进行风格转移时, 会出现人脸扭曲变形的情况.

综上所述, 本文提出基于CNN的中国肖像画的风格转移算法, 确保输出图像不仅能最大限度地保留参考国画的风格特点, 还能保持特征分布的协调性和人脸辨识的一致性.针对两种不同的国画绘画技法, 提出笔触控制约束以改进损失网络, 融合不同种类的笔触特征与内容图像, 指导图像的纹理分布.针对中国肖像画的客观写实性和“ 神形兼备” 的特点, 优化基于CNN的特征提取网络, 提出国画特征移动距离, 最小化人物照片图像与国画风格图像之间的特征分布, 有效解决人脸辨识度较差、扭曲变形等问题.针对国画的水墨色调和留白特点, 提出水墨留白约束以改进损失网络, 使最终的输出图像更接近参考国画的整体色调并具有留白特征.本文算法得到的风格转移结果与参考的中国肖像画风格能保持更高的一致性, 提高艺术创作的效率.

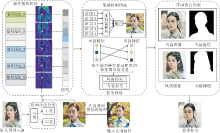

为了能自动生成一幅与参考国画风格一致的中国肖像画, 本文提出中国肖像画的风格转移算法, 确保输出图像不但能最大限度地保留参考国画的风格特点, 还能保持特征分布的协调性和人脸辨识的一致性.算法框图如图1所示.本文算法以人物照片与中国肖像画作为算法输入, 为了保证肖像照风格转移的一致性, 需要参考肖像画的基本布局, 对人物照图像进行剪裁预处理.

写意画线条笔触粗犷, 人物刻画传神; 工笔画线条笔触细腻工整, 细节刻画生动.为了使输出图像更好地具备参考的中国画风格, 本文设计并提出笔触控制约束.主干网络使用VGG16的全卷积层, 共分为5个阶段, 在主干网络中加入膨胀卷积, 较好地解决下采样后感受野变小的问题.分别针对写意画和工笔画进行边缘笔触特征的自动提取与训练, 每个阶段输出一幅边缘特征图, 使对应绘画技法的模型更快收敛.在笔触特征融合阶段分别对写意画和工笔画设计不同的权重策略, 引入残差结构, 将输出的笔触特征与内容图像叠加, 指导损失网络中图像的纹理分布.为了保证生成的目标图像不仅能携带底层网络提取的低级特征, 还能携带中国肖像画的高级特征, 在VGG16特征提取网络的基础上引入超列.为了使人物肖像保持特征分布的协调性并且不发生扭曲变形, 在损失网络设计中, 提出国画特征移动距离, 用于度量两幅图像的特征相似度.针对中国画整体的水墨色调与留白特点, 提出水墨留白约束, 改进损失网络.最终经过本文算法输出的中国肖像画不仅具有参考国画的风格特点, 而且人脸特征分布协调无变形, 辨识度较高.

中国画的构图是衡量画作质量的重要因素之一, 是画家对作品主题和美学的总体设计.开合、虚实、疏密是指导中国画构图的主要依据.开合主要指起承转合, 讲求开合分明; 虚实指有无, 在国画中有画之处为实, 无画之处为虚, 留白即为虚; 疏密指物象的排列关系, 中国画在构图时常会避免对称, 并且要求整体协调.如果将输入图像直接与风格图像进行风格转移, 输出将出现特征分布不协调、面部扭曲变形的现象.如果对输入图像直接进行剪裁, 选择的区域及图像长宽比均未知, 输出具有极大不确定性.因此需要感知风格图像人物占比分布并对输入图像做出匹配剪裁的图像预处理.

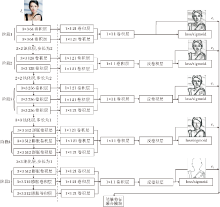

本文利用内容感知的图像剪裁技术对输入的人物照片进行预处理, 参考风格图像语义分布及构图特点, 使处理后的内容图像能最大程度地具备中国肖像画的风格特征, 实现良好的风格转移效果.具体过程如图2所示.

预处理过程如下.

1)对输入的人物照片A进行Laplace算子边缘检测.

2)根据颜色查找饱和度较高的区域.

3)使用人脸识别应用程序接口检测输入的中国肖像画Is中人脸所处位置及占比情况, 得到区域检测图Y.

4)参考图Y对A使用滑动窗口选择宽、高等参数, 生成一组候选图像.

5)基于智能照片剪裁库中的重要性函数对候选图像进行排序, 输出与Y占比相似的候选图像作为内容图像Ic.

当人物肖像的结构占比与参考风格图像相差较大时, 输出图像的人脸区域会出现严重的扭曲变形现象.经过基于内容感知的图像剪裁预处理, 内容图像与风格图像在一定程度上保证语义特征的对齐, 有利于得到良好的风格转移结果.

中国画讲究以线造型, 善于运用不同厚度的线条和水墨色调的变化以描绘不同的物象和它们的位置.为了烘托意境, 画面中通常会有一定的留白, 给鉴赏者留有充足的想象空间.画面多以水墨色调为主.肖像画是中国人物画最早出现的分支, 力求人物刻画逼真传神, 气韵生动, 人物肖像五官的勾勒尤为重要.

针对中国肖像画的风格特点, 本文改进VGG16卷积神经网络以提取图像特征.在各个卷积层中, 接近输入层的底层卷积层能提取输入图像的低级特征, 如人物轮廓、明暗、清晰度、空间位置等.接近输出层的高层卷积层能提取图像更抽象的高级特征.现有文献通常把神经网络的最后一个全连接层作为输入图像的特征表示, 无法精确描述局部空间的特征, 这些特征通常是人物肖像图像不损失辨识度的关键要素.为了解决上述问题, 本文在VGG16特征提取网络中加入超列[24].

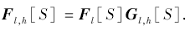

超列为所有CNN单元对应像素位置的激活输出组成的向量.本文提取不同层的输出作为特征, 使用双线性插值将大小不一的特征映射缩放到需要的尺寸大小.F表示特征映射, Φ 表示经过上采样后的特征映射, 在第i个位置提取特征向量:

Φ i=

其中ε ik的数值取决于第i个位置和第k个特征映射.沿着特征维串联所有由式(1)得到的特征向量即可得到每个像素位置的超列, 包括内容图像和风格图像的浅层边缘、颜色特征、中层纹理特征、高层语义特征.浅层网络提取的特征能复用于深层网络, 使得到的中国肖像画更好地保持人物肖像的基本结构与细节特征.

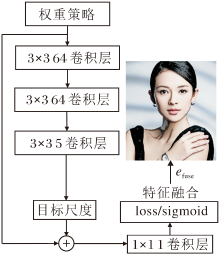

中国画不同绘画技法的笔触特征是中国画风格的重要体现.写意画的特征总体可归纳为粗线条的轮廓与传神的细节.在写意人物肖像画中, 画作多用大面积的墨色晕染人物肖像次重要的部分, 如面积占比较大的头发区域等.人物的五官是肖像画的传神之处, 画家通常用寥寥几笔, 点缀出令人意想不到的神韵.工笔画因其细腻工整的线条笔触成为中国肖像画中具有代表性的一类.在工笔人物肖像画中, 无论是面积占比大的头发区域, 还是五官的细节轮廓, 笔触均细致入微, 线是画面的灵魂.各种笔力的运用均来源于画家持之以恒的训练, 描线技法多达18种.因此, 本文针对中国画的上述特点提出笔触控制约束, 网络结构如图3所示.

笔触控制约束模型以更丰富的卷积特征检测(Richer Convolutional Features for Edge Detection, RCF)[25]结构为基础, 图3中虚线左侧为主干网络, 右侧为深监督(Deep Supervision, DS)模块, 最下方为特征融合模块.主干网络分成5个阶段以提取图像的边缘特征.传统的卷积结构只能处理局部感受野中的空间信息和特征信息, 常会忽略很多重要的细节特征, 并且当下采样的次数越多, 图像的细节信息丢失越多.因此本文模型使用膨胀卷积[26]取代主干网络后两个阶段的传统卷积, 在不增加计算参数量的同时扩大感受野.去除后两个下采样, 使用3× 3的池化层, 并设置步长为1.右侧的DS模块对主干网络提取的笔触特征连续使用2个1× 1的卷积进行压缩, 再通过反卷积实现上采样.5个阶段分别输出1次边缘特征图, 提升主干网络提取效率, 改善不同绘画技法的模型训练效果.

笔触特征融合模块在原有网络的基础上加入不同的权重策略, 更好地匹配写意画和工笔画的不同笔触特征:

(efuse, e1, e2, e3, e4, e5)=RCF'(Ic, P, w, wf),

其中, efuse表示笔触特征融合模块的融合边缘特征, ei(i=1, 2, …, 5)表示5个阶段输出的边缘特征, RCF'表示改进后的RCF检测网络, Ic表示输入算法的内容图像, P表示检测网络的基本参数, w表示各阶段输出的边缘特征的权重, wf表示笔触特征融合模块融合权重.

在5个阶段输出的边缘特征中, 图像的内容信息逐渐减少, 边缘纹理信息与语义信息逐渐增加.根据参考中国画的分类结果, 本文设计不同的权重策略, 用于匹配写意肖像画和工笔肖像画, 指导损失网络进行训练.除对efuse设置不同的权重外, 针对不同的分类结果还分别对不同阶段输出的边缘特征赋予不同权重, 加深对应技法的纹理信息.经过文献[22]及多次实验, 将分类结果为写意的中国肖像画目标笔触的权重分别设计为0.4, 0.8, 0.1, 更好地突出图像粗线条的轮廓特征:

Sgoal=w1e2+w2e4+w3efuse.

针对分类结果为工笔的中国肖像画, 将目标笔触的权重分别设计为0.2, 0.8, 0.4, 更好地突出图像细致的线条笔触:

Sgoal=w1e1+w2e5+w3efuse.

在设计不同的权重策略后, 为了更好地融合多尺度笔触特征, 本文加入能对多尺度特征信息进行处理的残差结构, 如图4所示.

笔触特征融合模块通过2个分支进行输入, 相加后实现多尺度笔触特征融合.再经过1个1× 1的卷积压缩后与内容图像叠加, 指导损失网络中图像的纹理分布.加入笔触控制的内容图像:

Istr(Sgoal)=γ 1Sgoal+γ 2Ic.

其中:Istr表示融合笔触纹理的内容图像作为损失网络的输入; γ 1=0.25表示目标笔触的比例; γ 2=0.75表示原内容图像的比例.

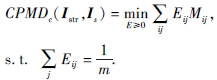

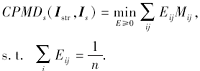

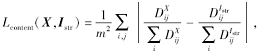

目前的风格转移算法相关文献通常使用Gram矩阵度量输出图像与风格图像在风格上的差异.Gram矩阵可看作是特征之间的偏心协方差矩阵, 特征图中每个数值都来自于特定滤波器在特定位置的卷积, 表示每个特征的强度.因此, Gram矩阵计算两幅图像两两之间的相关性.当风格转移的过程仅依赖于Gram矩阵时, 得到趋于混沌的图像纹理.此方法并不适用于中国画的水墨色调与留白特征, 并且无法直接适用于人物肖像的风格转移.为了有效解决此问题, 本文提出国画特征移动距离(Chinese Painting Moving Distance, CPMD):

CPMD(Istr, Is)=

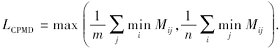

其中:Istr=[Istr1, …, Istri, …, Istrm], 为叠加笔触纹理指导的内容图像中的m维特征向量; Is=[Is1, …, Isj, …, Isn], 为风格图像中的n维特征向量; E为国画特征传输矩阵, 表示成对的特征匹配; M为国画特征代价矩阵, 表示Istr中特征向量与Is中特征向量分布的远近程度[27], 记录2个向量之间的传输成本.CPMD通过度量内容图像与风格图像特征向量之间的相似度, 记录中国肖像画的特征结构.本文对式(2)加入m维特征向量的约束条件, 内容图像特征向量的度量表示为

对式(2)加入n维特征向量的约束条件, 风格图像特征向量的度量表示为

CPMD能更好地表征中国肖像画的结构特征并最小化特征分布, 使输出结果保持特征分布的协调性.对应的损失函数如下:

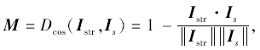

此损失函数将中国肖像画特征的结构形式传递给目标图像.M为国画特征代价矩阵:

其中, Dcos表示特征集合Istr和Is成对坐标位置的余弦距离.

水墨留白, 虚实相生.在大量的中国画作品中, 留白使画面协调精美, 为观者留下无限想象的空间.在传统中国画中主要使用矿物颜色和植物颜色, 不同的材料造就国画作品中丰富的色彩.针对国画水墨色调及留白特点, 本文提出国画水墨留白约束, 实现图像最终的国画特征调整.

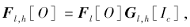

人物肖像画主要分为人物前景与背景, 人物前景通常具有丰富的水墨色调, 背景通常留白.针对这种特点, 本文将掩膜[28]添加到图像上作为另一个通道[29], 通过传播掩膜通道增强神经网络风格转移算法, 更新当前的风格损失函数:

其中:O表示内容图像和风格图像经过LCPMD最小化国画特征分布后的输出图像; Fl, h[· ]表示特征矩阵, h表示掩膜中的通道数量; Nl表示滤波器的数量; Gl, h[· ]表示第l层掩膜的通道; El, h[· ]表示与Tl, h[· ]对应的国画特征传输矩阵.

在CNN的每层对掩膜进行降采样, 匹配特征空间的大小, 再结合LCPMD, 可得到国画水墨留白损失.为了使墨色匹配后的最终结果保留前一阶段的内容特征, 本文在LCPMD中加入调整权重η , 最终得到国画水墨留白损失:

Link=

在风格转移算法中, 内容损失函数描述内容图像与输出图像特征之间的距离, 基于CPMD损失, 其中国画特征代价矩阵表示特征集合与风格图像成对坐标位置的余弦距离, 本文的内容损失函数选择使用向量之间的余弦距离表示为

其中, X表示特征提取的高列特征向量, Istr表示内容图像的特征向量集合,

综上所述, 本文的中国肖像画风格转移算法最终的损失函数为

Lfinal(Istr)=

其中, λ l、 μ l、υ l为配置选项权重, α 为LCPMD的控制权重, β 为Link的控制权重.

在天津美术学院教授及《中国画图鉴》等相关文献指导下, 从互联网收集并筛选五代时期到近现代共3 000幅中国人物画组成数据集, 画作涵盖写意和工笔的绘画技法, 样本数据广泛.将中国画数据集作为输入微调VGG16网络的预训练模型并提取特征, 批处理大小为64, 迭代共计20 000次.ImageNet数据集预训练模型具备丰富的图像特征, 在此基础上使用中国画数据集微调预训练模型, 在加快训练速度的同时, 解决中国画数据量较少带来的过拟合问题.

在conv4_2中, λ 1=1, 其余层中λ 1=0.在卷积层1_1、2_1、3_1、4_1、5_1中, μ 1=0.25, 其余层中μ 1=0.在卷积层1_1、4_1中, υ 1=0.5, 其余层中υ 1=0.α =4, β =1.

在Ubuntu16.04系统上进行实验.深度学习网络架构采用PyTorch并依赖CUDA运算平台进行加速.处理器为Intel core i7 4710HQ, GPU为NVIDIA Quadro K1200.

为了验证本文针对2种绘画技法提出的不同处理策略的有效性, 首先对参考的中国肖像画进行分类实验.实验在Windows 10系统上进行, 深度学习网络架构采用TensorFlow.实验基于预训练的Goo-gle InceptionV3模型[30], 训练集包含2 500幅国画, 测试集包含500幅国画, 其中写意画与工笔画的数量各占数据集的50%.学习率为10-3, 批处理大小为32, 分类类别设置为2.在中国画数据集的基础上迭代训练共8 000次, 最终准确率为0.95, 召回率为0.97.

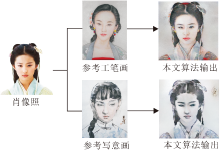

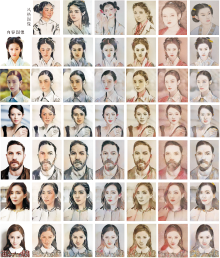

本文算法输入的参考国画将通过训练好的国画分类模型得到分类结果, 在笔触控制约束部分分别被赋予不同的权重进行特征融合, 在损失网络中完成风格转移, 得到的实验结果与参考国画风格保持一致, 结果如图5所示.

为了证实本文算法能在不同的参考图像上均有良好表现, 在体现中国画风格的同时, 保持人物肖像的辨识一致性, 不发生扭曲变形.在数据集上选择6幅中国肖像画, 分别与6幅人物肖像照进行风格转移, 实验结果如图6所示.

由图6可知, 本文算法无需将输入的内容图像与风格图像保持语义对齐, 也能保证人物肖像特征无明显不协调, 脸部未出现扭曲变形现象, 并且保证人脸辨识的一致性.加入笔触控制约束, 使图像不再具有人物照片图像中的真实画面机理, 呈现良好的参考的中国画风格.

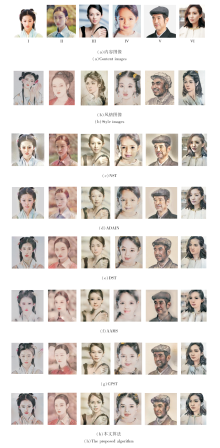

为了证实本文算法对于中国肖像画具有良好的风格转移效果, 选择如下对比算法:NST[4]、ADAIN[5]、DST[10]、AAMS[14]、CPST[22].各算法风格转移结果如图7所示.

NST生成的风格转移结果与原始输入更相似, 转移的纹理结构较简单.虽然颜色特征有一定程度的转移, 但人物肖像出现伪影, 对中国画风格并不敏感, 无法生成令人满意的结果.ADAIN生成的风格转移结果比NST特征转移更明显, 伪影现象有一定减少, 但局部特征依然有变形, 基本不具备2种国画技法对应的代表特征.AAMS是加入内容图像注意力图的风格转移算法, 针对人物风格转移会出现的五官变形问题, 在注意力图的引导下, 保持人物五官的基本结构、神态表情, 但对中国画2种绘画技法的风格特征不敏感, 生成的人物肖像画线条感弱.DST旨在从几何形状和纹理2个视觉风格的基本要素出发, 通过特征点匹配完成图像艺术风格的转移, 但仅对图像的纹理和形状进行约束, 未考虑内容的辨识度与整体艺术效果, 生成的人物肖像造型夸张, 不够写实.CPST是针对中国画风格提出的风格转移算法, 自动生成中国画, 但用于人物题材时会出现局部特征不协调、人脸辨识不一致甚至扭曲变形的现象, 不适用于人物画的风格转移.本文算法能针对参考的某种特定的中国肖像画, 将输入的肖像照片图像转化成具有国画风格的艺术作品, 输出结果不仅能保持肖像特征分布的协调性和人脸辨识的一致性, 还能充分表现中国画的笔触、水墨色调和留白特点.

图7(b)中第2幅风格图像为杨佩璇作品, 使用工整细腻的笔触表现中国古代女子的丹凤眼、柳叶眉等五官特征.对比本文算法, 最大限度地将人物照片转移为极具该工笔人物特色的中国肖像画, 充分展示参考国画的人物神韵.图7(b)中第5幅风格图像为郭全忠作品, 人物肖像的表达十分传神.简单的水墨笔触却捕捉不简单的人物特征, 刻画出质朴的百姓形象.对比本文算法, 输出结果与风格图像笔触相似, 表现出一致的人物肤色及神态特征.本文算法得到的风格转移结果使背景基本保持留白的特征, 当输入背景复杂的内容图像时, 本文算法也能弱化背景带来的不协调现象.

为了验证本文算法在中国肖像画的风格转移结果上不仅具有良好的视觉感官效果, 而且与参考的中国画风格更相似, 符合风格转移技术要求输出结果在保持内容的条件下更保持参考风格图像的风格特征.

实验中将算法生成的结果图像与参考的国画风格作为定量实验的输入, 使用向量空间的余弦相似度度量方法分别对图7(a)所示的6幅图像进行余弦相似度对比分析, 结果如表1所示.由表可知, 本文算法与参考的中国画风格更接近.

| 表1 各算法的余弦相似度对比 Table 1 Comparison of cosine similarity of different algorithms |

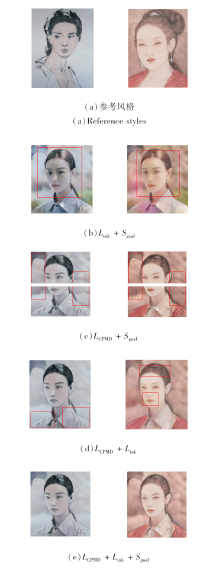

为了验证本文算法提出的每项损失函数都对输出结果产生重要影响, 分别针对写意人物肖像画和工笔人物肖像画进行消融实验(Ablation Study), 结果如图8所示, 余弦相似度对比如表2所示.

| 表2 各损失函数的余弦相似度对比 Table 2 Comparison of cosine similarity of loss functions |

LCPMD为本文的国画特征移动距离损失, 主要用于完成国画风格的特征转移.Link为本文的国画水墨留白损失, 主要用于进一步实现国画图像的留白及画作水墨色调的特征.Sgoal为本文的笔触控制约束, 主要使用不同的笔触融合策略指导国画的纹理合成.若仅使用Link+Sgoal, 目标图像并未协调地部署风格图像的中国画风格.若仅使用LCPMD+Sgoal, 只能完成中国肖像画的基本风格转移, 忽略中国画整体的水墨色调风格及留白特点.若仅使用LCPMD+Link, 目标图像缺少国画不同技法的笔触特征.只有使用LCPMD+Link+Sgoal, 才能得到较满意的风格转移算法输出结果.

为了得到客观的实验结论, 通过用户研究(User Study)表征各算法输出结果的质量.根据中国肖像画的笔触、留白及水墨色调特征风格转移的结果, 分别设计单项评价和综合评价.单项评价从国画的特征出发, 包括笔触、留白及水墨色调.综合评价从肖像照片经过风格转移后形成的最终效果出发, 包括人物肖像特征分布是否协调、人脸辨识是否一致无变形及中国画特征的总体保留效果.

参与评价的人员包括美术专业人士20名, 非美术专业人士20名.评价结果经统计后如图9所示.由图可得, 本文算法在笔触、留白和水墨色调上表现最佳, 在保证特征分布协调性的同时确保人脸辨识的一致性, 无扭曲变形问题, 整体效果良好.

基于CNN, 本文提出中国肖像画的风格转移算法, 将人物照片自动生成具有中国画风格的中国肖像画.针对2种不同的国画绘画技法, 提出笔触控制约束改进损失网络的方法, 融合不同种类的笔触特征与内容图像, 指导图像的纹理分布.以最小化特征分布为优化目标, 提出国画特征移动距离(CPMD), 度量内容特征与风格特征, 将参考中国画的风格特征协调地部署在肖像照图像上.针对国画的水墨色调与留白特征, 提出水墨留白约束改进损失网络的方法.实验表明, 本文算法生成的肖像画不仅保证特征分布的协调性及人脸辨识的一致性, 而且视觉效果优于现有的中国画风格转移算法.今后的工作将围绕为算法加入交互式语义控制展开, 以满足不同用户对输出中国肖像画的细节要求.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|