曹飞龙,博士,教授,主要研究方向为深度学习、图像处理等.E-mail:feilongcao@gmail.com.

作者简介:

杜子金,硕士研究生,主要研究方向为深度学习、点云分析等.E-mail:thetempest0302@163.com.

叶海良,博士,讲师,主要研究方向为深度学习、图像处理.E-mail:yhl575@163.com.

梁吉业,博士,教授,主要研究方向为人工智能、粒计算、数据挖掘等.E-mail:ljy@sxu.edu.cn.

3D点云的不规则性与无序性使点云的分类仍具有挑战性.针对上述问题,文中设计基于残差边卷积的3D点云分类算法,可直接从点云学习到具有区分度的形状描述子,用于目标分类.首先,设计具有残差学习的边卷积模块,用于点云的特征提取.通过 K近邻算法,该边卷积模块在输入点云上构建局部图,使用卷积及最大池化进行局部特征的提取与聚合.然后,通过多层感知器从原始点特征中提取全局特征,并以残差学习的方式与局部特征结合.最后,以该卷积块为基本单元,构建深度神经卷积网络,实现3D点云的分类.文中方法较全面地考虑点云局部特征与全局特征的有机结合,网络具有更深层次的结构,最终得到的形状描述子更抽象,具有更高的区分度.在具有挑战性的ModelNet40、ScanObjectNN数据集上的实验证实文中方法的分类性能较优.

CAO Feilong, Ph.D., professor. His research interests include deep learning and image processing.

About Author:

DU Zijin, master student. His research interests include deep learning and point cloud analysis.

YE Hailiang, Ph.D., lecturer. His research interests include deep learning and image processing.

LIANG Jiye, Ph.D., professor. His research interests include artificial intelligence, granular computing and data mining.

The irregularity and disorder of 3D point cloud make the classification of point cloud more challenging. Therefore, a 3D point cloud classification algorithm based on residual edge convolution is designed. The discriminative shape descriptor can be learned from the point cloud directly and used for target classification. Firstly, an edge convolution block with residual learning is designed for feature extraction on the point cloud. In the edge convolution block, local graph is constructed with the input point cloud through the K-nearest neighbor algorithm and the local features are extracted and aggregated via convolution and maximum pooling, respectively. Subsequently, global features are extracted from the original point features through the multi-layer perceptron and combined with the local features in a residual learning way. Finally, a deep neural convolution network is constructed with the convolution block regarded as the basic unit to realize the classification of 3D point cloud. The organic combination of local features and global features is considered comprehensively. With a deeper structure, the network makes the final shape descriptor more abstract and discriminative. Experiments on two challenging datasets, ModelNet40 and ScanObjectNN, show that the proposed method obtains superior classification results.

本文责任编委 杨 健

Recommended by Associate Editor YANG Jian

点云是三维空间中的一组点, 可用于表示3D表面.每点都有一个空间位置坐标(x, y, z)及一个属性矢量, 如颜色, 强度或法线.由于点云可重建3D对象或场景, 因此点云处理广泛应用于各种领域, 如自动驾驶[1]、虚拟现实[2]、城市规划[3]等.在点云处理中, 点云的分类是最基本且具有挑战性的问题, 受到研究人员的广泛关注.这项任务的关键在于提取的特征是否丰富并且是否具有高度判别能力.

然而, 点云的如下属性使点云的特征提取具有挑战性.1)非结构化性.点云是一系列不均匀的采样点.一方面, 它使各点之间的相关性难以用于特征提取.另一方面, 在图像/视频处理中广泛使用的卷积神经网络不能直接应用于点云处理.2)无序性.与图像和视频不同, 点云是一组无特定顺序的点.因此, 所有关于点云特征提取的算法都必须不受输入点排列次序的影响.

至今, 学者们提出许多有效提取点云特征的深度学习方法, 主要分为基于投影的方法[4, 5]、基于点的方法[6, 7, 8]和基于图的方法[9, 10, 11].基于投影的方法通常需要先将点云转换到规则域中, 如多视角图像、体素网格、球面网格等, 然后采用规则域中的深度学习方法进行特征提取.然而, 这样往往会在数据转换过程中破坏原始点云的几何特性, 丢失信息.因此, 近年来学者们更多研究基于点的方法与基于图的方法, 这两类方法都是直接在点云上进行特征提取而不需要进行数据转换.Qi等[6]提出点网络(Point-Net), 使用多层感知器(Multi-layer Perceptron, MLP)与对称函数(如全局池化)提取全局形状描述子, 用于形状分析.Qi等[7]采用最远点采样(Fastest Point Sampling, FPS)与球查询的方法, 分别对点云进行下采样分组, 再以共享的MLP提取局部特征, 如此重复多次, 最终获取全局的形状描述.Simonovsky等[11]提出边条件卷积(Edge-Conditioned Convolution, ECC), 将图方法应用于点云特征学习, 可有效处理非结构化的数据.Feng等[9]在点云上构建图卷积时引入注意力机制, 自适应地聚合邻域特征.

虽然上述工作取得较优的形状分类性能.然而, 大部分网络结构仍是卷积层的简单堆叠, 网络层数较浅, 这在很大程度上限制网络特征提取的能力, 使特征提取不够充分且缺乏深度.

为了解决这一问题, 本文提出基于残差边卷积的3D点云分类算法.以动态图卷积(Dynamic Graph Convolutional Neural Network, DGCNN)[12]为基本卷积算子, 提取点云的局部特征.并在此基础上引入全局的特征学习与残差学习, 构建残差边卷积块.该卷积块在提取深度局部特征的同时, 采用MLP提取点云的全局特征, 并以残差学习的方式融合局部特征与全局特征.算法一方面丰富特征的多样性, 另一方面改善网络之间的信息传递, 缓解因网络层数加深产生的网络退化问题.

形状分类的关键在于提取一个具有高度判别能力的形状描述子, 该形状描述子通常被表示为一个高维的特征向量.因此, 本文提出残差边卷积神经网络, 用于点云分类.网络结构具体如图1 所示, 网络通过1个边卷积(Edge Convolution)及3个残差边卷积块(Residual Edge Convolution Block)分层进行特征提取.将边卷积及堆叠的残差边卷积块提取得到的特征分别记为X1, X2, X3, X4.再通过密集连接的方式将其拼接, 执行一次卷积操作进行融合, 以充分利用不同层次的特征.

为了获取最终的全局形状描述子f, 本文将全局最大池化和平均池化得到的2个高维向量进行拼接, 保留更多的特征信息.整个过程描述如下:

其中, ‖ 表示拼接操作, * 表示卷积运算, Γ 表示非线性激活函数, $\widetilde{W}$表示融合特征阶段的卷积核权重.

最后形状描述子f被输入到3层全连接网络中, 用于预测最终的分类结果.该全连接网络中前两层网络随机丢弃神经节点的概率为0.5.第三层为线性层, 将目标预测为最终的分类得分.

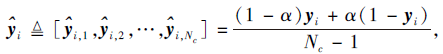

令

X={x1, x2, …, xN}∈ RC× N

为具有N个点的C维点云.在深度网络中前一层的输出被用作后一层的输入.因此, C通常表示当前层特征的维度.为了捕获点云细致的局部结构特征, 本文根据DGCNN中构图的方式, 将点云构建为一系列的局部图, 并在图上构建边卷积, 结构如图2(a)所示.

首先, 以每个点xi及它的K个近邻点xi, j∈ N(xi)构建局部图结构,

N(xi)={xi, j∶ ‖ xi, j-xi‖ < δ , j=1, 2, …, K},

其中‖ · ‖ 表示欧几里得范数.每次卷积层都是根据特征空间的距离确定每个点的K近邻, 因此在每层中随特征变化的局部图是动态更新的.通过动态更新的图结构可有效捕获点云在高维空间中的相关性.为了体现邻域点与中心点之间的相关性, 定义图上的节点特征集合:

于是, 边卷积的输出

Xout=Maxpool(Γ (W* H))∈ RC'× N,

其中, W为卷积核的权重, Maxpool为对称函数, 保证对任意顺序的输入点集, 输出都保持不变, 从而确保在点云特征提取过程中的置换不变性.

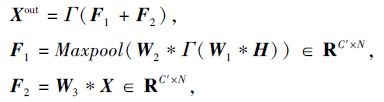

为了强化特征提取能力, 加深网络是一种简单、有效的手段.然而, 简单堆叠卷积层反而会因网络的退化造成特征提取能力的减弱.如图2 (b)所示, 本文在边卷积的基础上, 结合PointNet与残差学习的思想, 构建具有更深层次结构的残差边卷积块.该卷积块的输出为

其中, F1表示从局部图上学习得到的细节特征, F2表示MLP分支学习到的全局特征, W1、W2、W3为卷积核的权重.

整个卷积块能提取到更深层次的细节特征, 并通过残差学习的方式补充全局特征, 从而丰富点云的特征表示.此外, 残差学习能有效缓解深度网络退化的问题, 构建更深层次的网络, 提高特征提取的能力.此外, 由于在网络特征提取的过程中局部图结构是动态更新的, 因此, 该卷积块能捕获更细致的点对之间的相关性.

实验设备使用一块RTX 6000进行加速运算, 并以Pytorch1.6作为深度学习框架进行网络的搭建与训练.为了公平对比其它方法, 所有的实验结果来源于论文本身.

本文使用整体精度(Overall Accuracy, OA) 和类平均精度(Class-Wise Mean Accuracy, mAcc)作为分类的性能评估指标.

残差边卷积网络中各层的参数如表1所示.表中N表示点的个数, K表示邻域中点的个数, Nc表示类别数, 残差边卷积层的通道数从左到右边依次为卷积核W1、W2、W3的个数.

| 表1 残差边卷积网络各层参数设置 Table1 Parameter settings of each layer of residual edge convolutional network |

另外, 在网络训练阶段, SGD优化器的训练轮数为400, 初始学习率为0.1, 动量系数为0.9, 权重惩罚因子为0.000 1.学习率通过余弦退火函数[15]衰减到0.001.

本文在ModelNet40[16]、ScanObjectNN[17]数据集上进行实验.ModelNet40数据集是3D形状分类任务常用的基准数据集, 包含40个类别的计算机辅助设计(Computer Aided Design, CAD)模型, 总计12 311个.为了公平对比现有算法, 使用相同的方法划分数据集, 9 843个样本用于训练, 2 468个样本用于测试.此外, 与DGCNN[13]相同, 每个样本被表示为归一化坐标的1 024个点.

ScanObjectNN数据集是真实世界的数据, 样本不仅包含目标本身, 还包含背景信息及噪声干扰.因此, 此数据集更真实、复杂, 具有挑战性.与Model-Net40数据集不同, 每个样本由2 048个坐标归一化的点表示.

在训练阶段, 为了提高样本的多样性, 采用如下操作增强数据:1)[-0.8, 1.25]内的随机各向异性缩放; 2)添加服从N(0, 0.01)分布的随机抖动; 3)随机丢弃部分点 (不超过总点数的12.5%).

本文选择如下算法作为对比方法:PointNet[6]、点网络加强版(PointNet++)[7]、ECC[11]、DGCNN[12]、蛛网型卷积神经网络(Spider Convolutional Neural Network, SpiderCNN)[18]、K维树型网络(K-dimen-sional Tree Network, Kd-Net)[19]、自组织网络(Self-organizing Network, SO-Net)[20]、点卷积神经网络(PointCNN)[21]、点卷积(Point Convolution, Point-Conv)[22]、拓展点卷积神经网络(Point Convolutional Neural Networks by Extension Operators, PCNN)[23]、环形卷积神经网络(Annularly CNN, A-CNN)[24]、形状关系卷积(Relation-Shape CNN, RS-CNN)[25]、几何结构卷积神经网络(Geometric Structure CNN, Geo-CNN)[26]、连续点卷积(Continuous Convolutions for Point Cloud, ConvPoint)[27]、点云自适应采样非局部网络(Point Cloud Adaptive Sampling Nonlocal Neural Networks, PointASNL)[28]、修正的3D费舍尔向量表示(3D Modified Fisher Vector Representation, 3Dm-FV)[29].各方法在Model-Net40、ScanObjectNN数据集上的性能对比如表2和表3所示, 表中黑体数字表示最优结果.

| 表2 各算法在ModelNet40数据集上的分类性能 Table 2 Classification performance of different algorithms on ModelNet40 dataset |

| 表3 各算法在ScanObjectNN数据集上的分类性能 Table 3 Classification performance of different algorithms on ScanObjectNN dataset % |

在ModelNet40数据集上, 本文算法在OA、mAcc指标上分别达到93.67%和91.3%, 并且仅采用1 024个点的坐标信息就已取得较优结果, 甚至超过以更多点或更多信息作为输入的方法, 如DGCNN、SO-Net、PointASNL等.在ScanObjectNN数据集上, 本文算法不仅在OA、mAcc指标上超出次优方法约4%, 提高点云分类的性能, 而且在多个类别的分类性能上取得最优结果.

最后, 本文采用T分布随机邻域嵌入(T-distri-buted Stochastic Neighbor Embedding, T-SNE)[30]对获得的形状描述子进行可视化, 如图3所示.由图可看出, 获得的形状描述子具有良好的判别能力, 可有效分类不同类别.这在很大程度上受益于残差边卷积提取较丰富的特征和构建网络的深层次结构.

本节讨论网络中不同成分对分类性能的影响.本文构建4组模型的自身消融对比实验.模型A采用原始边卷积进行特征提取.模型B采用串联方式在模型A的基础上堆叠更多层边卷积, 构建更深的特征提取网络.模型C采用残差边卷积块构建深度特征提取网络.模型D在模型C的基础上采用密集连接的方式融合不同层次的特征.实验结果如表4所示.

| 表4 各模型的消融实验结果对比 Table 4 Comparison of ablation experiment results of different models % |

由表4可看出, 当以简单串联的方式加深网络结构时, 反而会出现网络退化问题, 分类性能欠佳.残差边卷积块能有效改善网络中信息的传递, 一定程度上缓解网络退化的问题, 有效增强特征提取的性能.此外, 采用密集连接的方式能有效融合不同层次的特征, 使最终的形状描述子具有更丰富的特征, 更具判别能力.

在相同的实验环境下, 与DGCNN对比, 分析本文算法的时间复杂度, 具体如表5所示.由表可知, 由于本文算法加深模型深度, 在训练阶段需要花费较多的时间保证模型得到充分的训练.而在测试阶段, 本文算法花费时间与DGCNN仍保持同一水平.结合分类性能提升的幅度来看, 时间复杂度的小幅度提升是可接受的.

| 表5 各算法的时间复杂度分析 Table 5 Time complexity analysis of different methods |

残差边卷积块涉及的超参数仅有一个邻域节点的数量K, 该参数控制局部图的大小, 即卷积核的大小.于是, 本文通过一组对比实验, 分析不同大小的邻域选择对分类性能的影响, 结果如表6所示.

| 表6 ModelNet40数据集上邻域节点数量对分类性能的影响 Table 6 Effect of the number of neighbor nodes on classification performance on ModelNet40 dataset % |

由表6可知, 当局部图过小时, 由于局部结构特征提取不充分, 分类结果较差.而当局部图过大时, 由于信息的冗余反而使局部特征提取能力下降, 同样影响分类精度.因此, 通过实验发现, 当K=20时, 分类性能达到最优.

本文提出基于残差边卷积的3D点云分类算法.一方面, 设计具有残差学习的残差边卷积块, 该卷积块融合基于图的方法与基于点的方法, 分别提取点云上的局部特征与全局特征, 并采用残差学习的方式融合两类特征.另一方面, 采用的残差连接方式可改善网络中的信息传递, 有效缓解因网络层数加深而出现的网络退化问题.此外, 本文以提出的残差边卷积块作为基本单元构建深度卷积神经网络, 以分层形式提取深度特征, 采用密集连接的方式充分利用不同层次的特征.最终通过全局最大池化与全局平均池化获取形状描述子, 用于分类预测.本文获取的形状描述子具有丰富的语义信息.在两个具有挑战性的数据集上的实验验证本文算法的优越性.本文通过T-SNE对形状描述子进行可视化, 验证最终的形状描述子具有较强的分辨能力, 即同一类别的形状描述子距离较小, 不同类别的形状描述子之间的距离较大.

本文算法从整体来看具有较优性能, 然而对于某些类别的分类效果还不是很理想, 产生该问题的原因在很大程度上是由于分类目标的类别数量不平衡, 导致在训练过程中对某些数量较少的类别学习不充分.今后可针对类不平衡问题设计合理的损失函数, 用于加强网络对数量较少或难度较大的类别的学习能力.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|