孙 锐,博士,教授,主要研究方向为计算机视觉、机器学习.E-mail:sunrui @hfut.edu.cn.

作者简介:

余益衡,硕士研究生,主要研究方向为图像信息处理、计算机视觉.E-mail:2020111040@mail.hfut.edu.cn.

张 磊,硕士研究生,主要研究方法为图像信息处理、计算机视觉.E-mail:2020171121@mail.hfut.edu.cn.

张旭东,博士,教授,主要研究方向为智能信息处理、机器视觉.E-mail:xudong@hfut.edu.cn.

现有的有监督可见光-近红外行人重识别方法需要大量人力资源去除手工标注数据,容易受到标注数据场景的限制,难以满足真实多变应用场景的泛化性.因此,文中提出基于语义伪标签和双重特征存储库的无监督跨模态行人重识别方法.首先,提出基于对比学习框架的预训练方法,利用可见光行人图像和其生成的辅助灰度图像进行训练.利用该预训练方法获取对颜色变化具有鲁棒性的语义特征提取网络.然后,使用DBSCAN(Density-Based Spatial Clustering of Applications with Noise)聚类方法生成语义伪标签.相比现有的伪标签生成方法,文中提出的语义伪标签在生成过程中充分利用跨模态数据之间的结构信息,减少跨模态数据颜色变化带来的模态差异.此外,文中还构建实例级困难样本特征存储库和中心级聚类特征存储库,充分利用困难样本特征和聚类特征,让模型对噪声伪标签具有更强的鲁棒性.在SYSU-MM01、RegDB两个跨模态数据集上的实验验证文中方法的有效性.

SUN Rui, Ph.D., professor. His research interests include computer vision and machine learning.

About Author:

YU Yiheng, master student. His research interests include image information processing and computer vision.

ZHANG Lei, master student. His research interests include image information processing and computer vision.

ZHANG Xudong, Ph.D., professor. His research interests include intelligent information processing and machine vision.

The existing supervised visible infrared person re-identification methods require a lot of human resources to manually label the data and they fail to adapt to the generalization of real and changeable application scenes due to the limitation by the labeled data scene. In this paper, an unsupervised cross-modality person re-identification method based on semantic pseudo-label and dual feature memory banks is proposed. Firstly, a pre-training method based on the contrast learning framework is proposed, using the visible image and its generated auxiliary gray image for training. The pre-training method is employed to obtain the semantic feature extraction network that is robust to color changes. Then,semantic pseudo-label is generated by density based spatial clustering of applications with noise (DBSCAN) clustering method. Compared with the existing pseudo-label generation methods, the proposed method makes full use of the structural information between the cross-modality data in the generation process, and thus the modality discrepancy caused by the color change of the cross-modality data is reduced. In addition, an instance-level hard sample feature memory bank and a centroid-level clustering feature memory bank are constructed to make the model more robust to noise pseudo-label by hard sample features and clustering features. Experimental results obtained on two cross-modality datasets, SYSU-MM01 and RegDB, demonstrate the effectiveness of the proposed method.

行人重识别技术的目的是给定一幅特定摄像机拍摄的行人图像, 在其它非重叠摄像机视图中匹配相同的行人目标[1, 2].该技术广泛应用于现实生活中, 特别是在视频监控系统当中.然而现有的单一模态行人重识别技术在生活中的应用存在局限性, 并不能解决光照条件不好时的识别问题, 所以引入跨模态可见光-近红外行人重识别技术.该技术旨在将由可见光摄像头捕获的可见光行人图像和由红外摄像头获取的近红外行人图像进行匹配.现有的可见光-近红外行人重识别方法都是属于有监督类方法, 利用大量人为注释添加的标签训练深度学习网络提取的特征, 得到有利于识别的模态不变特征表示.然而, 相比单模态行人重识别, 有监督模型需要的跨模态行人身份标签更难获取.首先, 挑选同时出现在可见光摄像头和近红外摄像头中的行人需要耗费大量的人力资源和时间成本.其次, 相比可见光图像, 近红外图像缺少重要的颜色信息, 导致注释者难以判断近红外图像和可见光图像是否是同一个人.因此, 利用无标签信息的行人图像数据解决可见光-近红外行人重识别问题具有重大意义.此类方法可定义为无监督跨模态可见光-近红外行人重识别.

无监督可见光-近红外行人重识别中存在2个主要挑战.1)相比传统单模态可见光行人重识别, 可见光-近红外行人重识别存在模态差异.2)相比有监督模型, 由于缺少行人身份标签, 无监督模型很难学习具有辨识度且鲁棒的行人特征.因此, 现有的行人重识别方法并不能完全解决无监督可见光-近红外行人重识别问题.现有方法研究重点分别是无监督可见光行人重识别和有监督跨模态行人重识别, 却少有学者涉及无监督跨模态可见光-近红外行人重识别领域.

在跨模态行人重识别中, 模态差异主要来自于不同模态行人图像之间的颜色信息, 相比可见光图像, 近红外图像缺少足够的颜色信息.因此, 颜色信息特征并不能作为跨模态任务中的共享信息.但是, 不同模态行人依然有共享信息, 如身份标签、行人的语义信息等.现有的有监督方法充分利用跨模态身份对标签, 但是在无监督任务当中, 并不存在跨模态身份标签信息.因此, 对颜色信息具有鲁棒性的高级语义信息就成为解决无监督跨模态行人重识别中模态差异的重点.在现有无监督任务中, 基于伪标签的无监督模型是当下的主流方法.但是, 聚类生成的伪标签中存在噪声标签, 从而误导特征学习.

现有的无监督域自适应行人重识别方法主要可分成2类:分布对齐方法和基于伪标签的自适应方法.分布对齐方法的目标是学习跨域不变特征以解决不同域之间的差异.Lin等[3]和Wang等[4]尝试利用语义属性对齐潜在空间中的特征分布.然而这种类型的方法依赖额外的语义属性注释, 需要耗费额外的人力资源.此外, Tarvainen等[5]和Chen等[6]通过生成对抗网络将标记的源域图像转换成目标域的样式以对齐特征分布.相比分布对齐方法, 基于伪标签的自适应方法更直接, 其直接利用聚类方法为无标签的目标域分配伪标签, 再利用有监督方法微调预训练的模型.Wang等[7]利用源域对网络进行初始化, 再在目标域上通过聚类方法生成伪标签后, 使用伪标签训练网络, 持续迭代指导模型收敛.Zhang等[8]提出一种渐进的方式用于逐步学习可信的伪标签, 同时利用基于排序和基于聚类的三元组损失进行学习.Zhong等[9]提出HHL(Hetero-Homoge-neous Learning Method), 分别解决域间差异和相机间差异.异质学习的目的是将目标域中未标注的图像进行对应的风格转换, 而源域(目标域)图像视为目标域(源域)的负匹配.然而, 在没有任何身份信息的情况下, 域自适应方法并不能取得良好性能也并不能解决无监督跨模态行人重识别问题.

现有的完全无监督行人重识别方法主要分成3类:传统无监督行人重识别方法、基于无监督特征学习方法和聚类生成伪标签方法.传统无监督行人重识别方法主要以手工提取特征方法[10]和字典学习[11]为主, 但在学习过程中往往会忽略语义信息, 无法达到较优性能.目前, 无监督的特征学习方法在图像检索和图像识别等方面得到学者的关注并取得一定进展.行人特征在行人重识别任务中起着至关重要的作用.贲晛烨等[12]提出利用行人步态作为特征表示和识别对象, 融合步态特征与其它生物特征, 得到多生物通道特征.Han等[13]结合传统的手工特征和聚类方法, 设计基于正则回归的新目标矩阵格式, 有效实现对未标记数据的特征选择.Yang等[14]在现有无监督特征学习的基础上提出基于块特征的学习框架, 并通过学习块级别的局部特征提高行人特征的区分性, 提升最终的识别率.

聚类生成伪标签方法是常见的解决无监督行人重识别问题的方法.此类方法首先通过样本特征相似性进行聚类生成伪标签, 然后利用这些伪标签以有监督的方式对模型进行训练.Lin等[15]提出BUC(Bottom-Up Clustering), 联合优化卷积神经网络和个体样本之间的关系, 考虑不同身份之间的多样性和同一身份内部的相似性, 在自底向上聚类过程中使用一个多样性正则化项平衡每个聚类的数据量, 实现多样性和相似性之间的有效平衡.Yu等[16]将目标域无标签任务身份表示为与一组额外带标签的行人数据之间的相似度, 即软多标签, 利用外观特征和软多标签之间的一致性进行困难负样本挖掘, 大幅提升无监督的识别效果.Wang等[7]将无监督行人重识别任务看作是一个多标签分类任务, 并使用内存库训练网络, 让标签预测和特征学习反复工作以提升性能.Li等[17]结合无监督学习与对比学习, 设计不对称的对比学习框架, 实例级和聚类级的对比学习可帮助孪生网络学习关于不同数据增强视图内外的聚类结果的判别特征.

在有监督单模态行人重识别任务中, 行人之间的姿态差异、服装变化等模态内差异是研究者需要解决的问题.Zhang等[18]指出在单模态长期行人再识别中, 存在着随时间推移的显著的服装变化.为了解决该问题, 提出包括时空流和骨架运动流的双流网络.时空流作用在图像序列上, 学习与身份相关的时空模式.骨架运动流通过自适应图卷积网络, 从骨架序列中学习纯运动模式.

然而在现有监督可见光-近红外行人重识别中, 模态差异问题是研究者关注的重点.Wu等[19]提出深度零度填充的方法, 训练一个单流网络, 使其能自动改进网络中特定于域的节点, 实现跨模态匹配.Ye等[20]通过联合优化特定模态和模态共享度量, 提出分层跨模态匹配模型, 使不同模态下的特征表达尽可能相似.在分层跨模态匹配模型基础上, Ye等[21]还提出具有双向双约束排序损失的双路径网络, 便于处理模态内和模态间的差异, 提高特征的辨识度.Hao等[22]提出端到端双流超球面流形嵌入网络, 利用Sphere Softmax学习超球面流形嵌入, 并在该超球面上对模态内和模态间变化进行约束.Zhu等[23]提出HC loss(Hetero-Center Loss), 减少类内交叉模态的变化.在交叉熵损失函数和中心损失的共同作用下, 减少类间差异和改进类内交叉模态相似性.Liu等[24]提出EDFL(Enhancing the Discrimina-tive Feature Learning), 通过跳连接的方式融合中间特征, 提高特征的识别性和鲁棒性, 同时使用双模态三元组损失优化特征融合.Lu等[25]提出cm-SSFT(Cross-Modality Shared-Specific Feature Transfer Algorithm), 在跨模态邻近吸引力模型的基础上分离模态独有信息, 有效利用每个样本的共享信息和特定信息之间的联系.Li等[26]提出XIV(X-Infrared-Visible ReID Cross-Modal Learning Framework), 利用可见光模态图像学习得到X模态图像, 将双模态问题转化为三模态问题, 利用辅助模态减少模态间差异.Ye等[27]提出HAT(Homogeneous Augmented Tri-Modal), 生成可见光图像的灰度图作为辅助模态, 缩小可见光与近红外图像之间的模态差异.

综上所述, 本文提出基于语义伪标签和双重特征存储库的无监督跨模态行人重识别方法.首先, 提出基于对比学习框架的预训练方法并结合DBSCAN(Density-Based Spatial Clustering of Applications with Noise)聚类生成语义伪标签, 有效减少模态差异.然后, 构建实例级困难特征存储库和中心级聚类特征存储库, 并提出双重特征存储库对比损失函数和存储库一致性损失.该过程充分利用实例级困难样本信息和中心级聚类信息, 提高模型的判别性和对噪声伪标签的鲁棒性.最后, 在SYSU-MM01、RegDB这两个跨模态数据集上的实验验证本文方法的有效性.

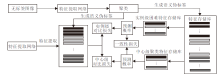

本文提出基于语义伪标签和双重特征存储库的无监督跨模态行人重识别方法, 整体框架如图1所示.首先, 通过聚类方法结合语义特征提取网络为无标签的行人图像生成语义伪标签.然后, 利用特征提取网络提取行人特征, 建立实例级困难特征存储库和中心级聚类特征存储库.最后, 利用双重特征存储库对比损失和存储库一致损失优化网络模型.

定义原始无标签行人图像数据X1=

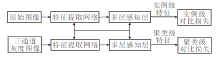

预训练语义特征提取网络首先将原始无标签图像与其对应三通道灰度图像分别输入双路网络的上下分支中, 再依次经过特征提取网络和全连接网络.此双路网络采用孪生网络结构, 上下分支共享训练参数.具体来说, 给定原始图像x1和三通道灰度图像x2, 分别输入上/下分支特征提取网络中, 上分支特征提取网络输出f1=F(x1; Θ f), 下分支特征提取网络输出f2=F(x2; Θ f).与监督学习中定义正负对样本的方式不同, 正样本对定义为来自同一图像的原始图像和其三通道灰度图像, 负样本定义为来自不同图像的原始图像与其三通道灰度图像.因此, 对于图像xi, 正向样本对为

S(

其中, i=1, 2, …, N, j=1, 2, …, N.为了最大化正向样本对的相似度和最小化负样本对的相似性, 可获取对颜色变化具有鲁棒性的高级语义特征, 在此步骤中分别使用实例级对比损失函数和聚类级对比损失函数进行训练.样本xi的实例级对比损失函数为:

其中, τ 为温度超参数, s=1, 2.在此步骤中, 所有样本都需要计算实例级对比损失函数, 因此实例级损失函数总和为:

LI=

聚类级对比损失函数与实例级对比损失函数类似, 计算过程如下:

L

最后的损失函数为Lr=LI+LC.

存储此步骤中学习的特征提取网络参数Θ 'f, 当作下一步聚类生成伪标签任务中特征提取网络的参数.具体过程如算法1所示.

算法1 基于对比学习的语义特征提取网络训练过程

输入 数据集X={xi

多层感知器参数Θ P, 温度超参数τ

输出 提取高级语义特征的特征提取网络参数Θ 'f

初始化 将特征提取网络初始化参数设置为Θ f

while epoch≤ total_epoch do

从数据集中选取样本x'i, 并生成对应三通道灰度图像

利用2个MLP层将特征矩阵f1和f2映射为I1, I2, C1, C2

利用损失函数Lr更新参数Θ f

end

在有监督行人重识别问题中, 三元组损失和身份损失是改善识别性能的有效方法.而在无监督任务当中, 由于缺少真实的身份标签, 并且伪标签在训练过程中会发生变化, 因此通常使用非参数分类损失.Xiao等[28]基于内存字典设计在线实例匹配损失, 对比查询图像与未标记身份的内存特征.Wang等[7]提出多分类损失, 在实例级别计算损失并更新存储库.现有方法并未从实例级和聚类级层面同时改善模型, 因此本文在现有无监督方法[29, 30]中使用的特征存储库的基础上, 设计实例级困难特征存储库和中心级聚类特征存储库, 充分利用实例级困难特征信息和中心级聚类特征.在这两种特征存储库的帮助下, 模型可增强噪声伪标签的鲁棒性.

在生成伪标签数据之后, 将带有伪标签的数据集D输入特征提取网络中, 得到对应的特征f=F(x; θ 'f).再利用每类的平均特征初始化实例级困难特征存储库MI∈

其中,

为了进一步区分容易混淆的样本对和更好地探索实例间的关系, 利用困难样本挖掘策略构建实例级困难特征存储库, 在实例级聚类存储库中伪标签为yi的聚类特征为:

其中, f

f

其中, f

由上述公式可知, 实例级困难特征存储库中的特征更新是基于单独的实例特征.然而, 单独实例级的特征训练并不能满足基于伪标签的无监督行人重识别任务对噪声样本鲁棒性的要求.因此, 本文还设计中心级聚类特征存储库, 利用聚类平均计算聚类中心特征以更新存储库, 从而减少噪声样本的干扰.

与实例级困难特征存储库一样, 中心级聚类特征存储库也是根据每个聚类的平均特征进行初始化.中心级聚类特征存储库中伪标签yi的聚类特征为:

两种特征存储库的不同之处是它们的更新方式.具体来说, 对于中心级聚类特征存储库的更新, 首先需要计算同类样本的平均特征作为聚类中心特征, 然后利用获取的聚类中心特征对中心级聚类特征存储库进行更新, 过程如下:

其中, mi为批次当中伪标签为yi的所有样本对应的中心聚类特征值,

mi=

特征存储库可被看作为一个用于分类任务的无参数分类器.为了提高分类效果, 提出实例级困难特征存储库对比损失函数

Lhfm=-log2

用于训练模型, 其中, y为行人特征f对应的伪标签, τ 为温度超参数.由上式可得, 当行人特征f与其对应伪标签表示的存储库特征相似度更高, 而与存储库中其它特征相似度更低时, 实例级困难特征存储库对比损失值Lhfm更低.

为了训练中心级聚类特征存储库, 本文提出与实例级对比损失有相同功能的中心级聚类特征存储库对比损失:

Lcfm=-log2

中心级聚类特征存储库对比损失与实例级困难特征存储库对比损失的区别在于训练的特征类型不同, 该损失优化的是中心级聚类特征.在这两种对比损失的帮助下, 实例级困难特征存储库和中心级聚类特征存储库的分类效果得到提高.

在训练过程中, 使用的特征存储库MI和MC都会输出各自的预测概率PI和PC.为了促进特征表示学习和提高预测概率的准确性, 两种特征存储库的输出概率应具有一致性, 因此提出特征存储库一致损失:

LC=H(PI, PC),

其中H(· )表示smooth L1 损失函数.

综上所述, 最后的总损失函数为:

Lall=Lhfm+(2-μ )Lccm+λ Lc,

其中, μ 表示设置两种聚类对比损失之间的权重关系, λ 表示平衡两种聚类对比损失和聚类一致性损失的系数参数.

为了评估本文方法, 在两个公开跨模态数据集SYSU-MM01[19]和RegDB[31]上进行实验.本文使用如下评价指标:平均精度均值(Mean Average Pre-cision, mAP)和rank-n, n=1, 10, 20, 其中, n表示搜索结果中最靠前(置信度最高)的n幅图有正确结果的概率.

SYSU-MM01数据集是大尺度的跨模态行人重识别数据集.行人图像由4个传统可见光相机和2个近红外相机拍摄所得, 包含491个行人身份, 287 628幅可见光图像和15 792幅近红外图像.具体来说, 使用395幅行人身份的图像用于训练, 96幅行人身份的图像用于测试.本文在SYSU-MM01数据集上的实验采用单幅图像命中全搜索(Single-Shot All-Search)的评估模式, 并且为了实验的准确性, 在测试阶段采用10次随机实验的平均结果作为实验结果.

RegDB数据集是由包含一个可见光摄像头和一个热成像摄像头的双摄像头系统收集的小尺度数据集, 包含412个行人身份, 每个身份有10幅可见光图像和10幅热成像图像.遵循文献[20]和文献[22]中的跨模态行人重识别评估准则, 随机选择206幅行人身份图像进行训练, 剩下的206幅身份图像用于测试.在RegDB数据集上进行的实验可根据query和gallery中行人图像类型分成visible to ther-mal和thermal to visible.具体来说, 当query库中包含2 060幅可见光行人图像, gallery库中包含2 060幅热红外图像, 此时为visible to thermal 模式.与在SYSU-MM01数据集上进行的实验一样, 在RegDB数据集上的结果也是10次随机实验的平均结果.

在预训练语义特征提取网络中, 采用在Image-Net上预训练的ResNet-50作为主体框架, 输入的原始图像都是从SYSU-MM01数据集上挑选的可见光图像, 对比损失函数中的温度系数τ =0.3.与文献[32]一致, 本文使用GEM(Generalized Mean Poo-ling)方式, 然后添加批归一化层和L2归一化层.在训练期间, 批大小设置为80, 优化器使用Adam(Adaptive Moment Estimation), 其中衰减参数设置为0.000 5, 初始学习率设置为0.000 35, 经过50轮训练后, 学习率变为原有的1/10.双重存储库损失函数中温度系数设置为0.05.所有的输入图像大小调整成288× 144.代码实现使用pytorch框架, 总共训练50轮.整个训练使用GTX3090显卡加速.

在SYSU-MM01、RegDB数据集上进行对比实验, 本文方法的超参数动量值ω 设置为0.1, 损失函数中的系数λ 设置为0.5.

本文选择如下2类对比方法.1)无监督方法:HHL[9]、LOMO+XQDA(Local Maximal Occurrence and Cross-View Quadratic Discriminant Analy-sis)[10]、ELF(Ensemble of Localized Features)[33]、文献[34]方法、GOG(Gaussian of Gaussian)[35]、文献[36]方法、CycleGAN[37]、SSG(Self-Similarity Grouping)[38]、ECN(Exemplar-Invariance, Came-rainvariance and Neighborhood-Invariance)[39]、CCL(Cluster Contrast Learning)[40]、ABMT(Asymme-tric Branched Mean Teaching)[41].2)有监督跨模态行人重识别方法:Zero-Padding[19]、TONE(Two-Stream CNN Network)[20]、HCML(Hierarchical Cross-Modality Metric Learning)[20]、BDTR(Bi-directional Dual-Constrained Top-Ranking Loss)[21]、HC loss[23]、EDFL[24]、cm-SSFT[25]、XIV[26]、HAT[27]、SSCDL(Semi-Supervised Coupled Dictionary Learning)[42]、cmGAN(Cross-Modality Generative Adversarial Net-work)[43]、D2RL(Dual-Level Discrepancy Reduction Learning)[44]、MAC(Modality-Aware Collaborative)[45]、Hi-CMD(Hierarchical Cross-Modality Disentangle-ment)[46].其中CCU、ABMT和ECN是现有较先进的单模态行人重识别方法.

各方法的对比结果如表1和表2所示, 各对比方法实验数据取自原文献.

| 表1 各无监督方法在2个数据集上的实验结果对比 Table 1 Experimental result comparison of different unsupervised methods on 2 datasets % |

| 表2 各监督方法在2个数据集上的实验结果对比 Table 2 Experimental result comparison of different supervised methods on 2 datasets % |

由表1可看出, 本文方法性能最优.在SYSU-MM01数据集上, 相比无监督方法中表现最好的CCU, 本文方法在rank-1和mAP指标上提升13.1%和9.9%.而在RegDB数据集上, 相比在该数据集表现最好的CCU, 本文方法在rank-1和mAP指标上分别提升6.0%和2.9%.现有的无监督方法并未考虑跨模态数据之间的模态差异, 而本文方法则在聚类生成伪标签的过程中, 利用对比学习, 降低不同模态数据颜色信息的影响, 更关注没有模态的高级语义特征, 从而减少跨模态数据之间的模态差异.

由表2可看出, 本文方法性能与最好的有监督方法有一定差距, 但在不使用跨模态标签的条件下, 本文方法已超过部分有监督方法.相比有监督方法, 本文方法更具有真实场景的泛化性, 可节省人为注释标签的时间资源和人力资源.

本节在SYSU-MM01数据集上进行消融实验, 验证本文方法中各主要部分的有效性.各模块分别为语义伪标签生成模块(Semantic Pseudo-Labe-ling, spl), 实例级困难特征内存库(Hard Feature Memory Bank, hfm), 中心级聚类特征内存库(Clus-ter Feature Memory, cfm), 内存一致性损失(Me-mory Consistency Loss, mcl).

各模块的消融实验结果如表3所示.由表可见, 相比Baseline, 增加语义伪标签生成模块spl之后性能得到明显改善, 在rank-1和mAP指标上分别提升5.8%和5.4%.这主要是因为相比现有的伪标签生成方法, 语义伪标签在生成过程中充分利用跨模态数据中的语义特征, 减少造成模态差异的颜色信息的干扰, 有效减少模态差异.

| 表3 各模块在SYSU-MM01数据集上的消融实验结果对比 Table 3 Result comparison of ablation experiment of different modules on SYSU-MM01 dataset % |

从表3中还可看出, 实例级困难特征存储库hfm和中心级聚类特征存储库cfm都可提升性能.单独添加cfm分别让rank-1和mAP指标提升2.9%和3.5%, 而单独添加hfm可让rank-1和mAP指标提升4.3%和4.9%.因此, 相比cfm, hfm对性能提升的作用更大.不过在结合hfm和cfm之后, 性能可得到进一步提升, rank-1和mAP指标分别提升6.7%和7.7%.

存储库一致性损失mcl是用来保持两种不同类型特征存储库输出结果的一致性.由表可得, mcl可让性能进一步的提升, rank-1和mAP指标分别提升1.1%和1.3%.

为了更新两种不同类型的存储库和保持内存储库输出的一致性, 本文设置4个超参数:存储库更新动量值ω , 存储库一致性损失系数λ , 聚类对比损失权重参数μ 和温度系数τ .本节在SYSU-MM01数据集上进行实验, 验证这些超参数的不同取值对实验结果的影响.

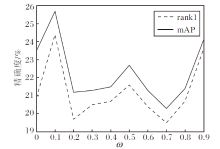

与现有的对比学习方式相似, 基于动量值的更新策略也被应用于实例级特征存储库和中心级特征存储库中.本文实例级困难特征存储库和中心级聚类特征存储库使用相同的动量值, 因此动量的取值就显得十分重要.如图3所示, 在动量值的递增过程中, 精确度也会有所起伏, 而在动量值ω =0.1时, 性能最优.所以在本文实验中, 本文将ω 设置为0.1.

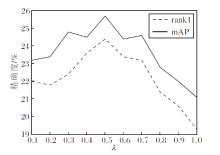

一致性损失的作用是用来限制两种不同类型存储库产生给定图像预测概率的一致性.λ 是用于平衡一致性损失影响的超参数, λ 对精确度的影响如图4所示.由图可观察到, λ 的取值过高或过低都无法取得较优结果, 而当λ =0.5时, 本文方法能取得最优性能.

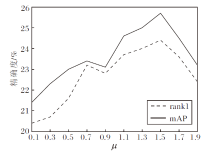

文中不同的μ 表示聚类对比损失的不同权重关系, μ 对精确度的影响如图5所示.由图可观察到, μ 从0.1升至1.5时, 性能大致呈现上升趋势, 在μ 从1.5升至1.9时, 性能逐渐下降.在μ =1.5时, 性能最优.由上述结果可得, 实例级困难特征库损失Lhfm对精确度的影响大于中心级聚类特征库损失Lccm.

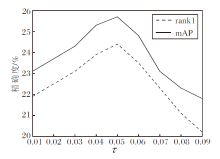

本文使用温度系数τ 调节对比损失函数对困难样本的关注程度, τ 对精确度的影响如图6所示.由图可观察到, τ 从0.1升至0.5时, 性能随τ 的增加而上升, 在τ =0.5时, 性能达到最优.在τ > 0.5后, 性能随τ 的增加而下降.这表明小温度系数更关注与本样本相似的困难样本, 可更好地获得辨识度高的特征.然而随着温度系数的减少, 对比损失只会关注最困难的负样本, 过分强迫与困难样本分开, 无法学到潜在的语义特征, 导致模型泛化能力较差.

本文提出基于语义伪标签和双重特征存储库的无监督跨模态行人重识别方法.首先, 利用可见光行人图像与其灰度图像, 提出基于对比学习框架的网络预训练方法, 可训练对颜色变化具有鲁棒性的语义特征提取网络, 有效减少模态差异.然后, 利用该语义特征提取网络结合聚类方法, 生成语义伪标签.同时, 本文还构建实例级困难样本特征存储库和中心级聚类特征存储库, 并且在训练过程中利用双重特征存储库损失函数和存储库一致性优化模型, 达到提高对噪声样本的鲁棒性和模型的辨识度的目的.在SYSU-MM01、RegDB这两个跨模态数据集上的实验表明, 本文方法可有效解决无监督跨模态行人重识别问题, 性能已超过现有常见的无监督方法和部分有监督方法.然而, 本文方法与现有先进的有监督方法还有一定差距, 所以在今后的研究中, 应考虑如何进一步在无监督模型中减少跨模态数据的差异并提高伪标签的质量, 从而提高整个模型的性能.

本文责任编委 叶东毅

Recommended by Associate Editor YE Dongyi

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|

| [43] |

|

| [44] |

|

| [45] |

|

| [46] |

|