尚晓可,博士,讲师,主要研究方向为认知神经科学、人工智能.E-mail:sxk-1212@zju.edu.cn.

作者简介:

安 南,硕士研究生,主要研究方向为计算机视觉.E-mail:NanAn0527@hotmail.com.

尚敬捷,硕士研究生,主要研究方向为图像处理、脉冲神经网络应用、神经网络压缩与部署.E-mail:ishawnshang@foxmail.com.

张韶岷,博士,教授,主要研究方向为生物信号处理.E-mail:shaomin@zju.edu.cn.

丁 鼐,博士,教授,主要研究方向为认知神经科学、认知计算、人工智能.E-mail:ding_nai@zju.edu.cn.

低光照图像增强是解决低光照环境下各种视觉分析任务的基础和核心步骤,但现有主流方法由于普遍未能对结构信息进行有效刻画,往往存在曝光不均衡、颜色失真等问题.针对上述问题,文中提出结合视觉显著性与注意力机制的低光照图像增强方法.首先,构建基于注意力机制的低光照图像增强网络,在引入注意力机制的同时考虑局部细节和全局信息,正确刻画增强结果中的颜色信息.再遵循由粗到细的逐步优化理念,设计渐进式注意力机制,将增强过程分阶段细化,实现精细化建设.然后,引入显著性引导的特征融合,增强网络对图像中显著性目标的感知能力,从更符合视觉认知需求的角度提升对于结构信息的表达,有效避免产生噪声/伪影等问题.实验表明,文中方法有效解决现有工作存在的曝光不足与颜色失真等问题,性能较优.

SHANG Xiaoke, Ph.D., lecturer. Her research interests include cognitive neuroscience and artificial intelligence.

About Author:

AN Nan, master student. His research interests include computer vision.

SHANG Jingjie, master student. His research interests include image processing, spiking neural network application and neural network compression and deployment.

ZHANG Shaomin, Ph.D., professor. His research interests include biological signal processing.

DING Nai, Ph.D., professor. His research interests include cognitive neuroscience, cognitive computing and artificial intelligence.

Low-light image enhancement is the foundation and core step for solving various visual analysis tasks in low-light environments. However, the existing mainstream methods generally fail to characterize structural information effectively, resulting in some problems, such as unbalanced exposure and color distortion. Therefore, a low-light image enhancement network combining visual saliency and attention mechanism is proposed in this paper. A low-light image enhancement framework based on attention mechanism is firstly constructed by introducing attention mechanism with consideration of both local details and global information to characterize the color information in the enhancement results correctly. To achieve refined construction, a progressive process is designed to refine the enhancement process in stages following the concept of gradual optimization from coarse to fine. The feature fusion module guided by visual saliency is introduced to enhance the ability of the network to perceive salient objects in images and improve the expression of structural information from a perspective of being more in line with visual cognitive needs. Thus, noise/artifacts and other problems are avoided effectively. Experimentsshow that the proposed method solves the problems of unbalanced exposure and color distortion effectively with superior performance.

本文责任编委 黄 华

Recommended by Associate Editor HUANG Hua

在图像获取过程中, 时常存在多种不理想的光照条件, 造成曝光不足, 而此类图像中包含的信息往往视觉不可见, 严重限制诸多高层视觉任务(如目标检测[1]、视觉跟踪[2])的性能, 因此学者们开始设计有效的低光照图像增强算法.根据算法设计思路的不同, 现有方法可粗略分为基于模型的传统方法和基于数据的深度网络方法.基于模型的传统方法以建立正则项约束的优化模型为核心, 构造迭代算法为目标.基于数据的深度网络方法的关键在于启发式地设计网络结构, 以海量的数据训练端到端的网络模型.

基于模型的传统方法以Retinex模型[3]为核心, 初始通用策略是基于Retinex模型, 利用高斯滤波器实现低光照图像增强.Jobson等[4]提出SSR(Single-Scale Retinex), 在对数域对低光照输入进行高斯滤波以产生光照, 进行减法运算, 得到增强结果.Rahman等[5]在SSR的基础上, 引入多尺度信息, 进一步构造MSR(Multi-scale Retinex), 在多个尺度上多次执行高斯滤波, 产生多个光照, 再对基于SSR的增强结果进行加权求和, 得到最终输出.Jobson等[6]提出MSRCR(MSR with Color Restoration), 引入权重, 进行颜色的校正, 实现更优的增强效果.Guo等[7]直接利用图像平滑模型估计光照, 并基于Retinex模型得到增强结果, 虽然显著提升亮度, 但在多数情况下会出现过曝现象.Zhang等[8]提出增加额外的正则项约束, 辅助估计更好的光照信息, 进一步避免过曝现象的产生, 然而由于多种正则项的引入, 测试代价明显变高.Li等[9]同时优化光照与反射, 在增强亮度的同时克服一些显著的噪声, 但受限于正则项的表征能力, 仅能使用在一些简单情形中.总之, 现有的基于传统方法的低光照图像增强技术普遍依赖于正则项的设计与求解算法的构造, 往往存在大量需要人工设定的参数, 在面对不同的低光照场景时, 需要消耗大量资源与时间以获取最佳的增强效果.

近年来, 得益于数据的井喷式增长, 深度学习技术取得蓬勃发展, 一系列行之有效的深度网络架构随之产生.然而, 区别于深度学习在常规图像处理问题(如图像去噪, 图像超分辨率)的发展进程, 基于深度学习的低光照图像增强技术发展相对缓慢, 其原因在于数据的合成及获取尚存许多困难.直至近期, 一些数据集的提出逐渐推动该领域的发展.Chen等[10]提出RetinexNet, 结合Retinex模型与深度学习, 设计一个简单的网络, 用于估计光照, 结合Retinex理论得到增强结果, 但是RetinexNet对于光照的刻画能力不足, 导致结果出现颜色失真等问题.Chen等[10]还提出一个成对的低光照图像数据集(LOL), 也成为低光照图像增强领域的重要数据集.

在RetinexNet之后, 学者们提出大量利用Re-tinex模型建立的有监督网络, 实现低光照图像增强的方法和手段.Wang等[11]提出DeepUPE(Deep Underexposed Photo Enhancement), 构建光照估计网络, 并设计基于光照先验约束的损失函数, 再基于Retinex理论对图像进行增强.在MIT-Adobe FiveK数据集[12]上训练DeepUPE, 并使用与MIT-Adobe FiveK数据集相同的生成方式提供新的数据集, 但方法也存在对亮度场景的刻画能力不足的问题.Lü 等[13]提出MBLLEN(Multi-branch Low-Light Enhance-ment Network), 也是类似的监督学习方法, 在不同层次上使用多个分支网络同时增强图像特征, 最后融合多分支输出结果, 形成最终的增强图像.Lü 等[13]也从损失函数上进行改进, 提出多损失加权的方案.MBLLEN的多分支结构使细节出现问题, 同时引入一些噪声, 在结构刻画方面存在明显不足.

通常而言, 依赖成对数据训练的有监督网络往往在给定与训练数据分布相同的数据集上具备较优性能, 然而由于成对数据的获取仍需要人工操作, 往往缺乏较强的适用性.为了解决此问题, 学者们提出一系列基于半监督或无监督的方法.Jiang等[14]提出EnlightenGAN(Deep Light Enhancement with Paired Supervision), 从图像分布的角度考虑低光照图像增强问题, 并引入生成对抗机制.EnlightenGAN基于U-Net结构建立生成器, 并进一步设计全局-局部判别器, 可基于非成对的数据进行训练, 一定程度上提升算法的适用性.类似地, Yang等[15]提出不完全依赖成对数据的半监督方法— — DRBN(Deep Re-cursive Band Network).但是由于缺乏有效的物理规律的建模, DRBN和EnlightenGAN都引入明显伪影, 造成视觉效果退化.最近, 一些研究人员尝试挖掘深度网络强大的刻画表征能力, 力求构建低光照图像与正常光照图像之间全新的显式映射关系.Guo等[16]提出Zero-DCE(Zero-Reference Deep Curve Estimation), 将亮度增强作为一种利用深度网络进行图像特定曲线估计的任务.Zero-DCE训练一个轻量级的深度网络, 用于估计像素和高阶曲线的动态范围, 调整给定图像, 具有较高的推理效率, 但会产生较明显的颜色失真.

随着注意力机制在计算机视觉领域的逐渐兴起, 学者们尝试构建具有注意力机制的低光照增强网络框架[17, 18].Zhang等[17]提出基于注意力的神经网络, 可从原始传感器数据中生成高质量的增强后低光照图像, 引入空间注意力模块和通道注意力模块, 抑制色差偏误和噪音产生.Lü 等[18]提出针对大规模合成低光照数据集的注意力引导的端到端多分支卷积神经网络, 学习两个注意力图, 分别指导亮度增强和去噪任务, 并根据输入自适应地工作.

显著目标检测旨在将显著物体与周围环境分离, 以抵抗背景、光照等变化引起的干扰.Hao等[19]为了解决现有算法由于缺少高级视觉信息导致存在过度增强、噪声被放大等问题, 提出基于Retinex理论和显著性理论的低光照图像增强框架, 融合显著性图和增强图像, 增强整个图像.为了进一步解决低光照图像模态中严重的对象信息丢失导致难以对显著目标检测的问题, Xu等[20]提出直接将物理光照模型嵌入深度神经网络中, 用于描述低光照图像的退化, 并利用非局部块层捕获对象的局部内容与其局部邻域偏好区域的差异, 促进低光照图像中的显著目标检测.

网络结构设计方面, 学者们指出, 遵循由粗糙到细致分阶段对图像进行增强是可行、有效的.Xu等[21]发现噪声在不同频率层中表现出不同水平的对比度, 基于在低频层比在高频层更容易检测到噪声的特点, 提出基于频率的渐进式分解和增强模型, 有效提升去噪和增强效果.

总之, 现有低光照图像增强方法由于未能对结构信息进行正确刻画, 并且缺乏视觉认知信息, 导致普遍存在颜色失真和伪影噪声等问题.为了解决上述问题, 本文提出结合视觉显著性和注意力机制的低光照图像增强方法.首先, 提出基于注意力的渐进式低光照图像增强网络, 作为本文方法的主干部分, 突破Retinex模型求解过程中的局限性.然后, 提出渐进式注意力机制, 同时引入通道注意力机制和空间注意力机制:空间注意力机制能高效感知图像不同区域的明暗特征, 同时考虑局部细节和全局信息; 通道注意力机制可针对图像的不同通道进行调整, 在正确刻画增强结果中颜色信息的同时, 使增强结果获得更均衡的光照.同时遵循由粗到精的建模理念, 提出渐进式注意力机制, 分阶段细化增强过程, 随后引入残差结构, 显著降低注意力学习的复杂度.在注意力网络中加入图像显著性特征作为引导, 增强网络对图像中显著性目标的感知, 提升结构信息刻画能力, 使方法在避免伪影等噪声和避免颜色失真等方面获得增益.对比实验验证本文方法的优越性与有效性.

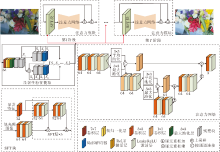

受近年来在计算机领域逐渐成为热点的注意力机制的启发, 本文提出结合视觉显著性与注意力机制的低光照图像增强方法, 具体流程如图1所示.首先, 引入注意力机制, 构建低光照增强网络, 将注意力网络生成的注意力图与原图逐像素相乘, 增强图像, 敏锐感知图像各处的曝光程度, 避免增强后带来的曝光不均衡问题.另外, 采用从粗糙到精细的渐进式优化理念进一步改进网络, 逐步提升增强性能.

在视觉显著性引导的特征融合部分, 利用一个预训练的显著性目标检测网络, 提取低光照图像的显著性特征.这些显著性特征以空间特征变换的方式与低光照图像的特征高度融合后进入注意力估计阶段.显著性检测大多将研究重心放在人眼注意点的检测上, 即检测图像中最吸引人类眼光的地方(如高亮度区域、高饱和度区域等), 检测结果为一组光亮点组成的感兴趣区域[22], 因此视觉显著性包含丰富的场景结构信息.为了提升本文方法对结构信息的刻画, 增添显著性特征作为补充信息输入.利用显著性引导注意力训练, 使网络训练进程加快、网络更稳健, 并且让注意力映射更关注图像中的主要物体, 同时也能更好地避免增强过程中物体周围出现伪影及处理后物体颜色偏向背景颜色而导致的颜色失真.

输入一幅RGB三通道的低光照图像, 记为y, 期望得到的光照正常图像记为x, 低光照输入对应的正常光照参考标准图像(Ground Truth)记为xgt.对y进行注意力估计以评估全局明暗差异.为了逐步优化结果, 引入渐进式的优化思想, 形成渐进式低光照图像增强网络.具体地, 假设注意力为α , 建模如下:

xt=α t-1☉xt-1+xt-1, t=1, 2, …, T, (1)

其中, ☉表示逐像素相乘, x表示光照正常的图像, t表示第t阶段, T表示总阶段数, 初始化x0=y.在基于Retinex理论的建模中, 常用低光照图像除以光照, 得到正常光照图像, 但是受制于像素阈值影响, 这种除法关系并不稳定.受Retinex物理模型的启发, 基于乘法关系建模注意力, 建立的注意力网络能输出包含图像中不同明暗区域注意力的注意力图.注意力具体表现为权重数值, 在低光照图像增强任务中, 对于图像中较暗区域的注意力较大, 将包含权重数值的注意力图像与输入低光照图像相乘即可达到增强效果, 有效规避Retinex模型的缺点.在此基础上, 进一步引入残差结构, 降低注意力学习的复杂度, 提升模型收敛效率.利用卷积神经网络实现由输入特征到注意力的映射, 该映射函数记为A, 即注意力网络.

注意力网络A的结构如下.首先, 将特征输入通过两个卷积层, 提取所需特征.在注意力的刻画上, 采用金字塔型编码器-解码器结构.具体地, 采用平均池化和最大池化两种池化层, 从不同角度获取综合信息, 并且三层金字塔结构中上/下采样的操作能使注意力网络感知包含高中低3个尺度的信息.在此基础上, 为了补偿在最小卷积层后的上采样时造成的特征损失, 在对应的层级上使用2个跳跃连接.每个生成的注意力权重图都有3个通道, 取值范围为[0, 1].注意力图的可视化结果如图2所示.最后, 网络生成的注意力图按式(1)的建模方式增强图像.注意力图框架总体可表示为:

其中, t=1, 2, …, T, 表示第t阶段, T表示总阶段数, 初始化x0=y.在该网络下, 低光照图像可实现从粗到细地逐步增强.

为了提升本文方法对结构信息的利用, 并使增强结果避免出现伪影噪声、颜色失真等问题, 在注意力网络前引入显著性信息, 作为注意力网络的引导.在本阶段中, 引用CPD(Cascaded Partial Decoder)[23], 选择网络前馈过程中的部分特征层面的中间结果作为本文提取的显著性特征, 用于引导注意力网络的训练.此特征提取过程可表示为:

[S1, S2, …, Sn]=S(x), n=1, 2, …, 8,

其中, S表示预训练参数固定的显著性目标检测网络, [S1, S2, …, Sn]表示提取的显著性特征序列.显著性特征数量n与注意力网络的阶段数量相同, 最多为8, 即CPD网络中使用跳跃连接到局部解码器.

对于低光照输入y, 本文希望与显著性特征融合, 共同作为注意力网络的输入.受Wang等[24]的启发, 使用空间特征变换的方式高度融合两种特征, 代替传统的在通道数上的连接.在空间特征变换中, 低光照图像首先输入4个卷积层中, 每个卷积运算后由ReLU函数进行激活, 最终得到64通道的低光照图像特征.同时前期提取的显著性特征也输入一个卷积层, 变换为32通道的特征, 达到维度匹配.然后, 将这些经过处理的低光照特征和显著性特征输入空间特征变换层, 进一步促进特征融合.

空间特征变换层学习由基础特征和先验特征到融合特征的映射.从先验特征Φ 学习一组变换配置参数(γ , β ).基于这组变换配置参数, 空间特征变换层可根据不同的先验特征和基础特征适应性地进行仿射变换融合.具体来说, 定义Γ 为映射函数, 可得到关系

Γ ∶ Φ |→ (γ , β ),

表示为

(γ , β )=Γ (Φ ).

获得变换配置参数(γ , β )后, 定义变换过程, 由基础特征结合先验特征进行变换, 得到变换后的融合特征, 变换过程可表示为

F=γ ☉P+β ,

其中, F表示变换后得到的融合特征, P表示基础特征, ☉表示逐像素相乘, F、P、γ 、 β 的通道数与尺寸均相同.

在本文方法中, 低光照输入特征作为基础特征, 由预训练网络提取的显著性特征作为先验特征, 执行空间特征变换, 得到融合特征.为了更深度的融合, 将5个空间特征变换层作为一个集合, 形成一个空间特征变换块.在每层注意力网络前设置一个空间特征变换块.另外, 对于挑选的显著性特征[S1, S2, …, Sn], 每个都会参与到不同的空间特征变换块中, 实验中n=2.

为了降低训练复杂度, 只采用基础的均方误差损失(Mean-Square Error loss, MSE loss)作为训练本文方法的损失函数, 函数方程可表示为

LMSE=

其中, xt表示第t阶段获得的增强图像, xgt表示参考标准图像.除去显著性检测模块的网络参数是预训练并且固定的.基于该损失函数在整体上训练本文方法.

本文选择的训练数据集来自带有参考图像的公开数据集MIT-Adobe FiveK[12].数据集包含5 000幅使用单反相机拍摄的真实场景中的低光照图像.图像涵盖广泛的场景、主题和照明条件.在此基础上, 数据收集组邀请5名专家调整图像的光照与色彩, 达到他们认为的光照程度使人愉悦的图像.本文选取500幅曝光程度相仿的低光照图像和校正后的对应图像作为训练集.此外, 在剩余图像中随机挑选110幅图像作为测试集.

为了训练本文方法, 在输入到网络前, 训练图像调整为320× 320的方形图像, 批尺寸设置为4.本文采用Adam(Adaptive Moment Estimation)作为优化器, 初始学习率为0.002, 优化参数β 1=0.9, β 2=0.999.共训练200个周期, 采用学习率衰减策略, 更好地适应训练进程.具体来说, 在100个周期后, 学习率会线性降至0.

整个训练过程在PyTorch框架上实现, 并在一台带有NVIDIA TITAN XP、32 GB 内存和Intel Core i7-8750 CPU的Linux服务器上进行训练.

对于图像质量的评价, 研究人员提出从不同角度评价图像质量的指标.然而, 由于每个指标的侧重点不同, 不是所有指标都能有效评估低光照图像的增强性能.为了全面评估方法性能, 本文选择峰值信噪比(Peak Signal to Noise Ratio, PSNR)、结构相似性(Structural Similarity, SSIM)、自然图像无参考评价器(Natural Image Quality Evaluator, NIQE)作为评价指标.PSNR是基于参考图像评价的标准, 用于表示增强后图像的峰值功率和噪声功率的比值, 可评估增强图像的畸变程度.SSIM是在结构的角度上对比增强结果和参考图像, 补充PSNR忽视的结构特性.NIQE无需参考图像, 从图像中提取一些特征, 并采用多变量高斯模型进行描述, 评价过程中利用待评价图像特征模型参数与预先建立的模型参数之间的距离确定图像质量.所以NIQE值越小, 表明模型参数差距越小, 图像的质量越高.

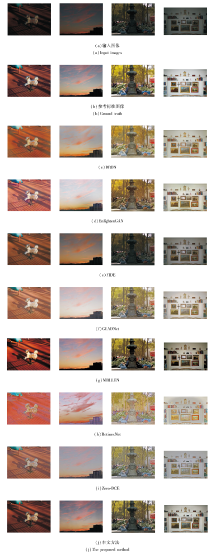

本文选择低光照图像增强领域内7种具有代表性的方法进行定量评估和定性分析, 分别为:Reti-nexNet[10]、MBLLEN[13]、EnlightenGAN[14]、DRBN[15]、Zero-DCE[16]、FIDE(Frequency-Based Image Decompo-sition-and-Enhancement)[21]、GLADNet(Global Illumi-nation Aware and Detail-Preserving Network)[24].

各方法部分视觉效果对比如图3所示.由图可知, 从整体的视觉满意度和增强结果与参考标准图像之间的贴合程度上看, 本文方法都明显优于其它对比方法.具体来说, DRBN、EnlightenGAN、GLADNet都存在一定程度的过曝现象, 引起一定程度的视觉不悦.FIDE的增强结果可明显看出增强力度不足, 增强后的图像仍处于曝光不足的状态, 甚至在个例中几乎看不出增强效果.Zero-DCE与MBLLEN虽然达到适宜的曝光程度, 但在色彩方面存在一定程度的失真, 如画面偏白或色彩过饱和.RetinexNet在画面整体刻画上失真, 使图像内容存在色彩和结构的偏差.相比之下, 本文方法既达到更适宜的曝光程度, 也未产生颜色失真等问题, 取得较令人满意的增强效果, 尤其是在平衡曝光程度和突出色彩生动方面.引入显著性引导的优势使本文方法增强结果几乎不存在伪影或振铃效应等处理过程中引入的噪声.相比参考标准图像可看出, 本文方法在曝光程度和色彩分布等方面都明显更贴合标准图像, 也呈现更自然的图像纹理和适宜的视觉效果, 这也说明采用由粗到细的渐进式低光照图像增强网络和引入显著性特征对得到色彩更生动的增强结果是有效的.

| 图3 各方法在MIT-Adobe FiveK数据集上的视觉效果对比Fig.3 Visualization result comparison of different methods on MIT-Adobe FiveK dataset |

在视觉效果对比分析之外, 还对比各方法的PSNR、SSIM、NIQE指标值, 具体结果如表1所示.由表可知, 在测试集上, 本文方法的PSNR值和SSIM值最高, NIQE值最低.由此, 从定性和定量角度上看, 本文方法均取得较令人满意的结果, 这同时也说明本文方法的优越性.

| 表1 各方法在MIT-Adobe FiveK数据集上的指标值对比 Table 1 Index value comparison of different methods on MIT-Adobe FiveK dataset |

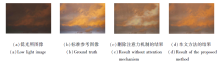

本节分析显著性引导和注意力机制对实验结果的影响, 说明在本文方法中引入显著性引导模块和注意力网络的必要性.首先, 删除本文方法中的显著性引导部分, 并与本文方法的结果在视觉和指标上进行对比评估, 验证显著性引导的有效性.

是否删除显著性引导的视觉效果对比如图4所示.由图可见, 删除显著性引导后带来明显的效果退化.从图中标注的红框及对应放大区域可更明显地看出, 当删除显著性引导后, 对图像的结构信息感知变弱的同时也降低对低光照场景下全局信息和局部细节的敏感性, 导致部分区域色彩饱和度不足, 并引入伪影噪声.相比之下, 本文方法的视觉效果色彩更生动, 也能有效解决伪影噪声等问题.

下面进行针对通道注意力机制的消融实验在本文方法中删除通道注意力机制, 并与本文方法在视觉和指标值上进行对比, 验证注意力机制的有效性.是否删除注意力机制的视觉效果对比如图5所示.由图可看出, 删除注意力机制后, 增强结果对颜色的刻画出现明显的偏差, 相比之下, 本文方法的增强结果对颜色的校正更正确和自然.这说明引入注意力机制可使方法具备正确刻画颜色及增强低光照图像的能力.

是否删除显著性引导和注意力机制后得到的3个指标值对比如表2所示.由表可看出, 引入显著性引导在3个指标上都有明显的积极影响.引入注意力机制后, 3个指标值也都有明显上升.

| 表2 不同模块对方法性能的影响 Table 2 Influence of different modules on method performance |

本文根据选择数据集的特点与实际需求, 设置两阶段注意力结构.为了分析阶段数量对实验结果的影响, 提供单阶段注意力结构和三阶段注意力结构的增强效果, 如图6所示.由图可见, 在MIT-Adobe FiveK数据集上, 单阶段注意力存在明显的曝光不足, 而三阶段注意力也并不能在视觉效果上带来更多增益, 只造成参数的冗余, 这说明在MIT-Adobe FiveK数据集上, 两阶段注意力已达到令人满意的效果, 故在实际实验中将阶段数量设置为2.同时也看出, 从单阶段到两阶段再到三阶段, 增强结果的曝光程度变得更均衡, 每一阶段都能对前一阶段的增强结果进行优化.三阶段注意力可提升性能的实情也表明, 本文方法可根据低光照数据的难易程度灵活调整阶段数量及对应显著性特征的数量, 达到更好的增强效果.

采用不同阶段数量的注意力网络的指标值对比如表3所示, 表中黑体数字表示最优值.由表可看出, 相比两阶段注意力, 单阶段注意力的指标值变小, 但三阶段注意力的指标值仅获得几乎可忽略不计的微弱提升.本文方法仅选用2个显著性特征作为后续补充输入, 未使用CPD剩余的网络结构.本文之所以未在图1中将未用到的部分删除是因为在不同的任务需求下需要的显著性特征数量也是不同的.对于其它曝光程度与MIT-Adobe FiveK数据集不同的或是其它类型的图像处理问题, 本文方法可根据低光照数据的光照条件困难程度或遵循任务需求应用更多阶段或更少阶段的注意力结构, 即使用不同数量的显著性特征作为后续引导.

| 表3 阶段数量不同时的指标值对比 Table 3 Index value comparison of different numbers of stages |

本文提出结合视觉显著性与注意力机制的低光照图像增强方法.首先构建基于注意力的渐进式低光照图像增强网络, 作为本文方法的主干架构, 实现对亮度场景的精确刻画及从粗糙到精细的逐步增强, 使增强结果的曝光程度更均衡.再在注意力网络中引入视觉显著性信息, 将显著性特征作为补充信息输入, 丰富空间结构信息, 充分利用低光照场景中的全局信息和局部细节, 使增强结果色彩更生动, 有效减少可能产生伪影噪声的问题.对比实验表明本文方法的优越性和有效性.

今后将考虑进一步探究如何更好地面向特定任务, 有效引入注意力机制和显著性引导以设计网络, 如图像去雨、图像去雾等.也尝试构建面向硬件结构的低延迟高效算法, 更好地贴近工业级的实际应用需求.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|