程 翔,博士,教授,主要研究方向为基于数据驱动的智慧网络和网联智能.E-mail:xiangcheng@pku.edu.cn.

作者简介:

张浩天,博士研究生,主要研究方向为多模态感知辅助的通信系统传输方案设计.E-mail:haotianzhang@stu.pku.edu.cn.

李思江,博士研究生,主要研究方向为网联条件下多移动智能体的协同定位感知与智能.E-mail:pkulsj@pku.edu.cn.

黄子蔚,博士研究生,主要研究方向为复杂高速移动场景下的无线通信信道的测量与建模.E-mail:ziweihuang@pku.edu.cn.

杨宗辉,博士研究生,主要研究方向为无线通信、通信感知一体化.E-mail:yzh22@stu.pku.edu.cn.

高诗简,博士,高级工程师,主要研究方向为无线通信、统计信号处理.E-mail:gao00379@umn.edu.

白 露,博士,研究员,主要研究方向为6G无线通信网络信道测量与建模研究.E-mail:lubai@sdu.edu.cn.

张嘉楠,博士,助教,主要研究方向为网络理论、网联智能.E-mail:zhangjianan@pku.edu.cn.

郑心湖,博士,助理教授,主要研究方向为多模态感知、多智能体协同感知、网联智能.E-mail:xinhuzheng@ust.hk.

杨柳青,博士,教授,主要研究方向为无线通信网络、多智能体系统、通讯感知一体化等.E-mail:lqyang@ust.hk.

通信感知一体化技术局限于雷达感知与通信在频谱和硬件层面上的共享,不足以提升新兴应用场景中通信与感知的性能.在涵盖海量多模态感知和通信数据的场景中,通信感知一体化技术应向考虑多模态感知的方向进行范式演进,即通信与多模态感知的智能融合.受人类联觉现象启发,文中系统化建立并论述通信和多模态感知智能融合的范式——机器联觉.首先,总结机器联觉3种典型工作模式:唤起模式、增强模式、合作模式,系统全面给出通信和多模态感知之间相互辅助增强的目的与方式.然后,介绍机器联觉研究的数据基础(通信与多模态感知智能融合仿真数据集)和理论基础(通信与多模态感知联觉机理).最后,综述当前机器联觉的研究现状,并展望未来的研究方向.

CHENG Xiang, Ph.D., professor. His research interests in-clude data-driven intelligent network and net-worked intelligence.

About Author:

ZHANG Haotian, Ph.D. candidate. His re-search interests include multi-modal sensing-assisted transceiver design in communication systems.

Li Sijiang, Ph.D. candidate. His research interests include cooperative localization, per-ception and intelligence of connected mobile agents.

HUANG Ziwei, Ph.D. candidate. His re-search interests include complex high-mobility communication channel measurements and mo-deling.

YANG Zonghui, Ph.D. candidate. His re-search interests include wireless communica-tions and integrated sensing and communi-cations.

GAO Shijian, Ph.D., senior engineer. His research interests include wireless communica-tions and statistical signal processing.

BAI Lu, Ph.D., professor. Her research interests include 6G wireless communication network channel measurements and modeling.

ZHANG Jia'nan, Ph.D., assistant profe-ssor. His research interests include network theory and networked intelligence.

ZHENG Xinhu, Ph.D., assistant professor. His research interests include multi-modal perception, multi-agent cooperative perception and networked intelligence.

YANG Liuqing, Ph.D., professor. Her research interests include wireless communica-tion networks, multi-agent systems and inte-grated communication and sensing.

Integrated sensing and communications(ISAC) technique is limited to the sharing of radar sensing and communications at the spectrum and hardware levels, and it fails to enhance the performance of communication and sensing in future emerging application scenarios. In scenarios involving massive multi-modal sensing and communication data, ISAC should evolve towards the incorporation of multi-modal sensing, specifically intelligent multi-modal sensing-communication integration. Inspired by human synesthesia, a paradigm for intelligent multi-modal sensing-communication integration, synesthesia of machines(SoM), is systematically established and discussed in this paper. Firstly, three typical operational modes of SoM , SoM-evoke, SoM-enhance and SoM-concert, are systematically summarized, and thus the purposes and methods of the mutual assistance and enhancement between communications and multi-modal sensing are given comprehensively. Then, the data foundation of SoM research, mixed multi-modal sensing and communication(M3SC) simulation dataset, and the theoretical foundation of SoM research, SoM mechanism, are also discussed. Finally, the current research status of SoM is reviewed and future research directions are prospected.

新一代移动通信系统, 如后五代移动通信系统(Beyond 5th Generation, B5G)和第六代移动通信标准(Sixth-Generation Mobile Networks, 6G), 被认为是许多新兴应用的关键推动因素之一[1, 2].新一代移动通信系统正朝着更高的频段(如毫米波、太赫兹)发展, 与雷达感知系统的频段逐渐交叠.此外, 雷达感知和通信系统都在向更大的天线阵列和微型化方向发展, 从而在硬件架构、信道特性和信号处理方面展现出极大的相似性, 催生通信感知一体化技术(Integrated Sensing and Communications, ISAC)的出现和发展.借助ISAC, 无线网络有望利用无线基础设施实现感知功能, 超越原有的通信功能, 提供泛在的射频感知服务, 进而实现对物理环境随时随地的感知与测量[3].国际电信联盟面向2030的未来技术趋势研究报告指出, ISAC将是新一代移动通信系统中最具潜力的关键技术之一.

当前的ISAC技术旨在实现无线通信与射频感知功能的深度融合, 本文称为射频通信感知一体化技术(Radio-Frequency-ISAC, RF-ISAC).该技术现已引起从基础理论到算法设计等多方面的广泛研究[4, 5, 6].其中, 共享时频资源与硬件架构的空口波形一体化设计是实现RF-ISAC的里程碑式技术, 是RF-ISAC设计中最重要的环节之一.

现有空口波形一体化设计可分为3种类型:以通信为中心的设计[7, 8, 9]、以雷达为中心的设计[10, 11, 12]和联合优化设计[13, 14].以通信为中心的设计强调提高通信波形自身的感知能力, 但由于通信波形携带随机通信信息, 无法调整波形的自相关性, 由其实现的感知能力是有限的.以雷达为中心的设计利用雷达信号作为载波, 将通信符号调制在时域、频域或其它域.其中, 基于索引调制的机会主义设计可将信息比特自然嵌入雷达波形参数中, 提高频谱效率[12].以雷达为中心的设计由于脉冲周期的限制, 难以应用在具有高带宽、低延迟和高可靠性要求的场景中.联合优化设计调整各方向上的波束形状, 平衡通信与感知性能.

尽管当前RF-ISAC的基础理论、信号处理和网络方面仍存在许多挑战, 但其仍被认为是6G网络新无线空口技术的基础[15], 有望在显著提高频谱和能量效率的同时降低硬件和信令成本.

然而, RF-ISAC仍具有较大的局限性.首先, RF-ISAC把感知功能局限在基于射频的雷达感知上, 实现的性能增益仅体现在硬件层面.随着新一代移动通信系统运行的频段逐渐提升, 射频环境和物理环境几何特性之间的关系逐渐变得紧密相关.例如:毫米波信道丰富的几何特性与物理空间的地理特征具有较强的关联性.然而, RF-ISAC却无法全面刻画这种关系, 因为雷达感知功能仅侧重于测量目标的距离、速度、方向等信息, 无法对物理环境进行全面细致地捕获与建模.其次, 新一代移动通信系统期望支持的新兴应用场景[16]大多包含高速移动的智能体, 如智慧城市、智能工厂、智能移动载人平台、空天地一体化网络, 使场景呈现出高度动态性, 为通信和感知系统的性能带来极大影响.现有研究表明, 动态场景通信和感知系统的性能优化往往需要获取场景的额外先验信息, 如收发端物体的位置及周围环境的几何信息, 而RF-ISAC难以提供此类信息.此外, RF-ISAC实现的雷达感知和通信双功能在动态场景中会不可避免地经历性能损失, 捕获的有限场景特征也含有误差.总之, RF-ISAC对于新兴应用场景中的通信和感知系统的优化作用具有一定的局限性.

新一代移动通信系统支撑下的应用场景中会同时部署大量的通信设备和感知设备(包括射频类和非射频类), 包含海量的通信和多模态感知信息, 即各类感知设备采集的不同性质、结构的感知数据, 如激光点云、RGB-D图像、雷达点云.多模态感知可共同获得多维度、多性质的物理环境认知, 在优化通信和感知系统性能方面具有巨大潜力.RF-ISAC应当向考虑多模态感知作用、扩展其优化范围的方向演进, 即通信与多模态感知融合.不同于局限于硬件层面优化的RF-ISAC, 通信与多模态感知融合旨在对系统的各个技术层面进行全面的性能增强, 提升系统的整体性能.

作为RF-ISAC的新范式, 通信与多模态感知融合的范式— — 机器联觉(Synesthesia of Machines, SoM)[17], 有助于提升动态环境中通信与感知性能, 而动态性也是B5G/6G期望支撑的应用场景的关键特性之一[18].同时, 这些应用场景对通信与感知服务具有极高要求, 为传统通信与感知系统设计方案带来前所未有的挑战.例如:在通信功能方面, 车联网场景中高速移动的车辆收发端以及场景中的散射体会导致信道展现显著的频率选择性和时间选择性, 因此需要频繁更新信道特性, 这为高效通信系统的设计带来极大挑战.在感知系统方面, 移动智能体有限的数据采集频率和传感范围影响其在高速运动时收集实时数据的能力, 并导致感知数据的有效时间缩短.因此, 智能体需要更大的感知范围, 确保提前准确检测环境物体, 从而有足够的时间做出合理的行为决策.

通信与多模态感知融合有望在面对上述挑战时提供RF-ISAC无法提供的先验信息, 并得益于多模态环境数据丰富的物理特性而拥有的更多样系统设计方式.例如:对于通信性能的提升, 多模态感知有潜力提供射频环境有关的多种特征, 如散射体的位置和速度、射频环境的清晰3D特征, 这些先验信息有望替代或加速获取这些信息的传统方案(如全向波束训练), 进而直接简化通信系统设计.对于感知性能的提升, 单智能体面对现实各种环境条件时, 多模态感知数据的融合处理有利于保证其感知系统的鲁棒性和准确性.同时, 基于通信网络, 来自多个智能体的多模态感知数据可融合并共同构成一个强化的感知系统.

本文系统化论述SoM, 并且基于SoM总结其3种典型工作模式.SoM可面向任何场景设计, 但更适合于提升动态环境中通信和感知系统的性能.在SoM的框架下, 回顾当前已有工作.本文的讨论重点在于动态应用场景中SoM的研究现状和潜在应用.因为随着6G研发的全面推进, 其支撑的关键动态应用场景已获得学术界和工业界的广泛关注.

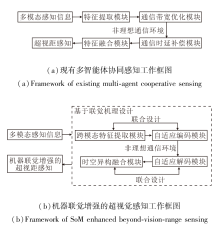

当前, 多模态感知对于通信和感知系统性能的提升作用已得到研究者们的广泛关注, 大量相关研究也已在多种系统应用上被开展.具体而言, 研究者通过合理设计多模态感知的数据处理及特征提取方案, 实现多模态感知在通信系统不同技术环节中带来的性能增益, 如波束预测[19, 20, 21, 22]、小区切换[23]、信道估计[24, 25]、资源分配[26, 27].在感知系统中, 研究者们融合多智能体捕获的多模态感知信息, 实现感知精度的增强和感知范围的扩展.相关研究已在鸟瞰视角/3D目标检测[28, 29]、目标追踪[30]、车道线分割[31]等应用上开展.上述工作均属于通信与多模态感知智能融合研究的范畴.然而, 当前该领域的研究仍缺乏一个统一的框架, 用于系统总结通信与多模态感知智能融合范式, 并指导该领域的相关研究.

联觉是指一个感官在受到刺激时, 会自动触发另一个与之不相关的感官产生感知体验的现象[32, 33], 具体如图1所示.

例如:在字形-颜色联觉中, 一个人在看到数字和字母时, 会自动感受到与之关联的颜色[34].有研究表明, 联觉现象产生的原因可能与人脑中超级连接的神经元有关, 即如果负责传递一个感官信号的神经元被刺激, 那么它们可能会触发负责传递另一个感官信息的神经元自发激活, 进而使人自主产生另一种感知体验[35].

受人类联觉现象启发, 本文定义通信与多模态感知智能融合的范式— — 机器联觉(SoM).

2.2.1 机器感官

在6G时代, 陆地、海洋和天空中都将部署大量的终端设备, 持续利用数以亿计的多模态感知器, 实时感知整个环境, 如LiDAR(Light Detection and Ran-ging)、雷达、RGB-D相机、惯性测量单元等, 整个网络将汇聚海量的物联感知数据[36].人类感官同样持续感知周围的物理环境, 获取声音、味道、视觉等感知信息.鉴于多模态感知设备和通信设备与人类感官之间的相似性, 本文把智能体配备的多模态感知设备和通信设备定义为“ 机器感官” .

如同人类感官的感知原理各异, 不同机器感官的工作原理和产生的感知数据性质也有所不同.LiDAR通过发射激光束进行距离和反射强度的测量, 进而生成高精度、稀疏的3D环境地图; 雷达通过发射电磁波探测和跟踪目标物体, 获得速度、距离等测量值信息; RGB-D相机可获取语义信息丰富的2D环境图像并同时感知环境的几何结构和物体距离; 通信设备调制有信息的电磁波, 通过智能体之间的无线射频信道传递信息.

总之, 如同人类一样, 6G支撑下的万物智联场景中, 智能体也将在全方面、持续地感知环境的过程中完成特定任务.下面将在机器感官的定义下介绍SoM的概念.

2.2.2 机器联觉定义

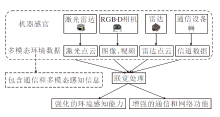

人类联觉现象发生于两种人类感官之间, 而通信与多模态感知智能融合则强调多模态感知与通信功能之间的性能辅助与增强.鉴于人类感官和机器感官之间、人类联觉现象和通信与多模态感知智能融合目标之间的相似性, 可把人类联觉的概念推广到机器感官, 即机器联觉(SoM).SoM是指通过多模态环境数据(包括通信和多模态感知信息)的联觉处理, 强化环境感知能力及增强通信和网络功能的过程.机器联觉示意图如图2所示.

2.2.3 工作模式

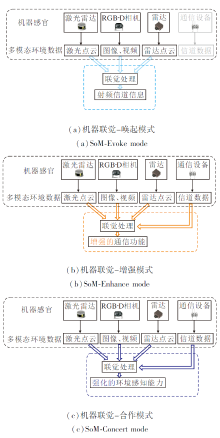

在SoM范式下, 本文系统总结通信与多模态感知智能融合的方式, 归纳为SoM的3种工作模式:机器联觉-唤起模式(SoM-Evoke)、机器联觉-增强模式(SoM-Enhance)、机器联觉-合作模式(SoM-Concert).

各工作模式示意图如图3所示.

1)机器联觉-唤起模式.当一种机器感官未工作时, 通过机器联觉处理其它一种或多种感知信息, 直接增强或实现其功能, 这种情况称为机器联觉的唤起模式.考虑到实际应用情况, 唤起模式在通信系统的实现具有应用价值, 即一种或多种感知信息通过机器联觉处理后, 在通信单元并未工作时可提升通信系统的性能.例如, 可基于多模态感知, 通过人工神经网络(Artificial Neural Network, ANN)直接获取通信系统的信道状态信息或信道统计特性[37], 进而确定信道质量并指导用于数据传输的通信链路选择策略.

2)机器联觉-增强模式.当通信单元工作并能收集一些射频环境信息时, 通过机器联觉处理一种或多种感知信息, 实现对于通信单元性能的辅助增强, 并同时显著降低通信系统开销, 这种情况称为机器联觉的增强模式.例如, 可通过提取多模态感知中移动用户的位置信息以提升毫米波波束对准的精度, 同时显著降低该过程中传统方式所需的导频开销以及随之产生的时延.

3)机器联觉-合作模式.合理融合多种环境感知信息(包括通信和多模态感知信息), 用于提升某些感知任务的性能, 进而增强系统整体的环境感知能力, 但环境感知信息本身并未得到优化, 这种情况称为机器联觉的合作模式.例如, 可通过融合RGB图像中稠密的语义信息和LiDAR点云中精确的环境结构信息, 提高目标检测、目标分类任务的准确性, 进而提升环境感知系统的可靠性.

如图3所示, 机器联觉处理是实现强化环境感知能力以及增强通信和网络功能的核心.在具体给出机器联觉处理方法之前, 从机器联觉的定义出发, 讨论机器联觉处理所需实现的目标.首先, 多模态环境数据具有截然不同的工作原理、语义信息、数据结构.举例来说, RGB图像由三原色的强度值组成, 包含丰富的语义信息; LiDAR提供场景中反射点的坐标及强度; 通信单元收集射频环境信息, 如信道状态信息、路径损耗信息.不同于RF-ISAC仅需利用传统信号处理算法实现数据结构极为相似的雷达和通信信号一体化, 机器联觉首先需要克服多模态环境数据之间的天然差异, 进而实现它们之间的相互辅助与增强.其次, 多模态环境数据之间的关联, 即映射关系, 是SoM研究的基础.多模态环境数据采集于不同频段, 具有不同的物理性质, 也因此刻画同一物理空间不同方面的特征.SoM需要寻找并建立多模态环境数据之间的潜在联系, 以此为依据合理设计其相互辅助与增强的方案.

面对上述机器联觉处理需要实现的目标, 并同时受人类联觉现象中脑神经网络作用的启发, 本文指出ANN是机器联觉处理的核心工具.ANN能适应不同类型的数据, 如图像数据、数值型数据, 同时处理复杂非线性的数据模式和关系, 并可通过训练数据自动发现并学习数据中的重要模式和规律[38].这些特点使ANN自然符合实现上述目标的需求.然而, 本文指出, 机器联觉处理中对于ANN的使用并非是纯数据驱动的, 即使用大量的训练数据提高模型在某一特定场景中特定任务的性能, 凭经验选取合适的ANN并将其作为黑箱模型.在机器联觉处理中, 需要在分析、研究通信系统和感知系统特定任务的理论基础上合理设计网络结构、设置网络参数, 使模型具备面向特定应用的可解释性, 即开发模型增强的数据驱动方案, 实现多模态感知与通信之间可信、可解释的智能融合.

SoM的研究面临着如下挑战.1)SoM的研究离不开大量采集于多场景、多视角的时间同步的高质量多模态环境数据(包含多模态感知数据和通信数据).然而, 截至目前, 可用数据集十分有限.2)多模态环境数据的数据结构、语义信息、工作原理截然不同, 目前为止它们之间的映射关系尚不明确.只有基于明确的映射关系, 多模态环境数据才能面向特定应用, 以可解释的方式被处理, 并进一步输入ANN.3)由于可用数据集的缺乏, 映射关系的研究也难以开展, 目前尚未得到系统研究.因此, 该领域内现存研究的可解释性和可扩展性不高.

SoM的研究离不开大量高质量的多模态环境数据, 即数据基础, 以及多模态环境数据之间的映射关系, 即理论基础.

通信与多模态感知的智能融合研究离不开高质量的多模态环境数据.此外, ANN作为机器联觉处理的核心工具, 同样需要大量高保真度的训练数据作为基础以确保其输出的准确性及模型的泛化性.因此, 包含射频信道信息和多模态感知信息的数据集对SoM的研究至关重要.

当前, 为通信系统和感知系统构建的数据集可按照采集方式分为实测数据集与仿真数据集.实测数据集在真实环境中利用传感器与通信设备采集环境感知信息与信道信息.然而, 实测数据的采集需要大量昂贵的设备, 存在高成本、高复杂度和场景受限等缺陷.不同于实测数据集, 仿真数据集借助强算力且高可靠的仿真软件, 实现复杂度和精确度上的良好权衡.

3.1.1 现有的数据集与分类

根据数据采集设备工作的频点、种类和支撑的应用, 分类现有的数据集.具体而言, 纯通信(Co-mmunications Only, COM)数据集包含电磁环境中的射频信道信息, 包括信道矩阵、出发角和到达角等.基于射线追踪算法, Alkhateeb[39]构建COM数据集— — DeepMIMO.为了支撑感知系统设计, Mani-vasagam等[40]构建仅包含LiDAR数据的射频单模态感知数据集— — LiDARsim, 并涵盖多种典型交通场景.为了丰富感知信息的模态, Xu 等[41]构建非射频多模态感知数据集— — OPV2V, 包含RGB图像、深度图和LiDAR数据.然而, DeepMIMO、LiDARsim和OPV2V数据集仅包含通信或感知信息, 无法支撑SoM的研究.

为了克服上述不足, Blandino[42]在室内场景的相同频点下采集毫米波雷达数据与信道数据, 构建纯射频单频段通信与感知数据集— — WALDO.进一步地, Ali等[20]构建纯射频多频段通信与感知数据集, 分别在73 GHz和76 GHz下采集得到信道数据和毫米波雷达数据.然而, 文献[20]和文献[42]数据集局限于射频通信和射频感知数据, 仅能支持RF-ISAC的研究.

为了引入非射频感知数据, Klautau等[43]利用文献[44]中提出的LiDAR仿真器以及Wireless InSite® 仿真平台[45], 分别采集LiDAR数据和信道数据, 构建混合单模态感知与通信数据集.然而, 该数据集的低信息冗余度和低感知鲁棒性造成低准确性和低适用性.为了弥补该不足, Alrabeiah等[46]构建混合多模态感知与通信数据集— — ViWi.数据集由基于射线追踪的信道数据和多模态感知数据(包括RGB图像、深度图像和LiDAR点云)组成.然而, 该数据集存在毫米波雷达数据缺失、场景保真度低和可仿真环境条件匮乏的不足.

总之, 现有的数据集无法支撑SoM的研究, 亟需构建真实完备的混合多模态感知与通信数据集.

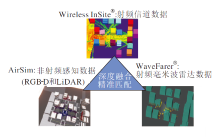

3.1.2 M3SC数据集

为了支撑机器联觉研究, 本文构建通信与多模态感知智能融合仿真数据集— — M3SC(http://pcni.pku.edu.cn/cn/dataset_1.html)[47].利用强算力高可靠仿真平台, 仿真数据集可实现复杂度和准确性之间良好的权衡.然而, 目前没有一个仿真软件能同时采集通信与多模态感知数据.为此, 本文同时使用Wireless InSite® 、WaveFarer® 及AirSim仿真平台, 并在确保其精准匹配的前提下构建M3SC数据集.Wireless InSite® 仿真平台[45]用于采集基于射线追踪技术的射频信道数据; WaveFarer® 仿真平台[48]用于采集射频感知信息, 即毫米波雷达数据; AirSim仿真平台[49]用于采集非射频感知信息, 即RGB图像、深度图像和LiDAR数据.

为了保证三个仿真平台的精准匹配, 首先需确保场景的精确搭建与渲染.以场景的精确搭建为例, 对AirSim和WaveFarer® 中的场景进行深度渲染以支撑高分辨率的感知信息的采集, 并简化Wireless InSite® 中的场景, 在保证射线追踪数据精度的基础上最大程度提高数据采集效率.此外, 实现场景元素对齐、天气参数统一、车辆坐标对齐与多源数据匹配.以场景元素对齐为例, 精确对齐Wireless InSite® 、WaveFarer® 和AirSim三个仿真平台中的每个物体在每个时刻下的位置.

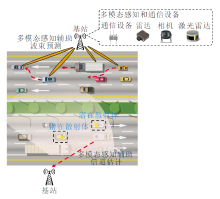

通过对上述三个软件的深度融合和精准匹配, 确保M3SC数据集上通信数据与多模态感知数据的高准确性与保真度.以M3SC数据集上十字路口场景为例, 图4给出M3SC数据集搭建方式的可视化展示.

目前, M3SC数据集包含具有典型特点的交通场景, 包括城镇(十字路口、超宽车道和高架立交桥)、郊区(分岔路口)和山区公路, 典型场景示例如图5所示.各场景详细信息如下.

1)城镇十字路口.路况复杂多变, 包含11个路端设备、12辆车、6位行人、诸多树木和建筑.

2)城镇超宽车道.双向12车道, 包含11个路端设备、100辆车、50位行人.

3)城镇高架立交桥.道路起伏、交错, 包含32个路端设备、50辆车、30位行人和绿化带.

4)郊区分岔路口.建筑较少、低矮, 路端设备较少, 包含6个路端设备、15辆车、建筑(加油站、低矮房屋、平房)、4位行人和树木.

5)山区公路.坡陡、弯路多, 路端设备较少, 包含5个路端设备、7辆车、山地和森林.

为了支撑机器联觉在现实场景条件下的应用研究, M3SC数据集还包含丰富的场景条件:多时段(早、中、晚)、多天气(晴天、雨天、雪天、雾天)、多视角(车端、路端)、多种车流量密度(高、中、低)、多频段(Sub-6 GHz、毫米波28 GHz)以及多种天线阵列(单输入单输出、多输入多输出和大规模多输入多输出).

目前, M3SC数据集涵盖19万幅RGB图像, 38万幅深度图, 19万组LiDAR点云, 17万组毫米波雷达波形、18万组信道矩阵和5万组路径损耗.

以可用数据为基础, SoM的研究还需挖掘物理环境中的多模态感知信息与电磁环境中信道信息的联觉机理(映射关系), 作为理论基础指导后续研究.由于多模态感知信息获得物理环境特征的方式相近, 不难挖掘多模态感知信息之间的映射关系.然而, 由于射频信道信息与多模态感知信息在采集频段和数据结构形式上的天然差异, 找寻它们之间映射关系变得极具挑战性.面向这一任务, 本文指出信道建模是多模态感知信息与射频信道信息映射关系挖掘的一个重要工具, 因为其可实现对射频无线传播环境的真实客观表征, 并有助于理解射频无线传播机制.

3.2.1 联觉机理(映射关系)挖掘的挑战

多模态感知和射频无线信道数据在采集频段和数据表现形式上存在显著差异, 因此探索二者之间的映射关系极具挑战性, 具体体现在如下方面.

1)数据采集频段上的差异.射频传播与非射频传播机制极其不同.具体而言, 相比射频传播, 非射频传播的散度更小、方向性更强.另外, 非射频由于波长小而一般不存在衍射.此外, 由于射频与非射频在频段上的巨大差异, 它们的反射和散射机制也存在显著差异.因此, 在物理环境中采集的非射频多模态感知数据与在电磁环境中采集的射频无线信道数据之间的相关性较低, 二者映射关系挖掘的难度较高.

2)数据表现形式上的显著差异.多模态感知数据(RGB图像、深度图、毫米波雷达点云和LiDAR点云)的数据表现形式为具有离散值的2D或3D结构.然而, 信道大尺度衰落特性(如路径损耗和阴影衰落)的数据表现形式为具有连续值的一维结构.

3)物理空间中物体与电磁空间中有效簇的复杂映射关系.RGB-D相机可获得物理环境中的物体位置, 它们可能是电磁环境中潜在的有效簇.毫米波雷达和LiDAR可获得对应的速度信息.因此, 多模态传感器可识别并实时追踪环境中的物体.在这种情况下, 需要以一种平滑连续地方式刻画环境中有效簇的演进, 这可通过捕捉信道的一致性完成.然而, 由于有效簇复杂的出现和消失现象, 信道一致性的捕捉极具挑战性.因此, 挖掘物理空间中的物体与电磁空间中的有效簇也极具挑战性.

3.2.2 联觉机理(映射关系)挖掘的现有工作

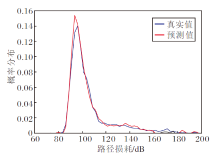

由于信道存在大尺度衰落与小尺度衰落这两类衰落特性, 有必要分别探索与挖掘多模态感知信息与信道大、小尺度衰落特性间的映射关系.由于信道大尺度衰落与多模态感知信息之间的映射关系挖掘存在巨大的挑战, 目前还没有相关的工作.为了填补这个空白, 本课题组挖掘RGB-D图像与路径损耗分布之间的映射关系, 提出一个无人机对地通信中基于图像的路径损耗预测方案.方案使用YOLO目标检测网络[50]识别无人机俯拍的RGB图像, 并匹配深度图提取图像中楼房密度、高度以及相对位置信息, 进而利用全连接网络预测路径损耗分布.因此, 为了克服映射关系挖掘的挑战, 利用感知图像提取物理空间中影响路径损耗分布的环境信息向量, 并结合全连接网络, 实现无人机对地通信中实时路径损耗预测.利用Wireless InSite® 仿真平台采集飞行路径中的路径损耗数据, 并利用AirSim同步采集RGB图像和深度图.

某一仿真时刻下路径损耗分布预测值和基于射线追踪获得的路径损耗分布(视为真实值)的对比结果如图6所示.从图中可以看出, 预测值与真实值极为接近, 充分表明所提方案的有效性.此外, 所有仿真时刻的预测结果和真实值之间的平均归一化均方误差(Normalized Mean Squared Error, NMSE)为5.32× 10-4.

| 图6 路径损耗分布预测结果与射线追踪结果对比Fig.6 Comparison of prediction results of path loss distribution and ray-tracing results |

类似于信道大尺度衰落, 信道小尺度衰落与多模态感知信息之间映射关系的挖掘也仅处于起步阶段, 聚焦于对信道一致性的捕捉.信道的一致性是信道的一个典型物理特征, 存在每个信道中.信道空间一致性或时间一致性表明信道随空间或时间的演进而平滑一致地变化[51, 52, 53].在捕捉信道一致性的基础上, 基于M3SC数据集开展LiDAR点云与信道小尺度衰落特性之间的映射关系, 并构建LA-GBSM(LiDAR-Aided Geometry-Based Stochastic Modeling).利用机器学习中DBSCAN(Density-Based Spatial Clus-tering of Applications with Noise), 智能化处理M3SC数据集上LiDAR点云, 从而识别动态车辆、静态树木与建筑.然后, 精准匹配物理空间与电磁空间, 区分动、静态散射体.进一步地, 挖掘动、静态散射体的距离、数量、角度和功率的统计分布, 联合建模信道一致性与非平稳特性.因此, 为了克服映射关系挖掘的挑战, LA-GBSM利用机器学习算法并借助于物理空间中的动、静态物体与电磁空间中的动、静态散射体的匹配性, 探索LiDAR点云到信道小尺度衰落特性的映射关系.基于LA-GBSM, 探索车流量密度对信道特性的影响, 并利用射线追踪结果验证LA-GBSM的有效性.本文对比传统仅利用射频信道信息的信道模型[54]和LA-GBSM仿真得到的信道特性, 即多普勒功率谱密度的精度.具体而言, 以射线追踪的结果为基准, 仅利用射频信道信息的信道模型的多普勒功率谱密度的精度为66%, 而LA-GBSM的多普勒功率谱密度的精度为92%, 信道特性精度提升39%.

到目前为止, 机器联觉-唤起模式的研究尚处于起步阶段, 因为它需要深入理解多模态感知和通信之间复杂的映射关系, 而这方面的研究仍然很匮乏.尽管如此, 本文认为机器联觉-唤起模式极具研究价值.举例来说, 在实际应用中, 通信单元在尚未部署时需要对射频环境进行大量测量, 根据信号覆盖能力、网络资源需求等因素确定部署位置.机器联觉-唤起模式有望通过环境中丰富且容易获得的多模态感知信息提供与射频环境相关的有用先验信息, 如区域路径损耗情况、通信链路潜在状态, 从而在一定程度上减少射频资源开销.

SoM的一个重要目标是增强通信和网络功能.在通信网络中, 收发双方之间依靠电磁波的传播进行通信, 因此, 通信系统的高效设计离不开对射频环境的全面认知.多模态感知具备刻画物理环境不同性质的能力, 而通信系统的射频环境又被物理环境影响.特别地, 随着5G的商用及B5G/6G研究的加速推进, 通信系统的工作频段逐渐提升, 射频环境与物理环境之间的关联性变得日趋显著, 多模态感知对于射频环境潜在的特征捕获作用也因此凸显.

图7以通信系统中波束预测和信道估计任务为例, 展示机器联觉-增强模式的应用方式.本节旨在介绍当前机器联觉-增强模式在动态场景毫米波波束对准以及信道估计中应用的研究现状.

4.2.1 机器联觉辅助的毫米波波束对准

毫米波具有带宽大、速率高等优势, 是5G及未来B5G/6G通信系统中的重要基础技术之一.为了克服毫米波频段衰减大、绕射能力差的问题, 毫米波通信往往借助多输入多输出(Multiple-Input Multiple-Output, MIMO)波束成形技术形成较窄的波束, 实现定向通信, 提高信噪比.然而, 这要求通信收发双方随时保证窄波束的精确对准, 确保通信链路的稳定性, 这为其在动态场景中的应用带来极大的挑战.为了克服传统波束训练方案在动态应用场景波束对准任务中带来的高昂通信开销和时延, 研究者们提出使用多模态感知信息以加速这一过程, 在无需额外导频开销的情况下预测最优的波束.

随着通信双方的移动, 波束对准的方向与二者之间的相对位置密切相关.RGB相机作为部署最广泛的感知设备, 可捕获到环境信息丰富的2D视觉信息, 其中包含通信对象的位置及周围环境的语义信息.最近, 有研究者基于成熟的ANN, 实现利用路侧单元采集的RGB图像预测最优波束[19, 23, 55].具体而言, 上述方案均假设路侧单元从有限精度的预定义的码本中预测实现最高信噪比的波束, 波束预测问题也因此等价为图像分类问题.此外, Charan等[23]和Alrabeiah等[55]均采用路侧单元拍摄的图像信息, Xu等[19]认为该方式需要额外进行通信对象的识别, 并且有侵犯用户隐私的问题, 为此提出使用车(通信对象)上配备的多视角RGB摄像机, 并应用3D检测技术获取车周围的环境信息以辅助波束预测.Gu等[56]进一步考虑ANN在不同部署环境下的适用性问题, 提出使用元学习方法增强基于车端图像的波束预测方案的泛化性.

LiDAR作为自动驾驶中常用的感知设备之一, 也同样可用于提供通信对象的位置信息并辅助波束预测[43, 57, 58].Klautau等[43]将LiDAR原始数据转换为3D直方图, 作为ANN的输入, 辅助视距传播路径(Line of Sight, LoS)的检测及最优波束的预测.Dias等[57]提出把3D直方图中的数值转化为二进制, 用于表示该区域是否存在反射点, 避免LiDAR数据的处理需要消耗大量计算资源的问题.

除了上述非射频感知设备, 基于射频的雷达感知因其可测量目标物体的参数, 也具有辅助波束对准的潜力.Demirhan等[59]使用调频连续波雷达测量目标车辆的参数, 并对雷达原始数据进行二维和三维傅里叶变换, 得到距离-速度谱、距离-角度谱以及雷达数据立方体, 作为ANN的输入辅助波束预测.类似地, Demirhan等[60]也基于调频连续波雷达数据, 使用类似的数据处理方式完成交通场景中潜在遮挡物的预测.

感知设备均有不同的应用限制, 例如:RGB摄像机容易受到光照条件影响, LiDAR容易受到恶劣天气的影响(如雨、雪、雾天).因此, 上述仅依靠单一模态感知数据辅助的方案并不具备对各种环境条件的鲁棒性.为此, Salehi等[61]提出FLASH(Federa-ted Learning for Automated Selection of High-Band mm-Wave Sectors), 分析车端的多模态感知数据在缺失其中某一模态时方案的适应性, 并实现多车在无需上传大量本地数据时共同分布式地参与共享ANN的学习, 使每辆车可以了解探测范围以外的环境特性.类似地, Salehi等[62]还提出同时使用车端和路段采集的多模态数据以辅助波束预测, 并采用将车辆采集的原始感知数据压缩为抽象特征的分布式推理方案, 降低数据传输的开销.在理论分析层面, Yang等[63]以波束预测为实例, 提出环境语义辅助的无线通信框架, 并分析不同环境语义对于波束预测任务的重要性.

上述基于机器联觉-增强模式的波束预测研究实现的均是从有限精度的预定义码本中预测最优波束.尽管该条件有助于提升方案的预测精度, 但一旦天线阵列尺寸变大、码本尺寸增加, 此类方案仍面临精度下降问题.此外, 通信对象在相似位置时均采用相同波束通信, 有时会不可避免地降低通信速率.事实上, 基于目标物体角度连续追踪实现的波束成形预测也已被广泛研究, 绝大部分相关工作[64, 65, 66, 67, 68, 69, 70, 71]仅基于射频信息, 即双功能波形或专用的导频信号.

为了实现连续性角度追踪的同时保证进一步避免上述通信资源开销, 在车对路(Vehicle-to-Infras-tructure, V2I)和车对车(Vehicle-to-Vehicle, V2V)通信场景下均开展基于机器联觉-增强模式的波束成形预测工作.

具体而言, Zhang等[72]在V2I场景下设计MMFF-Net(Multi-modal Feature Fusion Network), 周期性地利用路侧单元采集的RGB图像、深度图及Sub-6 GHz控制信道上收集的信道状态信息, 完成对通信对象的未来位置预测, 供通信单元直接向特定方向波束成形.在多模态特征的提取部分, 面向角度追踪任务, 以模型增强的方式, 针对性设计原始数据的预处理方案.此外, 为了更好地模拟用户复杂真实行为, 构建用户在行驶过程中随机侧移的轨迹数据如图8所示.MMFF-Net对该行为具有较好的鲁棒性, 在绝大多数时刻可实现最高的可达通信速率, 并且不存在仅基于射频方案[70]的误差累计问题.

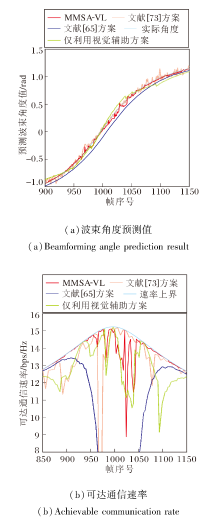

此外, 在V2V场景下设计利用视觉和激光雷达信息的MMSA-VL(Multi-Modal Sensing Assisted Beam Prediction with Vision and LiDAR Information), 从RGB图像提取环境中目标通信车辆的语义特征, 利用激光雷达点云获得高精度的位置信息, 优势互补两种模态的感知能力.同时, MMSA-VL考虑实际情况下感知设备和通信设备在通信传输车辆上的部署位置情况, 能适应实际情况中任意设备的部署方式.如图9所示, 相比仅利用通信信号的辅助波束对齐方案[73]、仅利用射频感知辅助的EKF(Extended Kalman Filtering)方案[65]和仅利用视觉辅助的方案, MMSA-VL表现出更稳定的追踪效果和最高的可达通信速率.

4.2.2 机器联觉辅助的信道估计

准确的信道估计对于优化无线通信系统的性能、容量、抗干扰性至关重要.不同于波束预测任务, 信道估计本质上是对射频信道环境进行精确获取.虽然多模态感知能对物理环境进行多方面刻画, 但是由于其与射频空间之间的映射关系仍未知, 如何使用多模态感知数据、合理地从中提取与射频有关的信息成为最大的挑战.因此, 当前基于机器联觉的信道估计研究仍然较少.

现已有一些基于射频感知辅助通信的工作, 尝试利用感知的射频域特征信息辅助快速用户波束匹配[66]、克服信道时频选择性[67]、辅助非线性解调[68]及优化均衡器设计[69].然而, 这些工作需要射频信道与物理高度匹配, 因此对环境的适应能力相对薄弱.从单一射频过渡至多模态的基于机器联觉设计有望获得更强的通用能力, 然而当前研究仍然较少.

Xu等[25]提出ULCCME(User Location Based Channel Covariance Matrix Estimation), 虽然信道协方差能在一定程度上辅助后续信道估计, 但后续采用的线性最小均方误差(Linear Minimum Mean Square Error, LMMSE)信道估计方案仍会带来较大的通信开销.

Jiang等[24]使用雷达获取移动用户和潜在散射体的距离、速度和方向信息.由于这些测量值与信道参数直接相关, 把该信息通过雷达信号处理转化为信道矩阵中对应的主要值的索引, 并作为OMP(Orthogonal Matching Pursuit)的先验信息, 以期提升算法性能.在文献[24]的基础上, Mundlamuri等[74]进一步解决雷达测量值包含误差的实际问题, 以及雷达探测的物体与射频环境中有效散射体之间不匹配的问题.然而, 由于雷达的固有性质, 文献[24]模型和文献[74]模型均为基于假设的固定信道模型, 在信道特性快变的动态场景中应用受限.

5G通信系统及未来B5G/6G通信系统均把毫米波视为关键技术之一.毫米波信号主要沿特定方向传输, 在其它方向上衰减较快, 因此毫米波信道在角域展现出显著的稀疏性.借助这一特性, 近年来学者们提出大量基于ANN的角域信道估计方案[75, 76, 77, 78].然而, 这些工作仅把导频信号作为模型输入, 未利用任何环境信息, 在复杂射频环境中不可避免地会经历性能损失.

为此, 本课题组最新开展基于机器联觉-增强模式的信道估计工作, 借助LiDAR对于环境的大范围清晰认知能力, 设计LE-CEN(LiDAR Empowered Channel Estimation Network), 在大幅节省导频的情况下达到较高的信道估计精度.LE-CEN对原始LiDAR数据进行射频环境相关信息的叠加预处理操作, 在尽可能降低LiDAR数据带来的计算复杂度的同时, 挖掘并学习LiDAR中隐含的角域信道特征.在复杂车联网的车对路通信链路上验证LE-CEN, 其中车辆配备单天线, 基站配备多天线.

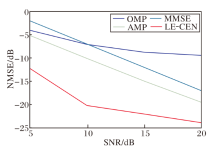

LE-CEN、OMP[79]、AMP(Approximate Message Pa-ssing)[80]及MMSE(Minimum Mean Square Error)[81]在信道估计结果的NMSE(Normalized Mean Square Error)指标上的性能对比如图10所示.由图可看出, 在不同信噪比(Signal-to-Noise Ratio, SNR)下, LE-CEN在发送导频的数量远小于其它方案, 可实现估计精度的大幅提升.

借助机器联觉-唤起模式和机器联觉-增强模式有望进一步提高通信系统的功能, 但对于移动智能体而言, 在复杂环境中实现实时感知同样是支撑其智能功能的重要任务之一.

在B5G/6G时代, 随着通信频段的逐渐提高, 通信和基于射频的感知功能呈现耦合趋势, 同时多样化的射频和非射频传感器被广泛部署于通信网络的智能体中, 因此预计感知功能将成为未来无线通信系统中的原生功能[82].

基于传感器采集的数据, 如RGB-D图像、激光点云、毫米波雷达点云等, 智能体可利用ANN提取环境特征, 进而获得感知结果.然而在动态环境中, 单一类型的传感器带来的环境信息冗余远远不够, 出现视距和视野范围受限、恶劣天气下可靠性较低等问题.

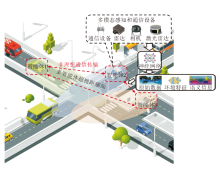

因此本节旨在介绍当前机器联觉-合作模式增强环境感知的相关工作, 主要集中在利用多模态感知设备优势互补的单智能体感知与利用通信共享多视角感知数据的多智能体超视距感知方面, 机器联觉-合作模式增强的环境感知总体架构如图11所示.

4.3.1 机器联觉辅助的单智能体感知

对于配备有多模态传感器的智能体, 机器联觉-合作模式可应用于多模态传感器间的优势互补, 提升感知信息冗余度, 进而提升感知性能.例如:相机可采集稠密纹理信息但缺乏结构信息; LiDAR点云呈现高度结构化但较稀疏; RGB-D相机同时具备稠密性和深度信息, 但测量范围受限; 射频雷达在雨雪等特殊天气下具有更强的鲁棒性, 可直接测量目标速度.由此可见, 基于机器联觉机理, 利用ANN, 可借助多模态融合提升单智能体的感知能力.根据融合流程, 现有工作可分为三类:前融合方案, 后融合方案, 混合融合方案.

在前融合方案中, 多模态感知数据被整合后输入ANN统一进行特征提取, 进而获得感知结果.由于多模态感知数据具有不同的组织形式, 如RGB-D相机的2D像素、LiDAR与射频雷达的2D或3D点云, 前融合方案设计的核心是统一不同形式数据后进行统一的ANN设计.Steyer等[28]利用鸟瞰视角的栅格地图, 将传感器数据投影到统一的2D鸟瞰视角, 并转化为平面栅格中数据点数量、障碍物占据概率、障碍物高度等信息.Steyer 等[30]对齐LiDAR和毫米波雷达点云, 用于生成栅格地图.Zheng等[83]利用RGB图像提取动态障碍物后, 与激光点云联合生成栅格地图.后续可通过聚类或机器学习算法, 从栅格地图中获得环境中目标的信息.

除了借助栅格地图统一多模态数据外, Dou等[29]将3D激光点云投影到2D图像平面, 基于叠加的传感器数据, 经ANN处理后, 获得3D目标检测结果.Zhang等[84]首先利用卷积神经网络提取毫米波雷达与多个鱼眼相机的环境特征, 再在统一的鸟瞰视角下进行特征的拼接和融合.

此类前融合方案在特征提取过程中具有最高的信息冗余度和性能上限.但前融合算法架构设计与传感器类型和数量紧密相关, 因此算法的灵活性较低.

在后融合方案中, 参与融合的对象为多模态传感器分别得到的感知结果, 在形式上较统一, 如2D或3D的目标检测框等, 因此后融合方法具有较强的灵活性和通用性.Asvadi等[85]将激光点云投影至2D平面后, 获得2D检测框, 与RGB图像提取的2D检测框加权融合.为了实现3D检测, Pang等[86]利用RGB图像提取的2D检测框, 对激光雷达的3D检测框位置进行修正优化.Gu等[31]融合激光雷达和相机的语义分割结果, 进行道路检测.

后融合方案中的关键问题在于确定多模态感知结果在融合中的权重, 例如:在多模态检测结果重叠区域, 利用置信度评分[87]、交并比[86], 计算不同模态的权重.此类后融合方案中单模态感知算法和多模态融合算法呈现解耦状态, 因此适合利用智能体现有的感知结果进行“ 即插即用” 部署, 从而具有最强的通用性.但与此同时, 由于单模态感知处理过程中的信息丢失, 在包括雨雪、遮挡等异常环境中, 多模态融合的性能会显著下降.

作为一种折衷方案, 混合融合方案综合考虑前融合的高信息冗余和后融合的高灵活度, 根据不同模态处理流程的特点, 将一种处理阶段的某种模态信息融入其它阶段的另一种模态的感知处理中, 以权衡性能和灵活度.Chen等[88]融合来自鸟瞰视角与前向视角的激光点云, 以及前向视角的图像, 利用来自激光雷达的3D候选检测框(感知结果), 确定多模态特征融合的感兴趣区域(Region of Internet, ROI).Qi等[89]和Wang等[90]利用已有的图像目标检测ANN模块, 利用RGB图像稠密的语义信息生成2D检测框, 减少激光雷达目标检测的搜索空间, 提升效率.Yang等[91]利用RGB图像获得像素层面语义分割结果, 为LiDAR的3D目标检测提供信息补充.

综上所述, 机器联觉-合作模式辅助的单智能体感知现有工作旨在利用多模态感知数据的互补性提升感知信息冗余度, 包括信息冗余度最高的前融合方案, 灵活性最强的后融合方案, 以及在效率和性能间寻求折衷的混合融合方案.然而在动态环境中, 智能体需要提前获得远距离或遮挡后的环境状况, 提前做出规划判断, 同时, 在异常环境下, 单一智能体上安装的多种传感器可能会出现同时的性能下降, 例如:在黑暗长隧道中, RGB图像质量因暗光下降, 激光点云因隧道内壁光滑而缺少结构特征, 射频雷达受多径效应影响较大, 仅借助单智能体多模态融合难以满足所需感知需求.

4.3.2 机器联觉辅助的多智能体感知

随着通信技术的发展, 多个智能体间有机会利用大带宽、低时延的通信网络实现感知数据的实时交互, 因此机器联觉-合作模式的增强环境感知不仅包含多模态传感器融合, 还包含通信作为信息交互媒介对多模态感知的增强.由于多个智能体上部署的传感器自然处于不同的视角和环境状态, 来自周边智能体的感知数据可显著提升信息荣誉度, 进而在不提升单智能体感知设备成本的前提下扩大感知范围, 提升感知性能.

然而, 与此同时通信的非理想性也是系统设计中的关键因素之一, 在感知系统中需要根据通信网络的质量灵活设计交互内容.根据多智能体间信息交互的内容, 现有的机器联觉-合作模式辅助的多智能体感知工作可分为原始数据级协同、特征级协同、语义级协同.

类似单智能体多模态前融合方案, 多智能体原始数据级融合方案同样可借助栅格地图或传感器数据投影实现, 然而区别在于, 相比单智能体中多传感器的有线通信, 多智能体间的无线通信网络连接性能受限, 需要评估原始数据级融合的数据量.Li等[92]提出通过共享相机画面增强现实的方式, 获得遮挡区域视野.Kim等[93]共享单线激光点云和低分辨率图像数据, 辅助车道线识别和配准地图.Chen等[94]融合多个车辆的多线激光雷达数据, 提升目标检测数量和准确度, 但单帧激光雷达MB级数据量使动态场景下的实时应用存在巨大挑战.Zheng等[83]在发送给周边智能体共享前通过鸟瞰栅格地图初步加工图像和多线激光雷达数据, 改善周边智能体视野和感知障碍物的轮廓清晰度, 但单帧栅格地图数据量同样接近MB级.为了改善数据量问题, Qiu等[95]评估感知数据和周边车辆轨迹的相关度, 赋予不同区域感知数据不同的优先级, 单个数据包的数据量可压缩为几百KB级, 但同时带来计算优先级的额外算力开销.

为了在受限的通信条件下实现多智能体协同感知, 首先在单智能体端, 特征级协同利用ANN提取感知数据中包含的稀疏环境特征, 进而与周边智能体共享特征图以增强感知.Chen等[96]传输ANN提取的激光雷达特征, 在降低通信数据量的前提下, 获得接近原始数据级协同的感知效果.Guo等[97]评估特征中包含的信息量, 进一步筛选不必要的特征以精简数据量, 通过无关特征去除模块以及特征通道选择模块[98], 在多智能体间共享的特征图数据量可灵活调控在50 KB到1 MB间, 动态适应不同通信条件.

尽管原始数据级协同与特征级协同均可为智能体带来信息冗余度的明显提升, 在实际应用中, 同样需要松耦合架构以适应多智能体间可能不同的传感器配置, 以及严重受限的通信条件.类似单智能体后融合“ 即插即用” 的模式, 感知数据可在多个智能体内部独立处理, 仅共享感知结果, 即语义级协同.在此类方案中, 在智能体间共享的通常是感知任务中的上层信息, 如车道线[99]、目标检测框和类别[100], 数据量仅为KB级, 最大程度节省通信资源, 同时信息形式不因传感器种类和ANN细节而变化, 具有较强的通用性.

然而在复杂场景中, 单智能体感知容易由于环境干扰而出现错误, 进而影响总体的协同感知性能, 因此在此类方案中, 在融合前需要评估外来数据的置信度[87], 确保剔除错误数据, 避免其干扰融合结果.

在上述基于机器联觉-合作模式辅助的多智能体感知的研究中, 通信主要作为环境感知信息交互的媒介, 在多个智能体间传输多模态感知数据、环境特征或感知结果, 实现协同超视距感知.针对不同程度受限的通信带宽, 可选择筛选关键原始数据、进行特征提取和压缩、亦或采用语义级协同以充分利用通信资源增强感知.针对通信网络的其它非理想性, 如随机时延, Wang等[101]设计时延补偿模块, 避免时延带来感知错误.

上述解决方案均通过处理感知数据或添加独立算法模块实现, 环境感知与通信传输仍呈现分立设计的态势, 未能充分体现通信与多模态感知智能融合的优势.为了充分发挥ANN在通信与多模态感知智能融合中的作用, 本课题组现开展的研究旨在利用ANN进行通信与多模态感知的联合设计, 即端到端考虑环境感知特征的提取加工与真实通信环境中的传输方案设计.具体而言, 在环境信息提取过程中, 联合考虑感知任务需要与通信网络条件自适应地选择特征提取的内容与冗余度.同时在特征传输过程中, 结合传输内容中包含的环境语义信息与射频信道状态, 决定通信的信源信道编码方案与MIMO编码方案.这旨在对用于感知与通信的ANN模块进行联合设计和整体调优, 充分发挥机器联觉对智能体环境感知能力的提升作用, 确保智能体在真实动态环境中的感知性能.

相比现有主流的多智能体感知工作, 本课题组现工作的核心架构特点如图12所示.

网络的动态控制是无线通信网络中的一个关键问题.合理的动态控制策略可促进网络节点共享频谱资源, 提升网络吞吐量.然而网络拓扑复杂多变, 链路状态难以预测, 任务需求各异, 现有动态控制算法无法高效支撑复杂多样的任务.借助多模态感知信息, 网络节点可进行链路状态预测, 获取精确的网络资源分布, 从而进行任务的路由、调度与网络资源的弹性分配, 提高无线网络的吞吐量与频谱效率.今后可进一步探索机器联觉启发下的无线网络的性能边界, 充分利用多模态感知提高无线网络的吞吐量与整体效用.

未来的无线通信网络将会向更高频段发展, 其更丰富的带宽资源有助于进一步提升通信的容量与感知的精度.因此, 面向更高频段的双功能波形设计是RF-ISAC的重要发展趋势.然而, 由于高频信号路径损耗严重, 需要更大的天线阵列汇聚能量, 导致收发机功耗的急剧上升, 并给其系统设计带来严峻挑战.借助多模态感知信息, 双功能收发设备可获取更丰富的环境特征, 降低其在用户搜索与感知区间扫描上的时间开销与计算复杂度.

预编码设计是无线通信收发机设计中提升通信性能的重要技术, 旨在消除多用户之间的接收干扰, 提升频谱效率和能量效率.现有预编码设计都是基于信道估计的结果进行的, 但是信道估计本身可能会存在误差.多模态环境信息可直接或间接地为预编码设计提供更多关于信道的先验信息.例如:在端到端的通信系统中, 根据导频信息和多模态感知信息, 不经过显式信道估计, 通过ANN直接输出预编码结果, 从而避免信道估计的误差.此外, 基于现有通信系统架构, 可利用多模态环境信息修正不完美的信道估计结果, 提升预编码的性能.

动态场景中的智能体需要借助通信网络共享多模态信息以扩大感知范围, 提升感知精度.借助ANN, 可进行多模态感知特征提取与非理想条件通信传输的端到端联合设计.一方面, 借助多模态环境数据间的映射关系, 进行多模态信息的冗余压缩, 优势互补; 另一方面, 实现环境特征提取与通信传输条件间的适应, 最大化通信效用.面向具体的感知任务, 进行特征提取网络与通信编码网络的整体设计, 联合调优, 最大化复杂动态场景下智能体的环境感知能力, 支撑其上层应用.

在B5G/6G时代通信和多模态感知智能融合的背景下, 本文系统化地定义并论述SoM, 定义3种典型工作模式, 总结通信和多模态感知之间实现智能融合的方式.首先, 介绍SoM的研究基础, 包括数据基础(通信与多模态感知智能融合仿真数据集)和理论基础(通信和多模态感知的联觉机理).然后, 从SoM的三个工作模式出发, 综述SoM的研究现状, 并介绍本课题组相关工作以及相应的仿真结果.最后, 提出关于SoM在网络动态控制、波形设计、预编码设计以及联合感知与传输方向上的进一步研究思路.SoM的提出旨在推动通信与多模态感知智能融合理论的研究发展, 并为该领域未来的研究提供一定指导.

本文责任编委 张荣庆

Recommended by Associate Editor ZHANG Rongqing

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|

| [43] |

|

| [44] |

|

| [45] |

|

| [46] |

|

| [47] |

|

| [48] |

|

| [49] |

|

| [50] |

|

| [51] |

|

| [52] |

|

| [53] |

|

| [54] |

|

| [55] |

|

| [56] |

|

| [57] |

|

| [58] |

|

| [59] |

|

| [60] |

|

| [61] |

|

| [62] |

|

| [63] |

|

| [64] |

|

| [65] |

|

| [66] |

|

| [67] |

|

| [68] |

|

| [69] |

|

| [70] |

|

| [71] |

|

| [72] |

|

| [73] |

|

| [74] |

|

| [75] |

|

| [76] |

|

| [77] |

|

| [78] |

|

| [79] |

|

| [80] |

|

| [81] |

|

| [82] |

|

| [83] |

|

| [84] |

|

| [85] |

|

| [86] |

|

| [87] |

|

| [88] |

|

| [89] |

|

| [90] |

|

| [91] |

|

| [92] |

|

| [93] |

|

| [94] |

|

| [95] |

|

| [96] |

|

| [97] |

|

| [98] |

|

| [99] |

|

| [100] |

|

| [101] |

|