通讯作者:

作者简介:

开放环境下机器学习面临类别集可变、非独立同分布、噪声干扰等诸多问题,容易导致传统封闭环境机器学习系统性能急剧下降.因此,面向开放环境的机器学习方法是当前人工智能研究的前沿热点之一.文中主要从泛化、优化、鲁棒性和效能度量四个方面介绍开放环境机器学习理论研究现状和重要进展.在泛化理论中,具体介绍开放类别集检测、迁移学习与元学习、稀疏学习等泛化分析成果.在优化理论中,具体介绍随机与稀疏优化、在线与持续优化、分布式与联邦优化等理论分析研究成果.在鲁棒性理论中,具体介绍对抗样本、随机噪声、噪声标签等干扰下鲁棒学习理论研究成果.在效能度量中,具体介绍面向开放环境机器学习一些重要性能评价准则.最后,展望开放环境机器学习理论的未来研究趋势.

Corresponding author:

YUAN Xiaotong, Ph.D., professor. His research interests include machine learning, stochastic optimization and computer vision.

About Author:

ZHANG Xuyao, Ph.D., professor. His research interests include pattern recognition, machine learning and deep learning.

LIU Xi, master student. Her research inte-rests include federated learning, transfer learning and pattern recognition.

CHENG Zhen, Ph.D. candidate. His research interests include pattern recognition, machine learning and adversarial robustness.

LIU Chenglin, Ph.D., professor. His research interests include pattern recognition, machine learning, and document analysis and recognition.

In an open environment, machine learning is faced with various challenges, including varying category sets, non-identically distributed data and noise interference. These challenges can result in a significant decline in the performance of traditional machine learning systems built under the closed-world assumption. Therefore, open-environment machine learning is a research focus on artificial intelligence. In this paper, the current status and recent important advances in the theoretical study of open-environment machine learning are discussed from the perspectives of generalization, optimization, robustness and performance measurement. For generalization theory, the advances on the generalization performance analysis of open-set detection, transfer/meta learning and sparse learning approaches are introduced. For optimization theory, the advances on the theoretical analysis of random and sparse optimization, online and continual optimization, as well as distributed and federated optimization approaches are introduced. For robustness theory, the advances on robust learning under adversarial samples, random noise and noisy labels are introduced. For performance measurement, a number of widely used performance measurement criterions for open-environment machine learning are introduced. Finally, some prospects on the theoretical research trends of open-environment machine learning are provided.

机器学习是人工智能领域的重要分支, 其理论和方法是解决人工智能问题的关键基础之一.近年来在大数据、云计算、硬件加速等新方法新技术以及经济社会发展重大需求的共同驱动下, 机器学习研究发展进入新阶段.尤其是迅速发展的深度学习、强化学习等方法, 在计算机视觉、语音识别、自然语言处理、博弈决策等智能感知和决策问题上都展现出超过传统方法的性能, 甚至超过人类水平[1].

尽管取得巨大成功, 但当前机器学习技术通常依赖于封闭环境假设, 即假定学习过程中涉及的诸多要素(类别集合、特征分布等)保持不变.然而, 实际学习任务面临的环境往往是开放的, 各种学习要素, 如类别集合、数据分布、特征表示等, 可能会随时间发生变化, 容易导致传统封闭环境机器学习系统性能急剧下降[2].因此, 如何使机器学习方法适应开放环境成为新一代人工智能技术研究需要解决的关键问题之一.

根据机器学习的不同要素划分, 开放环境学习通常蕴含类别集合开放、数据分布漂移、特征空间可变、目标准则多样四个层面的特性[2].针对类别集合开放问题, 一类常用的解决方式是当学习任务类别信息不充分时, 在训练阶段采用开放类别集及拒识学习的思想, 在测试期间实现新类别检测和模型的持续更新[3, 4].针对数据分布漂移问题, 突破训练/测试数据非独立同分布假设的机器学习方法近年来得到广泛深入的研究, 包括结构化预测相关学习[5]、领域自适应迁移学习[6]、多任务元学习[7]、多模态学习[8]等多种范式.针对特征空间可变问题, 基于特征漂移及增量/减量变化的机器学习方法得到广泛研究和应用[9, 10].在学习准则方面, 采用不同的目标准则进行学习往往会得到各具优势的不同模型.封闭环境机器学习通常假设度量准则需要预先指定且学习过程中始终保持不变.与之不同, 开放环境机器学习的目标准则往往具有多样性和动态性的特点[11, 12].

在实际需求的推动下, 上述具备开放集检测、领域自适应、在线/持续更新、鲁棒对抗等开放环境自适应感知能力的学习范式已成为当前机器学习研究的新兴热点, 在计算机视觉、模式识别、自然语言处理、知识图谱等领域得到日益广泛的应用[13, 14, 15, 16].在人工智能和模式识别领域, 目前已有多篇关于开放环境机器学习方法与应用的综述性论文[2, 17, 18].

随着方法和应用研究的不断推进, 开放环境机器学习的基础理论研究也得到学者们日益广泛的关注.相比传统封闭环境机器学习, 面向开放环境的机器学习面临概念和类别集变化、数据分布漂移、特征动态更新、噪声干扰攻击等诸多开放性要素的影响, 为模型的泛化性能、优化效率、鲁棒性、效能度量等关键理论问题带来巨大挑战, 同时也出现重要的研究机遇.

近年来, 面向开放环境的机器学习基础理论研究已取得长足的进步, 产生较丰富的成果[19, 20, 21].尽管研究进展显著, 关于开放环境机器学习理论研究成果的综述性文献仍较少.因此, 本文聚焦开放环境机器学习基础理论与算法研究, 从泛化理论、优化理论、鲁棒性理论和效能度量准则等视角对相关重要研究进展进行梳理介绍, 探讨存在的关键问题, 并展望未来研究趋势.

机器学习的目的是通过训练集学到隐含在数据背后的统计规律, 使训练模型对服从同一规律的测试样本具有良好的预测性能, 也称为泛化性能.泛化理论是关于泛化性能保证的统计理论, 主要针对模型的期望风险、预测误差等泛化性能指标进行统计一致性分析, 是理解机器学习模型泛化能力的基础.经过多年的研究和发展, 传统面向经验风险最小化学习的泛化理论已形成一系列包括模型复杂度理论、间隔理论、PAC(Probably Approximately Correct) Bayes理论、算法稳定性理论等的经典理论体系[22].近年来, 针对类别集开放、特征分布可变、噪声冗余干扰等开放环境挑战的机器学习泛化理论也日益得到关注, 取得不少重要研究进展.

图1总结本节介绍的开放环境机器学习泛化理论研究方向.

| 图1 开放环境机器学习泛化理论研究方向Fig.1 Research directions of generalization theory of open environments machine learning |

在开放类别集情况下, 分类器模型需判断输入样本属于已知类别还是未知类别(未学习过的类别, 又称为异常类别)或异常噪声.为此, 学者们提出很多开放集分类和异常检测算法, 也出现一些理论分析的工作.Liu等[19]提出一种异常类别检测算法并分析PAC检测率上界.基于PAC泛化理论框架, Fang等[20]提出若干开放类别集学习的可泛化性充分及必要条件.针对开放类别领域自适应问题, Fang等[23]提出一类开放集差异正则化模型, 并分析其泛化误差上界.针对开放集学习固有的训练-测试分布漂移问题, 研究表明通过构建包含未知类别信息的增广域, 可采用已有的迁移学习泛化理论分析开放集学习的泛化误差[24].

在类别信息不充分时, 另一类常用的学习方式是在训练阶段引入拒识类别选项[25], 从而允许在测试期间实现新类别检测和更新.现已开展带类别拒识选项的机器学习泛化理论的研究[26, 27]主要用于刻画拒识选项对分布内期望风险的影响.在半监督转导学习框架下, PQ model[21]同时训练分类函数和选择可信特征区域, 当测试样本在选择的特征空间内时进行类别预测, 当测试样本不在选择的特征空间内时则拒识.可证明PQ model具有紧致的泛化误差与拒识率上界保证.

当前开放类别集分类与异常检测的泛化理论研究多集中在传统一致收敛性分析框架下, 基于间隔理论、算法稳定性、PAC-Bayes等多种理论框架的开放类别集学习算法泛化分析是值得进一步探索研究的方向.泛化性能下界分析也是理解开放类别集学习性能理论极限的重要基础问题之一, 有待开展更深入的研究.

对先验知识进行整合与迁移是人类学习的一项重要特征, 它使人类能通过少量样本学习快速准确地实现新任务的良好泛化.受这一机理的启发, 迁移学习、元学习及多任务学习等学习范式利用历史任务积累的先验知识加速新任务的学习, 不需要从头开始重新训练, 能更好地反映人类的学习过程.

利用先验知识学习实现领域自适应迁移是开放环境机器学习的重要研究方向之一[28].在得到广泛应用的同时, 迁移学习方法的泛化理论也得到深入研究.作为早期代表性理论成果之一, Baxter[29]研究一类迁移表示学习模型, 假设训练任务共享特征表示并服从相同的环境分布, 进而给出迁移泛化上界.以经验过程理论为工具, Maurer等[30]建立一类通用、强大的泛化理论分析框架, 用于证明迁移学习的泛化上界.Maurer等[31]建立基于线性特征表示学习的迁移学习样本复杂度上界.针对神经网络表示学习模型, Tripuraneni等[32]提出任务多样性的概念, 分析结果揭示任务内部样本大小对多任务迁移表示学习泛化性能的影响.该理论可进一步推广到广义非线性迁移表示学习的泛化分析[33].

与迁移学习侧重模型参数共享有所不同, 元学习更关注算法先验信息(如优化算法初始化值、学习率等)的提取, 从而能“ 学会” 在未来任务中实现快速学习[28].采用算法稳定性理论工具, Maurer[34]建立通用的多任务元学习泛化理论, 揭示任务规模对泛化性能的影响.作为一类重要的元学习方法, 基于优化(如随机梯度下降等)的元学习近年来得到广泛研究[35].根据任务独立同分布假设, 基于随机优化、算法稳定性、压缩感知等相关理论, 这类方法的泛化性能保证已得到研究[36, 37, 38].

经过多年的发展, 迁移学习和元学习的泛化理论研究取得较丰富的成果.针对开放环境跨模态、跨领域学习等应用场景, 需进一步研究揭示数据分布、优化算法、网络结构等要素与迁移学习/元学习泛化能力的内在机理联系.此外, 如何将相关理论和方法推广到开放类别集学习的泛化分析中是值得更深入研究的方向.

近年来, 随着科学研究和工业应用等开放环境中数据规模的爆炸式增长, 特别是图像、文本、深度神经网络等高维数据和模型的普及, 概率统计和机器学习研究面临巨大挑战:传统面向低维数据的统计学习理论与方法难以高效推广适用于高维数据的分析与计算.因此如何构建面向高维数据分析的鲁棒高效统计学习理论与方法, 是当前机器学习需要解决的重要科学问题.

稀疏学习[39]利用稀疏结构先验信息对高维数据建模, 能自动发现潜在的、对解释观测数据有意义的决策变量, 大幅提升模型估计的准确性和可泛化性[40].高维稀疏学习理论和方法已在开放类别集识别、异常类别检测、鲁棒特征选择等开放环境自适应感知学习任务中得到广泛研究和应用[41, 42, 43].从稀疏诱导正则化/约束项的数学性质上看, 稀疏学习通常可分为凸稀疏模型(如采用l1-范数正则化等)[44]和非凸稀疏模型(如采用l0-伪范数约束等)[45].稀疏学习模型的统计泛化理论涵盖预测误差和期望风险等方面, 相关研究近年来取得较多的进展.

在凸稀疏学习方面, van de Geer S A[46]分析面向广义线性模型的l1正则化稀疏学习方法溢出风险上界.Maurer等[47]研究一类具有结构化稀疏约束的线性预测风险最小化算法, 建立与数据相关的泛化误差上界.针对非凸稀疏学习模型, Chen等[43]分析稀疏约束二值分类模型的稀疏溢出风险上界.

迭代阈值追踪是一类经典的求解非凸NP难稀疏优化模型的逼近优化算法.统计理论分析表明这类算法具有多项式时间稀疏优化方法最优的均方预测误差上界[48].基于算法稳定性理论, 近期研究进一步分析迭代阈值追踪算法的稀疏溢出风险上界, 并证明相关上界具有极小极大理论最优收敛速率[49, 50].

当前稀疏学习泛化理论研究主要针对凸损失函数的情形开展.如何面向深度神经网络等非凸学习模型研究稀疏性与泛化性之间的统计量化关系是需要进一步研究突破的挑战性问题之一.同时, 非凸稀疏学习的泛化性能下界分析也是值得深入研究的基础理论问题之一.

模型优化是机器学习的重要组成部分.开放环境机器学习往往面临样本规模较大、数据动态更新、分布多源异构等挑战, 对优化算法的精确性和高效性提出更高的要求, 也促进机器学习优化理论的发展.针对大样本和高维度机器学习问题, 通常采用随机优化和稀疏优化等方式, 提升模型的训练效率和泛化性能[45, 51].针对数据流计算和属性动态更新等问题, 通常采用在线和持续优化策略实现模型随时间的序贯学习[52].针对数据多任务协同和多源异构等问题, 采用分布式和联邦优化等方式, 可大幅提升模型的优化效率及数据信息隐私保护能力.

图2总结本节介绍的开放环境机器学习优化理论研究方向.

| 图2 开放环境机器学习优化理论研究方向Fig.2 Research directions of optimization theory of open-environment machine learning |

随机优化通过在小批量随机样本上计算损失函数的一阶或高阶信息以更新模型参数, 具有迭代效率较高、样本复杂度较小等优点.作为一阶随机优化方法, 随机梯度下降(Stochastic Gradient Descent, SGD)广泛应用于求解期望风险最小化问题, 成为深度学习的标准优化算法之一[53], 其复杂度与泛化性能已得到广泛研究[54, 55, 56].SGD根据损失函数的一阶信息进行参数更新, 迭代鲁棒性往往显著依赖于学习率的选择[57].针对这一问题, 近年来学者们提出一系列利用损失函数的高阶信息的方法, 包括隐式随机梯度优化[58]、随机模型优化[57]、方差缩减随机近邻点优化[59]等方法, 相关理论分析表明利用高阶信息可提升随机优化的迭代稳定性和自适应性.

针对高维数据分析, 通常采用稀疏学习提升模型的泛化能力和鲁棒性.从数学模型上看, 稀疏学习通常表达为参数规模约束下的经验风险最小化问题, 是典型的非凸和NP难组合优化问题.

作为一类经典的凸松弛逼近方式, 凸稀疏诱导范数(如l1-范数等)正则化模型广泛应用于构建稀疏学习目标函数[39].针对这类凸稀疏优化模型, 学者们已提出一系列高效的优化算法, 包括近邻梯度下降算法[60]、近邻牛顿方法[61]、对偶随机优化方法[62]等.非凸优化稀疏学习模型通常采用l0稀疏度约束或非凸稀疏诱导伪范数正则化进行稀疏建模[63, 64].基于l0稀疏度约束的非凸稀疏优化理论研究现已取得不少成果, 涵盖一阶最优性条件[65]、局部渐进收敛理论[66]、对偶稀疏优化理论[67]等, 相关算法的计算复杂度对比研究可参考文献[67].

在优化计算效率得到充分研究的同时, 随机优化算法的泛化性能分析是值得深入研究的方向之一, 有助于解释其在实际深度学习应用中表现的优异泛化性能.如何将随机优化和稀疏学习结合以提升高维统计学习模型的优化效率也是需要进一步研究的问题.

开放环境应用中的数据往往随时间的累积, 形成数据流, 具有规模较大、变化较快的特性, 导致传统批量学习模式难以在有限时间内收集所有数据进行模型训练和部署.在线学习能通过在线吞吐的方式从数据流中实时学习, 适应动态流数据带来的数据随时间不断积聚的环境, 提高学习效率.在线学习通常建模为遗憾优化问题, 其目标是最小化学习器累计损失与最优模型损失之间的差值.经典的感知机模型[68]本质就是一种简单的在线分类算法.Zinkevich[69]将感知机的错误率分析方法推广到一般凸损失函数, 建立在线机器学习凸优化理论.Freund等[70]提出Hedge(β ), 是一类常用的在线动态分配算法, 可用于求解非凸随机在线优化问题.如果在线获取的样本服从独立同分布假设, 那么在线学习理论可用于分析相应的随机优化问题的泛化性能[71].

在静态封闭环境下, 遗憾的计算通常跟一个固定的最优模型进行对比.然而在动态开放环境下, 最优模型往往会随时间变化.为了更好地反映动态环境下的在线学习效果, 学者们现已提出一系列基于动态自适应遗憾定义的在线优化理论与方法[72].在线学习通常考虑学习器可观测到损失函数的完整信息.如果学习器只能观测到损失函数在当前决策上的数值, 属于赌博机在线学习的范畴[73].在线学习优化算法的计算复杂度理论综述可参考文献[74].

持续学习(或终身学习)是一类从任务流中不断学习新知识, 同时尽量保留已学知识的多任务增量学习范式[75], 可视为传统多任务或元学习模型的在线推广.在持续学习训练过程中, 一系列学习任务按顺序到达, 只有当前任务的数据可用于模型更新.持续学习往往需要考虑任务之间的关联性以克服灾难遗忘和负迁移等现象[76].

根据任务内样本的获取方式, 持续学习可大致分为两种方式:1)在线批处理方式, 假设每个任务开始时所有训练样本都可用[77]; 2)完全在线方式, 任务及其样本都序贯到达, 因此在每轮迭代中都只能获取和处理来自当前任务的当前样本[78].

持续学习通常采用任务相关的动态遗憾作为优化目标.常用的在线优化算法如FTL (Follow The Leader)和在线梯度下降等都可自然推广应用到持续学习优化问题中[79].

针对开放环境任务标签未知和任务边界定义不明确等特点, 在线和持续无监督学习是未来重要的研究方向之一, 其高效优化算法值得进一步研究.如何从优化算法方面保证持续学习稳定性与可塑性的平衡也有待深入研究.

随着数据规模的急剧增加, 单一机器的存储和计算能力往往无法做到独自完成数据的存储和机器学习模型的训练.另一方面, 数据采集设备的分散配置和数据保密也客观上要求使用分布式存储和计算以及时处理数据和保护隐私.因此, 分布式机器学习的主要目标就是当数据存储在多台计算机的情况下, 将模型训练任务分解到每台计算机上, 设计合理的节点间信息, 交互计算, 得到全局最优模型[80].Boyd等[81]详细阐述ADMM(Alternating Direction Method of Multipliers)的分布式优化算法理论, 并探讨其在非凸分布式优化问题中的应用.针对损失函数自洽的经验风险最小化问题, Zhang等[82]提出分布式非精确阻尼牛顿算法, 分析训练样本数、条件数等因素对其收敛性的影响.在条件数较小的优化问题上, 分布式随机梯度方差缩减方法可证明具有一阶分布式优化算法的理论最优通信复杂度[83].

联邦学习(Federated Learning)是近年来新兴的面向远程终端(如智能手机、物联网或代理)的分布式学习范式.2016年, Google首次提出联邦学习的概念, 并提出FedAvg(Federated Averaging)这一经典的联邦优化算法[84].相比传统的分布式学习, 联邦学习往往具有网络终端数量庞大、跨设备数据非独立同分布、计算节点动态更新等数据和系统层面的异构性特点, 为联邦学习的优化算法[85]设计和收敛理论分析带来巨大的挑战.

针对异构联邦学习问题, Li等[85]提出FedProx, 在FedAvg的基础上添加近邻正则项, 减小局部模型之间的差异.Yuan等[86]揭示FedProx对计算节点数据非独立同分布和随机参与计算的自适应性, 并进一步提出基于局部随机模型优化的改进算法— — FedMSPP, 显著提升海量数据情形下的优化效率.Chen等[87]提出FedMeta(Federated Meta-Lear-ning), 将每位客户端视为一个任务, 旨在训练一个初始化良好的模型, 可实现对新任务的快速适应.Zhu等[88]提出FedGen(Federated Distillation via Generative Learning), 是一类基于无数据知识蒸馏的联邦优化算法, 可在不需要任何外部数据的情况下实现高效的知识蒸馏, 解决用户异构性问题, 提高泛化性能.

异构联邦学习系统中用户本地的数据分布会随用户所在地及用户偏好而变动, 反映在模型性能上的现象就是局部模型与全局模型之间往往存在较大差异.个性化联邦学习技术尝试解决这一挑战问题.Per-FedAvg(Personalized FedAvg)[89]将模型无关元学习应用于个性化联邦学习, 目标是找到一个全局共享的初始模型, 在其基础上当前用户或新用户通过对本地数据执行少量梯度下降微调, 可快速实现局部模型寻优.pFedMe(Personalized Federated Learning)[90]从全局模型学习中分解个性化模型优化, 可采用类似于 FedAvg的随机梯度下降方法更新全局模型, 并能根据每个客户端的本地数据分布并行优化个性化模型.Ditto[91]采用多任务学习机制, 可同时提升个性化联邦学习的公平性和鲁棒性.

表1对比上述若干代表性联邦学习优化算法的通信复杂度, 以及相关理论分析对局部个性化建模、计算节点随机参与和非光滑损失函数等方面的适用性.

| 表1 异构联邦学习优化算法性能对比 Table 1 Performance comparison of heterogeneous federated learning optimization algorithms |

在复杂开放应用场景下, 受数据分布异构和用户不可控性等因素的影响, 联邦学习算法的泛化性能、优化效率和鲁棒性不如传统分布式学习, 因此需要研究更稳定、高效、鲁棒的异构联邦优化算法, 更好地实现全局模型和局部模型的协同优化.此外, 通过差分隐私等机制提升异构联邦学习的数据隐私保护能力也是值得研究的重要方向.

表2提供本节介绍的一些开放环境机器学习优化理论与算法的代码实现链接, 包括基于模型的随机优化、迭代阈值追踪稀疏优化、深度神经网络持续学习、异构联邦学习、个性化联邦学习等.这些共享的算法包可用于相关开放环境优化理论的验证, 并有利于进一步设计和实现面向开放环境的新型机器学习优化算法.

| 表2 开放环境机器学习优化方法的相关资源 Table 2 Corresponding resources for open-environment machine learning optimization methods |

实际开放环境下的数据往往含有较多的噪声干扰, 要求模型性能对噪声干扰不敏感, 即具有鲁棒性.一方面, 测试样本可能被噪声污染, 如会遇到人为设计的对抗样本或是由于环境(如天气等)的改变带来的随机噪声.另一方面, 收集的训练样本可能受到恶意污染, 如数据投毒和后门攻击, 这会导致训练得到的模型性能很差.

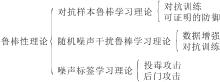

针对这些在开放环境下可能遇到的干扰和攻击问题, 学者们提出不少提高机器学习鲁棒性的理论与方法.图3总结本节介绍的开放环境机器学习鲁棒性理论研究方向.

| 图3 开放环境机器学习鲁棒性理论研究方向Fig.3 Research directions of robustness theory study of open-environment machine learning |

Goodfellow等[92]提出对抗样本的概念, 是指在模型的测试阶段对测试样本加入微小的扰动生成的样本, 会导致模型将本可正确识别的样本识别错误.Biggio等[93]总结早期对抗样本和对抗学习的问题和方法.当前, 为了提升模型应对对抗样本的鲁棒性, 通常采用对抗训练的方式进行学习[94], 即在训练过程中生成训练样本的对抗样本, 然后最小化模型在对抗样本上的风险, 也称为最小化对抗风险.

在广泛应用的同时, 对抗训练也存在一些局限性问题.Wong等[95]发现对抗训练存在明显的过拟合, 即训练集和测试集的对抗风险差距显著.Wu等[96]提出基于对抗性权重扰动的方法, 缓解这一过拟合现象.随后, Pang等[97]发现训练参数的设定对对抗鲁棒性影响较大, 并提出一套训练指南.

提升模型对抗鲁棒性的另一类主流方式是可证明的防御.Cohen等[98]提出可证明的鲁棒防御, 采用Random Smoothing技术, 推导已训练好的模型的鲁棒半径下界.Zhang等[99]从模型结构本身出发, 设计SortNet, 在不需要对抗训练的情况下也具有较好的鲁棒性.Cheng等[100]发现在较小方差的方向如果添加扰动将会更明显地影响模型的决策结果, 因此提出分布正则化的方法, 让各方向的方差尽可能一致, 可显著提升对抗学习的鲁棒性.根据对抗样本不是缺陷而是特征及卷积神经网络相对人眼更关注高频信息的思想, Li等[101]提出频域攻击和对抗训练算法.此外, 近年来也出现一些基于对抗性净化的方法, 主要思想是通过预处理去除图像中的对抗性扰动[102].

对抗鲁棒性是机器学习理论中一个重要的基础性问题, 如何设计一个更加对抗鲁棒的机器学习模型是未来一个值得研究的方向.此外, 如今的大语言模型也已在实验上证实缺乏对抗鲁棒性, 通过人为设计特殊的提示词, 可让其输出失去意义, 如何提高大语言模型的对抗鲁棒性也是未来值得考虑的一个问题.

相比对抗样本, 随机噪声是模型在测试阶段遇到的一类较温和的噪声.Hendrycks等[103]提出这类问题的评价框架和数据集, 定义15种常见的噪声类型, 每个噪声类型设置5种强度.随后, Hendrycks等[104]提出Augmix, 可明显提升随机噪声下的鲁棒性.在Augmix的基础上, Wang等[105]提出AugMax.除了数据增强, 对抗训练也能明显提升应对随机噪声的鲁棒性.尽管对抗训练的初衷是提高模型的对抗鲁棒性, 但是近来被发现也有利于其它情况的鲁棒性.Kireev等[106]在标准的对抗训练基础上, 引入LPIPS(Learned Perceptual Image Patch Similarity)度量和凸松弛, 提出RLAT(Relaxed LPIPS Adversa-rial Training), 与Augmix结合, 取得较优效果.

随着随机噪声和对抗样本之间研究的关联逐渐增强, 研究者也探究两者之间的理论联系, Ford等[107]在理论上证明:在小幅度扰动范围内的对抗训练等价于对模型进行高斯噪声数据增广.近期研究开始关注介于对抗鲁棒性和随机噪声鲁棒性之间的鲁棒性.Rice等[108]将这两种鲁棒性统一建模成扰动空间中的q-范数形式, 其中q=1表示随机噪声鲁棒性, 而q=表示对抗鲁棒性, 中间的取值表示介于两者之间的鲁棒性.Robey等[109]将这一问题统一建模成概率鲁棒学习问题, 可以以一定概率正确分类被扰动的样本, 达到两种鲁棒性的中间状态, 通过控制这个分类正确的概率, 可控制两种鲁棒性之间的权衡.

随机噪声是机器学习模型在日常环境中容易遇到的问题之一, 考虑到随机噪声形式的多种多样, 如何应对一些更普适的噪声类型是未来的一个重要研究方向.此外, 现在常用的基于启发式数据增强的算法会较明显地增加训练时间和存储空间, 如何设计一些更节约时间、空间的算法也是一个值得关注的问题.

对训练数据进行人为污染是导致机器学习模型性能异常的一类重要因素, 近年来引起广泛关注.常见的数据污染方式包括两种:1)投毒攻击.攻击者通过精心设计, 污染训练集, 导致训练得到的模型泛化性较差.2)后门攻击.在训练集上加入特殊的触发标记, 在测试时一旦遇到带有特殊标记的样本, 识别为某种特殊的类别.Biggio等[110]在SVM(Support Vec-tor Machine)上实现数据投毒, 通过对训练数据进行扰动, 导致训练的SVM准确率大幅降低.进入深度学习时代以来, 在监督学习任务上, Fowl等[111]提出的对抗数据投毒是目前最有效的方法之一.通过在训练数据上加入类别相关的对抗性扰动, 带来的特征往往较容易学习, 从而导致训练得到的模型泛化性较差.Carlini[112]将文献[111]方法推广到半监督学习上, 对其中的无标记数据进行投毒操作, 降低模型泛化性能.He等[113]进一步将数据投毒推广到自监督对比学习.在应对数据投毒上, Tao等[114]提出可使用对抗训练应对数据投毒, 从理论上证明对抗训练可让模型重新学习到被投毒的数据中的鲁棒特征, 这是目前最有效的防御方法之一.

多模态模型近年来得到较多的关注, 训练多模态模型往往需要在互联网上爬取大量数据, Carlini等[115]发现, 如果在这些被爬取的训练数据上加入后门攻击, 可让测试集的某些样本被识别为特定类别, 即多模态模型对于后门攻击缺乏鲁棒性.

在防御后门攻击方面, Hayase等[116]提出SPECTRE(Spectral Poison Excision through Robust Estimation), 使用PCA(Principal Component Analy-sis)分析数据的统计特性, 可剔除训练集上统计特性异常的数据.

与对抗攻击不同, 数据投毒关注训练数据被污染的问题.如今广受关注的大语言模型需要在网络上爬取数据进行训练或微调, 这些数据可能经过投毒攻击, 导致得到的模型性能较差.因此, 如何提高大语言模型应对投毒攻击的防御能力, 是今后一个较值得关注的问题.

表3提供本节介绍的一些开放环境鲁棒学习理论与方法的代码实现链接, 包括对抗训练、可证明防御、数据增强、投毒攻击与防御等.这些共享的算法软件包有利于相关理论的实际验证以及更高效地设计和实现新型开放环境鲁棒学习模型与方法.

| 表3 开放环境鲁棒学习方法相关资源 Table 3 Corresponding resources for open-environment robust learning methods |

机器学习模型的评价准则是评估其泛化性、复杂度、鲁棒性等性能的量化指标.针对分类任务, 可采用准确率、F1分数、ROC(Receiver Operating Cha-racteristic Curve)曲线下方面积(Area Under Curve, AUC)等作为预测性能评估准则.针对回归任务, 可采用平均绝对误差、均方误差等作为预测性能评估准则.机器学习评价准则是构建训练目标函数的重要基础和依据.针对开放环境机器学习的效能度量问题, 近年来, 学者们也提出不少新颖有效的度量准则.作为开放类别集学习的开创性工作之一, Scheirer等[117]提出开放空间风险作为优化准则, 当样本远离训练样本时会增加其来自未知类别的风险.EVM(Extreme Value Machine)[118]采用一种受统计极值理论(Extreme Value Theory, EVT)启发的识别准则, 能实现非线性无核可变带宽增量学习.针对开放类别集学习的PAC泛化性能分析问题, Fang等[23]采用分布内和分布外期望风险的加权平均定义α -风险函数, 作为开放类别集学习的泛化性能评价指标.针对带拒识选项的分类问题, Hu等[119]提出一类基于信息理论的度量准则函数, 评估其分类与拒识性能.针对动态环境下的在线学习问题, 学者们提出一系列动态和自适应的遗憾定义作为在线学习性能评估准则[72].

除了预测风险和遗憾等性能评价指标外, 模型及训练算法的复杂度、可解释性、鲁棒性等也是开放环境机器学习重要的效能度量准则.针对梯度优化元学习模型的任务过拟合问题, Tian等[38]在传统期望风险目标函数中引入模型参数稀疏度约束, 显著降低模型的复杂度并提升少样本元学习的泛化性能.针对跨域少样本分类问题, Ji等[120]提出基于模型稀疏约束和源域近邻正则化的经验风险损失函数, 提升目标域模型的泛化性能.针对自监督对比学习中的自标记语义不明确问题, Zhou等[121]研究精细化自标记方法, 用于提升对比学习自标记的语义区分度和鲁棒泛化性能.针对噪声标签学习问题, Li等[122]提出基于动态敏感损失的分类器, 能在训练前期更关注困难样本, 杜绝欠拟合问题, 而后逐渐提高对简单样本的关注程度, 从而杜绝模型过拟合标签噪声.在随机优化算法的鲁棒性方面, Yuan等[123]表明通过充分利用损失函数的高阶信息, 相比传统随机梯度下降算法, 随机模型优化算法具有更优的迭代稳定性和鲁棒性.

相比传统机器学习通常采用的经验风险最小化框架, 开放环境机器学习在尽量保证预测精度的同时需要考虑分布外检测、类别集合开放、噪声标签、模型复杂度等多种因素, 如何设计更通用、安全并实际可行的开放环境效能度量准则是需要进一步研究的关键问题.

相比传统封闭环境机器学习, 开放环境机器学习面临类别集合、数据分布、特征表达、评价准则等诸多要素动态可变的挑战, 为统计理论和优化算法研究带来巨大挑战, 同时也提供重要的研究机遇.本文主要从泛化、优化、鲁棒性及效能度量等关键理论视角梳理介绍开放环境机器学习理论研究近期取得的一些重要进展, 探讨存在的关键问题, 并展望进一步的研究方向.总之, 开放环境机器学习理论研究尚处于初步发展阶段, 在理论完备性、分析紧致性、计算可扩展性和模型可解释性等方面还有诸多基础性科学问题有待进一步探索和解决.同时, 现有开放环境机器学习理论方法的研究多体现在计算机视觉、自然语言处理、智能机器人等人工智能领域, 在人工智能其它应用领域及与科学交叉(AI for Science)等新兴领域方面的关注仍相对较少.因此, 拓展开放环境机器学习方法在自然科学领域(如物理、化学、大气科学、生命科学等)的学科交叉新理论与新应用研究是值得深入探索的前沿发展方向.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|

| [43] |

|

| [44] |

|

| [45] |

|

| [46] |

|

| [47] |

|

| [48] |

|

| [49] |

|

| [50] |

|

| [51] |

|

| [52] |

|

| [53] |

|

| [54] |

|

| [55] |

|

| [56] |

|

| [57] |

|

| [58] |

|

| [59] |

|

| [60] |

|

| [61] |

|

| [62] |

|

| [63] |

|

| [64] |

|

| [65] |

|

| [66] |

|

| [67] |

|

| [68] |

|

| [69] |

|

| [70] |

|

| [71] |

|

| [72] |

|

| [73] |

|

| [74] |

|

| [75] |

|

| [76] |

|

| [77] |

|

| [78] |

|

| [79] |

|

| [80] |

|

| [81] |

|

| [82] |

|

| [83] |

|

| [84] |

|

| [85] |

|

| [86] |

|

| [87] |

|

| [88] |

|

| [89] |

|

| [90] |

|

| [91] |

|

| [92] |

|

| [93] |

|

| [94] |

|

| [95] |

|

| [96] |

|

| [97] |

|

| [98] |

|

| [99] |

|

| [100] |

|

| [101] |

|

| [102] |

|

| [103] |

|

| [104] |

|

| [105] |

|

| [106] |

|

| [107] |

|

| [108] |

|

| [109] |

|

| [110] |

|

| [111] |

|

| [112] |

|

| [113] |

|

| [114] |

|

| [115] |

|

| [116] |

|

| [117] |

|

| [118] |

|

| [119] |

|

| [120] |

|

| [121] |

|

| [122] |

|

| [123] |

|