张桂梅,博士,教授,主要研究方向为计算机视觉、图像处理、模式识别.E-mail:guimei.zh@163.com.

作者简介:

侯冰震,硕士研究生,主要研究方向为计算机视觉、图像处理、模式识别.E-mail:hbz169678@163.com.

彭昆, 硕士研究生,主要研究方向为计算机视觉、图像处理、模式识别.E-mail:13077968561@163.com.

针对肾肿瘤图像分割中的边界模糊和特征丢失问题,在RAUNet(Residual Attention U-Net)的基础上,提出基于不确定性引导和尺度一致性的肾肿瘤图像分割方法.针对肾肿瘤图像边界模糊问题,在解码层引入不确定性引导模块,根据不确定性自适应分配权重,弱化错误像素点的影响,提高模型的边界定位能力.针对下采样引起的特征丢失问题,提出尺度注意力模块和特征一致性损失,利用多尺度融合策略融合不同尺度特征,并与编码器底部特征进行尺度一致性约束,缓解特征丢失问题.在公开数据集KiTS19上的肾脏和肾肿瘤的图像分割实验表明,文中方法提高肾肿瘤的分割精度.此外,由于文中方法引入不确定性引导模块,分割结果具有较好的可靠性.

ZHANG Guimei, Ph.D., professor. Her research interests include computer vision, image processing and pattern recognition.

About Author:

HOU Bingzhen,master student. His research interests include computer vision, image processing and pattern recognition.

PENG Kun, master student. His research interests include computer vision, image processing and pattern recognition.

ing at the problems of boundary blurring and feature loss in kidney tumor image segmentation, a kidney tumor image segmentation method based on uncertainty guidance and scale consistency is proposed on the basis of residual attention U-net model. For blurred boundaries of kidney tumor images, an uncertainty guidance module is introduced into the decoding layer to allocate weights adaptively based on uncertainty. Thus, the effect of wrong pixels is reduced and the boundary localization ability of the model is improved. For the problem of feature loss caused by down-sampling, the scale attention module and feature consistency loss are proposed. The multi-scale fusion strategy is utilized to fuse features of different scales, and the scale consistency constraint is conducted with the features at the bottom of the encoder to alleviate the problem of feature loss. Finally, experiments of kidney and kidney tumor segmentation on the public dataset KiTS19 demonstrate that the proposed segmentation method greatly improves the segmentation accuracy. In addition, the segmentation results of the proposed method hold better reliability due to the uncertainty guidance module.

医学图像分割是医学图像自动分析的重要研究内容之一, 旨在减轻医生负担、辅助医生诊疗.传统的医学图像分割方法耗时、费力、不可重复, 研究自动分割方法是解决上述问题的关键.

相比传统的机器学习算法, 基于深度学习的方法无需人工引导, 在实现自动分割的同时, 分割精度也超越传统算法.目前通用的医学图像分割算法也取得较好的分割效果[1, 2].Ronneberger等[3]提出U-Net, 设计对称编解码结构, 融合浅层特征与深层特征, 有效利用浅层特征的位置信息, 大幅提升医学图像的分割性能.Zhou等[4]提出U-Net++, 在U-Net的基础上融合不同层的特征, 弥补跳跃连接时产生的语义鸿沟和信息丢失, 在cell nuclei、colon polyp数据集上的分割效果较优.此外, U-Net++还采用剪枝方法, 大幅减少模型参数量.He等[5]提出ResNet(Residual Network), 较好地缓解因网络过深而导致的梯度消失或梯度爆炸问题.Zhao等[6]提出PSPNet(Pyramid Scene Parsing Network), 设计空间金字塔模块, 聚合不同区域的上下文信息, 提高网络获取全局信息的能力, 在一定程度上缓解卷积过程中感受野受限的问题.

上述方法分别从融合特征、加深网络深度和增大感受野方面提升图像分割效果, 但仍存在边界细节分割不理想、下采样导致的小目标丢失和引入过多冗余信息等问题.

针对上述问题, 学者们将注意力机制和多尺度融合策略添加到通用网络中, 缓解边界细节分割不理想及特征丢失的问题.Ni等[7]提出RAUNet(Residual Attention U-Net), 在跳跃连接中引入AAM(Augmented Attention Module), 同时捕获高层的语义信息和低层的位置信息, 并有效减少跳跃连接中的冗余信息.Fan等[8]提出PraNet(Parallel Reverse Attention Network), 聚合高级特征, 生成特征指导图, 基于特征指导图, 并结合反向注意力模块, 从低级特征中提取边界细节, 在ETIS、CVC-ClinicDB等5个数据集上验证PraNet的有效性.Wang等[9]提出Non-local U-Nets, Non-local模块[10]应用到婴儿脑部MR(Magnetic Resonance)多模态图像分割中, 提出基于Non-local的Global Aggregation Block, 解决编码器无法整合全局信息的问题.Jha等[11]改进U-Net, 提出ResUNet++, 加入ASPP(Atrous Spatial Pyramid Pooling)[12]、SE(Squeeze-and-Excitation)[13]及残差连接, 实验表明ResUNet++在Kvasir-SEG数据集上表现出较好的分割性能.Gu等[14]提出CA-Net(Comprehensive Attention-Based Convolutional Neural Network), 设计综合的注意力与多尺度融合策略, 使网络同时关注通道、空间信息和尺度信息, 从多个角度突出前景区域, 在ISIC2018、Fetal MRI数据集上的分割实验中取得较优结果.Feng等[15]提出CPFNet(Context Pyramid Fusion Network), 实现多尺度上下文信息的多层次融合, CPFNet在皮肤癌、视网膜条纹损伤等多个数据集上均取得较优的分割结果.Dai等[16]提出Ms RED(Multi-scale Residual Encoding and Decoding Network), 自适应地融合多尺度特征, 较好地分割皮肤的病变区域.

上述方法趋向于对图像分割的通用性设计, 对于肾肿瘤图像分割, 近年来学者们也开展研究.Guo等[17]提出RAU-Net, 包括预处理、自动分割和后处理的操作, 较完整地实现对肾肿瘤端到端的自动分割.Causey等[18]提出串联两个U-Net模型的集成网络, 分割肾肿瘤, 从多个视角训练模型, 在后处理阶段消除虚假预测并填补肿瘤预测中缺失的内部区域.Ruan等[19]提出MB-FSGAN(Multi-branch Fea-ture Sharing Generative Adversarial Network), 利用多尺度特征提取器提取大小不同的目标, 较好地实现肾肿瘤的小目标分割.

虽然上述各种基于深度学习的肿瘤分割方法取得一定成效, 但是上述方法不能提供分割预测的可靠性信息, 而医学图像分割属于高风险应用场景.针对该问题, 学者们提出将不确定性引入医学图像分割模型中.不确定性计算的经典方法是使用蒙特卡洛dropout[20]进行不确定性估计, 具体操作是在训练时在每层卷积之前加入一个dropout, 在测试时打开dropout进行多次采样, 获得互不相同的预测值, 再计算某个样本的多次预测得分的方差和均值, 其中方差作为神经网络预测图中不确定的区域, 均值作为最终预测图.Li等[21]提出对图像进行裁剪重组, 利用数据增强, 生成不同的预测图, 计算方差, 得到不确定性.Luo等[22]提出URPC(Uncertainty Recti-fied Pyramid Consistency), 对解码器中的不同尺度进行预测, 求其均值, 对每层进行不确定性修正.Yu等[23]用蒙特卡罗dropout抽样估计方法进行不确定性估计, 并将不确定性估计应用到医学图像分割中.在不确定性估计的指导下, 计算不同模型间一致性损失时, 过滤不可靠(不确定性高)的预测, 保留可靠(不确定性低)的预测.Czolbe等[24]探索包括蒙特卡洛dropout在内的四种不同的不确定性估计方法, 并将其应用到医学图像中, 理论分析和实验结果均证明不确定性与分割错误正相关.

由于肾肿瘤的病变区域差异较大, 对于形状较小、边界不清晰的肿瘤图像分割, 上述方法仍存在如下问题:1)肿瘤细胞相对于器官占比较小, 在分割时容易丢失; 2)肿瘤细胞边界模糊且与周围组织结构较接近, 难以准确分割和定位; 3)深度学习类似黑箱模型, 预测结果具有一定的不确定性, 存在的不确定估计方法需要进行多次前向传播或使用额外监督的方法, 计算资源消耗较大.

针对上述问题, 本文设计基于不确定性引导和尺度一致性的肾肿瘤图像分割方法.针对肾肿瘤细胞的边界模糊问题, 引入不确定性引导模块(Uncer-tainty Guidance Module, UGM), 计算不确定性边界概率图, 并将其作为权重嵌入特征图中, 提高模型对肿瘤边界的定位能力和分割精度.针对肿瘤组织占比较小及下采样导致的信息丢失问题, 首先在编码器最后一层添加自注意力模块, 获取全局信息.在不同尺度的解码层使用尺度注意力模块(Scale Attention Module, SAM)融合不同层的信息.再对全局信息和融合信息施加一致性约束, 进一步提升网络的分割性能.提出不确定性估计方法, 分离确定性区域和不确定性区域, 赋予不确定性高的区域较小权重、不确定性低的区域较大权重, 使目标的分割结果具有较高的可靠性.

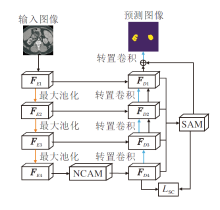

本文提出基于不确定性引导和尺度一致性的肾肿瘤图像分割方法, 结构如图1所示, 主要在编码和解码阶段之间引入非局部通道注意力模块(Non-local Channel Attention Module, NCAM)、在解码阶段引入尺度注意力模块(SAM)及不确定性引导模块(UGM).NCAM用于提取全局语义信息, 缓解卷积操作中感受野受限的问题.SAM用于融合解码层不同尺度的信息, 获得丰富的语义信息.UGM用于引导网络对不确定边界进行学习, 提高边界的定位精度, 提升网络对边界细节分割的精度.最后, 全局信息与融合后的信息进行尺度一致性损失(Scale Consistency Loss, SC Loss), 进一步提升方法分割性能.

如图1所示, 在网络左边输入肾脏图像, 右边为分割后的预测图像.本文方法是在RAUNet的基础上, 添加两个模块和一个损失函数, 而RAUNet是采用U型结构模型, 编码器的骨干网络为ResNet结构, 解码器采用转置卷积的上采样结构.本文采用在ImageNet上预训练好的ResNet34作为编码器的骨干网络, 经下采样获得不同层的编码特征FEi, i=1, 2, 3, 4, 在最后一层引入NCAM, 获得全局特征FD4.在网络结构图的右边为不同层的解码特征FDi, i=1, 2, 3, 4, 其中i=2, 3时, 解码层包括UGM及引入的AAM[7], i=1时, 解码层只包括增强注意力模块.

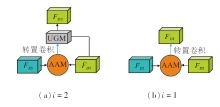

以i=2作为示例, 解码层的结构如图2(a)所示, i=3时的结构与其相同.(a)包含不确定模块和增强注意力模块, (b)为i=1时只包括增强注意力模块的部分.将不同解码层的解码特征经SAM融合后的特征与解码器FD1相加生成预测图.此外, 对全局特征FD4和经SAM融合后的特征求损失LSC, 计算SC Loss, 进一步提高网络的分割性能.

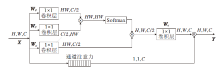

在卷积操作中, 卷积核的尺寸一般远小于特征图尺寸, 导致感受野受限而无法提取全局信息, 信息交互不够完善.针对该问题, 学者们提出多种增大感受野的方法[10, 25], 在一定程度上增大感受野, 但仍无法提取全局特征.受Wang等[10]提出的非局部注意力的启发, 利用自注意力方式, 对自身信息进行全局交互, 获得全局感受野, 提取全局信息.本文采用通道注意力和非局部注意力结合的方式.具体NCAM结构如图3所示.

非局部注意力旨在解决卷积中感受野受限的问题, 全局特征

X'=Wα (Softmax(XT

其中, Wθ 、Wψ 、WK均为经过1× 1卷积映射的权重矩阵, T为转置操作, Wα 为1× 1卷积操作, Softmax(· )为归一化函数操作.

由于深层次编码的特征维度较高, 直接计算会产生较大资源消耗.针对该问题, 学者们通常采取先降低维度的方法进行自注意力计算, 再通过1× 1卷积计算恢复到原来维度.由于在初始阶段采用降维操作会丢失重要特征, 针对该问题, 本文对特征进行通道注意力操作, 为每层通道赋予不同权重.同时将学习到的权重嵌入到非局部注意力中, 缓解非局部注意力中由于降维引起的重要特征丢失问题.经NCAM处理后的输出特征为:

Y=SE(X)X',

其中SE(· )为通道注意力操作.

本文将NCAM添加在编码器的最后一层的原因如下.1)在编码器阶段, 采用ResNet系列(如ResNet18, ResNet34, ResNet50, ResNet101等)作为编码器的骨干网络, 为了利用ImageNet上的预训练模型, 保留ResNet的原有结构.2)由于NCAM是以自注意力模型为基础, 多次实验表明, 如果在大尺度的特征图上使用, 会消耗过大的算力, 经过权衡, 将NCAM放入编码器最底端.

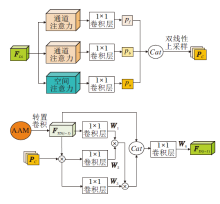

在解码阶段, 将不同尺度的特征进行融合, 目的是为了更好地利用不同尺度的特征信息.U-Net[3]和LinkNet[26]的融合操作是在编解码阶段的对应尺度的特征进行直接拼接或相加.近年来也出现一些不同尺度的融合策略[14, 15, 16, 27], 将不同尺度的特征融合后添加注意力, 使性能得到一定提升, 但上述操作增加计算量并产生大量冗余信息.针对该问题, 本文提出尺度注意力模块(SAM), 结构如图4所示, 在聚合多尺度信息的同时, 可减少冗余信息的产生.

SAM整个过程分为两种不同的池化操作.沿通道拼接后的特征为:

g(F)=Cat(pool1(FDi)),

其中, pool1(· )为通道间池化, Cat(· )为拼接操作, i为特征数量索引.沿水平方向拼接后的特征为:

l(F)=Cat(pool2(FDi)),

其中, pool2(· )为水平方向池化, Cat(· )为拼接操作, i为特征数量索引.

为了恢复特征图尺寸与增大像素值, 将拼接的特征矩阵与其自身矩阵的转置相乘, 获得具有显著性目标区域的特征图.最后将通道间池化融合后获得的特征权重分别赋予水平方向池化融合后得到的特征图, 获得不同权重的特征图:

FC=diag(g(F)(g(F))T)l(F)(l(F))T,

其中, diag(· )为求对角线矩阵, 目的是为了突出每层特征相对的重要程度, 取矩阵中相对最重要的对角线元素为通道权重, 忽略其它的相对权重, 最终得到全局通道的相对权重.

本文的融合方法与以往直接特征拼接方法的区别在于:采用池化后再融合的方法可大幅减少计算资源, 在背景复杂的医学图像上直接使用特征融合会降低分割性能, 使用本文方法也可减少噪声和冗余信息对分割性能的干扰.

在解码阶段, 由于降维使部分重要信息丢失, 针对该问题, 本文采用尺度一致性损失(SC Loss)对高维的特征信息进行再次利用, 可有效补充因降维丢失的部分信息.具体为:将SAM融合后的特征FC与经过NCAM处理后的全局特征FG进行一致性约束.由于FG与FC的大小不同, 为了便于一致性学习, 将FG进行尺度缩放至与FC的尺寸相同, 即

F'G=y(FG)∈ Rc× w× h, (1)

其中, y(· )为缩放函数, c× w× h为F'G的特征尺寸, c为通道数, w为宽度, h为高度.

为了突出神经元的重要性, 本文采取绝对值求和的方法激活神经元, 计算公式为

$\beta (x)=\text{ }{{\sum\limits_{i=1}^{c}{\left| {{x}_{i}} \right|}}^{2}}$ (2)

其中, xi为特征图, c为特征图的通道数, i为通道索引.

经式(1)处理后, 进行尺度一致性学习:

${{L}_{SC}}={{\sum\limits_{(i, j)}{\left\| \frac{M_{i}^{e}}{{{\left\| M_{i}^{e} \right\|}_{2}}}-\frac{M_{j}^{d}}{{{\left\| M_{j}^{d} \right\|}_{2}}} \right\|}}_{1}}$ (3)

其中,

Me=β (y(F'G)), Md=β (FC),

M

本文方法针对肾肿瘤图像的分割展开研究, 肾肿瘤图像分割的困难如下.1)由于肾肿瘤与周围组织的对比度差异较小, 相对于皮肤、息肉, 肾脏图像的边界更模糊, 分割起来更困难; 2)由于下采样过程导致特征图尺寸减少、边界信息丢失, 在上采样时, 难以准确恢复边界信息.

针对该问题, 本文引入不确定性引导模块(UGM), 引导边界分割, 因为UGM可对边界信息进行像素级分类, 降低因边界分割的不确定性而导致的边界误分割问题.具体操作如下.对解码阶段不同尺度肾肿瘤特征图使用sigmoid函数计算像素点的概率, 在后续的卷积学习中根据像素点概率的高低, 自适应地赋予特征图权重, 减少像素的误分类, 其中添加通道注意力与空间注意力使特征可自适应地聚焦目标区域的语义信息, 经过UGM将得到的前景、背景及不确定边界的概率图拼接后嵌入下一层特征中, 指导下一层特征边界的学习.通过给不确定性小(即把握性大)的边界信息分配较大的权重, 不确定性大(即把握性小)的边界信息分配较小的权重, 减少错误像素对边界分割的影响, 提高边界分割的准确率.

UGM结构如图5所示, 根据不同层的解码特征估计不确定性, 边界分别计算前景概率图pf、背景概率图pb和不确定性概率图pu:

pf=max(p-0.5, 0), pb=max(0.5-p, 0), pu=0.5-abs(p-0.5),

其中,

p=sigmoid(FDi),

为概率图, FDi为特征图, sigmoid(· )为激活函数, max(· )为最大值函数, abs(· )为绝对值函数.

在生成概率图之前, 对前景和背景施加通道注意力以保留语义信息, 对不确定图施加空间注意力[28]以保留边界信息.将不同的概率图进行拼接, 得到特征图Pc.将Pc嵌入下一层的解码特征中, 根据学习权重, 使其自适应地给予不确定性低的边界位置信息较大的权重, 以及不确定性高的边界较小的权重, 则

FD(i-1)=W4(Cat(W1FTD(i-1)W2(FTD(i-1)PC)· W3(FTD(i-1)PC), (FTD(i-1))),

其中,

FTD(i-1)=TransConv(FDi),

TransConv(· )为转置卷积, W1、W2、W3、W4均为1× 1卷积操作后获得的权重, Cat(· )为拼接操作, 并通过自注意力的方式恢复到原尺寸, 最终通过1× 1卷积获得包含丰富边界信息的特征图, 对下一层恢复特征时进行不确定信息的引导.

参考文献[22], 引入Dice Loss和CE Loss(Cross Entropy Loss):

LDice=1-

${{L}_{ce}}=-\sum\limits_{i=1}^{n}{p({{x}_{i}})}\log (q({{x}_{i}}))$ (5)

其中, smooth为平滑度系数.结合式(3)~式(5), 总损失

Ltotal=LDice+Lce+λ LSC,

其中, λ 为超参数, LSC为尺度一致性损失, LDice为Dice Loss, Lce为交叉熵损失.

本文实验中网络均使用Adam(Adaptive Mo-ment Estimation)优化器, 学习率初始化为0.001, 采用余弦函数调整学习率的变化, 最低学习率为0.000 001.为了提高网络的泛化性能, 先采用比例缩放、随机旋转和翻转等方法进行数据增强.为了提高训练效率, 将图像统一裁剪为384× 384大小.

实验均在Pytorch1.8框架下实现, 在搭载两张NVIDIA GeForce RTX 2080Ti GPU(11GB)的GPU上进行训练和测试.

根据多次实验结果可知, 对网络进行训练时, 均在60个迭代周期上达到收敛.

本文选择KiTS19数据集, 采用数据集上210个完整的腹部CT图像, 并包含肾脏(Kidney)和肾肿瘤(Kidney Tumor)的分割Ground Truth.训练集选取168幅图像, 测试集选取42幅图像.为了提高训练效率, 本文将图像进行切片处理, 切片厚度在1 mm至5 mm之间, 图像分辨率在轴向上的调整范围为0.4 mm至1 mm, 纵向视野范围从20至140.大多数肿瘤的体积在9.6 cm3至109.7 cm3之间.

在医学图像分割中, 通常采用Dice分数进行评价.在实验中对每个案例计算Dice分数, 求其均值作为最终结果.单个案例的Dice分数的损失函数为

Dice=

另外选择体积重叠误差(Volumetric Overlap Error, VOE)和相对体积偏差(Relative Volume Diffe-rence, RVD)作为评估指标, 函数如下:

$VOE=1-\frac{\left| X\cap Y \right|}{\left| X \right|+\left| Y \right|} \\ RVD=\frac{\left| X \right|-\left| Y \right|}{\left| Y \right|}$

其中, X为目标的预测值, Y为目标的真实值.VOE和RVD是误差的度量, 数值越小分割性能越优.Dice分数越大, 分割性能越优.

2.3.1 骨干网络选择实验

选择ResNet为基础网络, 在肾脏图像和肾肿瘤图像上进行多次实验, 选取本文的骨干网络, 结果如表1所示, 表中黑体数字表示最优值.

| 表1 不同骨干网络的实验结果 Table 1 Results of different backbone experiments |

由表1可知, 当选择ResNet18作为骨干网络时, 性能明显低于ResNet34作为骨干网络时的性能, Dice分数下降7.3%, 这是因为ResNet18太小, 特征提取能力不足, 无法充分挖掘数据集的潜力.当选择ResNet50和ResNet101作为骨干网络时, 相比ResNet34, Dice分数均有下降, 这是因为相比RestNet34, ResNet50和RestNet101参数增加, 提取特征能力变强, 但是由于网络模型变大而数据集未变大, 不能充分发挥网络性能, 出现拟合过度, 泛化性变差, 在测试时产生过拟合现象.经过多次实验均得到类似结果, 故本文选取ResNet34作为骨干网络.

2.3.2 对比实验

为了验证本文方法的有效性, 在KiTS19数据集上分别进行肾脏和肾肿瘤的图像分割对比实验, 选择如下对比方法:U-Net[3]、UNet++[4]、PSPNet[6]、RAUNet[7]、PraNet[8]、ResNet++[11]、CA-Net[14]、CPF-Net[15]、Ms RED[16]、RAU-Net[17]、文献[18]方法、RBCA-Net[29].

各方法的性能对比如表2所示, 表中黑体数字表示最优值.由表可知, 本文方法的Dice分数比U-Net提升7.2%, 并且VOE和RVD指标均有一定下降.相比U-Net, UNet++和PSPNet的分割性能下降, 这是因为UNet++和PSPNet均使用多尺度融合策略, 由于医学图像中背景与前景灰度接近且图像中存在一定噪声, 直接融合会引入冗余信息.本文方法虽也采用多尺度融合策略, 但并不是将不同尺度的特征直接融合, 而是使用尺度注意力模块, 计算不同尺度通道间的综合权重, 且对不同尺度的信息池化后进行交互, 减少噪声影响, 同时也增强重要特征的权重, 大幅提升分割精度.本文方法是在RAUNet的基础上进行的改进, 对比RAUNet, 在Kidney Tumor上的Dice分数提升3.8%, 在Kidney上的Dice分数提升0.2%.由于器官分割较简单, RAUNet已能达到较高的分割精度, 本文方法的分割精度稍有提升, 而对于Kidney Tumor的分割, 本文方法分割性能提升较大, 这是因为本文方法加入SAM后将不同尺度的解码特征进行交互融合, 获得更丰富的语义信息.本文方法引入UGM, 提高肿瘤边界的定位能力.此外, 相比RAU-Net、文献[18]方法和RBCANet, 本文方法性能也有较明显的提升, 尤其在Kidney Tumor分割上性能提升较大.

| 表2 不同方法的实验结果 Table 2 Experimental results of different methods |

2.3.3 消融实验

为了测试本文方法中各模块对分割性能的影响, 在KiTS19数据集上的肿瘤区域进行消融实验, 结果如表3所示, 表中黑体数字表示最优值.由表可知, 本文提出的各模块对分割性能均有提升作用, UGM模块可将Dice分数提高1.8%, 因为在不确定性引导下, 网络可学习更多的边界信息, 并给予不确定性高的边界更低的权重.SC模块的添加将Dice分数提升2.2%, 因为SC模块对高维信息的特征图进行再学习, 补充因上采样降维丢失的部分信息.SAM模块将上采样阶段不同尺度的信息进行交互融合, 获得包含不同尺度的语义信息, 故增加SAM模块后Dice分数提升1.7%.NCAM模块对高维语义信息进行全局提取, 在降维时, 减少重要信息的丢失, Dice分数提升1.4%.组合4个模块, Dice分数达到0.783.故本文增加的模块对提高分割精度均有作用, 尤其是SC模块, 对分割性能提升最大.由此可看出, 对高维语义信息的重利用, 可获得更优性能.

| 表3 各模块消融实验结果 Table 3 Ablation experiment results of different modules |

由于注意力模块可在网络训练的过程中聚焦于目标信息, 故本文采用的UGM模块包含通道注意力模块(Channel Attention Module, CAM)与空间注意力模块(Spatial Attention Module, SAM), 目的是利用注意力机制聚焦目标区域的特性, 在UGM模块的引导下自适应地分离目标信息与背景信息.在相同位置引入CAM模块、SAM模块及CAM+SAM模块.

各模块对方法性能的影响如表4所示, 表中黑体数字表示最优值.由表可知, UGM模块在肾肿瘤图像分割实验中表现出最优性能, 其次为SAM模块和CAM模块, CAM+SAM模块性能相对较低, 其原因是肾肿瘤细胞边界模糊, 使用传统注意力机制难以精确定位, UGM模块通过注意力机制聚焦目标区域后, 保留不确定性低(即把握性大)处的边界信息, 弱化不确定性高处错误边界的干扰, 过滤可能出现错误的预测, 提升分割精度.

| 表4 各模块对方法性能的影响 Table 4 Effect of different modules on performance of method |

2.3.4 超参数分析实验

本次实验的目的是分析一致性损失函数的超参数.选取超参数在0.1~0.9之间, 以肾肿瘤图像为分割对象, Dice分数作为分割指标, 实验结果如下.当λ =0.1时, Dice分数为0.762; 当λ =0.3时, Dice分数为0.765; 当λ =0.5时, Dice分数为0.783; 当λ =0.7时, Dice分数为0.767; 当λ =0.9时, Dice分数为0.761.

超参数的选取对网络精度影响较大, λ 值过大或过小都会影响分割性能, 当参数过小时, 一致性损失产生的作用过小, 对精度的增加有限.当λ 的权重过大时, 网络过度关注内部语义信息的学习, 泛化性能变差.当超参数处于0.3~0.7之间, 网络对高维语义信息的重利用、内部语义信息的学习与外部标签对网络的监督达到一个平衡状态.经过多次实验, 本文选取λ =0.5, 此时肾肿瘤图像的分割效果最优, Dice分数为0.783, 得到相对较优的分割结果.

2.3.5 定性实验

为了直观观察本文方法的有效性, 首先对肾脏图像分割进行定性对比, 定性实验结果如图6所示.

图6为5幅不同的肾脏切片可视化图, 各方法都能得到较好的分割效果, 均能分割肾脏的大部分区域.观察分析图6(a)中的第1列和第2列的CT图像发现, 由于边界清晰, 肾脏的轮廓较明显, 前景与背景区域的灰度相差较大, 肾脏内部组织较统一, 形状结构简单, 使用U-Net也能得到较优效果.对于图6(a)中第3列和第4列CT图像, 由于边界模糊, 参与对比的6种方法由于未使用UGM模块, 并未完全捕捉形状, 分割结果与真实值会有一定差距.在图6(a)中最后一列中, 肾脏内部出现空洞、形状复杂, 本文方法由于采用SAM模块和UGM模块, 分割性能与真实值较接近, 而其它6种方法因为未采用边界引导, 或只简单使用多尺度融合与注意力机制, 引入较多冗余信息, 分割效果并不理想.通过肾脏图像分割的可视化图可看出, 本文方法分割性能最优.

进一步, 为了分析不同方法对肾肿瘤图像的分割可视化结果, 本文选用5幅包含肿瘤的肾脏CT图像, 进行分割实验, 定性实验结果如图7所示.与肾脏图像分割不同, 肿瘤细胞的目标区域差距较大、纹理不清晰、灰度分布不均匀, 并且相对器官占比较小、不易分割.在图7(a)中第1列和第2列图像中, 肿瘤目标区域较大, 分割相对容易, 4种方法均获得较优的分割效果.当目标区域与背景的灰度较接近时, 不宜分割肿瘤边界, 如图7(a)中第3列图像, 分割边界变得极不确定, 采用RAUNet和CPFNet只是简单添加注意力增强模块和多尺度融合模块, 并未对噪声进行有效处理, 出现误分割现象.UNet未使用这些结构, 虽然不会引入过多噪声, 但会丢失对小目标区域的捕捉.本文对边界采取不确定性引导, 有效分割目标边界.当肾肿瘤图像的目标区域较小时, 如图7(a)中第3列~第5列图像, 在分割肿瘤细胞时会导致小目标丢失或产生错误分割, 分割形状与真实值相差较大.本文采用SAM, 不仅融合不同尺度间的信息, 还减轻冗余信息的引入, 并在UGM的作用下, 分割结果接近于真实值, 达到最优的分割效果.

本文提出基于不确定性引导和尺度一致性的肾肿瘤图像分割方法.首先引入不确定性模块, 为确定性高的区域赋予较小权重, 为确定性低的区域赋予较大权重, 为模型提供一定的可解释性.由于肿瘤区域边界模糊, 分割时难以有效界定分割边界, 采用此方法可较好地确定肿瘤细胞的分割边界.其次, 采用尺度一致性模块将融合后的特征与经过非局部注意力模块处理后的全局特征进行一致性约束, 对高维信息进行有效再利用, 进一步提升模型的分割能力.实验表明, 本文方法对于肿瘤细胞分割的Dice分数有所提升.本文方法适合于肾脏和肾肿瘤图像的分割, 并且在肾肿瘤图像上分割性能较优, 具有一定的优越性.为了实现分割效果的进一步提升, 今后拟在训练时考虑邻近切片图像的信息关系, 使网络学习到更丰富的上下文信息.

本文责任编委 杨健

Recommended by Associate Editor YANG Jian

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|