周涛,博士,教授,主要研究方向为医学图像处理、深度学习、模式识别等.E-mail:zhoutaonxmu@126.com.

作者简介:

叶鑫宇,硕士研究生,主要研究方向为医学图像处理、计算机辅助诊断.E-mail:3303626778@qq.com.

陆惠玲,硕士,副教授,主要研究方向为图像处理.E-mail:lu_huiling@163.com.

常晓玉,硕士研究生,主要研究方向为医学图像处理.E-mail:yu0410yu@163.com.

刘赟璨,硕士研究生,主要研究方向为医学图像处理.E-mail:lyc9619@163.com.

X光片中肺炎存在影像学特征不明显、病灶与周围组织对比不明显、边缘模糊等问题,因此,文中提出基于多分辨率注意密集网络的肺炎分类识别方法.深度融合浅层定位信息与深层语义信息,并构造多分辨率空间注意力门,对不同分辨率的深层信息与浅层信息进行语义式交互增强,在深浅层信息中建立病灶信息的相互依赖关系.此外,设计坐标频率注意力,以方向和位置互补的方式自适应地增强肺炎特征的表达.在ChestXRay2017等5份肺炎X光片数据集上的实验表明,文中网络在肺炎分类识别任务上性能较优,同时还具有公共肺炎数据集上的鲁棒性.

ZHOU Tao, Ph.D., professor. His research interests include medical image processing, deep learning and pattern recognition.

About Author:

YE Xinyu, master student. His research interests include medical image processing and computer-aided diagnosis.

LU Huiling, master, associate professor. Her research inte-rests include image processing.

CHANG Xiaoyu, master student. Her research interests include medical image processing.

LIU Yuncan, master student. Her research interests include medical image processing.

X-ray film of pneumonia suffers from inconspicuous imaging features, low contrast between lesions and surrounding tissues, and blurred edges. Therefore, a pneumonia classification and recognition method based on multi-resolution attention dense network is proposed. Shallow localization information and deep semantic information are deeply fused. A multi-resolution spatial attention gate is constructed to enhance semantic interaction between deep and shallow information at different resolutions, establishing interdependency for lesion information in deep and shallow information. In addition, the coordinate frequency attention is designed to adaptively enhance the representation of pneumonia features in a complementary manner of orientation and location. Experiments on five pneumonia X-ray datasets including ChestXRay2017 show that the proposed method achieves better performance in pneumonia classification and recognition task with robustness on the public pneumonia dataset.

肺是人体气体交换必不可缺的器官, 但肺部疾病对人体健康造成严重威胁, 常见的肺炎因其病因错综复杂, 并且难以在早期进行精准检测, 导致全球每年约有7%的人口受到肺炎影响[1].胸腔X光片由于成本较低、易于获取[2]等原因, 成为全球肺炎检测常用的方式之一.

X光片中肺炎与多余液体等其它肺部异常具有相似的不透明度, 肺炎X光片计算机诊断技术并不发达, 导致目前诊断还主要依赖医师, 不仅增大医师的工作量, 而且使肺炎检测水平很大程度上依赖医师的诊断水平, 诊断结果的可靠性也面临巨大挑战.显然, 更精准的计算机诊断肺炎模型可以减少医生工作量和提高诊断的可靠性.

深度学习方法可以提取X光片中复杂而丰富的特征, 确保有效的识别结果.随着最大的胸腔X光片数据集ChestX-ray14[2]被不断深入研究, 学者们不断提出众多高性能的针对肺炎识别的深度学习方法, 用于减少医生工作量.Sharma等[3]使用VGG16, 在6 436幅X光片中识别肺炎, 获得95.4%的准确率.Bhandary等[4]采用支持向量机改进AlexNet, 检测X光片和CT中的肺炎.Banerjee等[5]在肺炎X光片上使用MobileNet进行计算机辅助诊断, 获得优于传统机器学习模型的性能.Afshar等[6]结合卷积神经网络(Convolutional Neural Network, CNN)和胶囊层, 提出COVID-CAPS, 捕获肺炎X光片中疾病细节, 实时诊断肺炎.Liu等[7]提出多分支融合辅助学习方法, 在肺炎X光片中获得96.80%的准确率.

DenseNet(Dense Convolutional Network)[8]是深度学习的一个重要模型, 在肺炎分类识别上具有广泛应用.Hammoudi等[9]在肺炎X光片数据集上训练深度学习模型, DenseNet169获得最优性能.Qin等[10]利用两个平行的三维密集网络提取不同模态的细粒度特征, 通过挤压激励(Squeeze-and-Excita-tion, SE)和空间注意门控对特征进行增强并聚集.

目前, 在肺炎识别分类任务上, 研究人员尝试结合DenseNet与其它技术.Chen等[11]并行多个密集块, 使用SE对特征图通道进行重新校准, 保证多个块训练稳定性的同时提高分类精度.Zhang等[12]通过注意力机制将密集块内全部层加权后进行连接, 提取更紧凑和重要的特征用于分类.Park等[13]利用DenseNet提取肺炎X光片中的特征, 将特征嵌入Transformer模型, 最终在肺炎诊断任务中获得较优性能.Ukwuoma等[14]融合DenseNet和Transformer, 提出Hybrid Model, 实现混合工作流, 提取X光片特征并集成, 在肺炎识别任务上获得99.21%准确率.

近年来, 注意力机制中的自注意力Transformer取得一系列新的进展, 在肺炎识别任务中应用广泛.Okolo等[15]提出用于肺炎X光片识别的输入增强Transformer, 获得98.48%的精度, 平均精度提升4.67%.Uparkar等[16]基于Transformer检测X光片肺炎, 随着内部层增加和补丁大小减少, 准确率提升明显.Peng等[17]提出Comformer, 在肺炎CT数据集上分类精度较优.

自注意力在肺炎分类任务上取得优异性能, 但肺炎病灶在X光片中存在影像学特征不明显、浅层特征包含图像细节信息、深层特征包含图像语义信息、现有模型难以获取深浅层多分辨率特征图中的丰富信息、难于对深浅层进行合理融合等问题.Zhao等[18]指出没有上下文语义关系和浅层细节信息的局部特征可能导致分类错误.

此外, 病灶与周围组织存在对比不明显、边缘模糊等问题, 由于部分通道并不包含肺炎特征, 病灶的空间信息缺乏, 在深浅层融合中也会导致病灶特征难以被捕获, 仅使用通道或空间注意力也难以消除噪声相关的特征.

因此, 本文提出基于多分辨率注意密集网络(Multi-resolution Attention Dense Network, MADense-Net)的肺炎分类识别方法.首先, 将包含图像细节信息的浅层特征向网络深层传递, 实现浅层定位信息与深层语义信息的深度融合.然后, 针对病灶与周围组织对比不明显、边缘模糊等问题, 设计坐标频率注意力, 以方向和位置互补的方式增强肺炎特征的表达.最后, 构造多分辨率空间注意力门, 生成空间权重并进行语义式交互增强, 并在多分辨率深浅层信息中建立病灶信息的相互依赖关系, 在关注病灶区域的同时降低特征提取过程中的噪声.

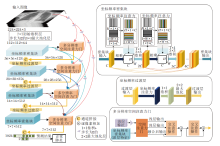

本文设计基于多分辨率注意密集网络(MA-DenseNet)的肺炎分类识别方法.MADenseNet整体框架如图1所示.将坐标频率注意力引入DenseNet中, 设计坐标频率密集块和坐标频率过渡层.此外, 将浅层特征图向深层特征进行逐层传递, 从而实现网络输入与密集块的深浅层密集连接.在深浅层密集连接中构造多分辨率空间注意力门, 该门由深浅层交互式空域增强的空间注意力门和用于建立病灶远程依赖关系的交叉注意操作构成.

ResNet通过残差连接拟合残差项, 对当前层与前续层特征进行相加, 在实现网络模型加深的同时提高性能.DenseNet[8]中每层向网络增加特征且保持其它特征不变, 以更少参数量和计算量获得更好的收敛率和更高的性能, 这是由于密集连接方式可以明确区分输入特征和新特征, 不会导致信息流被破坏, 进一步缓解梯度消失和网络退化问题.

但DenseNet最终决策仅利用最终密集块特征, 具有丰富定位信息的浅层特征并不能充分传递到最终决策层, 并且采用单一下采样容易造成信息丢失, 导致难以识别影像中影像学特征不明显的肺炎特征.为此, 本文设计深浅层密集连接, 在下采样同时将网络输入特征与密集块特征进行密集连接, 对不同分辨率的深层语义信息与浅层定位信息进行深度融合, 获取多分辨率特征图中的丰富信息, 并防止丢失一些图像的细节信息, 这在一定程度上弥补肺炎病灶的影像学信息不明显的缺陷, 跨层密集连接还实现整个网络的隐式深度监督, 改善网络中的信息流和梯度, 在降低参数的同时避免过拟合, 提高网络的特征表征能力.

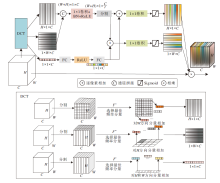

X光片中存在肺炎病灶与周围组织对比不明显的问题, 通道注意力机制可以增强肺炎相关的特征通道, 全局平均池化(Global Average Pooling, GAP)是频域分析中一种特例的特征分解, 等价于离散余弦变换(Discrete Cosine Transform, DCT)的最低频率分量, 但GAP取均值也难以表达出整个空间信息.例如:SE使用空间维度压缩后的特征向量对特征通道进行增强, 这样会忽略同一通道上特征的空间信息.为此, 本文设计坐标频率注意力(Coordinate Frequency Attention, CFA), 框架如图2所示.DCT替代GAP, 利用卷积运算在x方向空间信息中建立特征间依赖关系, 同时在y方向空间中保留精确的位置信息, 以空间方向和位置相互补充的方式增强感兴趣目标的表达.此外, 建模整个空间多频率分量中的通道相互关系, 并以残差学习方式与两个方向的空间多频率分量信息进行融合, 提高稳定性和鲁棒性.

设定H、W分别为输入特征图U的高、宽, C为通道数.DCT基本参数为:

$B_{:, h, w}^{c}=\cos \left(\frac{\pi h}{H}\left(i+\frac{1}{2}\right)\right) \cos \left(\frac{\pi w}{W}\left(j+\frac{1}{2}\right)\right)$,

其中,

h∈ {0, 1, …, (H-1)(C-1)},

i∈ {0, 1, …, H-1},

w∈ {0, 1, …, (W-1)(C-1)},

j∈ {0, 1, …, W-1}.

令h=w=0, DCT最低频分量为:

$\begin{aligned} D C T_{:, 0, 0}^{c}= & \sum_{i=0}^{H-1} \sum_{j=0}^{W-1} U_{:, i, j} B_{:, 0, 0}^{c}=\sum_{i=0}^{H-1} \sum_{j=0}^{W-1} U_{:, i, j}= \\ & \operatorname{GAP}(U), \end{aligned}$

可以看出相比SE, DCT应用的最低频分量GAP(U)包含更多频率分量信息.引入其它分量:

$\begin{aligned} D C T_{i, j} & =\sum_{h=0}^{H-1} \sum_{w=0}^{W-1} U_{:, i, j} B_{:, h, w}= \\ & \operatorname{GAP}(U)+U_{:, 0, 1} B_{:, 0, 1}+\cdots+U_{:, H-1, W-1} B_{:, H-1, W-1} .\end{aligned}$

本文设计的DCT可以沿整个空间方向提取多频率的通道分量信息Fc, 以及沿空间的x方向与y方向分别提取多频率的通道空间分量信息Fm与Fn, 即

Fn=DCT(U:, :, w)=

Fm=DCT(U:, h, :)=

其中, m、h取值范围相同, n、w取值范围相同.频率分量

合并多频率分量信息Fm和Fn, 然后利用卷积运算(Conv)和分割(Split), 生成2个二维特征矩阵:

Dm, Dn=Split(Relu(BN(conv(Fm© Fn)))),

其中, © 为拼接, Relu(· )为激活函数, BN(· )为批量归一化.Fc通过全连接层(FC)生成, 将其与2个二维特征矩阵相加, 生成注意力权重:

Wm=ϕ (conv(Dm+fc(Relu(fc(Fc))))),

其中ϕ (· )为Sigmoid函数.最后对两个空间方向上生成的二维权重Wm和Wn进行加权.

密集块和过渡层中引入坐标频率注意力, MADenseNet包含4个不同深度的坐标频率密集块, 深度和密集单元个数相同, 分别为6、12、24、16, 可以自适应地突出有价值的肺炎特征, 提高网络的表征能力, 融合不同分辨率深浅层信息.

肺炎病灶与周围组织间存在边缘模糊问题, 尽管采用坐标频率注意力增强肺炎特征, 可以更好地识别病灶类别, 但部分空间信息保留只能关注到整个通道的类别, 难以充分学习病灶的空间信息, 从而导致网络分类决策受到潜在背景和噪声的影响, 这种现象更容易在浅层定位信息与深层语义信息融合中发生.

此外, 深浅层特征直接融合网络难以精准关注病灶区域, 需要同时关注肺炎的类别信息和空间位置信息.

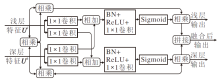

为此, 本文在多分辨率深浅层信息中, 构造由空间注意力门和交叉注意操作组成的多分辨率空间注意力门, 充分利用深浅层特征提升网络学习肺炎特征的能力.其中空间注意力门对不同分辨率的浅层特征和深层特征进行融合, 利用包含空间位置信息的浅层和包含上下文信息的深层生成空间权重, 进行语义式交互增强.空间注意力门结构如图3所示.

浅层特征Ul为网络输入和前续密集块的特征图, 深层特征Uh为当前密集块的特征图.首先, Ul与Uh相乘, 得到权重α .然后Ul和Uh分别通过两组1× 1卷积和相加, 其中通道数被压缩到1/8, 分别输入BN、ReLU和1× 1卷积中, 通过Sigmoid函数获得浅层空间注意力权重

$\boldsymbol{U}^{S 1}=\left(\boldsymbol{U}^{l} \cdot \alpha \cdot \widetilde{\boldsymbol{\beta}}\right) \Subset\left(\boldsymbol{U}^{h} \cdot \alpha \cdot \widehat{\boldsymbol{\beta}}\right)$

此外, 设计如图4所示的交叉注意操作, 进一步交叉相乘, 在语义式交互增强的深浅层特征中, 建立病灶信息的相互依赖关系.

首先在浅层特征图、深层特征图和融合后特征图中分别利用1× 1卷积生成3个矩阵Q、K、V.然后利用K乘Q和KT乘Q, 以K· Q+KT· Q的相加方式进行叠加, 可以表示浅层特征和深层特征之间的相关程度.最后使用Sigmoid函数(ϕ (· ))生成空间注意权重, 对V加权并使用残差学习, 获得交叉注意操作最终输出:

US2=ϕ (K· Q+KT· Q)· V+US1.

尽管交叉注意操作可以捕获水平方向和垂直方向的上下文信息, 在空间维度上生成传播路径, 对目标建立联系, 但单次操作生成的传播路径有限, 像素与像素周围的连接仍然稀疏, 难以获得充足的上下文信息.为此, 对交叉注意增强后的深浅特征图再进行交叉注意操作, 通过两次循环覆盖全部传播路径, 从所有像素中获取远程相互依赖关系.对US2使用1× 1卷积生成

$\boldsymbol{U}^{S}=\phi\left(\widetilde{\boldsymbol{K}} \cdot \widetilde{\boldsymbol{Q}}+\widetilde{\boldsymbol{K}}^{\mathrm{T}} \cdot \widetilde{\boldsymbol{Q}}\right) \cdot \widetilde{\boldsymbol{V}}+\boldsymbol{U}^{S 1}$

MADenseNet有4个多分辨率空间注意力门, 深浅层特征图通道数分别为128、256、512、512, 对深浅层特征进行语义式交互增强, 建立病灶信息的相互依赖关系, 使网络精准关注病灶区域, 并减少特征提取中的噪声.

实验采用如下4个数据集.1)广州市妇幼保健中心的肺炎X光片ChestXRay2017[19], 共1 583幅正常图像和4 273幅肺炎图像.2)文献[20]的肺炎相关X光片数据集, 共234幅正常图像和221幅新冠肺炎图像.3)文献[21]的肺炎相关X光片数据集, 共8 552幅正常图像、5 674幅肺炎图像和7 598幅新冠肺炎阴性图像.4)文献[22]的肺炎相关X光片数据集, 共6 845幅正常图像、10 192幅肺炎图像和7 660幅新冠肺炎图像.此外, 本文合并1)、3)、4)数据集上正常图像和肺炎图像, 使用较大的样本量进行进一步研究和可视化对比.

实验环境为Windows Server 2019系统, 256 GB内存, 搭载2块3 GHz的36核处理器, 并采用2块泰坦第V代显卡, 基于GPU的Pytorch框架搭建网络, 使用随机梯度下降(Stochastic Gradient Descent, SGD)优化器进行优化, 采用0.01的初始学习率和每10个周期0.9的衰减策略, 设置权重衰减值为1e-4, 训练周期为250, 训练批处理大小为48.

根据模型预测结果分类错误个数和正确个数, 得到真正类(True Positive, TP)、假正类(False Positive, FP)、假负类(False Negative, FN)、真负类(True Negative, TN).准确率(Accuracy)为全部类预测正确的比例, 精确率(Precision)为正类且模型预测正确占所有正类的比例, 召回率(Recall)为模型预测的正类占所有正类的比例, F1分数如下:

F1=2×

ROC(Receiver Operating Characteristic)曲线是以敏感度即真正类率(True Positive Rate, TPR)为纵轴、假正类率(False Positive Rate, FPR)为横轴进行绘制.将ROC曲线下面积定义为AUC(Area Under Curve), 越靠近左上角AUC值越大, 表示模型的排序和分类性能越优.评价指标均是值越大表示模型越优.TPR值等于召回率, FPR和TNR(True Negative Rate)定义如下:

$\begin{array}{l}F P R=\frac{F P}{F P+T N}, \\ T N R=\frac{T N}{F P+T N} .\end{array}$

为了评估坐标频率注意力的有效性, 在深浅层密集连接的基础上, 与4种通道注意力机制进行对比, 结果如表1所示.

| 表1 各注意力机制的指标值对比结果 Table 1 Index comparison of different attentions |

从表1可以看出, 高效通道注意力使用一维卷积替换挤压激励注意力中的全连接层, 参数量增加最少, 但在肺炎识别上表现略差.坐标注意力获得更高的性能提升, 在高效通道注意力基础上沿两个空间方向聚合特征, 可以较好地保留部分空间信息.相比深浅层密集连接, 高斯上下文自注意力的准确率和AUC值分别提升1.43%和2.53%, 在Transfor-mer基础上利用高斯方程计算注意权重, 学习上下文特征间的相互依赖关系, AUC值提升明显, 具有较优的肺炎识别能力.相比深浅层密集连接, 坐标频率注意力的准确率和AUC值分别提升2.17%和3.49%, 对深浅层特征提取空间x、y方向和通道的多频率分量信息, 在空间多频率分量信息中建立特征间依赖关系的同时保留精确的位置信息, 以通道间相互关系、方向和位置互补的方式增强感兴趣目标的表达, 在肺炎识别中获得最优性能和最佳鲁棒性.

为了评估MADenseNet结构的有效性, 进行5组选择, 基础模型为DenseNet121.1)网络1.缩减部分通道数.2)网络2.在部分通道数缩减的基础上进行整个网络的深浅层密集连接.3)网络3.在深浅层密集连接DenseNet121中引入坐标频率注意力.4)网络4.在网络3基础上, 对深浅层特征引入交叉注意操作.5)网络5.在网络4基础上, 在深浅层密集连接的连接处引入空间注意力门, 即MADenseNet.

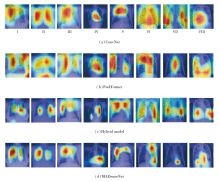

最终各网络的消融实验结果如表2所示, DenseNet121、网络2和网络5的热力图结果如图5所示, 红色程度越深表示网络对这个区域的关注度越高.

| 表2 5组实验消融的结果 Table 2 Results of 5 sets of ablation experiments |

由表2可见, 相比DenseNet121, 网络1的参数量下降明显, 但准确率和AUC值降低2.33%和2.71%.网络2的参数量减少42.17%, 训练时间降低40.84%, 而整体性能仅略微降低, 表明采用深浅层密集连接可大幅提高模型效率.由图5(c)可见, 网络2关注区域主要集中在胸腔内部, 较好地避免关注外部区域所导致的识别误差, 浅层定位信息与深层语义信息进行深度融合, 可获得更多图像细节信息, 进一步学习肺炎影像学特征.网络3以较少参数量获得近2%的性能提升, 表明坐标频率注意力在对比低的X光片中, 能自适应地增强包含病灶信息的通道, 提高网络表征能力.相比网络3, 网络4的准确率和AUC值分别提高1.07%和1.58%, 对病灶信息建立远程依赖关系, 可以较好识别肺炎.

相比网络4, 网络5的准确率和AUC值分别提高1.58%和2.54%, 空间注意力门对浅层特征与深层特征进行语义式交互增强, 利用浅层细节信息和深层语义信息, 可以更好地聚焦到肺炎特征.肺炎病灶特征不明显且对比度较低, 网络容易关注到其它类似肺炎的特征, 而提取较多的无用信息.由图5(d)可见, 网络关注区域更集中, 识别无错误, 可看出更多具有区分性的特征被学习, 表明语义式交互深浅层特征可以更集中和更精准地定位到病灶区域, 同时降低特征提取过程中的噪声.

相比DenseNet121, 网络5在准确率和AUC值上分别提高4.14%和6.57%, 训练时间降低29.02%, 在性能和效率上均提升明显.

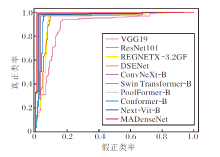

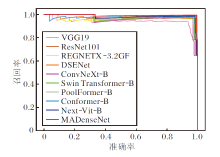

本节选择如下对比网络:1)CNN网络.VGG19[3]、ResNet101[4]、密集挤压激励网络(Dense Squeeze-and-Excitation Network, DSENet)[23]、REG-NETX-3.2GF[24]、ConvNeXt-B[25].2)Transformer网络.Swin Transformer-B[26]、PoolFormer-B[27].3)CNN结合Transformer网络.Conformer-B[17]、Next-Vit-B[28].在ChextXRay2017数据集上, 各网络的具体分类结果如表3所示.

| 表3 各网络在ChestXRay2017数据集上的对比结果 Table 3 Result comparison of different networks on ChestXRay2017 dataset |

由表3可知, ResNet101通过残差连接重构学习过程和重定向网络信息流, 相比VGG19, 性能和效率得到提升.基于架构搜索的REGNETX-3.2GF以较少参数量获得更优性能.DSENet利用SE和非对称卷积改进DenseNet121, 性能获得明显提升.相比ResNet101, ConvNeXt-B使用较大的7× 7卷积核, 准确率和AUC值分别提升2.55%和3.51%.相比5个CNN网络, MADenseNet以较高计算效率获得明显的性能提升.

Swin Transformer-B获得与REGNETX-3.2GF相近的肺炎识别性能.相比Swin Transformer-B, Pool-Former-B采用更通用的模型结构, 准确率和AUC值分别提升1.24%和1.06%.相比这2个Transformer模型, MADenseNet采用近10%参数量获得较大的性能提升.Conformer-B采用双分支并行, 以交互方式融合局部特征和全局特征, 以较大的模型参数量获得较高的肺炎识别能力.工业部署场景中设计的CNN-Transformer混合架构Next-Vit-B, 以Confor-mer-B近1/3参数量获得小幅性能提升.相比Next-Vit-B, MADenseNet的参数量和AUC值分别提升1.05%和1.54%.

MADenseNet可以提取更多的有效特征, 具有最高识别率和最好特征表征能力, 对X光片肺炎样本的识别能力最优.

各网络的ROC曲线如图6所示.由图可见, MADenseNet具有明显的优势和鲁棒性.

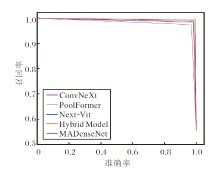

各网络的PR曲线如图7所示, 图中准确率越高, 召回率越低, 越向上方凸出、包围面积就越大, 表示网络效果越优.由图可看出, MADenseNet性能明显最优, 能更好地识别肺炎.

在2.1节描述的合并数据集上, 将MADenseNet与性能较优的ConvNeXt、PoolFormer和Next-Vit进行对比, 并对比X光片上融合DenseNet和Trans-former的混合模型Hybrid Model[14].各网络的具体分类结果如表4所示, PR曲线如图8所示.选择8例肺炎较难识别的患者, 各网络生成的热力图和分类错误结果对比如图9所示.

| 表4 各网络在合并数据集上的结果对比 Table 4 Result comparison of different networks on merged dataset |

由表4、图8和图9可以看出, MADenseNet计算效率和识别性能最佳.

从图9可看出, ConvNeXt在图像II、III、IV、VI、VII上判错, PoolFormer在图像I、II、V、VI上判错.Hybrid在图像IV、VII上判错, MADenseNet在图像VII上判错.相比PoolFormer, ConvNeXt关注区域相对更大, 虽然关注区域形状更贴合胸腔轮廓, 但难以捕获可区分特征, 说明识别区域大但识别能力不足.PoolFormer识别肺炎相关特征和背景的能力不强, 会出现关注到胸腔外部的情况(见图像I), 且关注区域较易出现规则的矩形形状(见图像V、VI).Hybrid Model利用全局信息和局部信息学习更丰富特征, 总体识别准确率更高, 网络也能更好地关注胸腔区域, 但还是会出现关注无病灶区域和肺炎病灶难以识别(见图像IV)的问题.MADenseNet在多分辨率深浅层信息中建立病灶信息的相互依赖关系, 具有最佳的肺炎识别能力.

为了验证MADenseNet的鲁棒性和泛化能力, 在2.1描述的第2个、第3个和第4个公开的肺炎相关X光片数据集上进行对比实验, 选择如下对比网络:VGG19[3]、COVID-CAPS[6]、Crawling+GSEN(Gray-Scale Spatial Exploitation Net)[20]、ViT-B32[21]、DenseNet and DLMNN(Deep Learning Modified Neural Network)[22]、E-DiCoNet[29]、CoroNet[30].

各网络在3个公开数据集上的对比结果如表4~表6所示.由表可见, MADenseNet均取得较优性能.

| 表5 各网络在第1个公开数据集上的对比结果 Table 5 Result comparison of different networks on public dataset 1) |

| 表6 各网络在第2个公开数据集上的对比结果 Table 6 Result comparison of different networks on public dataset 2) |

| 表7 各网络在第3个公开数据集上的对比结果 Table 7 Result comparison of different networks on public dataset 3) |

本文提出基于多分辨率注意密集网络(MA-DenseNet)的肺炎分类识别方法, 密集连接融合深层与浅层多分辨率特征, 以方向和位置互补的方式融合通道间相互关系, 并建立肺炎病灶的相互依赖关系.在5个肺炎数据集上进行对比和消融实验, MADenseNet在各项评估指标上达到较优性能, 以较高效率获得99.15%准确率和98.82%AUC值, 能较好地识别肺炎疾病, 在肺炎的诊断评估中具有很大潜力, 为医生的辅助诊断、术前术后检查工作提供有效帮助.

消融实验结果表明浅层特征的引入有助于提升方法的识别性能, 但是目前的研究只是在网络中间特征图之间进行交互, 原始图像在数据预处理中进行的尺寸压缩可能会丢失关键信息, 尤其是高分辨率医学图像中像素数还较少的病灶信息.因此, 在未来的工作中, 考虑使用基于数据特性设计恰当的深浅层注意力机制, 并兼顾局部和全局交互式学习, 设计满足医学高精度识别和低误诊率要求的模型.此外, 还可考虑使用训练可视化对比实验中的模型热力图, 指导后续批次的数据预处理, 尽可能高效和鲁棒地学习原始图中更清晰的病灶特征.

本文责任编委 黄华

Recommended by Associate Editor HUANG Hua

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|