薛 晖,博士,教授,主要研究方向为机器学习、模式识别.E-mail:hxue@seu.edu.cn.

作者简介:

杨梅梅,博士研究生,主要研究方向为双曲机器学习、双曲核学习、双曲图学习.E-mail:meimeiyang@seu.edu.cn.

方鹏飞,博士,副教授,主要研究方向为机器学习、模式识别.E-mail:fangpengfei@seu.edu.cn.

朱士鹏,博士研究生,主要研究方向为计算机视觉、多模态学习,模式识别.E-mail:shipengzhu@seu.edu.cn.

层次结构数据广泛存在于各类机器学习场景中,双曲空间能够以极低的失真编码层次结构数据,引入核方法后,可进一步提高双曲空间的表征能力.然而,现有的双曲核仍然存在自适应能力较低或数据失真的缺陷.为了解决这些问题,文中提出基于莫比乌斯陀螺矢量空间的双曲正定核方法.利用莫比乌斯陀螺矢量空间与庞加莱模型之间的关系,构造莫比乌斯径向基核.具体使用莫比乌斯陀螺距离代替欧几里得距离,构造莫比乌斯高斯核和莫比乌斯拉普拉斯核,并进一步证明核函数的正定性.另外,将该核函数从复空间转换到实空间上,更适用于大多数机器学习任务.在多组真实的社交网络数据集上的实验验证文中方法的有效性.

XUE Hui, Ph.D., professor. Her research interests include machine learning and pattern recognition.

About Author:

YANG Meimei, Ph.D. candidate. Her research interests include hyperbolic machine learning, hyperbolic kernel learning and hyperbolic graph learning.

FANG Pengfei, Ph.D., associate profe-ssor. His research interests include machine learning and pattern recognition.

ZHU Shipeng, Ph.D.candidate. His research interests include computer vision, multimodal learning and pattern recognition.

Hierarchical data is widely present in various machine learning scenarios and the data can be encoded in hyperbolic spaces with very low distortion. Kernel methods are introduced to further enhance the representation capability of hyperbolic space. However, the existing hyperbolic kernels still have the drawbacks of low adaptive capacity or data distortion. To address these issues, hyperbolic positive definite kernels based on Möbius gyrovector space is proposed in this paper. By leveraging the relationship between the Möbius gyrovector space and the Poincaré model, a class of hyperbolic kernel functions, the Möbius radial basis kernels, are constructed. Specifically, the Möbius gyrodistance is employed in place of the Euclidean distance to construct the Möbius Gaussian kernel and the Möbius Laplacian kernel, with the positive definiteness of the kernel functions further demonstrated. Moreover, kernel functions are transformed from complex space to real space, and thus they are more suitable for most machine learning tasks. Experiments on several real-world social network datasets validate the effectiveness of the proposed method.

层次结构数据, 即内蕴树型或图等其它能够被分层表示的结构性信息的数据, 广泛存在于自然语言处理、计算机视觉、知识图谱推荐系统等热点研究领域[1, 2, 3, 4, 5, 6, 7, 8].在自然语言处理中, 文本数据中蕴含的关联关系能够根据某些先验知识表示为图结构.在计算机视觉中, 层次结构体现为图像在时间或空间上的关系或图像类别之间的关系.在知识图谱领域, 知识层级间的层次结构信息也可以用图模型等方法进行刻画.在推荐系统领域, 用户与商品之间的关系建模具有分层拓扑结构.现有的处理层次结构数据的方法主要是先将数据表征到欧氏空间, 再基于欧氏空间设计算法, 处理下游机器学习任务.然而, Bourgain定理已经证明, 即使是在无限维的欧氏空间中也不能对这种层次数据进行无损编码[3].

近年来, 双曲空间因其无损表征层次结构数据的能力而引起研究者们的关注, 用来代替欧氏空间作为层次结构数据的表征空间[9].双曲空间是具有负常数曲率的空间, 体积树型增长的性质与层次结构的节点数随层数增加而与指数增长呈一致.因此, 双曲模型即使在低维也能以很低的失真表征层次结构数据.事实上, Hsu等[10]也指出任意低维度的双曲空间能够以极小的畸变编码任意树状结构.

目前, 针对层次结构数据设计的双曲表征算法层出不穷, 在机器学习任务上展现出极强的优越性.Nickel等提出两种对数据层次结构进行编码的方法, 即基于庞加莱模型的方法[11]和基于洛伦兹模型的方法[12].相比欧氏空间嵌入, 这些研究取得更优效果.另外, Khrulkov等[8]表明图像数据集中存在层次结构, 并证明在视觉数据中使用双曲算法的可能性.这是双曲学习与计算机视觉结合的开创性工作之一.

由于双曲嵌入的迅速发展, 用于处理下游任务的算法, 包括双曲神经网络和双曲核方法等双曲算法, 也不断涌现.Ganea等[13]将双曲空间作为嵌入空间集成到深度神经网络中, 用于实现双曲空间的非线性运算.方法将欧氏空间上的向量加和乘等基本操作扩展到双曲空间上, 进而提出双曲神经网络结构.利用双曲神经网络中的加、乘等基本算子, 学者们提出一系列包括Hyperbolic Attention Network[14]、Hyperbolic Neural Networks++[15]、Hyperbolic Graph Neural Network[9, 16]等网络, 并取得良好效果.然而, 相比欧氏空间中的神经网络, 双曲神经网络由于其基本操作的复杂性和网络层级中双曲空间与切空间之间的转换, 计算复杂度更高.

核方法在分类、回归和聚类等不同的机器学习任务中都被广泛应用[17, 18, 19, 20, 21], 其核心思想是通过非线性映射函数将原始空间中线性不可分数据映射到一个再生核希尔伯特空间(通常是高维空间), 使映射后数据可在该再生核希尔伯特空间中达到线性可分的效果.该非线性映射并不需要显性求解, 而是通过使用原始空间中的核函数代替映射后向量的内积以实现, 这就避免计算高维特征空间中的内积.欧氏空间中的核方法不仅具有简约的形式, 也具有完备的理论.

基于上述优势, 研究者们将核方法推广到双曲空间中.相比双曲神经网络, 核方法在一定程度上解决双曲神经网络算法计算复杂度较高的问题.Cho等[22]提出双曲核方法, 并基于洛伦兹模型设计双曲多项式核.在构造核函数的过程中, 先将数据从洛伦兹模型等距同构地转换到克莱因(Klein)模型上, 再用欧氏核函数将数据投射到高维克莱因模型, 最后将数据映射回洛伦兹模型.相比欧氏核, 该双曲核函数在层次结构数据的分类上性能有所提升.然而方法将曲率固定为-1, 限制核函数的映射能力, 进而影响如分类在内的具体任务性能.这是因为虽然不同曲率的双曲模型之间是等价的, 但由于计算机精度的限制, 选择不同曲率对双曲算法的性能存在一定影响[9].另外, 由于该核函数映射后的特征空间仍然是双曲空间, 需要在双曲空间上定义能够利用该核函数的算法, 因此难以应用希尔伯特空间上丰富的理论.Fang等[23]定义双曲空间中的正定核, 使双曲空间能充分利用核机强大的表示能力.该工作揭示庞加莱模型与切空间上曲线长度之间的关联关系, 并确定一个双射函数, 有助于在庞加莱模型中定义正定核.Fang等[23]提出一系列正定核, 并成功应用在模型的自适应任务上.然而, 该研究利用切空间获得“ 线性” 的双曲表征, 存在对双曲空间利用不充分的问题.

针对上述双曲核方法存在的问题, 本文提出基于莫比乌斯陀螺矢量空间的双曲正定核方法.基于莫比乌斯陀螺矢量空间上的陀螺矢量距离, 构造莫比乌斯高斯核(Mö bius Gaussian Kernel, MGauss)和莫比乌斯拉普拉斯核(Mö bius Laplacian Kernel, MLap), 并证明该核函数的正定性.这类核函数将曲率值作为参数, 不仅把双曲空间上的数据映射到再生核希尔伯特空间上, 利用现有核方法的丰富理论, 而且把曲率的值作为输入参数, 增加核函数在不同数据集上的自适应性.莫比乌斯陀螺距离的使用意味着该函数在构造过程中遵循双曲几何设定, 保留双曲空间本身的度量, 减少双曲数据在核映射过程中的失真.多组在真实数据集上的对比实验验证本文方法处理层次结构数据时的优越性, 以及对不同数据的适应能力.

本文方法主要基于庞加莱模型和莫比乌斯陀螺矢量空间, 下面就相关概念和基本知识予以介绍.

本文中, 分别使用Cn表示n维复空间, Rn表示n维实空间,

本文的理论涉及复空间与实空间运算, 因此简单介绍复空间的基本内积和范数操作.

令

C∋x=x1+ix2=(x1, x2)=xR∈ R2,

则xR表示x转化为实空间上数据的表示.当y∈ C时, x和y内积表示为

< x, y> =

其中

表示y的共轭复数.另外, x的范数定义为

$ |x|=\sqrt{x_{1}^{2}+x_{2}^{2}}=\sqrt{x \bar{x}}=\left\|\boldsymbol{x}^{\mathbf{R}}\right\|, $

其中, |· |表示复数的模或复向量的范数, |· |表示实空间上向量的范数.此外, 也可得

< x, y> +< x, y> =2xR· yR,

其中xR· yR表示实向量的内积.

该结论可以直接扩展到高维空间.具体地, 对于高维空间, 当x∈ Cn, y∈ Cn表示复向量, 即

x=(x1, x2, …, xn)∈ Cn

时, x∈ Cn可以使用2n维实向量xR∈ R2n等价表示, 则

|x|=

另外, 根据

< x, y> =x1

也可以推出

< x, y> +< y, x> =2xR· yR,

其中xR· yR表示xR和yR的内积.

双曲空间是具有负常数曲率的黎曼流形, 可以使用多个不同的等距同构模型表示, 这些双曲模型包括庞加莱模型、克莱因模型及洛伦兹模型等[24].类似于向量空间为欧氏空间提供加、减等基本操作, 莫比乌斯陀螺矢量空间为庞加莱模型提供基本操作算子[25].下面对庞加莱模型、克莱因模型、洛伦兹模型、庞加莱模型对应的莫比乌斯陀螺矢量空间进行简单介绍.

可以表示为一个具有黎曼度量

表示n维半径为

|z|=

庞加莱模型也可表示为

R

其中,

且

表示黎曼度量.

n维克莱因模型可定义为(

并且

n维洛伦兹模型[15]是一个位于n+1维闵可夫斯基空间Rn+1中的超曲面, 对于v∈ Rn+1, q∈ Rn+1, 闵可夫斯基内积可以表示为

v* q=v

其中

给定负常数曲率-c, 则洛伦兹模型定义为

这些双曲空间上的模型之间是等距同构的, 相互之间可以转换[15].例如, 庞加莱模型上的任意点zR与克莱因模型上唯一对应的u之间的坐标可通过

$\begin{array}{l} \mathbf{R P}_{c}^{n} \rightarrow \mathbf{K}_{c}^{n}: \boldsymbol{u}=\frac{2 z^{R}}{1+c\left\|z^{R}\right\|^{2}}, \\ \mathbf{K}_{c}^{n} \rightarrow \mathbf{R P}_{c}^{n}: \boldsymbol{z}^{R}=\frac{\boldsymbol{u}}{\mathbf{1}+\sqrt{\left(1-c\|\boldsymbol{u}\|^{2}\right.}} \end{array}$

进行转换.而庞加莱模型上的任意点z和洛伦兹模型上唯一对应的点v=(v0, h)的相互转换公式为

$\begin{array}{l} \mathbf{R P}_{c}^{n} \rightarrow \mathbf{L}_{c}^{n}: \boldsymbol{v}=\left(\frac{1}{\sqrt{c}}\left(\frac{1+c\left\|z^{R}\right\|^{2}}{1-c\left\|z^{R}\right\|^{2}}\right), \frac{2 z^{R}}{1-c\left\|z^{R}\right\|^{2}}\right), \\ \mathbf{L}_{c}^{n} \rightarrow \mathbf{R P}_{c}^{n}: z^{R}=\frac{\boldsymbol{h}}{1+\sqrt{c} v_{0}} . \end{array}$

双曲空间模型之间的等距同构变换意味着只需要在其中一个模型上设计算法.与双曲神经网络和双曲核函数等现有工作一致[13, 23], 本文主要利用庞加莱模型设计双曲算法.

莫比乌斯陀螺空间是一个具有莫比乌斯陀螺距离的度量空间, 为庞加莱模型提供代数形式[26].

∀ zi∈ Pc, zj∈ Pc,

zic zj=

zic zj=zic(-zj)=

莫比乌斯陀螺距离的定义可以拓展到高维空间[28], 即当zi∈

另外, 莫比乌斯陀螺矢量空间上的陀螺测地线即为庞加莱模型上的测地线, 庞加莱测地线距离可以由莫比乌斯陀螺距离推断而来, 即

$\begin{aligned} d\left(z_{i}, z_{j}\right)= & \frac{2}{\sqrt{c}} \tanh ^{-1}\left(\sqrt{c} d_{\ominus_{c}}\left(z_{i}, z_{j}\right)\right)= \\ & \frac{2}{\sqrt{c}} \tanh ^{-1}\left(\sqrt{c}\left|z_{j} \Theta_{c} z_{i}\right|\right), \end{aligned}$

其中zi∈

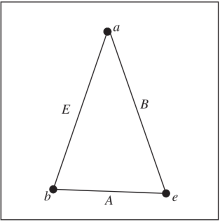

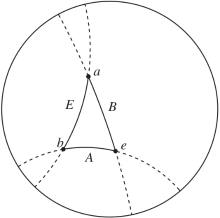

图1和图2分别表示欧氏空间对应的向量空间与庞加莱模型对应的莫比乌斯陀螺矢量空间[26].

图1表示常见的向量空间以及向量空间上的三角形, a、b、e分别表示三角形的三个顶点, A、B、E分别表示顶点对应的边, 则三条边的长度分别为

d(A)=|b-e|, d(B)=|e-a|, d(E)=|a-b|.

双曲空间中也有类似的性质.如图2所示, 在双曲空间设定下, 莫比乌斯陀螺矢量空间上垂直于边界的圆弧(虚线)表示庞加莱模型上的“ 直线” , 即测地线.实线部分表示测地线构成的“ 莫比乌斯陀螺三角形” , 其中, a、b、e分别表示三角形的三个顶点, A、B、E分别表示顶点对应的边, 则莫比乌斯陀螺三角形上的边“ 长度” , 即莫比乌斯陀螺距离分别为

$\begin{array}{l} d_{\Theta_{c}}(A)=\left|b \ominus_{c} e\right|, \\ d_{\Theta_{c}}(B)=\left|e \ominus_{c} a\right|, \\ d_{\Theta_{c}}(E)=\left|a \Theta_{c} b\right| . \end{array}$

受到这些理论的启发, 本文构造基于莫比乌斯陀螺空间上的核方法.

本文基于莫比乌斯陀螺距离, 提出莫比乌斯高斯核(MGauss)和莫比乌斯拉普拉斯核(MLap), 并证明核函数的正定性.

径向基核是欧氏空间中经典的核函数之一, 只依赖于参数之间的距离大小, 最常用的径向基核是高斯核和拉普拉斯核[29].高斯核为

$k^{\text {Gauss }}\left(\boldsymbol{x}_{i}, \boldsymbol{x}_{j}\right)=\exp \left(-\frac{\left|\boldsymbol{x}_{i}-\boldsymbol{x}_{j}\right|^{2}}{2 \xi^{2}}\right), \xi> 0, $

其中xi∈ Cn, xj∈ Cn, |xi-xj|表示xi、xj之间的欧氏距离, ξ > 0表示高斯核的带宽.可使用双曲测地线距离代替欧氏距离构造双曲高斯核.然而文献[23]的工作表明, 直接使用测地线距离构造的高斯核函数不是正定的.

本文使用莫比乌斯陀螺距离代替欧氏距离, 构造双曲高斯核函数.具体地, 该双曲高斯核表示为

$\begin{aligned} k^{\mathrm{MGauss}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)= & \exp \left(-\frac{d_{\Theta_{c}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)^{2}}{2 \xi^{2}}\right)= \\ & \exp \left(-\frac{1}{2 \xi^{2}}\left|\frac{\boldsymbol{z}_{i}-\boldsymbol{z}_{j}}{1-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle}\right|^{2}\right), \\ \xi> 0, & \end{aligned}$ (2)

其中, zi∈ Cn, zj∈ Cn,

2.1.1 正定性证明

下面证明莫比乌斯高斯核的正定性.首先给出正定核函数和负定核函数的定义[30].

定义1(正定核函数和负定核函数) 令Z表示一个非空集合.对于任意zi∈ Z, zj∈ Z和有限个λ 1∈ C, λ 2∈ C, …, λ m∈ C, 如果核函数k∶ (Z× Z)→ C满足

$\sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j} k\left(z_{i}, z_{j}\right) \geqslant 0$

则核函数k称为正定核.反之, 若核函数满足

$\sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j} k\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right) \leqslant 0, $

且

$\sum_{i=1}^{m} \lambda_{i}=0, $

则核函数k称为负定核.

给定正定核和负定核的定义之后, 定理1建立两者之间的联系[26].

定理1[26] 令Z表示一个非空集并且

k∶ (Z× Z)→ C

是一个核函数.Φ (zi, zj)表示zi、zj的函数, 当且仅当Φ (zi, zj)是负定时, 核函数

k(zi, zj)=exp(-γ Φ (zi, zj))

对于所有γ > 0是正定的.

而对于莫比乌斯空间, 其本身与再生核希尔伯特空间存在联系[31], 具体如下.令

$\mathbf{D}_{c}^{n}=\left\{\boldsymbol{z} \in \mathbf{C}^{n}: c\|\boldsymbol{z}\|^{2}< 1, c> 0\right\}$

表示半径为

$\delta^{\mathbf{D}_{c}^{n}}\left(z_{i}, z_{j}\right)=\sqrt{1-\left|\left\langle\hat{k}_{z_{i}}, \hat{k}_{z_{j}}\right\rangle\right|^{2}}, $

其中

表示规格化核函数.当该核函数

时, 度量

$\begin{aligned} \delta^{\mathbf{D}_{c}^{n}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)= & \sqrt{1-\frac{\left(1-c\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{i}\right\rangle\right)\left(1-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{j}\right\rangle\right)}{\left|1-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle\right|^{2}}}= \\ & \sqrt{c}\left|\frac{\boldsymbol{z}_{i}-\boldsymbol{z}_{j}}{1-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle}\right| \end{aligned}$

故

即

代入式(2), 莫比乌斯高斯核可写成

$\begin{aligned} k^{\mathrm{MGauss}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right) & =\exp \left(-\frac{\delta^{\mathbf{D}_{c}^{n}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)^{2}}{c \xi^{2}}\right)= \\ & \exp \left(-\frac{1}{c \xi^{2}}\left(1-\mid\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}||^{2}\right)\right), \right. \end{aligned}$ (3)

其中, ξ > 0, c> 0.

因此, 证明莫比乌斯高斯核的正定性可以转化为证明等式(3)中的核函数的正定性.根据定理1, 由于

要证明式(3)的正定性, 只需证明如下引理1.

引理1 函数

$\begin{aligned} \Phi:\left(\mathbf{D}_{c}^{n} \times \mathbf{D}_{c}^{n}\right) \rightarrow & \mathbf{C}: \Phi\left(z_{i}, z_{j}\right)= \\ & \delta^{\mathbf{D}_{c}^{n}}\left(z_{i}, z_{j}\right)^{2}= \\ & \left.1-|| \frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right\rangle\left.\right|^{2} \end{aligned}$

是负定的.

证明 1)证明核函数

的正定性.根据麦克劳林公式, 核函数

可以转换为

即正定核函数

$\begin{aligned} \sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j} k^{\mathbf{D}_{c}^{n}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)= & \sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j}\left(\sum_{l=0}^{\infty} c^{l}\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right\rangle^{l}\right)= \\ & \sum_{l=0}^{\infty} c^{l}\left(\sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j}\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right\rangle^{l}\right), \end{aligned}$

由于cl> 0且

$\begin{array}{l}\sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j}\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right\rangle^{l} \geqslant 0, \end{array}$

因此

$\begin{array}{l} \sum_{l=0}^{\infty} c^{l}\left(\sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j}\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right\rangle^{l}\right) \geqslant 0, \end{array}$

则

$\begin{array}{l} k^{\mathbf{D}_{c}^{n}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)=\frac{1}{1-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle} \end{array}$

为正定核函数.

2)证明

的正定性.由于

$\begin{array}{l} \left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|> 0, \left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|> 0, \\ \sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j}\left(\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right) \geqslant 0 \end{array}$

成立,

$\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right\rangle$

是正定的, 则

$\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right\rangle$

也是正定的.因此

$\left|\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{j}}^{\mathbf{D}_{c}^{n} \mid}}\right\rangle\right|^{2}=\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{j}}^{\mathbf{D}_{c}^{n} \mid}}\right\rangle \overline{\left|\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{i}}^{\mathbf{D}_{c}^{n} \mid}}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{j}}^{\mathbf{D}_{c}^{n} \mid}}\right\rangle}$

仍然是正定的[27], 即

$\sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j}\left|\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{i}}^{\mathbf{D}_{c}^{n} \mid}}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right\rangle\right| \geqslant 0$

3)证明

$\left.\Phi\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)=1-|| \frac{k_{z_{i}}^{\mathbf{D}_{n}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right\rangle\left.\right|^{2}$

是条件负定的.在

时,

$\begin{array}{l} \sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j} \Phi\left(z_{i}, z_{j}\right)= \\ \sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j}\left(1-\left|\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right\rangle\right|^{2}\right)= \\ \left(\sum_{i=1}^{n} \lambda_{i}\right)\left(\sum_{j=1}^{n} \bar{\lambda}_{j}\right)-\sum_{\substack{i=1 \\ j=1}}^{m} \lambda_{i} \bar{\lambda}_{j} \mid\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \left.\frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right|^{2}=\right. \\ -\sum_{\substack{j=1 \\ i=1}}^{n} \lambda_{i} \bar{\lambda}_{j}\left|\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n} \mid}\right|}\right\rangle\right|^{2}< 0, \end{array}$

因此

$\left.\Phi\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)=1-|| \frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \frac{k_{z_{j}}^{\mathbf{D}_{n}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right\rangle\left.\right|^{2}$

是负定的[26], 引理1得证. 证毕.

综上所述, 在证明引理1后, 根据定理1和等式(3), 可以证明莫比乌斯高斯核是正定的.

2.1.2 实数空间上的莫比乌斯高斯核

莫比乌斯高斯是定义在复庞加莱模型上的, 但是实际的机器学习任务多数是在实数空间上进行的, 因此本文将该核函数转换为实数空间上的运算.

类似莫比乌斯加法的实运算[26], 也可以在实数空间上表示莫比乌斯减法.令zi∈ C, zj∈ C,

$\begin{array}{c} \mathbf{C}^{n} \ni \boldsymbol{z}_{i} \ominus_{c} \boldsymbol{z}_{j}= \\ \frac{z_{i}-\boldsymbol{z}_{j}}{1-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle}= \\ \frac{\left(1-c\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right\rangle\right)\left(\boldsymbol{z}_{i}-\boldsymbol{z}_{j}\right)}{\left(1-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle\right)\left(1-c\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right\rangle\right)}= \\ \frac{\left(1-c\left\langle\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right\rangle-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle+c\left\|\boldsymbol{z}_{j}\right\|^{2}\right) \boldsymbol{z}_{i}-\left(1-c\left\|\boldsymbol{z}_{i}\right\|^{2}\right) \boldsymbol{z}_{j}}{1-c\left\langle\boldsymbol{z}_{i}, z_{j}\right\rangle-c\left\langle\boldsymbol{z}_{j}, \boldsymbol{z}_{i}\right\rangle+c^{2}\left|z_{i}\right|^{2}\left|z_{j}\right|^{2}}= \\ \frac{\left(1-2 c \boldsymbol{z}_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c\left\|\boldsymbol{z}_{j}^{\mathbf{R}}\right\|^{2}\right) z_{i}^{\mathbf{R}}-\left(1-c\left\|\boldsymbol{z}_{i}^{\mathbf{R}}\right\|^{2}\right) \boldsymbol{z}_{j}^{\mathbf{R}}}{1-2 c \boldsymbol{z}_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c^{2}\left\|\boldsymbol{z}_{i}^{\mathbf{R}}\right\|^{2}\left\|\boldsymbol{z}_{j}^{R}\right\|^{2}}= \\ \boldsymbol{z}_{i}^{\mathbf{R}} \ominus_{c} z_{j}^{\mathbf{R}} \in \mathbf{R}^{2} . \end{array}$ (4)

该结论可以拓展到高维空间, 即当

zi∈ Cn, zj∈ Cn,

式(4)仍然成立.令

为n维实庞加莱模型上的数据, 则式(1)中定义的莫比乌斯陀螺距离可以转变为实空间上的如下运算:

$\begin{array}{l} d_{\ominus_{c}}^{\mathbf{R}}\left(z_{i}^{\mathbf{R}}, z_{j}^{\mathbf{R}}\right)=\left\|z_{j}^{\mathbf{R}} \ominus_{c} z_{i}^{\mathbf{R}}\right\|= \\ \left\|\frac{\left(1-2 c z_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c\left\|z_{j}^{\mathbf{R}}\right\|^{2}\right) z_{i}^{\mathbf{R}}-\left(1-c\left\|z_{i}^{\mathbf{R}}\right\|^{2}\right) z_{j}^{\mathbf{R}}}{1-2 c z_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c^{2}\left\|z_{i}^{\mathbf{R}}\right\|^{2}\left\|z_{j}^{\mathbf{R}}\right\|^{2}}\right\|, \end{array}$ (5)

代入式(2), 可得实庞加莱球上的莫比乌斯高斯核:

$k^{\mathrm{MGauss}}\left(z_{i}^{\mathbf{R}}, z_{j}^{\mathbf{R}}\right)=\exp \left(-\frac{d_{\Theta_{c}}^{\mathbf{R}}\left(z_{i}^{\mathbf{R}}, z_{j}^{\mathbf{R}}\right)^{2}}{2 \xi^{2}}\right)=\exp \left(-\frac{\left\|\left(1-2 c z_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c\left\|z_{j}^{\mathbf{R}}\right\|^{2}\right) z_{i}^{\mathbf{R}}-\left(1-c\left\|z_{i}^{\mathbf{R}}\right\|^{2}\right) z_{j}^{\mathbf{R}}\right\|^{2}}{2 \xi^{2}\left(1-2 c z_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c^{2}\left\|z_{i}^{\mathbf{R}}\right\|^{2}\left\|z_{j}^{\mathbf{R}}\right\|^{2}\right)^{2}}\right), \xi> 0 .$

在欧氏空间中, 拉普拉斯核可写为

$\begin{array}{l} k^{\text {Lap }}\left(\boldsymbol{x}_{i}, \boldsymbol{x}_{j}\right)=\exp \left(-\frac{\left|\boldsymbol{x}_{i}-\boldsymbol{x}_{j}\right|}{\xi}\right), \\ \xi> 0 \end{array}$

其中, xi∈ Cn, xj∈ Cn, 且

$\begin{array}{l} k^{\mathrm{MLap}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)=\exp \left(-\frac{d_{\Theta_{c}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)}{\xi}\right), \\ \xi> 0 . \end{array}$ (6)

代入

可得到莫比乌斯拉普拉斯核:

$\begin{array}{l} k^{\mathrm{MLap}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)= \\ \quad \exp \left(-\frac{1}{\sqrt{c} \xi} \sqrt{1-\mid\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \left.\frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\left|k_{z_{j}}^{\mathbf{D}_{c}^{n}}\right|}\right|^{2}\right.}\right) . \end{array}$

2.2.1 正定性证明

定理2[26] 如果k∶ (Z× Z)→ C为一个负定核函数并满足k(zi, zj)≥ 0, 则对于0< α < 1, kα 仍然是负定的.

结合定理1、引理1和定理2, 由于

1-

是负定的, 令α =

$\begin{array}{c} \sqrt{1-\mid\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{n}^{n}}}{\left|k_{z_{i}}^{\mathbf{D}_{c}^{n}}\right|}, \left.\frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{j}}^{\mathbf{D}_{c}^{n} \mid}}\right|^{2}\right.}= \\ \left(1-\left|\left\langle\frac{k_{z_{i}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{i}}^{\mathbf{D}_{c}^{n} \mid}}, \frac{k_{z_{j}}^{\mathbf{D}_{c}^{n}}}{\mid k_{z_{j}}^{\mathbf{D}_{c}^{n} \mid}}\right\rangle\right|^{2}\right)^{\alpha} \end{array}$

也是负定的, 进而可得莫比乌斯拉普拉斯核也是正定的.

2.2.2 实数空间上的莫比乌斯拉普拉斯核

对于式(6), 使用式(5), 即实数空间上的莫比乌斯陀螺距离

$\begin{array}{l} k^{\mathrm{MLap}}\left(z_{i}, z_{j}\right)=\exp \left(-\frac{d_{\Theta_{c}}^{\mathbf{R}}\left(z_{i}^{\mathbf{R}}, z_{j}^{\mathbf{R}}\right)}{\xi}\right)= \\ \exp \left(-\frac{\left\|\left(1-2 c z_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c\left\|z_{j}^{\mathbf{R}}\right\|^{2}\right) z_{i}-\left(1-c\left\|z_{i}^{\mathbf{R}}\right\|^{2}\right) z_{j}^{\mathbf{R}}\right\|}{\xi\left(1-2 c z_{i}^{\mathbf{R}} z_{j}^{\mathbf{R}}+c^{2}\left\|z_{i}^{\mathbf{R}}\right\|^{2}\left\|z_{j}^{\mathbf{R}}\right\|^{2}\right)}\right), \\ \xi> 0 . \end{array}$

其中,

本文在Facebook[32]、PIT[33]、Wiki[34]、Amazon Electronics Computers(AEC)[35]、Cora ML[36]这5个社交网络数据集上进行实验.

1)Facebook数据集.2007年收集的用于表示4类蓝色认证的Facebook页面网络之间互相喜欢关系.本文在实验中选择频率最高的前2 489个节点.

2)PIT数据集.马里兰大学信息和网络动力学实验室收集的数据集, 实验中保留614个样本和3个类别.

3)Wiki数据集.2007年从英文维基百科收集的文章网络.在实验中保留2 123个样本和10个类别.

4)AEC数据集.亚马逊共同购买图[37]的一部分, 节点表示商品, 边表示商品一起购买.实验中选择样本数最多的3类, 并按比例随机抽取2 500个样本.

5)Cora ML数据集.从Cora数据集[38]中提取的图.实验中保留2 507个节点和5个类别.

对于每个数据集, 分别利用庞加莱嵌入算法[11]和Deepwalk[39]将其嵌入2、5、10和25维双曲空间和欧氏空间, 再用不同的核函数支持向量机对样本进行分类.

本文选用如下评价指标:多分类精度的均值(Average Multiple Classification Accuracy, ACC)、ROC(Receiver Operating Characteristic Curve)曲线下面积(Area Under Curve, AUC)和平均查准率-查全率曲线下面积(Area Under Precision-Recall Curve, AUPR).

为了保证方法的泛化性, 减少过拟合, 各算法都分别在每个数据集不同维度的双曲嵌入和欧氏嵌入上至少进行10轮二次交叉验证, 再求其平均值和方差.另外, 实验结果中也给出每种算法在每个指标上取得最好效果的次数(记为Top1 Times).

为了体现本文方法的莫比乌斯高斯核 (kMGauss)、莫比乌斯拉普拉斯核(kMLap)有效性, 选择现有的双曲核和欧氏核进行对比, 对比函数包括双曲空间上的核函数与欧氏空间上的核函数.

双曲核函数包括由Fang等[23]定义在庞加莱模型上的Hyperbolic RBF Kernel, Hyperbolic Laplace Kernel, Hyperbolic Binomial Kernel, Hyperbolic Tan-gent Kernel.在这些核函数中[23],

$f(z)=\tanh ^{-1}(\sqrt{c}\|z\|) \frac{z}{\sqrt{c}\|z\|}, c> 0, $

其中z∈ R

1)Hyperbolic RBF Kernel[23].

$\begin{array}{l} k^{\mathrm{HGauss}}\left(\boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)=\exp \left(-\frac{\left\|f\left(\boldsymbol{z}_{i}\right)-f\left(\boldsymbol{z}_{j}\right)\right\|^{2}}{2 \xi^{2}}\right), \\ \xi> 0, \boldsymbol{z}_{i} \in \mathbf{R P}_{c}^{n}, \boldsymbol{z}_{j} \in \mathbf{R} \mathbf{P}_{c}^{n} . \end{array}$

2)Hyperbolic Laplace Kernel[23].

$\begin{array}{l} k^{\text {HLap }}=\exp \left(-\frac{\left\|f\left(\boldsymbol{z}_{i}\right)-f\left(\boldsymbol{z}_{j}\right)\right\|}{\xi}\right), \\ \xi> 0, \boldsymbol{z}_{i} \in \mathbf{R P}_{c}^{n}, \boldsymbol{z}_{j} \in \mathbf{R} \mathbf{P}_{c}^{n} . \end{array}$

3)Hyperbolic Binomial Kernel[23].

$\begin{array}{l} k^{\mathrm{HBin}}=\left(1-\left\langle f\left(\boldsymbol{z}_{i}\right), f\left(\boldsymbol{z}_{i}\right)\right\rangle\right)^{-\alpha}, \\ \alpha> 0, \boldsymbol{z}_{i} \in \mathbf{R} \mathbf{P}_{c}^{n}, \boldsymbol{z}_{j} \in \mathbf{R} \mathbf{R}_{c}^{n} . \end{array}$

4)Hyperbolic Tangent Kernel[23].

$\begin{array}{l} k^{\mathrm{HTang}}=\left\langle f\left(\boldsymbol{z}_{i}\right), f\left(\boldsymbol{z}_{i}\right)\right\rangle, \\ \boldsymbol{z}_{i} \in \mathbf{R} \mathbf{R}_{c}^{n}, \boldsymbol{z}_{j} \in \mathbf{R} \mathbf{P}_{c}^{n} . \end{array}$

5)Hyperbolic Polynomial Kernel[22].

$\begin{array}{l} k^{\mathrm{HPloy}}= \\ \frac{k^{E}\left(g\left(\boldsymbol{v}_{i}\right), g\left(\boldsymbol{v}_{j}\right)\right)-1}{\sqrt{\left(1-k^{E}\left(g\left(\boldsymbol{v}_{i}\right), g\left(\boldsymbol{v}_{i}\right)\right)\right)\left(1-k^{E}\left(g\left(\boldsymbol{v}_{j}\right), g\left(\boldsymbol{v}_{j}\right)\right)\right)}}, \\ k^{E}\left(\boldsymbol{v}_{i}, \boldsymbol{v}_{j}\right)=\left(\boldsymbol{v}_{i}, \boldsymbol{v}_{j}\right)^{\alpha}, \end{array}$

α > 0表示多项式的次数,

$\begin{array}{l} \boldsymbol{v}=\left(v_{0}, v_{1}, \cdots, v_{n}\right) \in \mathbf{L}^{n}, \\ g(\boldsymbol{v})=\left(\frac{v_{1}}{v_{0}}, \frac{v_{2}}{v_{0}}, \cdots, \frac{v_{n}}{v_{0}}\right), \end{array}$

表示将v的坐标从洛伦兹模型映射到Klein模型上.

6)Hyperbolic SVM[22].双曲线性SVM, 优化目标kHLinear为

$\begin{array}{l} \min _{\boldsymbol{w} \in \mathbf{R}^{n+1}}\left(-\frac{1}{2} \boldsymbol{w} * \boldsymbol{w}+\beta \sum_{i=1}^{m} l\left(\boldsymbol{w} * \boldsymbol{z}^{i}\right)\right), \\ \text { s. t. } \boldsymbol{w} * \boldsymbol{w}< 0, \end{array}$

其中

l(· )=max(0, sinh-1(1)-sinh-1(· )),

* 表示闵可夫斯基内积, zi∈ Ln表示嵌入在洛伦兹模型上的样本, w表示决定分类超平面的法向量, β > 0表示一个常数.HLinear可以看作是双曲线性核.

欧氏空间上的核函数包括Gaussian Kernel[29], Laplace Kernel[40], Polynomial Kernel[29].函数具体形式如下.

1)Gaussian Kernel[29].

$\begin{array}{l} k^{\mathrm{EGauss}}=\exp \left(-\frac{\left\|\boldsymbol{x}_{i}-\boldsymbol{x}_{j}\right\|^{2}}{2 \xi^{2}}\right), \\ \xi> 0, \boldsymbol{x}_{i} \in \mathbf{R}^{n}, \boldsymbol{x}_{j} \in \mathbf{R}^{n} . \end{array}$

2)Laplace Kernel[40].

$\begin{array}{l} k^{\text {ELap }}=\exp \left(-\frac{\left\|\boldsymbol{x}_{i}-\boldsymbol{x}_{j}\right\|}{\xi}\right) \\ \xi> 0, \boldsymbol{x}_{i} \in \mathbf{R}^{n}, \boldsymbol{x}_{j} \in \mathbf{R}^{n} \end{array}$

3)Polynomial Kernel[29].

$\begin{array}{l} k^{\mathrm{EPloy}}=\left(\gamma \boldsymbol{x}_{i} \boldsymbol{x}_{j}+1\right)^{\alpha}, \\ \gamma> 0, \alpha> 0, \boldsymbol{x}_{i} \in \mathbf{R}^{n}, \boldsymbol{x}_{j} \in \mathbf{R}^{n} . \end{array}$

本文还进行显著性测试, 将所有对比函数与kMLap在显著性水平0.05下进行成对t检验.在每个结果后面使用• /* 来表明是否kMLap显著优于或劣于对比函数, • 表示显著优于对比函数, * 表示显著劣于对比函数.

对于每个核函数, 本文利用SVM在每个数据集上进行图节点分类.对比的核函数中, kHPoly是不定的, 其余都是正定的.对于正定核, 利用凸优化求解SVM[41], 对于双曲多项式核, 利用Kreǐ n SVM[42]求解.

另外, 对于kMLap和kMGauss, 参数ξ 采用交叉验证, 从集合{2-6, 2-5, …, 26}中选取.相应地, kHGuass、kHLap、kEGauss、kELap也是如此.对于kHPoly, 多项式次数α 固定为2.对于kEPloy, γ 从集合{0.01, 0.1, 1, 10}中选择, α 固定为2.另外, kMGauss、kMLap、kHGauss、kHLap、kHTang、kHBin中的曲率参数c也通过交叉验证从集合{2-6, 2-5, …, 26}中获取.

各对比函数在6个数据集上的ACC、AUC和AUPR指标值对比如表1~表3所示, 表中黑体数字表示最优值.由表可见, kMLap和kMGauss在不同指标上的Top1 Times最大, 性能最佳, t检验结果也表明该结果具有统计学意义.

| 表1 各核函数在5个数据集上的平均ACC对比 Table 1 Average ACC comparison of different kernel functions on 5 datasets |

| 表2 各核函数在5个数据集上的平均AUC对比 Table 2 Average AUC comparison of different kernel functions on 5 datasets |

| 表3 各核函数在5个数据集上的平均AUPR对比 Table 3 Average AUPR comparison of different kernel functions on 5 datasets |

对比现有双曲核, 发现本文的核函数在不同的评价指标上都有显著提升.相比kHGauss、kHLap、kHTang、kHBin和kHPoly, 在ACC评价指标上, kMLap分别提升2.7%、2.1%、17.4%、4.9%和9.9%, 在AUC指标上, kMLap分别提升3.2%、1.2%、17.5%、4.7%和11.5%, 在AUPR指标上, kMLap分别提升4.8%、2.6%、24.9%、9.2%和16.2%.kMLap性能的提升, 验证利用莫比乌斯陀螺距离构造的核函数, 能够减小将数据映射到切空间上造成的扭曲, 提升核函数的映射能力.对比kHPoly的性能优越性验证kMLap的自适应能力.另外, 对比双曲线性分类, 发现所有的双曲核函数都具有明显的性能提升, 这说明双曲核函数的有效性.

对比欧氏空间上对应的核函数, 发现kMGauss和kMLap提升更加显著.相比kEGauss, kMGauss在ACC、AUC和AUPR指标上分别提升7.0%、5.4%和9.4%, 相比kELap, kMLap在ACC、AUC和AUPR指标上分别提升 7.2%、4.2%和8.3%.这不仅表明本文方法的有效性, 也验证双曲空间具有更强大的表征能力.

另外, 对于kMGauss和kMLap, 很低的维度就能达到与高维相差不大的效果, 而欧氏空间中核函数的分类效果明显地随着嵌入维度的升高而提升, 即使在25维也很难达到与双曲嵌入相当的效果.这个结论进一步验证双曲空间对于层次结构数据的强大表征能力.

为了充分探讨庞加莱模型曲率参数c对于MGauss和MLap的影响, 在Facebook、Terrorist、Wiki、AEC、Cora ML数据集的10维庞加莱嵌入上利用核SVM进行图节点分类.

核函数在不同评价指标上的分类性能变化如图3~图5所示.由图可以观察到:1)在不同的指标上, MGauss和MLap变化趋势都很接近, 这主要取决于核函数形式的相似性, 两者都是基于莫比乌斯陀螺距离的径向基核.2)当c较小时, MGauss和MLap在不同指标上都较平稳, 能得到较优性能, 这说明核函数的鲁棒性.3)当c值过大时, 不同指标下的分类性能都有所下降, 这说明庞加莱模型的曲率确实会影响核函数的性能, 因此把c作为核函数的参数有助于提高核函数的自适应能力.

| 图3 c不同时MGauss和MLap在5个数据集上的ACC指标对比Fig.3 ACC comparison of MGauss and MLap with different c on 5 datasets |

| 图4 c不同时MGauss和MLap在5个数据集上的AUC指标对比Fig.4 AUC comparison of MGauss and MLap with different c on 5 datasets |

| 图5 c不同时MGauss和MLap在5个数据集上的AUPR指标对比Fig.5 AUPR comparison of MGauss and MLap with different c on 5 datasets |

另外, 注意到当c很小时, MGauss和MLap趋向于Gaussian Kernel和Laplace Kernel, 但是由表1~表3中的结果可知, 在欧氏映射数据上利用Gaussian Kernel和Laplace Kernel效果与在双曲映射数据上利用MGauss和MLap的对比进一步说明双曲空间能更好地表征层次结构数据.另外, 虽然MGauss和MLap在c值趋向于0时趋向Gaussian Kernel和Laplace Kernel, 也许在双曲映射数据上直接利用Gaussian Kernel和Laplace Kernel也能取得较优效果, 但是在双曲空间上利用欧氏方法本身是不合理的.而 MGauss和MLap既符合双曲几何的设定, 又有足够好的性能, 是处理层次结构数据更好的选择.

基于庞加莱模型, 本文提出基于莫比乌斯陀螺矢量空间的双曲正定核方法.利用莫比乌斯陀螺矢量空间与庞加莱模型之间的关系, 使用莫比乌斯陀螺距离代替欧氏距离, 设计莫比乌斯高斯核和莫比乌斯拉普拉斯核, 并进一步证明核函数的正定性.曲率绝对值作为核函数的参数, 可提高核函数的自适应性.莫比乌斯陀螺矢量空间的使用保证双曲数据的极小失真.进一步将核函数计算从复空间转换到实空间上, 使核函数更适用于实际任务.在真实数据集上的实验验证莫比乌斯高斯核和莫比乌斯拉普拉斯核的优越性.今后将进一步拓展双曲空间上的核方法, 如多核学习、深度核学习等.

本文责任编委 于 剑

Recommended by Associate Editor YU Jian

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|