叶海良,博士,讲师.主要研究方向为深度学习、图神经网络、图像处理、点云分析等.E-mail:yhl575@163.com.

作者简介:

蒋清婷,硕士研究生,主要研究方向为深度学习、图神经网络、医学图像处理.E-mail:jqt0723@163.com.

曹飞龙,博士,教授,主要研究方向为深度学习、图像处理等.E-mail:icteam@163.com.

卷积神经网络由于强大的特征提取能力在医学图像分割任务上取得一定进展,但仍需提升边缘分割的准确性.为此,文中提出基于边缘选择图推理的三路径网络,包括目标定位路径、边缘选择路径和细化路径.在目标定位路径中,设计多尺度特征融合模块,聚合高级特征,实现病变区域的定位.在边缘选择路径中,构造边缘选择图推理模块,用于低级特征的边缘筛选,并进行图推理,保证病变区域的边缘形状.在细化路径中,建立渐进式组级细化模块,逐步细化不同尺度特征的结构信息与细节信息.此外,引入融合加权Focal Tversky 损失和加权交并比损失的复合损失,减轻类不平衡的影响.在公开数据集上的实验表明,文中方法性能较优.

YE Hailiang, Ph.D., lecturer. His research interests include deep learning, graph neural networks, image processing and point cloud analysis.

About Author:

CAO Feilong, Ph.D., professor. His research interests include deep learning and image processing.

JIANG Qingting, Master student. Her research interests include deep learning, graph neural networks and medical image proce-ssing.

Convolutional neural networks make certain progress in medical image segmentation tasks due to their powerful feature extraction capabilities. However, the accuracy of edge segmentation still needs to be improved. To address this problem, a triplet-path network based on edge selection graph reasoning is proposed in this paper, including the target localization path, edge selection path and refinement path. In the target localization path, a multi-scale feature fusion module is designed to aggregate high-level features for the localization of lesion regions. In the edge selection path, an edge-selective graph reasoning module is constructed for edge screening of low-level features and graph reasoning to ensure the edge shape of the relevant lesion region. In the refinement path, a progressive group level refinement module is established to refine the structure information and details of different scale features. Moreover, a composite loss fusing weighted Focal Tversky loss and a weighted intersection over union loss is introduced to mitigate the effects of class imbalance. Experimental results on public datasets demonstrate the superior performance of the proposed method.

医学图像分割是医学图像处理和分析领域中复杂、重要的任务之一[1, 2].临床医生通常利用成像技术观察图像中器官等病变的情况, 以便在疾病的早期阶段进行干预[3].然而, 医学图像本身往往存在边缘模糊的问题, 使边缘分割的效果不够理想, 给临床医生的诊断带来巨大的障碍[4, 5].因此, 医学图像边缘的精准分割是一个极具前景的研究方向.

近年来, 卷积神经网络(Convolutional Neural Networks, CNN)在医学图像分割任务中取得重大进展.特别是, 2015年Ronneberger等[6]提出U-Net, 已成为后续许多医学图像分割方法研究的基准网络[7, 8].Zhou等[9]构造UNet++, 设计密集跳跃连接, 更好地利用不同尺度下解码器的特征.Gu等[10]引入空洞卷积, 提出CE-Net(Context Encoder Network).

然而, 上述方法在编码与解码过程中都连续采样, 容易导致空间信息和细节信息的丢失, 不利于医学图像的边缘分割[11].为此, 研究人员提出基于注意力机制的边缘细化方法[12, 13, 14]和基于CNN的边缘分割方法.Zhou等[15]提出CFA-Net(Cross-Level Feature Aggregation Network), 设计两个分割网络, 整合语义信息和边界信息.Fan等[16]提出PraNet(Parallel Reverse Attention Network), 引入反注意力模块, 关注病变区域外的边缘部分.Cao等[17]提出TSD-BA(Two-Stage Decoding Network with Boundary Attention), 利用粗预测作为先验, 进一步挖掘边界特征.然而, 上述方法仅考虑单独添加先验指导信息, 未考虑特征通道之间的不平衡性, 效果相对较弱, 很难保证边缘形状分割的连续性.

近年来, 图神经网络(Graph Neural Networks, GNN)在远程信息推理方面显示出巨大的潜力, 已逐渐应用于医学图像的分割任务中[18].对于CNN很难保证目标形状连续性的问题, GNN将形状的连续性编码为图的约束, 确保网络预测的连续性[19].Shin等[20]使用CNN和GNN的组合进行视网膜血管分割.Meng等[21]提出边界感知图卷积网络, 用于医学图像分割.进一步, Meng等[22]又提出一种基于GNN的区域和边界聚合网络.Wang等[23]提出CGRNet(Contour Guided Graph Reasoning Network).Liu等[24]提出MFBGR(Multi-scale Feature Boundary Graph Rea-soning Network for Polyp Segmentation).然而, 上述方法均通过图表示学习对边界特征进行推理, 忽略非目标边界信息的干扰, 容易造成目标边缘推理的错误.

为了更好地解决上述问题, 本文针对医学图像分割任务, 提出基于边缘选择图推理的三路径网络(Triplet-Path Network Based on Edge Selection Graph Reasoning, ESG-TNet), 借鉴由粗化到细化的策略, 实现逐步分割的思想.具体来说, ESG-TNet包括目标定位路径、边缘选择路径和细化路径.在目标定位路径中, 构造多尺度特征融合模块(Multi-scale Fea-ture Fusion Module, MFFM), 融合高层特征, 生成一个粗全局位置图.在边缘选择路径中, 设计边缘选择图推理模块(Edge Selection Graph Reasoning Module, ESGM), 选择突出的关键目标边缘特征进行图推理, 生成初始边缘分割图.在细化路径中, 将粗全局位置图作为初始指导图添加到浅层特征中, 构建渐进式组级细化模块(Progressive Group Refinement Module, PGRM), 进一步挖掘结构信息和细节信息.此外, 本文引入融合加权Focal Tversky 损失和加权交并比损失的复合损失, 缓解类不平衡的影响.

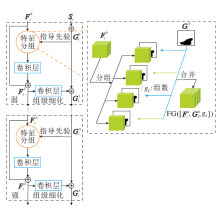

本文提出基于边缘选择图推理的三路径网络(ESG-TNet), 整体框架如图1所示.

ESG-TNet包括目标定位路径、边缘选择路径和细化路径.目标定位路径包含多尺度特征融合模块(MFFM), 聚合主干网络中最后三层的高级特征, 实现初始的粗全局位置图.边缘选择路径包含边缘选择图推理模块(ESGM), 选择突出的目标边缘特征进行图推理, 生成初始目标边缘特征图.细化路径将目标定位路径中得到的粗全局位置图作为初始指导先验添加到浅层特征中, 通过渐进式组级细化模块(PGRM)采取自下而上的方式进一步细化.

本文选择Res2Net-50[25]作为ESG-TNet的主干网络.Res2Net-50由1个卷积层、4个多层残差卷积块和1个全连接层组成.本文使用前5个卷积模块, 捕获5个不同分辨率的特征图.对于输入尺寸为H× W× C的图像X, 在主干网络中提取5个不同层次的特征图, 分别表示为F1, F2, …, F5, 分辨率分别为

其中Ci表示第i个特征通道数.

由于医学图像的低层特征存在复杂的背景区域, 容易导致不准确的目标分割.因此, 本文设计多尺度特征融合模块(MFFM), 聚合高层特征, 较准确地定位目标区域.故将该过程称为目标定位路径, 具体流程如图2所示.

为了不增加计算成本, 对最后三层的输入特征Fi进行降维操作, 每个分支使用1× 1卷积核, 将通道数减少到32, 即

F'i=σ (Wi* Fi), i=3, 4, 5,

其中, Wi表示1× 1的卷积核, * 表示卷积操作, σ (· )表示ReLU函数.

本文使用连续的卷积和拼接操作融合相邻两个分支的特征, 可得

其中, Ψ i、Φ i和Φ i+1表示3× 3的卷积核, Up(· )表示上采样操作, ‖ 表示拼接操作.经过同样的操作, 融合上述

其中Γ i、Qi和Qi+1表示3× 3的卷积核.

最后, 对特征

MFFM整合多层高级特征, 有效实现语义特征的融合, 较准确地定位目标区域.

在目标定位路径中, MFFM聚集最高的三层特征, 实现粗全局位置图.然而, 低级特征通常也包含大量的边界信息, 有利于目标边界的分割.现有方法往往忽略这点, 同时还忽略非目标边界信息的干扰, 容易造成边缘分割的错误.

因此, 本文提出边缘选择图推理模块(ESGM), 突出低级特征中的目标边界信息, 改善医学图像边缘分割的质量, 此过程称为边缘选择路径.ESGM流程图如图3所示.

具体地, 首先将低层特征F1和F2经过一个1× 1卷积层, 动态考虑不同通道中同一空间位置信息的重要性, 并根据相应的重要性对所有边缘信息进行聚合, 即

Ei=δ (Zi* Fi), i=1, 2,

其中, δ (· )表示Sigmoid函数, Zi表示1× 1的卷积核.然后, 设置多个阈值过滤信息, 确定边缘信息的位置.假设ESGM包含N个路径, 每个路径都使用一个阈值, 第j个路径的边缘置信图如下:

ECM

i=1, 2; j=1, 2, …, N,

其中, (m, n)表示空间坐标, τ j表示第j个路径对应的阈值.

通常确定相关信息的准则是:只有当Ei每个位置的元素大于或等于阈值时, 该位置才被识别为目标边缘位置.一般而言:设置一个较低的阈值意味着判断条件不严格, 可保留丰富的边缘信息, 但容易引入背景噪声; 设置一个高阈值意味着判断标准十分严格, 可收集有限且可靠的边缘信息, 但往往会丢弃一些潜在的边缘信息, 导致边缘信息的不完整.这两种设置在某种程度上是互补的.因此, 本文考虑一个融合低、中和高三路径信息的边缘选择, 综合考虑较低、适中和较高阈值的优势, 便于获得较好的初始目标边缘.

基于

其中,

最后, 利用图神经网络进行边缘图推理.将获取的

1)投影.将给定的初始边缘特征

转换成

Xi∈

再投影到一个新的节点特征

Vi=PiXi∈

其中Pi∈

2)图推理.从Vi中学习节点之间的连通性, 得到邻接矩阵:

Ai=(Bi* Vi)(Bi* Vi)T∈

其中Bi表示1× 1的卷积核.同时, 利用图卷积算子在节点之间传播消息.根据文献[26], 图卷积算子的定义为

其中,

Θ i表示可学习的参数.

3)逆投影.经过图卷积神经网络进行推理后, 可更新每个节点的特征.为了适应现有模型, 需要学习一个映射函数, 将更新的节点特征

Di=

与1)类似, 仍采用投影矩阵Pi实现.

综上所述, ESGM不仅考虑边缘特征的筛选, 过滤大量背景噪声的干扰, 还利用图推理网络保证边缘形状的连续性, 有效提升分割性能.

在目标定位路径中, MFFM聚集最高的三层特征, 捕获粗全局位置图.这些高级特征图中具有丰富的语义信息, 有利于目标定位, 但忽略结构和细节信息.为此, 本文构建渐进式组级细化模块(PGRM), 将粗预测图作为初始指导先验添加到浅层中, 通过弱、中和强三种渐进式指导方式逐步挖掘医学图像的结构信息和细节信息, 此过程称为细化路径.通过这种方式, 网络可识别更多医学图像的空间结构和细节信息, 并逐步交互细化.PGRM流程图如图4所示.

本文设计一个反向指导策略, 通过Sigmoid函数和反向操作, 得到反向指导先验:

其中, Down(· )表示下采样操作, E表示元素全为1的矩阵.

由于特征通道之间存在差异, 单独添加指导先验的作用相对较弱.受文献[27]的启发, 本文引入特征分组的思想, 充分利用通道之间的冗余性和差异性, 有效利用反向指导先验.同时, 结合弱、中、强三种渐进式的指导先验进一步细化特征.如图4所示, 将特征沿通道维度分成多组gk, 反向指导先验

其中,

或

经过PGRM细化后, 得到最终的分割预测:

Si=

综上所述, PGRM实现结构信息和细节信息的细化, 多阶段的细化模块更有利于提升分割性能.

受像素位置感知损失[28]的启发, 本文提出一个复合损失, 定义为

L=LwFTL+LwIoU.

其中:LwFTL表示用于局部约束的加权Focal Tversky损失, 可缓解医学图像的类不平衡问题; LwIoU表示用于全局约束的加权交并比损失.具体地, 加权Focal Tversky损失定义为

LwFTL=

其中, ϕ mn由中心像素与其周围的差值计算得到, γ 、η 表示超参数, TI表示Tversky指数[29],

TI=

ync表示第n个像素是否属于第C类,

LwIoU旨在优化全局约束, 不受不平衡分布的影响, 定义为

LwIoU=1-

其中ynm和

本文中所有的输出分割图都被上采样到与分割标签图G相同的大小, 因此, 总损失

Ltotal=

为了验证ESG-TNet的有效性, 选择结肠镜图像CVC-ClinicDB[30]、CVC-ColonDB[31]和乳腺超声图像BUS-B[32]这3个医学图像数据集进行实验.

CVC-ClinicDB数据集是一个公共的结肠镜数据库, 包含612幅结肠镜图像, 每幅图像尺寸为384× 288, 病变平均占比为9.3%± 7.76%.CVC-ColonDB数据集包含380幅结肠镜图像, 每幅图像尺寸为574× 500, 病变平均占比为7.45%± 10.8%.2个数据集的训练集和测试集比例与PraNet[16]一致, 均为9∶ 1.

BUS-B数据集包含163幅乳腺超声图像, 每幅图像都含有一个或多个病变区域, 每幅图像的尺寸是变化的, 病变平均占比为4.84%± 5.45%.与Atten-tion UNet[33]一样, 该数据集随机将75%的样本用于训练, 剩余25%的样本用于测试.

本文使用缩放、翻转、直方图匹配和旋转四种方式进行数据增强, 所有的输入图像尺寸统一调整为256× 256.优化器采用Adam(Adaptive Moment Es-timation)[34], 初始学习率设置为1e-4, 每20轮衰减一半.这3个数据集均训练100个迭代周期, 批大小设置为10.

所有实验均在NVIDIA RTX 2080Ti GPU上基于Pytorch框架实现.渐进式组级细化模块(PGRM)中分组为g0=1, g1=4, g2=32.在边缘选择中, 经验性设置超参数τ 1=0.3, τ 2=0.5, τ 3=0.7.在损失函数中, 经验性设置超参数γ =4, η =1.5.

本文采用DSC(Dice Score)[35]、交并比(Inter-section over Union, IoU)、精确度和召回率作为评价指标[36, 37].

为了验证ESG-TNet的医学图像分割性能, 本文选择如下对比方法.

2)基于注意力机制的方法:基于三重交互关注网络 (Triplet Interactive Attention Network, TIAN)[7]、SANet (Shallow Attention Network)[12]、AAU-Net (Adap-tive Attention U-Net)[13]、PVT-CASCADE (Pyramid Vi-sion Transformer and Cascaded Attention Decoder)[14].

3)基于边缘分割的方法:CFA-Net[15]、PraNet[16]、TSD-BA[17].

4)基于卷积神经网络和图神经网络结合的方法:CGRNet[23].

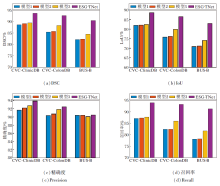

各方法在3个数据集上的指标值对比如表1~表3所示, 表中结果为5次实验的平均值, 黑体数字表示最优值.各方法可视化效果对比如图5~图7所示.

| 表1 各算法在CVC-ClinicDB数据集上的定量对比 Table 1 Quantitative comparison of different methods on CVC-ClinicDB dataset % |

| 表2 各算法在CVC-ColonDB数据集上的定量对比 Table 2 Quantitative comparison of different methods on CVC-ColonDB dataset % |

| 表3 各算法在BUS-B数据集上的定量对比 Table 3 Quantitative comparison of different methods on BUS-B dataset % |

| 图5 各算法在CVC-ClinicDB数据集上的视觉效果对比Fig.5 Visualization comparison of different algorithms on CVC-ClinicDB dataset |

| 图6 各算法在CVC-ColonDB数据集上的视觉效果对比Fig.6 Visualization comparison of different algorithms on CVC-ColonDB dataset |

从表1可以看出, 在CVC-ClinicDB数据集上, ESG-TNet在DSC、IoU和召回率指标上实现最优, 在精确度指标上取得第三优.尽管PraNet的精确度为94.85%, 但召回率只有91.86%, 这意味着该结果的假阴性较高、真阳性较低, 造成分割错误.因此, 只有较高的精度不足以表明其良好的分割性能, 而本文的损失函数有助于精确度和召回率之间的平衡.图5中对比方法存在不能正确识别病变区域的情况, 但ESG-TNet不仅能准确识别病变区域, 还能较好地保证边缘分割的形状.

从表2可以看出, 在CVC-ColonDB数据集上, ESG-TNet在DSC、IoU和召回率指标上实现最优, 在精确度指标上实现第三优.对比其它方法, ESG-TNet分别在DSC、IoU和召回率指标上至少提升0.85%, 0.28%和1.21%.从图6可看出, 对比方法不能有效定位病变区域的位置, 在区域边界分割上存在严重的分割不足, 难以分割正确的区域边界.

从表3可以看出, 在BUS-B数据集上, ESG-TNet在所有指标上均实现最优.由于该数据集存在严重的边缘模糊问题, 很难区分区域和背景, 导致分割困难.从图7可看出, 对比方法几乎难以分割区域及区域的边界, 而ESG-TNet能较好地定位病变区域的位置, 保证相对清晰和完整的病变区域的边界形状, 较好地克服该数据集的分割挑战.

总之:从定量的角度出发, ESG-TNet在各评价指标上都有显著改善; 从可视化的角度出发, ESG-TNet不仅可实现病变区域的准确识别, 还可较好地保证病变区域边界的相对完整.这都得益于ESG-TNet中的3个模块:1)MFFM结合高层次特征, 初步实现较好的目标定位; 2)ESGM利用底层特征丰富的边界信息, 经过选择和图推理, 保证较好的边界形状; 3)PGRM逐层细化, 进一步完善粗分割的结构信息和细节信息, 得到最终较完美的分割结果.

为了验证ESG-TNet中3个模块的有效性, 建立如下不同的组合模型进行消融实验.

1)模型1.移除ESG-TNet中所有模块, 仅有ESG-TNet的主干网络.

2)模型2.移除ESG-TNet中ESGM和PGRM, 即在模型1的基础上加入MFFM.

3)模型3.移除ESG-TNet中的PGRM, 即在模型2的基础上加入ESGM.

4)ESG-TNet.在模型3的基础上加入PGRM.

具体消融实验结果如图8所示.从图可看出, 在3个数据集上, 模型2中所有指标值均优于模型1.这表明MFFM对分割性能的提升有一定的作用.在模型2的基础上, 模型3的DSC、IoU和召回率指标均实现较大提升, 特别是在CVC-ColonDB数据集上, DSC、IoU和召回率指标都增长超过3%, 这表明ESGM能促进有效的分割.相比模型3, ESG-TNet中所有指标均实现显著的提升, 特别是在DSC指标上提升超过4%, 在IoU和召回率指标上提升超过6%, 这表明PGRM可极大提升分割性能.

综上所述, 在3个数据集上, MFFM、ESGM和PGRM都起到积极作用, 有利于提升医学图像分割的性能.

本节在CVC-ClinicDB数据集上讨论初始目标边缘选择中的阈值组合和损失函数中超参数的选择.记τ 1, τ 2和τ 3分别表示用于设置较低、适中和较高的阈值组合, 本文经验性选择3种组合进行实验, 具体指标值如表4所示, 表中黑体数字表示最优值.

| 表4 不同的阈值组合选取对ESG-TNet性能的影响 Table 4 Effect of different threshold combinations on ESG-TNet performance % |

由表4可见, 当τ 1=0.3, τ 2=0.5, τ 3=0.7时, 分割性能最优, 因此, 本文选择τ 1=0.3, τ 2=0.5, τ 3=0.7进行实验.类似地, 在另两个数据集上也经验性地选取τ 1=0.3, τ 2=0.5, τ 3=0.7进行实验.

本文还进一步讨论普通单一阈值法和无初始目标边缘选择对ESG-TNet性能的影响, 具体指标值对比如表5和表6所示, 表中黑体数字表示最优值. 从表5可看出, 相比普通的单一阈值法, ESG-TNet具有较好的性能提升.同时, 从表6可看出, 初始目标边缘选择有助于后续整体算法性能提升.

| 表5 ESG-TNet与单一阈值法在CVC-ClinicDB数据集上的性能对比 Table 5 Performance comparison of ESG-TNet and single threshold method on CVC-ClinicDB dataset % |

| 表6 有无初始目标边缘选择对ESG-TNet性能的影响 Table 6 ESG-TNet performance with or without initial target edge selection % |

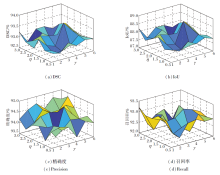

此外, 损失函数中超参数γ 和η 用于调整像素比例.本文经验性地选择 γ =1, 2, 3, 4, 5, 6和η =0.5, 1, 1.5, 2, 2.5, 3, 在CVC-ClinicDB数据集上进行实验.具体指标值如图9所示.

由图9可见, 当γ =4和η =1.5时, ESG-TNet分割效果最优.因此, 本文选择γ =4和η =1.5.类似地, 在另两个数据集也经验性选取γ =4和η =1.5进行实验.

本文提出基于边缘选择图推理的三路径网络(ESG-TNet), 该网络分别用于目标定位、边缘选择和细节细化.具体地:多尺度特征融合模块聚合高层次特征, 实现目标定位; 边缘选择图推理模块精准选择突出的目标边缘特征, 进行图推理; 渐进式组级细化模块用于细化结构信息和细节信息.此外, 本文引入融合加权Focal Tversky损失和加权交并比损失的复合损失, 减轻类不平衡的影响.在3个类不平衡的公共数据集上的一系列实验表明, ESG-TNet实现较优的分割性能.但是, ESG-TNet还存在可继续探索的空间, 如可尝试利用元学习策略进行超参数的自适应选择, 今后可考虑在这些方面展开研究.

本文责任编委 叶东毅

Recommended by Associate Editor YE Dongyi

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|