张万松,博士,副教授,主要研究方向为仿真建模、模式识别.E-mail:zhangwansong0217@gmail.com.

作者简介:

刘子健,博士研究生,主要研究方向为图像生成、对比学习.E-mail:32185246@qq.com.

王兴梅,博士,教授,主要研究方向为人工智能、图像处理、计算机视觉.E-mail:wangxingmei@hrbeu.edu.cn.

陈伟京,硕士,助理工程师,主要研究方向为水下图像转换.E-mail:chenweijing@hrbeu.edu.cn.

张天姿,硕士研究生,主要研究方向为水下图像复原、图像处理.E-mail:zhangtianzi@hrbeu.edu.cn.

在获取稀缺水下图像时图像生成技术至关重要,通常依赖有序配对数据.考虑到实际海洋环境中获取该类数据受限,引入CL-GAN(Contrastive Learning-Based Generative Adversarial Network),克服图像域双射条件的限制,但由于随机采样的负样本质量较低,模型难以从水下噪声图像中学习复杂内容特征.因此,文中提出基于硬负样本对比学习的特征级生成对抗网络(Hard Negative Sample Contrastive Learning-Based Feature Level Generative Adversa-rial Network, HCFGAN),用于水下图像生成.为了提高负样本质量,提出硬负样本采样模块(Hard Negative Sampling Module, HNS),挖掘样本间的特征相似性,将靠近锚点样本的硬负样本加入对比损失中,学习复杂特征.为了保证负样本的复杂性和全面性,构造负样本生成模块(Negative Sample Generation Module, NSG).通过NSG和HNS的对抗性训练,确保硬负样本的有效性.为了提高模型对水下模糊图像的特征提取能力及训练稳定性,设计上下文特征生成器和全局特征判别器,增强对细微内容特征和水下风格信息的感知能力.实验表明,HCFGAN生成的水下图像具有良好的真实性和丰富性,在水下图像生成实际应用中具有重要价值.

ZHANG Wansong, Ph.D., associate professor. His research interests include simulation and modeling, and pattern recognition.

About Author:

LIU Zijian, Ph.D. candidate. His research interests include image generation and con-trastive learning.

WANG Xingmei, Ph.D., professor. Her research interests include artificial intelligence, image processing and computer vision.

CHEN Weijing, Master, assistant engineer. His research interests include underwater image translation.

ZHANG Tianzi, Master student. Her research interests include underwater image re-storation and image processing.

Image generation is essential to acquire scarce underwater images, and it is typically reliant on paired data. Considering the limitation of practical access to such data distributions in marine environments, a contrastive learning-based generative adversarial network(CL-GAN) is introduced to overcome the constraints of bijection in image domain. However, the model struggles to learn complex content features from noisy images due to the low quality of negative samples resulting from random sampling. To address this issue, a hard negative sample contrastive learning-based feature level GAN(HCFGAN) for underwater image generation is proposed. To improve the quality of negative samples, a hard negative sampling module(HNS) is designed to mine feature similarity between samples. The hard negative samples close to the anchor sample are incorporated into contrastive loss for complex feature learning. To ensure the complexity and comprehensiveness of negative samples, a negative sample generation module(NSG) is constructed. The adversarial training of NSG and HNS ensures the validity of hard negative samples. To enhance feature extraction capability and training stability of the model for underwater fuzzy images, a contextual feature generator and a global feature discriminator are designed. Experiments show that the underwater images generated by HCFGAN exhibit good authenticity and richness with practical value in underwater image generation.

水下图像承载着丰富的水下环境信息, 在海洋考古、水下图像探测等领域具有重要意义[1, 2].由于光线衰减和散射效应的限制, 拍摄重要的水下目标(如沉船和残骸)难度较大.因此, 图像生成变得至关重要, 其目的是将源域图像(非水下图像或模糊的水下图像)转换为目标域图像(清晰的水下图像), 生成难以采集的水下图像数据集.然而, 水下图像清晰度和对比度较低, 相比一般低清晰度图像, 水下图像受到颜色失真和浮游物引起的背景噪声等影响, 并且水体介质造成图像具有很强的朦胧感, 这些特点使该类图像在细节表现和色彩还原上更复杂.因此, 如何设计有效的方法改善水下图像质量和可用性成为值得研究的问题.

近年来, 生成对抗网络(Generative Adversarial Network, GAN)[3]已成为构建深度学习图像生成模型的关键技术之一.该类模型将成对图像作为监督信息, 在保持原始图像细节纹理的同时学习图像间的映射关系[4, 5, 6].Guo等[7]结合GAN与U-Net, 实现对水下图像的颜色恢复和去雾处理, 生成保持场景内容结构的清晰水下图像.Fabbri等[8]利用GAN提高水下视觉场景中转换图像的质量, 减少图像噪声和失真.在水下场景中, 高质量配对数据集往往有限, 这些方法的应用受到很大限制.

为了克服配对图像数据的挑战, 在GAN中引入循环一致性损失成为图像生成的研究热点之一[9, 10, 11], 如CycleGAN[12]和FUNIT(Few-Shot Unsu-pervised Image-to-Image Translation) [13]等通过无监督方式进行训练, 大幅减轻数据采集难度.Li等[14]提出基于CycleGAN和多个损失函数的弱监督图像颜色迁移方法, 旨在解决水下颜色失真问题.

为了提高水下图像的生成质量, Liu等[15]将极深超分辨率重建模型引入水下超分辨率应用中, 并通过改进训练模式提高多个损失函数的性能.在FUNIT基础上, Chen等[16]提出SSIT(Underwater Small Sample Image Transformation), 引入子像素卷积通道注意力机制, 增强图像表示能力, 并在小型水下数据集上采用弱化循环语义一致性损失生成图像.Sun等[17]提出UMGAN(Underwater Multiscene Generative Adversarial Network), 提高图像的整体质量, 实现水下浑浊域和清晰域之间的非配对图像转换.然而, 这些研究通常假设跨域图像之间满足严格的映射关系, 即双射条件, 并未充分考虑域间差异对内容特征的影响.

随着无监督模型的发展, 对比学习开始用于解决上述问题.Park等[18]提出CUT(Contrastive Un-paired Translation), 通过最大化输入和输出间的互信息学习跨域相似性函数, 避免双射条件的限制, 在不使用循环一致性损失的情况下可生成高质量图像.Jia等[19]提出SRUNIT(Semantically Robust Un-paired Image Translation), 学习高维特征映射, 保证生成图像的语义特征, 进一步解决CUT中存在的语义翻转问题.Emami等[20]提出CL-GAN(Contrastive Learning-Based GAN), 利用正负样本对之间的互信息, 避免域间严格的双射条件, 其中负样本取自同一幅源域图像中区别于目标域锚点位置的不同区域.CL-GAN在水下图像生成任务中的有效性受到两个主要因素的制约.1)多变水下环境导致严重的图像噪声.CL-GAN随机采样的低质量负样本限制网络从噪声图像中捕获复杂内容特征的能力.2)由于水体的特殊性, 水下图像往往出现严重退化.CL-GAN在处理水下模糊图像时, 特征提取能力不足, 影响生成图像的真实性和多样性.

与此同时, 扩散模型在各种与图像相关的任务中表现出卓越性能, 包括:高保真图像生成[21]、超分辨率图像生成[22]和文本驱动的图像处理[23].在图像风格化方面, 已提出的方法包括:DiffuseIT(Di-ffusion-Based Unsupervised Image Translation Me-thod)[24]和InST(Inversion-Based Style Transfer Method)[25], 这为水下图像生成提供新思路.但是上述方法依赖迭代推理, 计算成本相对较高, 难以保留全局内容特征.相比之下, GAN因为模型结构的简单性、生成结果的多样性、训练过程的灵活性, 仍是较成熟且优秀的图像生成方法.

本文提出基于硬负样本对比学习的特征级生成对抗网络(Hard Negative Sample Contrastive Lear-ning-Based Feature Level GAN, HCFGAN), 将CL-GAN与水下图像生成结合, 提出硬负样本采样模块(Hard Negative Sampling Module, HNS), 解决低质量负样本的问题.HNS选择与锚点样本分布接近的硬负样本, 有效增强训练过程中对比损失的有效性.设计负样本生成模块(Negative Sample Generation Module, NSG), 使对比学习中的训练负样本复杂且全面.通过在HNS和NSG之间实施对抗性训练, 利用多样性与挑战性之间的博弈, 进一步提高负样本的质量.为了解决水下图像特征模糊的问题, 在CL-GAN的生成器和判别器中分别引入上下文特征注意力和全局特征注意力.此外, 还采用全局谱归一化方法, 提高训练过程的稳定性.对比实验和消融实验表明, HCFGAN生成的水下光学图像和水下声纳图像在真实性和丰富性方面均较优.

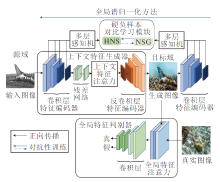

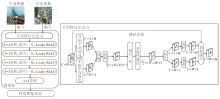

本文提出基于硬负样本对比学习的特征级生成对抗网络(HCFGAN), 结构如图1所示.HCFGAN由三部分组成:上下文特征生成器、硬负样本对比学习模块和全局特征判别器.上下文特征生成器结合上下文特征注意力生成目标域图像, 有效捕获源域图像的上下文信息, 保留细节特征.在训练过程中, 目标域图像和源域图像的编码特征输入硬负样本对比学习模块, 确保内容特征一致性.硬负样本对比学习模块采用硬负样本采样模块(HNS)和负样本生成模块(NSG)的对抗性训练, 提高负样本的质量, 增强对比学习的有效性.同时, 生成图像和真实图像输入全局特征判别器, 综合对比风格特征.通过全局特征注意力有效捕获全面的风格信息, 确保图像风格特征一致.本文还提出全局谱归一化方法, 保持网络训练的稳定性.

受CUT[18]启发, HCFGAN采用CL-GAN[20]架构, 源域图像首先输入生成器, 生成目标域图像, 然后与真实图像一起输入判别器进行评估.生成器和判别器采用对抗训练, 提升生成图像的质量, 通过最小化BCE Loss(Binary Cross Entropy Loss)提高生成图像与目标域图像在像素级别上的一致性:

$\begin{aligned} L_{\mathrm{GAN}}= & E_{\boldsymbol{y} \sim \boldsymbol{Y}}[\ln D(\boldsymbol{y})]+ \\ & E_{\boldsymbol{x} \sim \boldsymbol{X}}[\ln (1-D(G(\boldsymbol{x})))], \end{aligned}$

其中:G(· )表示生成器, D(· )表示判别器, x表示源域图像, y表示目标域图像, Ey~Y[ln D(y)]表示输入真实图像时判别器的结果, Ex~X[ln(1-D(G(x)))]表示输入生成图像时判别器的结果.

在对比学习阶段, 从编码器中选取若干关键特征层, 以此提高特征的表达能力.较低层主要聚焦于提取图像的局部纹理等低级特征, 较高层负责捕获高维抽象特征.参考MoCo(Momentum Contrast)[26]和SimCLR(A Simple Framework for Contrastive Lear-ning of Visual Representations)[27]等模型, 将特征图输入双层的多层感知机(Multilayer Per-ceptron, MLP), 提炼更具区分性的高维特征.引入

$s \in S=\left\{S_{l} \mid l=1, 2, \cdots, L\right\}, $

其中, l表示层数, Sl表示第l层的图像区域个数.

为了进行图像区域级别的对比学习, 将源域图像和目标域图像中对应区域进行精确匹配.计算不同特征间的互信息, 使模型区分正样本和各种负样本.多层对比损失:

$L_{\text {Contrast }}(G, H, X)=E_{z \sim P} \sum_{l=1}^{L} \sum_{s=1}^{S_{l}} l\left(\boldsymbol{z}_{l}^{\prime s}, \boldsymbol{z}_{l}^{s}, \boldsymbol{z}_{l}^{S \backslash s}\right), $ (1)

其中, H表示双层MLP, Ez~P表示对样本z取随机采样概率分布P下的期望值, z'sl、

$\begin{array}{l} L_{\mathrm{InfoNCE}}= \\ -\ln \left(\frac{\exp \left(\frac{\operatorname{sim}\left(z_{l}^{\prime s}, z_{l}^{s}\right)}{\tau}\right)}{\exp \left(\frac{\operatorname{sim}\left(z_{l}^{\prime s}, z_{l}^{s}\right)}{\tau}\right)+\sum_{i=1}^{N} \exp \left(\frac{\operatorname{sim}\left(z_{l}^{\prime s}, z_{l_{i}}^{S \backslash s}\right)}{\tau}\right)}\right) \end{array}$ (2)

为了保持生成图像的风格特征, 引入一致性对比损失LContrast(G, H, Y)[12], 将目标域图像输入多层一致性对比损失, 期望输出一致结果.

CL-GAN的最终损失函数由生成对抗损失、多层对比损失和多层一致性对比损失组成:

$\begin{aligned} L_{\mathrm{CL}-G A N}= & L_{\text {GAN }}(G, D, X, Y)+\lambda_{X} L_{\text {Contrast }}(G, H, X)+ \\ & \lambda_{Y} L_{\text {Contrast }}(G, H, Y), \end{aligned}$ (3)

其中:λ X、λ Y表示对应的惩罚系数, 在本文中取λ X=λ Y=1.

CL-GAN在无监督图像生成任务中表现出巨大潜力.然而, 在现有训练过程中, 负样本通常是从源域图像中随机采样, 模型难以有效学习锚点样本与负样本之间的差异分布, 导致图像生成质量不佳.针对此问题, 本文提出硬负样本采样方法, 获取更具挑战性的负样本.

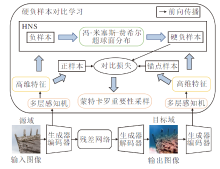

不同负样本采样方法获取的图像如图2所示.在随机采样方法中, 大多数负样本与锚点样本的距离较大, 样本之间差异明显, 模型只能学习数据间的显著差异, 无法充分捕获细节差异.而硬负样本采样方法倾向于采样靠近锚点的负样本, 可使模型提高区分能力.

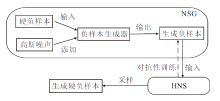

基于上述思路, 本文提出硬负样本采样模块(HNS), 使用HNS的水下图像生成模型结构如图3所示.

HNS利用双层MLP提取高维特征分布, 通过

$\begin{array}{l} f_{n}(\boldsymbol{x}, \boldsymbol{u}, k)=\frac{k^{\frac{n}{2}-1}}{(2 \pi)^{\frac{n}{2}} I_{\frac{n}{2}-1}(k)} \exp \left(k \boldsymbol{u}^{\mathrm{T}} \boldsymbol{x}\right), \\ I_{v}(\boldsymbol{x})=\left(\frac{\boldsymbol{x}}{2}\right)^{v} \sum_{k=0}^{\infty}\left(\frac{\left(\frac{z^{2}}{4}\right)^{k}}{k!\int_{0}^{+\infty} t^{k+v} \exp (-(k+v+1)) \mathrm{d} t}\right), \end{array}$

将其映射到冯· 米塞斯-费希尔超球面分布(Von Mises-Fisher Distribution), 描述n维空间中的点分布, 其中, x表示n维单位向量, k≥ 0, ‖ u‖ =1, Iv(x)表示v阶第一类变形贝塞尔函数, 称x遵循参数为u、k的冯· 米塞斯-费希尔分布.

锚点样本z's和负样本zS\s通过双层MLP获得高维特征分布.将这些特征映射至超球面分布, 通过计算zS\s与z's间的距离进行硬负样本采样, 则

$z_{\beta}^{S \backslash s}=\exp \left(\beta f\left(z^{\prime s}\right)^{\mathrm{T}} f\left(z^{S \backslash s}\right)\right) \cdot p\left(z^{S \backslash s}\right), $

其中, β 表示控制点积对采样难易度影响的调控因子, 通过该指数项与基本负样本采样分布相乘, 得到硬负样本采样概率.与此同时考虑负样本自身的分布特性以及其与锚点样本之间的关系, 实现更精细的采样控制.

在将特征映射至冯· 米塞斯-费希尔超球面分布之后, 将基于式(2)改进的InfoNCE Loss引入式(1), 计算基于硬负样本的对比学习损失:

$L_{\mathrm{VMFD}}=E_{z \sim P}\left[-\ln \left(\frac{\exp \left(f\left(\boldsymbol{z}^{\prime s}\right)^{\mathrm{T}} f\left(\boldsymbol{z}^{s}\right)\right)}{\exp \left(f\left(\boldsymbol{z}^{\prime s}\right)^{\mathrm{T}} f\left(\boldsymbol{z}^{s}\right)\right)+E_{z^{S s_{s}} \sim z_{\beta}^{S(s}}\left[\exp \left(f\left(\boldsymbol{z}^{\prime s}\right)^{\mathrm{T}} f\left(\boldsymbol{z}_{\beta}^{S \backslash s}\right)\right)\right]}\right)\right], $ (4)

其中, zs表示正样本,

为了降低式(4)的算法复杂度, 使用蒙特卡罗重要性采样简化损失函数的计算.该方法侧重于重新调整计算损失函数的目标, 而不是对采样过程进行复杂修改, 不仅简化算法实现, 而且保持模型训练效果.改进项如下:

$\begin{array}{l} E_{z^{S \mid s} \sim z_{\beta}^{S \mid s}}\left[\exp \left(f\left(\boldsymbol{z}^{\prime s}\right)^{\mathrm{T}} f\left(z_{\beta}^{S \backslash s}\right)\right)\right]= \\ \quad E_{z^{S \mid s} \sim P}\left[\exp \left(\frac{(\beta+1) f\left(\boldsymbol{z}^{\prime s}\right)^{\mathrm{T}} f\left(\boldsymbol{z}^{S \mid s}\right)}{z_{\beta}}\right)\right], \end{array}$

其中, 归一化系数zβ 为

$\begin{array}{c} \boldsymbol{z}_{\beta}=E_{z^{S \backslash s \sim P}}\left[\exp \left(\beta f\left(\boldsymbol{z}^{\prime s}\right)^{\mathrm{T}} f\left(\boldsymbol{z}^{S \backslash s}\right)\right)\right]= \\ \frac{1}{N} \sum_{i=1}^{N} \exp \left(\beta f\left(\boldsymbol{z}^{\prime s}\right)^{\mathrm{T}} f\left(\boldsymbol{z}_{i}^{S \backslash s}\right)\right) . \end{array}$

结合式(1), 经过硬负样本采样后的多层对比损失重写为

$\operatorname{Loss}_{\text {newcontrast }}=\lambda_{1} \operatorname{Loss}_{\text {Contrast }}+\lambda_{2} \operatorname{Loss}_{\text {VMFD }}, $

其中, λ 1、λ 2表示平衡不同损失的权重参数.类似于式(3), HNS的目标函数为:

$\begin{aligned} L_{\mathrm{HNS}}= & L_{\mathrm{GAN}}(G, D, X, Y)+\lambda_{X} L_{\text {newContrast }}(G, H, X)+ \\ & \lambda_{Y} L_{\text {newContrast }}(G, H, Y) . \end{aligned}$

HNS有效提取高质量的硬负样本, 提高对比学习性能.为了避免相似负样本导致模型存在的过拟合风险, 本文进一步提出负样本生成模块(NSG), 结构如图4所示.

在硬负样本中添加高斯噪声作为负样本生成器的输入, 以生成多样性负样本, 并通过HNS和NSG进行对抗性训练, 为对比学习提供更有效的训练数据.

将硬负样本空间均值特征向量和高斯噪声输入负样本生成器, 得到生成负样本:

$z_{\text {neg }}^{-}=\frac{G_{\text {neg }}^{l}\left(z_{\beta}^{S \backslash s}, z_{n}\right)}{\left\|G_{\text {neg }}^{l}\left(z_{\beta}^{S \backslash s}, z_{n}\right)\right\|_{2}}, $

其中,

$G_{\text {neg }}^{l} \in\left\{G_{\text {neg }}^{0}, G_{\text {neg }}^{1}, \cdots, G_{\text {neg }}^{L}\right\}, $

表示多层负样本生成器, 通过从标准高斯分布zn中采样噪声向量生成多种负样本.

受GAN启发, 为了使负样本生成器生成足够数量的高质量硬负样本, 将NSG和HNS进行对抗性训练:

$\begin{aligned} L_{\mathrm{adv}}= & \min _{\mathrm{HNS}} \max _{\mathrm{NSG}} l\left(\boldsymbol{z}^{\prime s}, \boldsymbol{z}^{s}, \boldsymbol{z}_{\mathrm{neg}}^{-}\right)= \\ & -\ln \left(\frac{\exp \left(\frac{\boldsymbol{z}^{\prime s} \cdot \boldsymbol{z}^{s}}{\tau}\right)}{\exp \left(\frac{\boldsymbol{z}^{\prime s} \cdot \boldsymbol{z}^{s}}{\tau}\right)+\sum_{i=1}^{N} \exp \left(\frac{\boldsymbol{z}^{\prime s} \cdot \boldsymbol{z}_{\text {neg }_{i}}^{-}}{\tau}\right)}\right) . \end{aligned}$

在此过程中, NSG致力于生成多样性负样本, 旨在最大化对比损失; HNS侧重于减小锚点样本和正样本的距离, 增大锚点样本和负样本之间的距离, 旨在最小化对比损失, 优化模型性能.两个模块在不断挑战中提升自身学习和泛化能力.

为了避免负样本生成器忽略噪声输入, 偏向于单一复杂的负样本, 进一步引入噪声正则化项, 利用不同噪声矢量增加生成负样本的多样性, 进而增强模型的泛化能力:

$L_{\text {noise }}=-\left\|G_{\text {neg }}^{l}\left(z_{\beta}^{S \backslash s}, z_{1}\right)-G_{\text {neg }}^{l}\left(z_{\beta}^{S \backslash s}, z_{2}\right)\right\|_{1}, $

其中z1、z2表示从标准高斯分布随机选取的两个不同噪声.因此, HCFGAN的损失函数为:

$L_{\mathrm{HNSGAN}}=L_{\mathrm{HNS}}+L_{\mathrm{adv}}+L_{\mathrm{noise}} .$

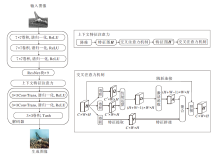

水下图像通常具有复杂结构, 主要表现在海洋生物、植物和水下地形等.CL-GAN中的生成器由于细微特征捕获能力不足, 无法精细复原图像细节内容.同时, 判别器往往关注局部特征, 可能忽略图像不同区域的丰富风格信息, 导致判别能力受限.对此, 本文在生成器中引入上下文特征注意力, 增强其感知内容特征细微变化的能力.在判别器中加入全局特征注意力[28], 全面捕获整体水下风格信息.最后, 提出全局谱归一化方法, 提高网络训练过程的稳定性.

上下文特征生成器结构如图5所示, 其中, 上下文特征注意力由双层交叉注意力机制[29]组成, 用于捕获完整图像的相关性.对特征图H进行卷积, 分别得到注意力机制对应特征图Q、K和V.在Q的空间维度上选取特征点n对应的特征向量Qn, 同时提取K中对应特征点n位置的水平方向特征和垂直方向特征, 获得对应特征向量集合Kn.Q、K的特征向量根据仿射运算生成注意力特征图A.同理, 提取特征图V中特征点n位置处的水平方向特征和垂直方向特征, 得到对应特征向量集合Vn, 聚合特征向量, 可得

$\boldsymbol{H}_{n}^{\prime}=\sum_{i=0}^{H+W-1} \boldsymbol{A}_{i, n} \boldsymbol{V}_{i, n}+\boldsymbol{H}_{n} .$

全局特征判别器结构如图6所示.全局特征注意力准确捕捉生成图像和真实图像间的关键特征差异, 使生成图像和真实图像在训练过程中的风格特征分布进一步接近, 保证水下风格特征得到一致保留.

首先在水平方向和垂直方向上分别对特征图进行平均池化, 提取的特征图通过空间信息编码得到新特征图Zh和Zw, 这允许注意力模块捕获沿一个空间方向的长程依赖关系, 并保留沿另一个空间方向的精确位置信息.最后, 空间信息通过通道加权的方式融入原始特征图中, 得到新的特征图:

$y_{c}(i, j)=x_{c}(i, j) \cdot g_{c}^{h}(i) \cdot g_{c}^{w}(i), $

其中,

为了保持整体网络训练稳定性, 本文采用全局谱归一化方法, 将谱归一化(Spectral Normalization, SN)[30]同时用于生成器和判别器的各层卷积操作之后和激活函数之前, 确保网络满足Lipschitz约束, 同时保持强大的表示能力, 计算如下:

$\boldsymbol{W}_{\mathrm{SN}}(\boldsymbol{W})=\frac{\boldsymbol{W}}{\sigma(\boldsymbol{W})}, $

其中, W表示权重矩阵, σ (W)表示谱参数, 即最大奇异值.将W除以σ (W)获得归一化的权重矩阵WSN, 保证网络层的输出不会随输入而剧烈变动, 有效防止梯度消失或梯度爆炸等问题, 提高整体网络稳定性, 生成更高质量的水下图像.

本节旨在验证HCFGAN在水下图像生成任务中的性能.为此, 在4个数据集上进行对比实验和消融实验, 通过对比视觉效果和评价指标验证方法的优越性.

同时, 在所有可视化实验中随机选取第一列图像进行局部区域的效果展示(展示于可视化实验结果的最后一列), 以此充分说明提出模块对图像局部信息的提升效果.

水下图像生成涉及源域数据集和目标域数据集.源域数据集包括废墟残骸数据集(MSITM数据集[31])和潜水器数据集(内部项目实验数据集), 目标域数据集包括水下光学数据集(UIEB数据集[32])和水下声纳数据集(内部项目实验数据集).从可视性角度分析, MSITM数据集和UIEB数据集为立体平面结构, 潜水器数据集和水下声纳数据集为俯视平面结构, 这种区别保证生成的水下光学图像和水下声纳图像的视觉效果.

MSITM数据集包含725幅图像, 其中, 飞机残骸图像299幅, 轮船残骸图像395幅, 城市废墟图像31幅.

潜水器数据集包含1 391幅图像, 其中, 粗型潜水器图像288幅、小型潜水器图像117幅、长型潜水器图像212幅、中型潜水器图像774幅.部分图像如图7所示.

UIEB数据集包含950幅真实水下世界图像, 其中, 890幅图像具有对应的参考图像, 60幅图像没有满意的参考图像.

水下声纳数据集包含304幅图像, 其中, 船只图像114幅、鱼群图像8幅、飞机图像37幅、沙石图像140幅、轮胎图像5幅.部分图像如图8所示.

为了准确地展示模型效果, 选择如下3种数值指标:FID(Fré chet Inception Distance Score)[33]、KID(Kernel Inception Distance)[34]和IS(Inception Score)[35].

FID、KID和IS的核心机制都基于高层特征空间的分布差异或分类器的输出, 不仅适用于自然光学图像评估, 也成功应用于声纳图像的评估[36].虽然声纳图像与自然图像在视觉上存在差异, 但两者的评估目标(如图像质量、真实感和多样性)是一致的.因此, 上述指标同样能有效评估声纳图像的生成效果.

FID评估图像生成质量, 较低的FID分数表明生成图像样本的特征分布更接近于真实图像样本的特征分布, 具体公式如下:

$\begin{aligned} \operatorname{FID}(\boldsymbol{x}, \boldsymbol{y})= & \left\|\boldsymbol{u}_{x}-\boldsymbol{u}_{y}\right\|_{2}^{2}+ \\ & \operatorname{tr}\left(\boldsymbol{\Sigma}_{x}+\boldsymbol{\Sigma}_{y}-2\left(\boldsymbol{\Sigma}_{x} \boldsymbol{\Sigma}_{y}\right)^{\frac{1}{2}}\right) \end{aligned}$

其中, ux表示真实图像对应的特征均值, uy表示生成图像对应的特征均值, Σ x表示真实图像特征向量的协方差矩阵, Σ y表示生成图像特征向量的协方差矩阵, tr(· )表示矩阵的迹, 即矩阵对角线元素之和.

KID度量两组样本之间的距离, 更一致匹配人类感知.较小的KID值表示生成图像更真实, 具体公式如下:

$\begin{aligned} K I D= & \frac{1}{N^{2}} \sum_{i=1}^{N} \sum_{j=1}^{N} k\left(\boldsymbol{x}_{i}, \boldsymbol{x}_{j}\right)+\frac{1}{M^{2}} \sum_{i=1}^{M} \sum_{j=1}^{M} k\left(\boldsymbol{y}_{i}, \boldsymbol{y}_{j}\right)- \\ & \frac{2}{N M} \sum_{i=1}^{N} \sum_{j=1}^{M} k\left(\boldsymbol{x}_{i}, \boldsymbol{y}_{j}\right), \end{aligned}$

其中, xi表示真实图像的特征向量, yi表示生成图像的特征向量, N表示真实图像的数量, M表示生成图像的数量, k(· )表示衡量特征向量x和y相似度的三次核函数.

IS评估生成图像的丰富度和多样性, 较高的IS值表示生成图像包含更多的丰富信息, 具体公式如下:

$I S(G)=\exp \left(E_{\boldsymbol{x} \sim P_{g}}\left(D_{\mathrm{KL}}(p(\boldsymbol{y} \mid \boldsymbol{x}) \| p(\boldsymbol{y}))\right)\right), $

其中, x~Pg表示生成图像, p(y|x)表示将生成图像x输入Inception-v3得到的输出向量, p(y)表示生成图像的边缘分布, DKL(· )表示计算KL散度.

本节选择如下图像生成方法进行对比实验:UNIT(Unsupervised Image-to-Image Translation)[9]、CycleGAN[12]、CUT[18]、FastCUT[18]、SRUNIT[19]、Di-ffuseIT[24]、InST[25]、文献[37]方法、GcGAN(Geome-try-Consistent Generative Adversarial Network)[38].

设定如下两个任务:将废墟残骸图像转换为水下光学图像(简记为w→ u), 将潜水器图像转换为水下声纳图像(简记为s→ s).

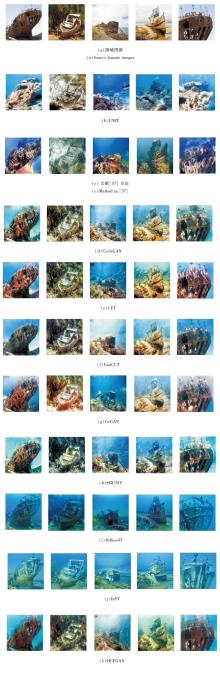

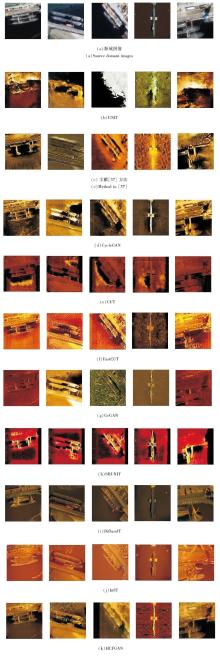

各模型在w→ u任务和s→ s任务上的定性结果如图9和图10所示.对比两图结果可知, UNIT和文献[37]方法生成的图像质量都较差, 对风格特征的转换和内容特征的保留未达到图像生成的基本要求.

CUT的生成结果稳定性较差, 复杂图像噪点过多.FastCUT对水下特征的转换不明显, 保留部分原有图像风格特征.GcGAN和SRUNIT生成的图像结构和纹理信息模糊, 图像真实性不足.

CycleGAN生成图像较逼真, 但棋盘噪声明显, 相邻区域之间的色彩过渡突兀, 由于扩散模型的随机性质, 在反向扩散期间经常难以保持图像的原始内容, 因此导致生成图像出现内容偏差或缺失.

相比之下, HCFGAN有效保留源域的内容信息, 相邻区域像素点之间的联系紧密, 图像真实性得到一定提升.

各方法在w→ u任务和s→ s任务中的指标值结果如表1所示.

| 表1 各方法在w→ u任务和s→ s任务中的定量结果 Table 1 Quantitative results of different methods in w→ u and s→ s tasks |

由表1可见, HCFGAN性能较优.在两个任务中, 相比其它方法, HCFGAN的FID值和KID值都达到最优, 可保证生成水下图像的真实性、高质量和丰富性.

为了对比分析各方法的运行效率, 以使用NVI- DIA RTX 3090生成一幅256× 256的水下光学图像的平均运算时间作为衡量标准, 对比各方法的时间性能, 结果如表2所示.

| 表2 各方法的时间性能对比 Table 2 Comparison of time performance of different methods ms |

由表2可见, DiffuseIT和InST的耗时太长, 几乎没有竞争力.HCFGAN耗时10.5 ms, 优于UNIT、文献[37]方法和CycleGAN, 更是领先于扩散方法, 在时间性能方面具有优势.

2.4.1 网络结构

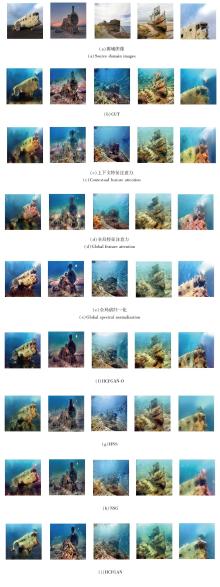

本节旨在验证各模块在水下图像生成中的有效性, 并在此基础上验证本文的硬负样本采样方法的改进效果.HCFGAN性能的提升归功于上下文特征注意力、全局特征注意力、全局谱归一化、HNS和NSG, 包含前三个模块的方法简记为HCFGAN-O.

各方法在w→ u任务中的可视化结果如图11所示.由图可知, 相比CUT, HCFGAN-O生成图像的背景更和谐, 各区域语义信息表达更清晰, 整体质量和真实感都有大幅提高.HCFGAN生成的水下光学图像的细微特征真实感和信息丰富完整性提升较大, 废墟的水下光影效果显著增强, 残骸的水下腐蚀效果更逼真.

各方法在s→ s任务中的可视化结果如图12所示.由图可知, HCFGAN-O生成图像中潜水器轮廓完整清晰, 水下声纳风格效果明显, 整体背景真实稳定, 但因环境特征的覆盖, 潜水器的内容特征在此过程中仍存在丢失问题.HCFGAN生成的水下声纳图像整体风格特征与目标域风格特征极为接近, 表现出明显的多样性和丰富性, 充分呈现水下声纳的沙化效果.

各方法在w→ u任务和s→ s任务中的指标值如表3所示.

| 表3 各方法在w→ u任务和s→ s任务中的消融实验结果 Table 3 Ablation experiment results of different methods in w→ u and s→ s tasks |

由表3可见, 相比CUT, HCFGAN-O和HCFGAN的FID、KID和IS指标值较优, 图像的真实性和丰富性都有大幅提升.

HCFGAN在生成具有复杂几何或结构模式的图像类(如水下光学图像)方面实现更优性能(更低的FID值和KID值), 分别比HCFGAN-O降低5.84%和11.00%.

对于结构约束较少的类别(如水下声纳图像, 它们更多地通过纹理而不是几何进行区分), 其特征隐蔽且图像风格单一, HCFGAN在对生成图像的表达即图像的丰富度方面实现更大改进, 获得更高的IS值, 比HCFGAN-O提升39.15%.

2.4.2 负样本采样方法

为了验证不同负样本采样方法对对比学习训练过程的影响, 本节使用随机采样方法和硬负样本采样方法, 对比由此生成的多层对比损失曲线和多层一致性对比损失曲线.在w→ u任务中的损失曲线如图13所示, 在s→ s任务中的损失曲线如图14所示.由图可见, 两种方法的损失曲线整体呈下降趋势, 但是随机采样的负样本在对比学习训练过程中相对容易区分, 对锚点样本的影响力较小, 导致损失函数值一直处于较低水平, 下降趋势明显, 进而影响水下光学图像的生成效果.相比之下, 硬负样本采样方法较高的对比损失值表明负样本生成器生成的负样本通过对抗性学习可保持挑战性, 从而提高生成图像对内容特征和水下风格特征的保留程度.相比水下光学图像, 水下声纳图像的特征更隐蔽, 生成过程中需要与锚点区域更接近的高复杂度负样本进行训练, 因此对应的对比损失值偏高.

为了可视化不同负样本采样方法下的负样本分布差异, 将水下光学图像嵌入向量投影至二维平面, 并归一化处理为与圆点距离模长为1, 再以圆点为中心计算样本间余弦相似度, 观察采样负样本间的距离, 结果如图15所示.

随机采样方法在图像中随机选择与锚点样本不相关的样本作为负样本, 包含一些无效或容易被区分的样本, 导致方法容易学到较弱的特征区分能力.硬负样本采样方法选择与锚点样本特征相似度较高、难以区分的样本作为负样本, 可促进方法学到更具区分性的特征, 然而方法倾向于在靠近锚点样本的较小范围(cosθ 1)内采样, 可能导致过拟合特定样本的微小差异.负样本生成模块在硬负采样样本基础上, 通过添加高斯正则项及对抗训练策略, 保持样本挑战性和多样性, 使采样范围保持在适当区间(cosθ 2), 能更好地关注水下图像内容细节特征和风格多样性.

2.4.3 硬负样本数量

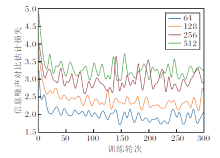

为了验证硬负样本数量对性能的影响, 将各特征层中的硬负样本数量分别设置为64、128、256和512, 对HCFGAN进行消融实验.

选择w→ u任务, 硬负样本数量不同时的可视化结果如图16所示.

| 图16 在w→ u任务中硬负样本数量不同时的可视化结果Fig.16 Visualization results in w→ u task with different hard negative sample numbers |

由图16可见, 当硬负样本数量较少时, 图像的结构信息和纹理信息保留不充分, 物体主体轮廓较模糊.当负样本数量为256时, 生成图像具有最优的视觉效果.

选择w→ u任务和s→ s任务, 硬负样本数量对HCFGAN指标值的影响如表4所示, 表中训练时间表示每轮迭代所需的训练时间.

| 表4 w→ u任务和s→ s任务中硬负样本数目不同时的指标值对比 Table 4 Metric value comparison of w→ u and s→ s tasks with different hard negative sample numbers |

由表4可见, 当硬负样本数量为256时, HCF- GAN的性能达到最优, 此时生成图像与真实图像分布最接近, 图像的丰富度及多样性表现最优.随着硬负样本数量的增加, 每轮迭代训练时长也会随之增加.

相比采用更多的硬负样本, 256个硬负样本能在训练效率和训练结果上都达到较优标准.

w→ u任务中采样不同硬负样本数量对应的对比学习损失曲线如图17所示.由图可见, 硬负样本数量过少时无法有效利用对比学习损失, 导致将正样本推向锚点失效.随着硬负样本数量的增加, 对比损失值也相应增大.当训练轮次逐渐增大时, 采样256个硬负样本与采样512个硬负样本的对比损失曲线逐渐逼近, 过多的硬负样本可能包含一些不相干的扰动, 并显著增加计算成本.综合考虑性能和计算损耗, 256个硬负样本数量为最佳采样选择.

本文提出基于硬负样本对比学习的特征级生成对抗网络(HCFGAN).首先设计硬负样本采样模块(HNS), 确保负样本与锚点样本在特征空间中具有适当的分布关系.在此基础上, 构建负样本生成模块(NSG), 为对比学习提供多样性负样本, 帮助方法学习图像的高层特征信息.通过NSG和HNS间的对抗性训练, 保证硬负样本的挑战性.此外, 上下文特征生成器和全局特征判别器的引入, 提高方法提取水下图像重要特征的能力, 并确保网络训练稳定性.实验表明, HCFGAN生成的水下光学图像和水下声纳图像具有较好的真实性、丰富性和多样性, 图像原始内容信息和水下风格特征得到较好表现.

然而, 缺乏高质量真实水下风格图像及图像生成模型的弱泛化性, 使水下图像生成方法仍面临挑战.目前HNS采样负样本选取的阈值为经验参数, 今后可在不同数据集上进行研究, 实现该参数自适应调整, 以此研究图像生成方法在更多场景下的泛化能力.

本文责任编委 徐 勇

Recommended by Associate Editor XU Yong

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|