黄 捷,博士,教授,主要研究方向为模式识别、智能系统、多智能体系统.E-mail:jie.huang@fzu.edu.cn.

作者简介:

蔡逢煌,博士,教授,主要研究方向为机器学习、电力电子变换器控制.E-mail:caifenghuang@fzu.edu.cn.

张家翔,硕士研究生,主要研究方向为智能视觉、无人系统.E-mail:zjx4350@163.com.

针对无人机航拍图像目标检测中视野变化大、时空信息复杂等问题,文中基于YOLOv5(You Only Look Once Version5)架构,提出基于图像低维特征融合的航拍小目标检测模型.引入CA(Coordinate Attention),改进MobileNetV3的反转残差块,增加图像空间维度信息的同时降低模型参数量.改进YOLOv5特征金字塔网络结构,融合浅层网络中的特征图,增加模型对图像低维有效信息的表达能力,进而提升小目标检测精度.同时为了降低航拍图像中复杂背景带来的干扰,引入无参平均注意力模块,同时关注图像的空间注意力与通道注意力;引入VariFocal Loss,降低负样本在训练过程中的权重占比.在VisDrone数据集上的实验验证文中模型的有效性,该模型在有效提升检测精度的同时明显降低复杂度.

HUANG Jie, Ph.D., professor. His research interests include pa-ttern recognition, intelligent system and multi-agent system.

About Author:

CAI Fenghuang, Ph.D., professor. His research interests include machine learning and power electronic converter control.

ZHANG Jiaxiang, Master student. His research interests include intelligent vision and unmanned system.

To address the challenges of significant changes in the field of view and complex spatiotemporal information in unmanned aerial vehicle aerial image target detection, a model for small object detection in aerial photography based on low dimensional image feature fusion is presented grounded on the YOLOv5(you only look once version 5) architecture. Coordinate attention is introduced to improve the inverted residuals of MobileNetV3, thereby increasing the spatial dimension information of images while reducing parameters of the model. The YOLOv5 feature pyramid network structure is improved to incorporate feature images from shallow networks. The ability of the model to represent low-dimensional effective information of images is enhanced, and consequently the detection accuracy of the proposed model for small objects is improved. To reduce the impact of complex background in the image, the parameter-free average attention module is introduced to focus on both spatial attention and channel attention. VariFocal Loss is adopted to reduce the weight proportion of negative samples in the training process. Experiments on VisDrone dataset demonstrate the effectiveness of the proposed model. The detection accuracy is effectively improved while the model complexity is significantly reduced.

无人机凭借其高机动性已广泛应用于各类远距离或环境复杂的任务中.近年来, 随着深度学习的不断发展, 无人机目标检测技术在城市交通、农业监测等领域取得重大突破[1].然而, 无人机航拍图像目标检测技术面临一系列特殊性挑战[2]:视角和高度变化大、背景和环境复杂、数据处理规模大、实时性要求高等.由于目标在不同视角下可能呈现不同的外观, 导致目标的形状、大小和特征在图像中发生变化.并且无人机航拍的背景可能涉及复杂的环境, 如密集的建筑物、树木、车辆等.这种复杂的背景会使目标与周围环境混淆, 有时甚至会导致目标与背景融为一体, 使检测算法难以准确区分目标, 导致误检或漏检.因此需要更实时、准确的目标识别技术, 为无人机的决策制定和行动执行提供信息和数据支持[3].

目前常见的目标检测算法主要包含:1)以YOLO(You Only Look Once)[4, 5]、SSD(Single Shot Multi-Box Detector)[6]为代表的一阶段目标检测算法; 2)以Faster R-CNN(Faster Region-Based Convolutional Neutral Network)[7]、Mask R-CNN(Mask Region-Based Convolutional Neutral Network)[8]为代表的二阶段目标检测算法.

相比一阶段目标检测算法, 二阶段目标检测算法通常更复杂.因为它需要在第一阶段生成候选框的基础上进行第二阶段的分类和位置回归, 涉及更多的网络组件和计算步骤.并且由于需要进行两个阶段的处理, 二阶段目标检测算法耗费计算资源更多、速度更慢.因此本文选择一阶段目标检测算法中性能较优的YOLOv5(YOLO Version 5)研究航拍目标检测.

在目标检测过程中, 前向计算作为核心阶段, 直接影响检测性能, 尤其是对小目标的检测效果.前向计算过程主要包括特征提取和特征融合两部分.YOLO采用深度卷积网络作为特征提取器, 每个卷积层都执行滤波操作, 捕获图像中的不同特征, 如边缘、纹理、颜色等.此外, YOLO通过上采样(Up-sam-pling)和特征级联(Feature Concatenation)融合不同尺度的特征图.通过加法、乘法、拼接等方式合并来自不同卷积层或网络架构的特征图, 获得更丰富的信息以支持决策.并在YOLOv3(YOLO Version 3)[9]及以后的版本中采用一个特征金字塔网络结构, 整合来自不同分辨率的特征图, 每个特征图都包含不同尺寸的目标信息, 可更好地预测目标位置和类别.

虽然常用的目标检测算法在COCO[10]、ImageNet[11]等数据集上表现优异, 但在背景复杂、小目标众多的VisDrone[12]、UAVDT数据集上检测性能较差.这是由于小目标通常具有较少的像素, 因此包含的信息有限.常用的检测模型难以从有限的像素中提取足够的有用特征以准确检测小目标.

因此, 学者们提出各种针对小目标检测的改进方法.Liu等[13]提出ALFNet(Asymptotic Localization Fitting Network), 利用级联网络的思想, 采用SSD作为框架, 以ResNet-50作为基础网络, 训练多个定位模块, 不断提高IoU(Intersection over Union)阈值以提升对小目标定位精度.Nayan等[14]针对小尺度目标在深层网络中存在信息丢失的问题, 提出一种实时检测算法, 采用上采样和跳跃连接的方式, 在学习任务中提取不同卷积级别上的多尺度特征, 从而提升对小目标的检测性能.Wang等[15]提出YOLO-D(YOLO-Based Detection Model), 在YOLOv3的基础上, 建立CBAM(Convolutional Block Attention Mo-dule), 增强模型对特征图和上下文信息的使用, 并将特征金字塔网络替换为二次递归特征金字塔网络, 减少复杂背景带来的影响, 提高模型对海岸线附近航拍小目标的检测性能.

然而各种改进方法往往致力于模型精度的提升, 改进多采用增加网络深度、引入更多参数等方式, 使网络复杂度提升, 却较少考虑对模型的轻量化处理及图像浅层信息的应用[16, 17].针对上述问题, 本文提出基于图像低维特征融合的航拍小目标检测模型.引入CA(Coordinate Attention), 改进MobileNetV3的反转残差块, 增加图像空间维度信息的同时降低模型参数量.改进YOLOv5特征金字塔网络结构, 融合浅层网络中的特征图, 增加模型对图像低维有效信息的表达能力, 进而提升对小目标检测精度.同时为了降低航拍图像中复杂背景带来的干扰, 引入无参平均注意力模块, 同时关注图像的空间注意力与通道注意力; 引入VariFocal Loss, 降低负样本在训练过程中的权重占比.在VisDrone数据集上的实验证实文中模型的有效性, 该模型在有效提升检测精度的同时明显降低复杂度.

本文主要基于YOLOv5的网络架构进行研究, YOLOv5的主干网络采用CSPDarknet53, 这是一种改进的Darknet架构, 结合CSPNet(Cross-Stage Par-tial Network)的思想, 提高特征的表示能力.同时引入C3模块, 捕获图像中不同层次的特征, 提取从低级到高级的语义信息.由于网络结构相对复杂, 需要更多的计算资源, 不利于模型的边缘化部署, 因此本文改进主干网络的残差结构, 采用更轻量化的MobileNetV3[18]进行特征提取.

MobileNetV3是一种轻量级卷积神经网络架构, 旨在计算资源受限的设备上实现高效的图像识别任务.在MobileNetV3中引入倒残差结构(Inverted Residuals), 通过一系列的卷积层和激活函数构建网络.

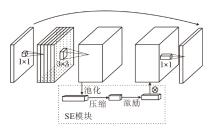

MobileNetV3倒残差结构如图1所示.首先使用1× 1卷积层扩展通道维度, 丰富特征表达能力.然后在输入和输出之间使用深度可分离卷积层, 深度可分离卷积的优势在于减少计算量和参数数量.在标准卷积中, 每个卷积核在所有输入通道上进行滑动操作, 导致参数数量较多.而在深度可分离卷积中, 首先进行深度卷积, 每个输入通道单独应用一个卷积核, 然后使用逐点卷积, 将这些通道的输出进行线性组合, 从而减少参数量.同时由于深度卷积只进行空间上的卷积操作, 未涉及跨通道的操作, 因此相对标准卷积而言, 计算量也大幅减少.并且逐点卷积是使用1× 1的卷积核在通道维度上进行的, 能在计算量相对较小的情况下促进不同通道之间的特征交互, 提升特征的表达能力.最后, 使用1× 1卷积层将通道维度恢复到较小值, 进一步减少模型的计算负载.

此外, MobileNetV3在倒残差结构中引入SE(Squeeze-and-Excitation)模块, 用于增强模型对输入中特定区域的关注程度.如图1虚线框内所示, SE模块的工作过程主要包括压缩和激励两部分.首先, 通过全局平均池化操作将特征图在空间维度上进行压缩, 得到一个通道维度上的特征描述向量, 然后通过一个小型的多层感知机结构, 对特征描述向量进行学习, 生成一个通道注意力权重向量.这个权重向量用于对原始特征图中的每个通道进行加权求和, 增强重要特征的表示能力.

由于SE模块引入多层感知机结构, 用于学习通道注意力权重, 增加网络的参数数量和计算量.同时SE模块只在通道维度上对特征图进行注意力加权, 忽略空间关系的建模, 对于空间相关性较强的无人机航拍目标检测任务不够理想.

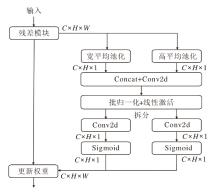

因此本文采用CA(Coordinate Attention)模块[19]改进MobileNetV3中的SE模块.如图2所示, CA模块通过两个并行阶段, 将各通道上的输入特征图xc分别在宽度和高度方向进行全局平均池化操作, 得到宽度和高度方向上的特征图:

$ \begin{array}{l} z_{c}^{h}(h)=\frac{1}{W_{0}} \sum_{0 \leqslant i< W} x_{c}(h, i), \\ z_{c}^{w}(w)=\frac{1}{H_{0}} \sum_{0 \leqslant j< H} x_{c}(j, w) . \end{array}$

将宽度和高度方向上的特征图合并到同个维度后进行卷积和激活, 获得新的特征图.将合并后的特征图再次通过两个并行阶段, 分离成宽度和高度方向的特征图, 然后利用1× 1卷积调整通道数并应用sigmoid函数获得注意力权重.这些权重经过缩放和激活后, 与原始特征图逐通道相乘, 以加权重要特征和抑制不重要特征, 从而获得具有空间注意力的特征图.

相比SE模块, CA模块能同时关注通道和空间维度, 帮助网络捕捉无人机航拍图像中的细微特征和局部信息, 有助于对小尺寸目标或具有细微特征的目标进行更准确的检测.通过在宽度和高度方向上分别计算注意力权重, 更好地关注图像中不同位置的特征, 有助于提升模型的精确度和鲁棒性.

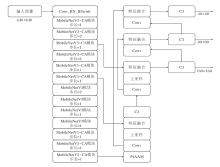

本文重新构建特征提取网络, 采用改进的MobileNetV3-CA残差模块以及由卷积层、批量归一化和Hard Swish[18]激活函数构成的Conv_BN_HSwish模块, 使网络在保持高性能的同时有效降低参数量和计算量, 存储和部署更便捷, 适合在资源受限的设备或网络环境中使用.

由于无人机航拍视角和高度的特殊性, 图像中包含大量只占据整个图像很小的一部分的目标[20], 这类目标在图像上的分辨率和尺度非常低, 使目标的检测和识别变得更困难.

为了进一步提高模型对无人机航拍目标的检测性能, 本文在MobileNetV3-CA模块构建特征提取网络的基础上, 基于YOLOv5网络架构进行多尺度特征融合, 改进后的网络结构如图3所示.

YOLOv5通过多尺度特征融合网络整合不同层级的特征图, 使用一种特征金字塔结构融合网络底层到高层的特征, 以此提供丰富的上下文信息和多尺度感知能力[21], 并通过1/8、1/16、1/32三个比例尺度的检测头共同检测不同尺度目标.

然而YOLO对航拍图像中的大量小目标并不敏感, 因为小目标通常具有较少的像素信息, 在YOLO中经过多次下采样操作后丢失信息过多.深层网络较大的感受野对小目标不敏感, 而浅层网络通常具有较小的感受野, 可捕捉图像中更细节化的信息.Zhu等[22]提出TPH-YOLO(Transformer Prediction Head YOLOv5), 在YOLO中增加小目标检测层, 有效提高网络对小目标的检测能力, 然而小目标检测层的添加导致网络复杂度和计算量增加, 额外的上采样操作使网络丢失更多的细节信息.

因此本文改进YOLOv5网络结构, 减少网络中的下采样操作以减缓特征图尺寸的下降速度.具体地, 将主干网络中最后一次步长为2的卷积操作修改为步长为1的卷积操作, 并修改多尺度特征融合网络结构, 如图3所示, 在多尺度特征融合网络中通过Concat模块融合主干网络中浅层特征图信息, 在保持网络深度不变的情况下提高网络获取的特征图尺度.本文在无人机航拍目标检测数据集上的实验发现, 当不断降低YOLO中大尺度检测头及中尺度检测头获取特征图通道数时, 对最终训练好的模型精度并未产生较大影响, 说明YOLO中的大尺度检测头甚至中尺度检测头在进行无人机航拍目标检测时工作效率较低.而经过本文对多尺度特征融合网络的改进, 原网络中进行大、中、小三个尺度目标检测的检测头现在将进行中、小、微小三个尺度的目标检测, 在提高网络工作效率的同时使网络能更好地捕捉小目标的细节信息.

网络中下采样操作的减少同时会导致网络感受野的降低, 可能会丢失一部分上下文信息.无人机航拍图像中目标除了尺寸较小以外, 还容易被复杂的背景干扰, 如密集的建筑物、树木、道路等, 这些背景元素可能与小目标在颜色、纹理等方面相似.在某些场景中, 小目标的分布还可能不均匀, 可能会出现集中在某个区域的情况, 这使目标检测算法很难准确区分背景和小目标.

因此, 本文引入PfAAM(Parameter-Free Average Attention Module)[23], 增强目标的区分度, 减少背景的干扰, 提高目标检测的准确性和定位精度.PfAAM包含空间注意力和通道注意力两部分, 空间注意力(Asp)与通道注意力(Ach)的计算公式如下:

$ \begin{array}{l} A_{s p}\left(x_{H \times W}\right)=\frac{1}{C} \sum_{i=1}^{C} x_{H \times W}(i), \\ A_{c h}\left(y_{C}\right)=\frac{1}{H \times W} \sum_{i=1}^{H} \sum_{j=1}^{W} y_{C}(i, j), \end{array}$

其中xH× W、yC分别表示每个空间及通道上的元素.PfAAM的空间注意力部分沿输入特征图的每个通道进行平均计算, 降低特征图维度, 生成特征图的每个元素表示跨通道的平均值, 从而突出高激活的空间区域并抑制低激活的空间区域.同理通道注意力部分沿特征图的空间维度进行平均计算, 突出检测到特征的高激活值通道, 抑制低激活通道带来的影响, 进一步增强网络对特征的提取能力.

由于PfAAM仅基于输入特征图的平均计算改善网络性能, 因此并未引入其它可训练参数或超参数, 符合本文对于网络轻量化要求, 通过实验验证, PfAAM可为航拍小目标检测提供更好的性能.

IoU损失函数用于衡量预测的边界框与实际目标边界框之间的重叠度.IoU损失函数在训练模型时起关键作用, 有助于模型学习准确的边界框位置.YOLOv5在训练过程中采用CIoU(Complete IoU)损失函数衡量预测框和真实框之间的差异.相比传统的IoU损失函数, CIoU损失函数考虑预测框和真实框之间的位置偏移和尺寸偏移, 能更准确地评估目标检测的准确性.CIoU损失函数的公式如下:

LCIoU=1-IoU+

其中, ρ 2(b, bgt)为预测框与真实框之间的距离, v为两框纵横比影响因子,

$ v=\frac{4}{\pi^{2}}\left(\tan ^{-1}\left(\frac{w_{g t}}{h_{g t}}\right)-\tan ^{-1}\left(\frac{w}{h}\right)\right)$

wgt、hgt分别为真实框的宽和高, w、h分别为预测框的宽和高.然而当预测框与真实框的宽度和高度呈线性比例时, 纵横比影响因子v=0, 此时纵横比差异不会对回归优化产生影响, 导致模型在优化过程中无法充分学习并调整预测框的尺寸.因此本文采用EIoU(Efficient IoU)损失函数进行改进, 并通过VariFocal Loss[24, 25]机制聚焦优质锚框.EIoU的计算公式如下:

$ \begin{array}{l} L_{\mathrm{EIOU}}= \\ \qquad 1-I o U+\frac{\rho^{2}\left(b, b_{g t}\right)}{c^{2}}+\frac{\rho^{2}\left(w, w_{g t}\right)}{c_{w}^{2}}+\frac{\rho^{2}\left(h, h_{g t}\right)}{c_{h}^{2}}, \end{array}$

其中, cw、ch分别为预测框与真实框最小外接矩形的宽度和高度, 即将CIoU中的纵横比影响因子中宽度与高度分别进行计算, 从而加快收敛速度, 提升回归精度.同时, 由于航拍目标检测中正负样本不平衡, 图像中背景占大部分区域, 导致训练数据中负样本数量过多.因此本文进一步引入VariFocal Loss, 减少负样本在计算损失过程中的贡献, 公式如下:

$ \begin{array}{l} \operatorname{VEL}(p, q)= \\ \left\{\begin{array}{ll} -q(q \ln p+(1-q) \ln (1-p)), & q> 0 \\ -\alpha p^{\gamma} \ln (1-p), & q=0 \end{array}\right. \end{array}$

其中, p为IoU感知分类评分, q为目标得分, α 为可调节的比例因子.由上式可见, VariFocal Loss减少负样本(q=0)的损失贡献, 提升网络训练过程中对正样本的敏感度.

本文选取VisDrone公开无人机目标检测数据集[11]对模型进行训练与测试.VisDrone数据集包含行人、人(非行走或站立状态)、自行车、汽车、货车、卡车、三轮车、遮阳篷三轮车、公共汽车及摩托车共10类.训练集包含6 471幅图像, 验证集包含548幅图像, 测试集包含1 610幅图像, 均采用无人机平台采集得到, 小尺寸目标(小于32像素)众多.VisDrone数据集上各实例的分布情况如图4所示, YOLOv5s的混淆矩阵如图5所示.

从图4和图5可见, VisDrone数据集具有实例情况复杂、分布不均衡、类别混淆严重的特点, 是一个十分具有挑战性的数据集.

本文选取mAP@0.5与mAP@0.5:0.95作为模型精度的评价指标, mAP@0.5指每个类别计算IoU阈值为0.5时的平均精度均值, 而mAP@0.5:0.95指每个类别计算IoU阈值为0.5到0.95之间步长为0.05的多个mAP平均值.mAP具体计算公式如下:

$ \begin{array}{l} P=\frac{T P}{T P+F P}, \\ R=\frac{T P}{T P+F N}, \\ A P=\int_{0}^{1} P R \mathrm{dr}, \\ m A P=\frac{1}{N} \sum_{i=0}^{n} A P_{i}, \end{array}$

其中, P为精确率, R为召回率, AP为平均精度, TP为预测正确的正样本, FP为预测错误的正样本, FN为预测错误的负样本.同时本文选取模型规模、模型参数量评价模型复杂程度.

本文模型训练使用的操作系统为CentOS7, CPU为Intel Xeon Gold 6253CL@3.10 GHz, 显卡为Nvidia RTX 4090 24G, 采用深度学习框架pytorch 2.0.1版本搭建模型, 采用CUDA 12.0加速训练.训练过程中批次大小为16, 初始学习率为0.01, 训练轮次为300, 优化器采用Adam, 采用余弦退火算法调整学习率.

为了验证本文选取MobileNetV3作为特征提取网络的合理性与对MobileNetV3改进的有效性, 选择其它主流轻量化网络模型在同等条件下进行对比实验:YOLOv5s、MobileNetV3[18]、ShuffleNet V2[26]、GhostNet[27]、GSConv[28].

各模型对比实验结果如表1所示.由表可见, ShuffleNetV2具有更少的参数量和计算量, 但精度损失过大, 不能达到本文对航拍目标检测准确率的要求.GhostNet与GSConv性能相近, 虽然平均精度高于MobileNetV3, 但参数量与计算量下降较少, 不能达到本文对网络轻量化的要求.本文的研究目的在于提高网络精度的同时对网络进行轻量化处理.因此, 选择MobileNetV3作为新的主干网络更符合本文平衡精度与轻量化的要求.同时, 本文改进的MobileNetV3-CA的平均精度与模型复杂度均优于MobileNetV3, 可见本文对主干网络的改进合理有效.

| 表1 各模型实验结果对比 Table 1 Comparison of experimental results among different models |

为了验证本文提出的各个改进的有效性, 以YOLOv5s为基线模型, 在同等实验条件下设计一组消融实验, 所有实验均在VisDrone数据集上完成.

1)改进A.使用MobileNetV3-CA替换YOLOv5s的特征提取主干网络.2)改进B.在改进A的基础上, 使用调整后的网络结构改进多尺度特征融合网络.3)改进C.在网络中引入PfAAM.4)改进D.使用VariFocal Loss替换CIoU损失函数.

YOLOv5s添加不同改进后的消融实验结果如表2所示.由表可见, 使用改进的MobileNetV3-CA替换YOLOv5s主干网络, 虽然模型精度出现下降, 但参数量和计算量均大幅减少.进一步改进模型网络结构, 使模型的平均精度提升9.6%, 同时参数量也进一步下降, 但计算量出现提升, 这是因为网络结构的改进使网络层数减少、深度降低, 但同时导致网络计算特征图的尺度增加, 从而影响计算量.PfAAM的引入和VariFocal Loss的改进均未带来模型参数量和计算量的增加, 分别使模型mAP@0.5提升0.9%和1.3%, 表明引入PfAAM和VariFocal Loss的有效性.

| 表2 各模型在VisDrone测试集上的消融实验结果 Table 2 Results of ablation experiments of different models on VisDrone test set |

本文模型和YOLOv5s的精度与定位损失曲线如图6所示, 由图可见, 本文模型对目标位置和大小的预测更准确, 学习到更准确的边界框信息.

| 图6 改进前后模型精度与定位损失曲线对比Fig.6 Comparison of model accuracy and positioning loss curves before and after improvement |

总之, 相比YOLOv5s, 本文模型的mAP@0.5提升8.9%, 参数量下降71.4%, 计算量增加5.2 G.改进后模型精度与复杂度均得到有效改善, 为模型在终端平台的部署提供可行性.

为了进一步验证本文模型的有效性, 与当前主流一阶段目标检测算法及学者们针对VisDrone数据集的改进性YOLO进行对比.对比模型包括:SSD、YOLOv5s、TPH-YOLO[22]、 YOLOv7-tiny[29]、YOLOv8n、YOLOv5sm+[30]、基于多尺度分割注意力的无人机航拍图像目标检测算法(Multi-scale Split Atten-tion-YOLO, MSA-YOLO)[31].

各模型在VisDrone数据集上的对比结果如表3所示.由表可见, 相比YOLOv5s、YOLOv7-tiny、YO-LOv8n, 本文模型虽然计算量分别提升5.2 G、7.7 G、12.9 G, 但mAP@0.5分别提升8.9%、5.8%、9.6%, 参数量分别下降71.4%、66.7%、33.3%, 模型规模分别下降66.7%、61.0%、23.8%, 具有检测性能上的优势.

| 表3 各模型在VisDrone测试集上的对比结果 Table 3 Results of comparative experiments of different models on VisDrone test set |

相比YOLOv5sm+、MSA-YOLO, 本文模型的mAP@0.5分别提升5.7%、7.0%, 计算量分别下降9.8 G、125.1 G.

相比目前针对VisDrone数据集的主流算法TPH-YOLO, 本文模型的mAP@0.5提升2.5%, 计算量下降238.0 G.由此可见, 本文模型检测性能整体上得到有效提高, 更适合边缘设备的部署.

为了提高航拍目标检测任务的准确性, 为航拍目标检测模型的边缘化部署提供参考, 本文提出基于图像低维特征融合的航拍小目标检测模型.设计MobileNetV3-CA残差模块, 构建特征提取骨干网络, 在保持网络高性能的情况下减少网络中不必要的参数.调整网络结构, 改善网络深度, 降低网络感受野, 提高网络对航拍图像中大量小尺度目标的检测能力.引入PfAAM, 提高模型的鲁棒性和定位精度, 并使用VariFocal Loss, 平衡负样本对网络训练的不利影响, 提高网络泛化能力.在经典航拍目标检测数据集VisDrone上的实验表明, 本文模型具有较高的平均精度和较少的参数量.下一步工作的重点是对多尺度特征融合网络中标准卷积模块和C3模块的改进, 降低由于网络中特征图尺度增加带来的模型计算量的提升.

本文责任编委 张军平

Recommended by Associate Editor ZHANG Junping

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|