郑忠龙,博士,教授,主要研究方向为模式识别、机器学习、图像处理等.E-mail:zhonglong@zjnu.edu.cn.

作者简介:

盛晶晶,硕士研究生,主要研究方向为计算机视觉、对抗攻击与防御等.E-mail:jingjing.s@zjnu.edu.cn.

张大伟,博士,讲师,主要研究方向为深度学习、计算机视觉等.E-mail:davidzhang@zjnu.edu.cn.

蔡听依,博士研究生,主要研究方向为图神经网络、图表示学习.E-mail:tingyicai@zjnu.edu.cn.

肖 昕,博士研究生,主要研究方向为人工智能、智能教育等.E-mail:xinshaw@zjnu.edu.cn.

蒋云良,博士,教授,主要研究方向为智能信息处理、地理信息系统等.E-mail:jyl2022@zjnu.cn.

随着深度学习在视觉跟踪领域的广泛应用,对抗攻击逐渐成为影响方法性能的关键因素之一,然而针对对抗攻击的防御方法研究还处于初始阶段.因此,文中提出基于时空交并比约束的目标跟踪对抗防御方法.首先,在对抗样本上随机添加高斯噪声约束.然后,根据噪声等高线的切线方向,选择噪声等级相同且时空交并比分数最高的切线约束.通过其法线约束使防御目标向原始图像的方向更新,并将法线约束和切线约束进行正交组合优化.最后,经过不断迭代,选择具有最高时空交并比分数且噪声等级最低的组合向量作为最佳约束,添至对抗样本图像中,同时传递给下一帧图像,从而实现时序防御.在VOT2018、OTB100、GOT-10k、LaSOT跟踪数据集上的实验验证文中方法的有效性.

ZHENG Zhonglong, Ph.D., professor. His research inte-rests include pattern recognition, machine lear-ning and image processing.

About Author:

SHENG Jingjing, Master student. Her research interests include computer vision and adversarial attack and defense.

ZHANG Dawei, Ph.D., lecturer. His research interests include deep learning and computer vision.

CAI Tingyi, Ph.D. candidate. Her research interests include graph neural networks and graph representation learning.

XIAO Xin, Ph.D. candidate. Her research interests include artificial intelligence and intelligent education.

JIANG Yunliang, Ph.D., professor. His research interests include intelligent information processing and geographic information system.

With the wide application of deep learning in the field of visual tracking, adversarial attack is one of key factors affecting the model performance. However, the research on defense methods for adversarial attack is still in the initial stage. Therefore, a spatio-temporal intersection over union(IoU) constraints based adversarial defense method for object tracking is proposed. In this method, Gaussian noise constraints are firstly added to the adversarial examples. Then, according to the tangent direction of the noise contour, the tangential constraint with the same noise level and the highest spatio-temporal IoU score is selected. The normal constraint is utilized to update the defense target towards the direction of the original image, and the normal and tangential constraints are orthogonally combined and optimized. Finally, the combined vector with the highest spatio-temporal IoU score and the lowest noise level is selected as the best constraint, and it is added to the adversarial example image and transferred to the next frame image, thereby realizing temporal defense. Experiments on VOT2018, OTB100, GOT-10k and LaSOT tracking datasets verify the validity of the proposed method.

视觉目标跟踪是计算机视觉领域的一个重要研究方向[1], 目标是在视频序列中连续、自动地定位一个或多个感兴趣的目标对象, 现广泛应用于智能交通监控[2]、无人机[3]、自动驾驶[4]等领域.随着深度学习技术的发展, 基于深度学习的目标跟踪算法已取得显著进步, 能准确、鲁棒地跟踪目标.

对抗攻击是指故意添加微小、往往难以察觉的扰动到输入数据中, 从而使深度学习模型做出错误判断的攻击方式.对抗攻击揭示深度神经网络在理解数据时存在的脆弱性, 已引起广泛关注.

在视觉目标跟踪领域, 对抗攻击可能会通过修改视频帧中的像素值, 导致跟踪算法失效, 如跟踪到错误目标或完全丢失目标.这种攻击给依赖目标跟踪技术的视觉应用系统带来极大的安全隐患.

鉴于对抗攻击的潜在危害, 研究和开发有效的防御方法至关重要.防御方法的目标是提高模型的鲁棒性, 能抵御或最小化对抗攻击的影响.在视觉目标跟踪领域, 这意味着即使在受到对抗攻击的情况下, 跟踪算法也能准确跟踪目标, 保证应用的安全性和可靠性.

对抗攻击防御方法大致可分为两类:被动防御和主动防御.被动防御通常指通过增强模型的鲁棒性以抵御攻击, 如对抗训练[5, 6]、输入数据的预处理[7, 8]等.主动防御可能涉及检测对抗样本并采取相应措施, 如恢复原始输入或隔离恶意输入.

对抗训练[9, 10]是一种通过将对抗样本纳入训练过程中, 使模型学会识别并抵抗对抗攻击的方法.在视觉目标跟踪领域, 研究者尝试生成对抗样本并使用这些样本对跟踪模型进行再训练, 以提高模型对攻击的鲁棒性.虽然对抗训练能提升模型的鲁棒性, 但可能导致模型性能在正常样本上的下降, 并且需要较大的计算资源.

考虑到对抗攻击通常通过在输入图像中添加微小的扰动以欺骗模型, 特征降噪防御[11, 12]在模型的输入层或中间层加入降噪模块, 滤除潜在的对抗扰动.这种方法旨在增强模型处理自然图像时的鲁棒性, 同时减少对抗扰动的影响.

输入变换[13, 14]是另一种防御策略, 通过对输入图像进行预处理, 如裁剪、缩放、压缩或使用图像滤波器, 消除或减少对抗扰动的效果.这种方法的优点是实现简单、计算成本相对较低, 但防御效果难以令人满意.

目标跟踪领域中现已有一些有效的对抗攻击防御方法, 如基于冷却收缩预测框的CSA(Cooling-Shrinking Attack)[15], 但是针对目标跟踪的防御方法依然处于初始阶段, 相关研究具有挑战性, 存在对抗样本攻击防御困难、数据集缺乏、场景多样性等问题.对抗样本攻击通过对输入图像进行细微、人眼难以察觉的修改, 可轻易欺骗深度神经网络, 导致跟踪失败, 这类对抗样本攻击对视觉目标跟踪系统构成严峻挑战.

现有的防御方法, 如对抗训练、输入数据的预处理等, 仍存在效果不稳定、计算成本高等问题, 而且现有研究大多基于特定的数据集进行, 这些数据集可能无法覆盖所有实际应用场景中可能遇到的挑战.攻击者可利用数据集的特定属性设计攻击, 降低防御方法在实际应用中的有效性.

针对上述问题, 本文提出基于时空交并比约束的目标跟踪对抗防御方法(Spatio-Temporal Intersec-tion over Union Constraints Based Adversarial Defense Method for Object Tracking, STIC).通过添加最佳约束的方法, 将对抗样本改为交并比(Intersection over Union, IoU)分数与原始样本接近的防御样本, 提升跟踪器的跟踪性能.STIC分为两个模块:基于切线方向的约束和基于法线方向的约束.STIC首先引入基于高斯噪声的约束, 再选择交并比分数最高的作为切线方向, 通过法线约束使防御目标向原始图像方向更新, 通过正交组合形成最佳约束, 不断迭代以寻找最优的正向迭代, 最终实现对在线攻击的有效防御.多种不同类型数据集上的实验验证STIC能有效防御目标跟踪领域的对抗攻击, 提升跟踪算法的对抗鲁棒性.

文献[16]表明, CNN(Convolution Neural Net-work)容易受到对抗性样本的攻击.先进的分类器很容易通过在原始图像上添加人眼无法察觉的微小扰动而被干扰, 使模型最终给出高置信度的错误输出.根据攻击者是否了解模型参数, 对抗攻击划分为白盒攻击和黑盒攻击.在白盒攻击中, 攻击者可访问模型的全部参数和算法[17, 18], 而在黑盒攻击中, 攻击者只能访问模型的输入和输出[19, 20], 对模型的了解有限, 但更接近实际场景.

黑盒攻击常见的方式可分为基于决策的方法[19]、基于得分的方法[20]和基于转移的方法[21].基于转移的方法利用白盒模型生成对目标模型具有欺骗性的输入样本.基于得分的方法知道预测的分类概率, 依赖近似的梯度以生成对抗性示例.基于决策的方法中威胁模型只能访问分类的最终标签.除了算法攻击之外, 物理攻击方法还会在现实世界中创造对抗性物体[22, 23, 24], 进一步扩大对抗攻击的影响.

在早期研究中, 对抗攻击主要应用于图像识别与分类领域.Szegedy等[25]提出盒约束的L-BFGS, 使神经网络在对对抗样本进行错误分类的同时, 最小化干扰量.同样, Goodfellow等[5]提出Fast Gra-dient Sign Method, 目的是通过在图像中引入干扰, 使损失函数最大化, 从而导致错误预测.文献[24]方法旨在最小化输入和它生成的对抗性样本之间的Chebyshev距离, 但由于Fast Gradient Sign Method执行独特的梯度步骤, 通常导致次优解.因此, Moosavi-Dezfooli等[17]提出DeepFool, 使用一种简单、准确的方法计算和对比不同分类器的鲁棒性与对抗性扰动.Chao等[26]提出AdvGAN, 使用GAN(Generative Adversarial Networks)生成对抗性样本.Li等[27]提出GMAA(Generalized Manifold Adversarial Attack), 使用对抗流形攻击目标的状态集合, 为对抗攻击提供一种新的范式.

对抗攻击也一直在向其它领域拓展.在目标跟踪领域, 针对跟踪器的对抗攻击成为学者们关注的热点.通过优化置信度损失和特征损失, 修改初始的目标补丁, Chen等[28]提出One-Shot Adversarial Atta-cks.Yan等[15]提出CSA, 设计一个对抗性损失, 冷却热图上的热点区域, 并缩小预测的边界框.Jia等[29]提出RTAA(Robust Tracking against Adversarial Atta-cks), 在视频序列中产生对抗样本, 同时在产生轻量扰动时将时序信息也考虑在内, 将时序的扰动添加到原始的视频序列中.Jia等[30]提出IoU Attack, 根据预测的交并比分数产生扰动, 通过减少交并比评分, 降低时间相干边界框的准确性, 并将学到的扰动转移到接下去的几帧, 用于初始化时间运动攻击.Cheng等[31]提出TAT(Targeted Backdoor Attacks), 是一种有针对性的后门攻击, 使用双触发投毒技术攻击视觉目标跟踪模型.

上述攻击方法均对跟踪性能造成较显著的影响.

修改数据是针对对抗攻击进行最广泛研究的防御策略之一[32], 旨在训练阶段修改数据集或在测试阶段改变输入数据.其中常见的防御方法包括对抗性训练[5, 6]、阻止可转移性[16]、数据压缩[33, 34]和数据随机化[35, 36].

对抗性训练将生成的对抗样本纳入训练集, 以增强目标模型的鲁棒性.Kim等[37]提出FSR(Fea-ture Separation and Recalibration), 分离和重新校准恶意、非鲁棒的激活, 获得更鲁棒的特征图.在某些小型图像数据集上, 对抗训练甚至提高对干净图像的准确性.由此可见, 将对抗样本的可传递性作为防止对抗攻击的关键问题变得非常重要.Hosseini等[16]提出一种三步NULL标记方法, 将扰动输入标记为空标签, 用于防止对抗样本在不同网络之间的传递应用.Guo等[14]使用输入变换对抗对抗性样本攻击, 在样本输入网络前就将其转换成不可微图像进行防御.Dziugaite等[33]发现JPG压缩方法可改善因Fast Gradient Sign Method攻击而导致模型精度下降的问题.随后, Das等[34]采用类似的JPEG压缩方法, 提出一种针对Fast Gradient Sign Method和Deep-Fool攻击的防御方法.然而, 这种数据压缩明显带来原始图像分类准确率下降的问题.Xie等[35]验证随机调整对抗样本大小可降低对抗样本攻击的有效性.Wang等[36]使用与模型分离的数据转换模块消除图像中可能存在的对抗性干扰.Liao等[38]将防御表述为去噪问题, 提出HGD(High-Level Representa-tion Guided Denoiser), 对图像分类任务进行防御.面对攻击不再单一化的现状, Tsai等[39]提出GAT(Ge-neralizing Adversarial Training), 结合分量级的投影梯度下降和自动化攻击顺序安排以寻找最佳的攻击策略组合, 由此给出对抗组合攻击的有效防御机制.

在目标跟踪领域, 对于对抗攻击的防御方法的研究仍处于初级阶段.Suttapak等[40]提出MUNet(Multi-model UNet), 使用像素和特征去噪器, 随机在图像上进行端到端的训练, 生成的去噪图像在需要最小计算资源的情况下防御跟踪对抗攻击.

当前的防御策略主要局限于图像识别领域, 目的是提高识别的鲁棒性.本文提出基于时空交并比约束的目标跟踪对抗防御方法(STIC), 整体防御过程如图1所示, 将防御从单纯的图像分类领域扩展至视觉目标跟踪领域.

相比遭受攻击的对抗样本, 原始的干净样本在交并比分数方面表现更优.本文在对抗样本中引入基于时空交并比的约束, 使其更新后更接近原始的干净样本.被攻击的对抗样本x'由对应的干净图像x和添加在上面的扰动μ构成, 即

x'=x+μ.

对抗样本可使跟踪算法F预测错误目标位置, 即

F(x)≠F(x').

本文提出一种新的约束∈, 即

F(x)=F(x'+∈), s.t.‖ ∈‖ ≤δ .

其中:

在遭受攻击后的对抗样本上添加一个约束∈, 使受到攻击后的跟踪算法输出结果回归至正确结果, 达到防御目的.随着约束的添加, 交并比分数逐渐提高, 同时, 约束幅度也在一定范围内逐渐增加.STIC的关键在于通过引入约束使交并比分数逐渐增加, 不断改进对抗样本与原始图像交并比分数的相似程度, 使其逼近或达到原始样本的质量水平.

STIC遭受对抗攻击后会生成相应的对抗样本, 在对抗样本上叠加约束.最佳约束由切线方向的约束和法线方向的约束正交组成.交并比分数由空间交并比分数和时序交并比分数组成, 切线方向更新选择交并比分数最高的约束.法线方向更新选择微调参数, 使其更接近原始图像, 也使交并比分数升高.最后正交组合生成对应约束, 并不断迭代寻找交并比分数最接近原始图像且噪声等级最低的最佳约束, 以此形成防御样本.

本文设定交并比分数的提升与添加的约束增加之间呈正相关, 尽管它们并不完全呈正比, 但增长趋势一致.在应对对抗攻击时, 本文的主要目标是逐步寻找噪声等级最小且交并比分数最大的最佳约束.然而, 在实际情况中, 不同类型的噪声对跟踪器性能的具体影响难以建模.因此, 本文采取一种简化方法, 如图2所示, 图中等高线表示不同噪声等级.采用正交组合迭代的方式寻找噪声等级最低、交并比分数最高的最佳约束, 使对抗样本添加约束后向着原始图像接近.这一简化方法可帮助更好地理解和应对不同噪声情况下的跟踪器性能, 并为防御对抗攻击提供有力支持.

本文定义原始图像为O, 被攻击后的对抗样本为Xa, 中间第k次迭代添加约束后的图像为Xk.首先随机生成一些符合高斯分布的随机约束∈~N(0, 1), 选择正切方向的最小约束:

d(Xa, Xk)=d(Xa, Xk+∈), (1)

其中, d表示两幅图像的像素距离, 确保约束在相同的噪声等级.选择的约束∈m(m=1, 2, …, n)表示向Xk点处噪声等高线的正切方向约束.

STIC不会对模型的训练阶段造成任何影响, 仅在测试阶段施行, 具体的防御过程如算法1所示.

算法 1 STIC

输入M 帧对抗视频V, 初始化约束 P1=0,

原始图像 O

输出M 帧防御样本

for t=2 to M do

获取当前对抗帧Xa 和原始预测框

Xa=Xa+αPt-1

for k=0 to K-1 do

//切线方向

生成N个随机约束 ∈

选择符合 d(Xa, Xk)=d(Xa, Xk+∈)的n个约束

for j=1 to n do

预测 Xk+∈j的预测框

计算

SIoU=λSspatial+(1-λ)Stemporal

Sspatial=

Stemporal=

end

选择SIoU 最高的j

// 法线方向

调整ε 增加 SIoU

生成

end

获得学到的最佳约束Pt=

return

end

算法输入包括对抗攻击方法生成的对抗样本序列、原始图像、设置为0的初始化约束, 输出为防御后的样本.中间过程主要涉及生成正切方向约束和法线方向约束的更新, 两者均根据交并比分数更新进行迭代优化, 交并比分数由时间交并比分数和空间交并比分数相加得到, 再将正切方向和法线方向约束正交组合形成的约束添加至对抗样本, 以达到将跟踪效果从遭受攻击后的无法准确跟踪恢复至接近原始跟踪效果的防御目标.由于相邻帧的相似性, 再将学到的最佳约束传递到下一帧, 循环往复, 实现对每帧的防御效果.

总之, STIC在对抗样本上添加最佳约束, 以提高跟踪的交并比分数, 达到抵御视觉目标跟踪领域对抗攻击的目的.

STIC的关键组成部分是如何有效利用交并比以实现防御.交并比不仅能提供一个衡量跟踪效果的标准, 同时也是确定和应用约束的基础.因此, 本文通过定义交并比分数以帮助获得最佳约束, 设交并比分数:

SIoU=αSspatial+(1-α)Stemporal.

其中:α表示控制比例的参数; 空间交并比分数

Sspatial=

表示第t帧预测得到的包围框

Stemporal=

表示第t帧预测得到的包围框

本文综合考虑空间交并比分数和时序交并比分数, 结合后得到最终的交并比分数, 并且利用这个分数作为后续防御措施的依据.总之, 本文选择生成后防御样本中交并比分数最高的样本进行进一步研究.如图2所示, 最佳约束的更新方向由正切方向和法线方向正交组成.正切方向约束∈m在随机产生的高斯噪声中选取, 选取原则为符合式(1)的切向约束, 选择交并比分数最高的迭代版本.为了使迭代的最佳约束向交并比分数增大的方向迭代, 假设原始图像为O, 在迭代第k次的Xk点得到∈m, 法线方向约束为:

φ =ε ψ (O, Xk+∈),

其中ε 表示向原始图像O前进的步长.

所得的法线方向约束使交并比分数升高, 也是法向噪声等级的等高线方向.故可得到第k+1次迭代的防御图像:

生成的防御图像分别与原始图像和对抗样本图像之间的像素差异如图3所示, 尽管这三者在视觉上看起来相似, 但对于跟踪模型而言, 防御图像与原始图像更接近, 与对抗样本存在显著差异, 体现防御的有效性.峰值信噪比(Peak Signal-to-Noise Ratio, PSNR)越大表示图像之间相似度越大, 在图中, PSNR_1表示防御图像和原始图像的PSNR值, PSNR_2表示对抗样本和原始图像的PSNR值, PSNR_3表示防御图像和对抗样本的PSNR值.由各PSNR值可见, 虽然防御图像、原始图像和对抗样本三者在人们肉眼看来非常接近, 但是实际上防御图像会更接近原始图像, 而对抗样本与防御图像、原始图像有一定的差距.

本文实验的硬件设备是Intel Xeon Gold 5118 CPU和一块Nvidia V100 GPU.

选择在OTB100、VOT2018、GOT-10k、LaSOT这4个挑战性跟踪数据集上进行实验.OTB100数据集包含100个序列, 涉及到目标跟踪的11个属性.VOT2018数据集包含60个不同的序列, 提供一些小目标和非刚体运动等复杂场景的跟踪测试.GOT-10k数据集是一个通用的目标跟踪基准, 训练集和测试集完全没有重叠数据, 可有效评估跟踪器的泛化性能.LaSOT数据集是一个大型数据集, 包含70个类别, 每类包含20个序列, 突破当前数据集存在的规模小、局限于短时跟踪和存在类别偏见的问题, 是当前最大的具有高质量手动密集注释的跟踪数据集.

本文实验以代表性攻击方法CSA测试防御效果, 旨在最大限度恢复跟踪性能至最佳状态.CSA是一种专为SiameseRPN++设计的对抗攻击方法, 兼具简洁性和高效性, 并涵盖多种攻击策略.Siamese-RPN++通过置信分数图(热力图)定位目标, 并依据预测的修正量实现精确的尺度估计.CSA通过冷却热力图, 使跟踪器难以锁定目标, 同时将修正量设为极小值, 导致预测的边界框不断缩小, 无法准确框住目标, 实现冷却-缩小预测框的攻击目的.

CSA攻击可分为仅针对搜索区域、仅针对模板、同时针对搜索区域和模板这3种类型, 本文对这3种攻击类型均进行防御研究.

在目标跟踪过程中, 搜索区域至关重要, 它定义在可能的目标出现位置周围进行搜索的范围.大多数跟踪器仅在上一帧目标物体的位置周围进行搜索, 以此确定下一帧目标位置.然而, 这种搜索方法存在局限性, 因为攻击者可能利用扰动生成器对搜索区域进行攻击, 从而干扰跟踪器的正常工作.定义CSA-S为一种针对搜索区域的对抗攻击方法, 将扰动生成器应用于搜索区域, 从而影响跟踪器的性能.

针对搜索区域攻击, 本文采用STIC-S防御策略, 也仅针对搜索区域进行对应防御.搜索区域在目标跟踪过程中始终存在, 因此针对该类型的攻击防御极具挑战性.尽管如此, STIC-S在防御方面取得一定成效.在OTB100、VOT2018、GOT-10k、LaSOT数据集上, STIC-S均使各评估指标得到显著提升, 具体结果如表1所示.由表可见, 在OTB100数据集上, STIC-S的精度提升2.7%.在VOT2018数据集上, STIC-S的准确率提升3.7%, 鲁棒性也从2.074降至1.470, 这表明跟踪器的稳定性得到提升.此外, 在GOT-10k数据集上, STIC-S在阈值为0.5时的成功率也提升6.0%.在LaSOT数据集上, STIC-S针对CSA搜索区域的防御也表现出色, 精度提升5.2%, 归一化精度提升5.0%, 防御效果显著.这些实验结果有力展示STIC-S防御方法对仅攻击搜索区域的CSA-S攻击方法具有防御效果.

| 表1 防御搜索区域结果对比 Table 1 Result comparison of defending search areas |

模板是从视频序列初始帧中裁剪的图像, 为后续的跟踪过程提供目标的外观信息.模板与初始帧相关, 因此也是后续跟踪过程中关键的一环.定义CSA-T为针对模板的对抗攻击方法.具体地, 攻击者在模板中插入扰动生成器, 干扰跟踪器的正常工作.这种攻击方式针对跟踪器中用于目标识别的外观信息, 因此对目标跟踪方法具有较大威胁.STIC-T针对模板攻击进行防御, 减少扰动生成器对目标跟踪的影响.CSA-T和STIC-T结果对比如表2所示.

| 表2 防御模板结果对比 Table 2 Result comparison of defending templates |

由表2可见, STIC-T防御方法对于CSA-T攻击具有有效的防御效果.在OTB100数据集上, STIC-T的成功率提升3.7%; 在VOT2018数据集上, STIC-T的准确率提升3.0%; 在GOT-10k数据集上, STIC-T的平均重叠率提升14.8%, 阈值为5%时的成功率也提升5.4%.这些数据表明, STIC-T防御方法对于跟踪器的整体跟踪效果提升明显, 体现其防御的有效性.相比仅防御搜索区域的STIC-S, STIC-T在各数据集的指标值都高于STIC-S, 这进一步说明对于模板的防御效果更显著.

进一步, 本文设计一种同时防御搜索区域和模板的策略STIC-TS.CSA-TS采用同时攻击搜索区域和模板的策略, 将相同的扰动生成器同时应用于搜索区域和模板, 实现全面攻击, 详细结果如表3所示.由表可见, 在OTB100数据集上, STIC-TS防御方法成功率和精度分别提升24.4%和27.9%, 接近原始图像水平.在VOT2018数据集上, STIC-TS防御后的准确率59.1%与原始图像准确率60%几乎一致, 显示STIC-TS对准确率的防御效果可达到原始图像水平.在GOT-10k数据集上, 平均重叠率从攻击后的24.2%提升至40.7%, 阈值为0.5时的成功率提高25.7%, 阈值为0.7时的成功率从7.2%上升至23.3%, 达到接近原始图像水平.

| 表3 同时防御搜索区域和模板结果对比 Table 3 Result comparison of defending search areas and templates |

CSA-TS和STIC-TS防御跟踪的结果如图4所示, 绿框为CSA-TS攻击后跟踪结果, 红框为STIC-TS防御后跟踪结果.

通过对比预测的包围框可发现, CSA-TS会导致包围框缩小并偏离目标位置.相比之下, STIC-TS的防御策略成功恢复包围框的大小, 并还原至原始目标位置, 从而显著提升跟踪效果, 实现预期的防御目标.

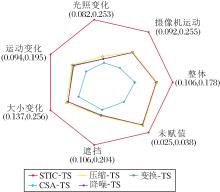

雷达图展示各攻击方法与防御方法在VOT-2018数据集上的属性对比结果, 具体如图5所示.由图可见, STIC-TS在VOT2018数据集上的表现显著优于其它方法, 其次为STIC-T.但STIC-T与CSA-T在遮挡指标上非常接近, 可能是因为只防御模板攻击, 对后续帧出现的遮挡没有优化防御作用.

| 图5 各攻击方法和防御方法在VOT2018数据集上的属性对比雷达图Fig.5 Attribute comparison of different attack methods and defense methods on VOT2018 dataset |

各方法在OTB100数据集上的成功率与精度对比如图6所示.

| 图6 各攻击方法和防御方法在OTB100数据集上的成功率和精度结果Fig.6 Success rates and precision of different attack methods and defense methods on OTB100 dataset |

由图6可见, STIC-TS防御方法表现最优, 但与STIC-T非常接近.攻击性最强的仍然是CSA-TS, 突显STIC-TS的强大防御能力.同时防御搜索区域和模板可显著提升防御效果, 优于单一防御策略.这可能是因为STIC-TS对更强攻击具有更强的防御效果.单一攻击只能获得单一防御, 交并比分数的优化也只针对一种, 对搜索区域和模板同时进行交并比分数的优化会获得更优的防御效果.

本文通过添加最佳约束进行防御, 约束的大小通过l2范数进行衡量, 本文分别将最佳约束l2范数最大值设置为1 000, 5 000, 10 000, 150 000, 不同约束大小对最终防御效果的影响如表4所示.由表可见, 最终选取的约束大小为10 000.

| 表4 不同程度的防御效果对比 Table 4 Comparison of defense effects of different degrees |

如表4所示, 当约束l2范数最大值不超过10 000时, 随着最佳约束最大值的增加, STIC防御方法在VOT2018、OTB100数据集上的防御表现变优.然而, 当最大值设置为15 000时, 防御效果会略有下降, 但仍高于最大值为5 000时的指标值.实验数据表明, 在一定范围内, 最佳约束的最大值设置越高, 防御效果越优.然而, 当超过某一阈值时, 继续叠加最佳约束反而会降低防御效果, 导致跟踪性能下降.

具体可视化结果如图7所示, 红框、绿框、黑框、蓝框分别代表l2范数最大值设置为1 000, 5 000, 10 000, 150 000时的跟踪结果.由图可见, 黑框能较好跟踪到目标, 达到最佳的防御效果, 即本文选取的l2范数最大值, 而l2范数最大值为1 000时的红框往往较小, 依然受到较严重的对抗攻击的影响.

在目标跟踪领域, 当前尚缺乏专门针对对抗攻击的防御手段, 因此本文采用经典预处理方法作为防御策略, 包括压缩、降噪和变换手段, 旨在同时防御模板和搜索区域的攻击.这些预处理方法的具体防御效果如表5所示.

| 表5 各方法在2个数据集上的指标值对比 Table 5 Index value comparison of different methods on 2 datasets |

由表5可见, 在VOT2018数据集上, 相比CSA-TS, STIC-TS在准确率上提升12.4%.其它预处理防御方法的提升效果相近, 但均低于STIC-TS.在鲁棒性、期望平均重叠率和丢包数指标上, STIC-TS也均优于其它预处理防御方法.这充分表明STIC-TS防御方法的显著效果.在OTB100数据集上, 各预处理防御方法的成功率与精度表现非常接近.然而, STIC-TS防御方法展现出更出色的防御效果, 相比CSA-TS, 成功率提高24.4%, 精度提升27.9%.相比其它预处理防御方法, STIC-TS的成功率与精度也有所提高, 这进一步验证STIC-TS在目标跟踪任务中的有效性.

实验结果表明, 这些预处理方法对于同时针对模板与搜索区域的攻击具有一定的防御效果, 然而, 相比STIC-TS, 防御效果并不显著.STIC-TS在准确率和精度上均表现出明显优势, 展现其在实际应用中的有效性和优越性.因此, 在实际应用中, 可考虑采用STIC-TS提高目标跟踪的鲁棒性和稳定性, 应对各种潜在的攻击.此外, 本文方法可为其它类似问题提供有益的启示和借鉴.

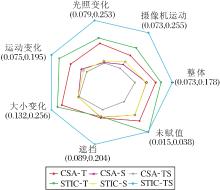

图8更加直观展现不同防御方法的属性对比效果, 压缩、变换、降噪的防御方法效果较接近, 比攻击后的结果有一定提高, 但是STIC-TS防御效果更优.

本文提出基于时空交并比约束的目标跟踪对抗防御方法(STIC), 旨在有效抵抗对抗攻击, 降低对跟踪器的影响.STIC无需参与训练阶段, 能在在线跟踪环境中实现有效防御.首先, 在对抗攻击生成的样本上随机引入高斯噪声的约束, 作为初始约束.这一步旨在通过噪声的随机性防御攻击的确定性, 从而在某种程度上降低对抗攻击影响.然后, 通过计算时空交并比分数, 对初始的约束进行优化.时空交并比分数由空间交并比分数和时序交并比分数共同构成, 旨在全面优化防御跟踪效果.这一步的核心思想是寻找最佳约束, 在添加约束的等级最小的情况下, 实现时空交并比分数最高.STIC针对视觉目标跟踪的对抗攻击具有显著的防御效果.由于防御直接在模型的测试阶段进行, 因此能避免潜在的后续对抗攻击.本文在多个主流的跟踪数据集上进行广泛的实验评估, 结果表明, STIC取得有效的防御效果.今后将进一步探索STIC的通用性, 致力于提升深度学习模型的对抗鲁棒性.

本文责任编委 高 隽

Recommended by Associate Editor GAO Jun

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|