王飞跃,博士,研究员,主要研究方向为智能系统和复杂系统的建模、分析与控制.E-mail:feiyue.wang@ia.ac.cn.

作者简介:

沈甜雨,博士,副教授,主要研究方向为具身智能、机器视觉、智能感知.E-mail:tianyu.shen@buct.edu.cn.

张 慧,博士,副教授,主要研究方向为多智能体协同、跨域适应、多模态感知.E-mail:huizhang1@bjtu.edu.cn.

叶佩军,博士,副研究员,主要研究方向为复杂系统管理与控制、认知计算、多智能体系统、智能交通.E-mail:peijun.ye@ia.ac.cn.

2024年是新人工智能(Artificial Intelligence, AI)的里程碑之年,人工智能科学取得一系列突破性进展.文中从大模型与具身智能、人工智能生成内容(Artificial Intelligence Generated Content, AIGC)、AI智能体、人工智能驱动的科学研究(AI for Science, AI4S)与人工智能相关科学研究(Science for AI, S4AI)、AI相关政策与平台等方面回顾2024年人工智能领域热点和动向.随着大模型、智能体等技术的飞速进步,AI应用领域持续扩大,对各行各业引发新的冲击,政策与平台建设不断完善,新质生产力展现出更大的发展潜力.围绕自主智能“新AI”,期待诞生更多AI里程碑工作.

WANG Fei-Yue, Ph.D., professor. His research interests include modeling, analysis, and control of inte-lligent systems and complex systems.

About Author:

SHEN Tianyu, Ph.D., associate profe-ssor. Her research interests include embodied intelligence, machine vision and intelligent perception.

ZHANG Hui, Ph.D., associate professor. Her research interests include multi-agent co-llaboration, domain adaptation and multi-modal perception.

YE Peijun, Ph.D., associate professor. His research interests include management and control of complex systems, cognitive computing, multi-agent systems, and intelligent transportation systems.

In 2024, a milestone year for new artificial intelligence(AI), significant breakthroughs were achieved in the field of artificial intelligence. This paper reviews the hotspots and trends in artificial intelligence from various aspects, including large models and embodied intelligence, artificial intelligence generated content(AIGC), AI agents, AI for Science(AI4S) and Science for AI(S4AI), as well as AI-related policies and platforms. With the rapid advancement of large models and AI agent technologies, the application of AI continues to expand, leading to new impacts across various industries. The construction of policies and platforms is continuously improving, and new quality productive forces are showing greater development potential. For autonomous intelligence, the "new AI", the emergence of more milestone works are being expected.

2024年, 是人工智能 (Artificial Intelligence, AI)科技与产业结合的里程碑之年.这一年, 以ChatGPT系列大模型为代表的人工智能生成内容(Artificial Intelligence Generated Content, AIGC) 热浪开局, 又迎来视频大模型Sora、抖音豆包、特斯拉人形机器人Optimus的接连冲击.在万众瞩目中物理和化学诺贝尔奖花落AI研究者, 在这一桂冠加持下, 人工智能驱动的科学研究(AI for Science, AI4S)向各个学科深入渗透, 年终OpenAI相继发布推理模型o1及继任模型o3, 推理范式研究成为国内外大模型领域新的开端.

2024年, 是AI智能体(AI Agents)的元年.伴随着持续高涨的大模型与具身智能热潮, AI被重铸为AI Agents, 并进一步演变为自主智能(Autonomous Intelligence), 即集无人机、无人车、无人船等各种物理机器人与数字人为一体的“ 新AI” , 实现从AI Agents到数字人、机器人、生物人一体化, 对各行各业引发新的冲击, 新质生产力的发展空间更是显著扩展.

回望2024, AI多点开花, 已成为全球经济增长的新前沿.展望2025, 新AI的变革创新与应用深化必将更加波澜壮阔.在此背景下, 探索AI领域的关键技术及进展显得尤为重要.本文总结2024年AI科学技术主要热点, 如表1所示.

| 表1 2024年人工智能科学主要研究热点 Table 1 Main research hotspots of artificial intelligence in 2024 |

2024年, 大模型广泛应用于语言处理、视觉生成、空间智能等领域(如图1所示), 其常用架构包含Transformer、Mamba等.本节从大模型基础架构优化、提示工程、检索增强生成与微调及通用大模型与行业大模型展开介绍.

1.1.1 大模型基础架构优化

Transformer架构是当前广泛应用的主流大模型架构, 能捕捉序列中任意两个位置间的关联权重, 同时支持并行计算, 相比传统的卷积架构, 大幅提升模型的能力上限.

然而, 2024年以来, 随着大模型任务规模的不断扩大, 当前基于自注意力机制的Trans-former架构使模型的算力需求、计算复杂度和训练推理成本随参数增加呈指数级增长, 对大模型的迭代优化和应用落地提出挑战.

因此, 对大模型基础架构的创新性探索逐渐成为大模型研究的重要趋势之一.

近年来, 研究者们针对Transformer的局限性, 引入其它架构的特点, 解决计算开销、可扩展性等问题, 设计出多种混合模型架构, 如KAN (Kolmogorov-Arnold Network)、Mamba-2[1]、TimeMixer、Falcon Mamba、LFMs(Liquid Foundation Models)等, 具体如表2所示.

| 表2 大模型典型架构对比 Table 2 Comparison of typical architectures for large models |

2024年5月, Dao等[1]发布Mamba-2, 其原理类似一个智能调度系统, 传统Transformer(如BERT(Bidirectional Encoder Representations from Transfor-mers))检查时对所有数据同等对待, 而Mamba-2会根据数据重要性动态开关通道, 因此在训练效率上提升2~8倍, 同时在语言建模方面与Transformer水平相当.2024年9月, 研究者在RWKV (Recep-tance Weighted Key Value) 循环神经网络混合架构的基础上, 推出最新版本RWKV-7的预览版, 该模型具有灵活的状态演化模式, 类似“ 接力赛记忆法” , 每个运动员(神经元)既传递接力棒(当前信息), 又参考自己的历史经验(长期记忆), 具备极强的上下文学习能力, 可实现高度并行化训练与高效推理, 能在相同算力条件下超越Transformer的表现.2024年9月, Liquid Al团队的研究者发布基于液体神经网络模型的混合架构LFM, 其原理类似“ 变形水母” 的智能体, 神经网络连接会像液体一样动态变化, 相比Transformer, LFM能更有效利用上下文长度, 在处理长序列输入时内存使用量显著减少, 有效处理多种类型的数据, 并且可根据特定的硬件平台或参数要求进行自动优化.

2024年涌现出的创新架构结合循环神经网络、状态空间序列模型、液体神经网络等思想, 通过设计混合模型, 优化大模型的基础架构, 性能良好, 甚至在很多评测数据集上超越Transformer.然而, 这些创新架构在训练复杂度与效率、模型可解释性、任务适配性与工程化部署等方面仍存在诸多局限和不足, 在实际应用层面, 这些新兴混合模型的训练和推理过程仍有待产业界进一步的验证, 未来在轻量化设计、算法与硬件联合优化、跨模态与多场景扩展方面值得进一步探索.

1.1.2 提示工程、检索增强生成与微调

在提升大模型输出质量的研究中, 提示工程(Prompt Engineering)、检索增强生成(Retrieval-Augmented Generation, RAG)和微调(Fine-Tuning)是三种主要方法.

提示工程通过精心设计输入文本(Prompt), 引导预训练模型生成特定输出.2024年, 提示工程在结合 Scaling Law 的研究中取得显著进展, 开发可扩展的提示设计方法, 减少为不同规模模型单独设计提示的成本[2].RankPrompt[3]将排序问题转化为多元回答的对比过程, 有效增强大模型的推理能力.ChainLM[4]改进思维链(Chain-of-Thought)提示, 采用“ 步骤级辩论” 机制, 生成更优质的提示.DDPrompt(Differential Diversity Prompting)[5]生成多样化推理路径并采用投票机制筛选最优提示, 进一步增强模型的推理能力.然而, 目前技术仍缺乏稳定性与泛化性, 提示的微小改动可能导致输出的显著差异.同时, 领域适配性仍存在不足, 针对特定任务优化的提示模板难以直接迁移到其它领域.此外, 高质量提示仍依赖专家经验, 自动化生成工具容易陷入局部最优.

检索增强生成(Retrieval-Augmented Generation, RAG)在模型处理信息前进行内容检索, 将相关数据整合到对话中, 解决模型知识局限和消息窗口不足的问题.2024年, RAG技术取得里程碑式进展[6].微软提出GraphRAG框架[7], 引入Leiden算法, 用于精确检测图的层次社区结构, 并利用LLM(Large Language Model)生成层级摘要, 实现知识的高效分层组织与检索.5月, GPT-4o[8]的发布推动多模态RAG技术的发展, 而12月发布的Fast GraphRAG[9]作为 GraphRAG 的轻量化版本, 简化社区及摘要生成环节, 降低对LLM的调用频率.然而, 目前检索质量的关键问题在于数据覆盖不全(如检索库未涵盖长尾知识时, 模型可能生成“ 自信但错误” 的答案)及多模态检索效率较低(如跨模态嵌入对齐仍不成熟, 影响检索精度).此外动态检索(如实时网络搜索)可能引入延迟和噪声, 目前仍缺乏统一指标区分“ 模型生成错误” 和“ 检索源错误” , 难以有针对性地进行优化.

微调则是在预训练模型的基础上, 利用少量特定领域的数据进行进一步训练, 提升模型在特定任务上的性能[10].RoSA(Robust Adaptation)[11]在固定预训练权重上训练低秩和稀疏组件, 实现参数高效的微调.Zhang等[12]提出Zeroth-Order Optimization, 显著降低大模型微调中的内存消耗.此外, 英伟达与佐治亚理工学院联合研发的RankRAG框架[13]在Llama 3上实现重大突破, 通过指令微调有机结合上下文排名与答案生成, 减少对独立检索模型的依赖, 并在知识密集型基准测试中超越GPT-4[14].然而, 目前技术仍存在数据依赖与过拟合风险, 小样本微调容易受数据偏差影响(如领域特定表述), 导致模型遗忘通用能力.此外, 在联合微调时可能存在多任务冲突, 任务间梯度干扰可能降低整体性能.微调后的模型动态环境适应性较差, 难以适应持续变化的需求, 这也是需要关注的问题之一.

综上所述, 2024年在提示工程、RAG 技术及 LLM 微调等领域的创新成果, 不仅显著提升模型性能, 也为其在更广泛场景中的应用奠定坚实基础.然而, 当前技术仍需在稳定性、动态适应性和协同优化层面突破, 如考虑提示、检索与微调跨技术协同与联合优化, 才能支撑LLM在更多复杂场景的可靠应用.

1.1.3 通用大模型与行业大模型

2024年是大模型技术突破与行业应用迈向成熟的重要转折点.GPT-4级别的大模型不再稀缺, 许多性能超越GPT-4的模型出现, 运行效率显著提升, 成本急剧下降, 尤其是支持图像、音频、视频处理的多模态模型越来越普及.

2024年大模型技术和产品飞速发展, 2月, Open- AI推出Sora, 进一步优化多任务处理和人机交互, 为行业应用奠定基础.5月, OpenAI发布GPT-4, 以更强大的自然语言处理和创造能力在学术界和企业实践中引发全球关注[15].6月, Claude 3.5 Sonnet[16]提升任务规划和复杂场景推理能力, 巩固其在智能助手领域的地位.7月, Meta推出开源的Llama 3.1, 参数量达40.5 B, 被认为是当时最强的开源大模型, 为开发者提供深度定制平台, 同时推动AI社区技术创新[17].

大模型技术也实现多模态与思维链的突破, 8月, 阿里云发布Owen 2VL, 这款专注多模态视觉-语言处理的大模型在电商和智能客服领域表现优异[18].9月, GPTo1引入思维链推理, 能像人类一样分步思考, 大幅提升逻辑推理能力[19].12月, Open-AI推出新的推理模型系列o3, 能更好地理解复杂的数学和逻辑问题[20].同期, DeepSeek-V3上线并同步开源, 超越Qwen2.5-72B和Llama-3.1-405B等主流模型[21].

2024年, 大模型技术在多模态能力、推理精度、硬件效率和应用生态等方面取得显著突破.随着硬件门槛降低和应用能力增强, Scaling Law的应用使得大模型能在更复杂和多样化的任务中表现出色, 推动大模型技术的普及, 并加速社会各领域的变革与创新.然而, 动态多模态交互瓶颈(如自动驾驶中的突发场景解析)、生成质量的不可控性、长链推理的脆弱性等问题仍然存在, 此外, Scaling Law的边际效益递减及动态稀疏化、混合精度训练等优化技术引入的额外调度开销也是未来值得关注的问题.

行业大模型是指基于通用大模型技术底座, 针对特定行业需求, 融入大量行业数据和知识的技术, 具备更高的专业性、场景适配性和成本优势.结合基础大模型与行业知识训练的专业大模型, 可在保持较高通用性的同时, 深度满足垂直领域需求, 实现更优性价比和更高精准度的应用落地.

数字原生行业是大模型应用的先行者.这些行业利用大模型优化营销、客服、内容生成等环节.2024年2月, 刘冀辰等[22]设计供电营业厅柜台服务智能化终端, 提升电力客户办电服务体验.7月, Cui等[23]研究基于混合专家大语言模型的多代理协作法律助手Chatlaw, 集成知识图谱和模拟真实律师事务所工作流程的标准操作程序, 提高AI法律服务的可靠性和准确性.生产性服务业作为传统行业与大模型结合的示范区, 表现出较快的推进速度, 如金融机构利用大模型提升营销、风控等环节的效率.2024年5月, Liang等[24]提出训练多模态变换器模型以自动预测人类反馈的方法, 通过丰富的人类反馈改进文生图像的质量, 在金融市场情景模拟等方面蕴含巨大潜力.重资产行业在大模型应用上进展较慢, 如能源、电力、建筑、制造等领域, 主要受限于生产流程的复杂性和高度专业化[25].

总之, 影响行业大模型应用速度的两个关键因素是数据可得性和需求适配度.数据质量越高, 需求越匹配行业, 推进越快.然而, 目前尚无行业达到完全落地成熟阶段.只有解决技术稳定性、可解释性及插件可靠性等问题, 行业大模型才能实现真正的商业化落地和成熟应用.

具身智能强调机器与物理世界的直接互动, 通过大脑、身体和环境三者的相互作用, 使智能体具备智能行为及自主进化能力.2024年, 人形机器人、四足机器人等具身智能机器人取得快速发展, 具体如图2所示.

本节从具身智能关键技术出发, 对涉及的具身感知与推理、具身交互与执行、空间智能等具体技术及具身智能机器人典型应用展开介绍.

1.2.1 具身感知与推理

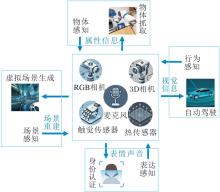

具身感知与推理与基于计算机视觉的感知推理不同, 为了应对多样、不确定和复杂的环境具有多模态感知、快速推理的特点[26, 27], 具体如图3所示.

具身感知与推理系统通过集成多源传感器, 如RGB相机、3D相机、麦克风和触觉传感器, 实现对环境的全面理解.PSG-4D(4D Panoptic Scene Graph)[28]将时间视为场景表示中的变量, 作为第四维度纳入现有的3D场景图中, 旨在连接动态4D世界中感知的原始视觉数据与高层次视觉理解, 类似一个“ 带记忆的监控系统” , 可理解物体的移动历史.Motion-GPT[29]将人类运动视为一种身体语言, 引入自然语言模型进行动作相关生成, 实现运动-语言预训练, 提高运动相关任务的性能, 类似一个“ 肢体翻译官” , 将动作转换为语言.MotionLLM[30]结合视频序列和动作序列, 有效捕捉身体部位的细微动态变化和语义信息, 适用于人类动作的理解、字幕生成和推理.针对感知推理模型体量巨大、推理速度较慢的问题, Sim2Real技术应运而生.EAGERx(Engine Agnos-tic Graph Environments for Robotics)[31]用于机器人学习的Sim2Real转换, 提供统一的软件流程, 支持真实环境和模拟环境下的机器人学习, 类似“ 机器人的电竞训练营” , 通过大量的虚拟特训提升机器人的现实抗干扰能力.其核心特点包括集成延迟模拟、领域随机化功能和提出的同步算法, 这些都有助于缩小模拟与现实之间的差距.

不同于仅识别图像中的物体, 具有具身感知推理能力的智能体必须在物理世界中移动并与环境互动, 这需要对三维空间和动态环境具有更透彻的理解.相比小模型, 大模型在推理任务上能力大幅提升, 这使基于大模型构建具身智能体成为一种自然的选择.然而, 目前的具身感知推理面临感知局限性、数据依赖性、计算资源需求、实时性能限制、维护难度较大等问题.人们期待上述问题的进一步优化与解决, 以便充分发挥大模型的潜力, 实现高效感知与快速推理.

1.2.2 具身交互与执行

具身智能体需要积极与周围环境或其他参与者进行交互式理解, 并在理解与模拟中验证并输出自身下一步行动, 而如何将具身智能体对外界环境的感知和认知结果转化为行动是具身执行阶段的核心.

具身交互是指智能体在物理空间或模拟空间中与人类和环境互动.典型的具身交互任务包括具身问答和具身抓取.在具身问答任务中, CAM(Central Answer Model)[32]整合不同代理的响应, 生成更可靠的答案.CoPa[33]是一种结合大模型的抓取方法, 通过融合多模态大模型与物体分割模型, 实现从粗略到精细的抓取点定位.MANUS(Markerless Hand-Object Grasp Capture Using Articulated 3D Gau-ssians)[34]采用铰接式3D高斯函数, 用于无标记捕捉手部与物体的抓握动作, 实现对手部关节运动的高保真度模拟并精确估计手与物体之间的接触点.

具身执行是实现具身智能的核心部分, 也是具身智能由概念到落地迈出的重要一步.Embodied-Scan[35]是一个多模态的、自我中心的3D感知数据集和基准测试, 根据第一人称观察充分理解 3D 场景, 并将其语境化为语言进行交互.具身导航是具身执行的重要组成, 它指导智能体在三维环境中移动以完成导航任务[36].LEO[37]是一种具身多模态通才代理, 在3D世界中执行感知、理解、推理、规划和行动任务, 通过统一的任务界面、模型架构和目标进行训练, 涵盖3D字幕生成、问答、推理等领域.

现今的具身交互与执行技术仍存在物理交互困难、硬件限制和决策复杂性等问题.在物理交互方面, 智能体难以精确模拟复杂的动力学和物理规律, 尤其是在进行精细操作和力量控制时.硬件平台的尺寸、重量、功耗和成本限制也制约智能体的性能和应用范围.在复杂环境中, 智能体在处理多任务、多目标或高度不确定性场景时的决策能力不足.这些问题尚待解决, 如何实现更先进的交互和控制系统、并增强智能体在多变环境中的执行能力仍需进一步研究.

1.2.3 空间智能

空间智能[38]是一种赋予机器感知、理解和在三维空间中交互的能力, 其突破传统二维视觉的局限, 使机器能在复杂的三维世界中导航、操作和决策.它不仅是人工智能发展的关键方向, 还将彻底改变人类与物理世界的交互方式.

空间智能与空间计算密切相关, 前者依托后者提供的基础设施和技术支持, 通过高度集成的感知、推理和行动能力, 实现对三维空间的深入理解与互动.空间计算[39]结合物理世界与数字内容, 通过对现实世界的数字化建模和虚拟场景的增强, 使人类能以全新的方式感知和操控世界.根据涉及的不同层次, 空间计算可分为基础设施层、数据层和交互层.其中, 基础设施层提供硬件支持和网络环境, 数据层负责对现实世界的感知、收集和处理, 交互层聚焦于人机互动的优化与提升.

近年来, 各科技公司纷纷推出标志性的空间计算设备, 为这一技术的广泛应用奠定基础.苹果公司于2024年2月发布混合现实(Mixed Reality, MR)头显设备Apple Vision Pro[40], 凭借出色的视觉效果和精准的空间定位能力, 引领MR领域的技术潮流.9月, Meta公司在年度开发者大会上发布新一代更具性价比的混合现实头显设备Meta Quest 3S[41], 进一步降低用户接触MR技术的门槛.Rokid则在11月推出与暴龙联名的消费级AI+AR眼镜Rokid Glasses, 轻便的设计和高效的空间交互能力, 受到广泛关注.这些设备不仅是空间计算技术的具体体现, 也展示三维空间交互的多种可能性.

空间智能旨在结合空间计算对虚拟世界的操控能力和具身智能触达现实世界的能力, 需要大量的数据处理、模型训练及技术在现实场景中的有效部署.它的发展将为通用人工智能(Artificial General Intelligence, AGI)铺平道路, 最终实现虚拟与现实的深度融合.然而, 感知与建模的物理瓶颈(如环境动态性的处理不足、视-触-力跨模态对齐数据不足导致真实世界的物理反馈难以数字化建模)、传感器硬件的固有缺陷、空间因果推理的缺失等问题仍将制约AGI的实现和规模化落地, 空间智能仍需跨越从“ 感知重建” 到“ 认知决策” 的鸿沟.

1.2.4 具身智能机器人应用

随着人工智能、机器人学、传感器技术及材料科学的不断进步, 具身智能机器人正逐渐从实验室走向实际应用, 展现出极大的应用潜力和前景.当前, 多个知名公司纷纷推出各具特色的具身智能机器人[42, 43].这些机器人具备感知、决策和行动的能力, 可与人类及环境进行自然互动, 并完成各种复杂任务.图4展示2024年推出的一些典型具身智能机器人.

波士顿动力于2024年推出新一代全电动Atlas机器人, 这一变革不仅扩展机器人的运动范围和增强自身力量输出, 还提高自身灵活性和反应速度.优必选科技于2024年发布工业级人形机器人Walker S1, 经过多次升级, Walker S1具备更高的稳定性和任务执行效率, 已在工业自动化和仓储物流领域取得重要应用.特斯拉于2024年对第二代人形机器人Optimus Gen 2的运动能力、自主性、任务执行效率等方面做出多项改进.宇树科技于2024年推出新型四足机器人B2-W, 能在复杂环境中高效移动, 表明其在特定领域中的卓越应用潜力.成都人形机器人创新中心于2024年发布首款“ 贡嘎一号” 人形机器人, 具备独立思考和推理能力, 能快速理解任务、观察环境、规划流程并精确执行.1X Technologies公司于2024年发布专为家庭场景设计的双足人形机器人NEO Beta, 能在人与人之间安全互动.它致力于通过提供物品抓取和陪伴服务, 探索其在改善行动不便群体生活质量方面的潜力.

这些机器人代表2024年具身智能机器人技术的最新应用, 在感知、决策、行动和交互方面都取得 显著进展, 具备在复杂环境和危险环境中自主执行任务的能力.随着技术的不断突破, 未来这些机器人将在工业、服务、医疗、救援等多个领域表现出更大的应用前景, 推动社会和行业的智能化进程.

人工智能生成内容(AIGC)是一种利用人工智能技术生成图像、视频、文本等多种内容的创新技术, 近年来在数字创意产业、媒体娱乐、教育培训等领域发挥越来越重要的作用.然而, AIGC仍面临一些挑战, 如生成内容的质量和一致性、数据隐私与伦理问题、技术的普适性和泛化能力等.

本节将探讨2024年AIGC在视频生成与世界模型的融合、3D内容生成技术的突破、虚拟数字人技术的创新等关键技术方面的最新进展, 分析这些前沿研究如何推动AIGC在理解和模拟现实世界方面的能力提升.

2024年AIGC关键进展如图5所示.

2.1.1 视频生成与世界模型

视频生成与世界模型的结合是当前人工智能与计算机视觉领域的重要研究方向之一, 它可理解世界的基本运行规律, 实现AGI[44].世界模型视频生成示意图[45]如图6所示.

2024年, 随着多模态大语言模型和Sora[46]的出现, 视频生成与世界模型成为热门的研究前沿之一[47], 视频生成技术逐渐从静态图像合成扩展至动态场景的构建, 而世界模型则为理解和预测视频中的动态过程提供强有力的理论支撑.通过视频生成, 系统能模拟真实世界的场景变化, 而世界模型的引入使这种生成过程具备对环境内在物理规律和因果关系的捕捉能力, 从而增强生成结果的真实性和一致性.在此背景下, 新理论和新技术不断涌现.

2024年1月, 腾讯AI实验室在已有的VideoCrafter1[48]的基础上推出VideoCrafter2[49]视频生成模型, 能生成高质量视频.2月, OpenAI Sora团队发布视频生成工具Sora[46], 通过大规模的视觉数据训练, 学习世界模型, 生成高质量、高逼真度的视频, 几乎可以与真实拍摄的视频媲美, 由此标志AI在理解和模拟现实世界方面取得革命性的进展.5月, Google DeepMind推出视频生成模型Veo, 建立在GQN(Generative Query Network)[50]、DVD-GAN(Dual Video Discriminator)[51]、Imagen Video[52]、Phenaki[53]、VideoPoet[54]等工作基础上, 可通过文本提示生成超1 min的高质量1 080 dpi视频.5月, 香港科技大学提出自动驾驶世界模型Vista[55], 这是一种通用的自动驾驶世界模型, 能在高时空分辨率下预测逼真的未来.6月, 清华大学提出首个生成式城市世界模型UrbanWorld[56], 为三维城市环境的自动化创建开辟新的路径.10月, 智源研究院发布原生多模态世界模型Emu3[57], 实现视频、图像、文本三种模态的统一理解与生成, 超越包括 SDXL[58]、LLaVA-1.6[59]、Open-Sora[60]在内的多种知名开源模型.12月, Google DeepMind推出视频生成模型Veo2, 能生成4K分辨率的视频, 同时能理解和模拟真实世界中的物理现象和视觉风格, 从而创造既逼真又具有艺术感的视频.

视频生成与世界模型正从“ 视觉欺骗” 迈向“ 物理可信” 阶段, 但还需解决因果性(理解世界)、可控性(编辑世界)、可持续性(高效模拟)三大核心挑战.物理一致性的“ 幻觉” 问题(如生成视频中存在违背常识的现象、长时序连贯性不足等)、可控性与多对象交互瓶颈、训练数据依赖与偏差放大(模型倾向于生成高频场景, 而对罕见场景表现失真)、算力与成本的不可持续等问题仍有待研究和探索.

2.1.2 3D内容生成

近年来, 随着深度学习和大规模数据集的飞速发展, 3D内容生成技术取得显著突破.生成对抗网络(Generative Adversarial Networks, GAN)[61]、变分自编码器(Variational Autoencoder, VAE)[62]等模型能从海量数据中学习并生成新的3D内容, 广泛应用于3D模型生成、纹理映射和风格迁移等任务.现阶段的3D内容生成模型已能从文本或图像中生成相应的3D模型, 大幅提升生成效率和多样性, 为3D内容创作开辟新的可能性.

基于文本的3D生成方法是指通过输入文字描述生成对应的3D模型.这种生成方式充分利用语言在人类交流和场景描述中的核心作用.Yu等[63]提出WonderWorld交互式3D场景生成模型, 使用户能根据单个输入图像和指定的文本探索和塑造虚拟环境.Chen等[64]提出3DTopia-XL, 基于高效且富有表现力的3D表示方法PrimX构建的扩散变换器(Diffusion Transformers, DiT), 实现高质量3D资产生成的规模化.

与基于文本的3D生成方法不同, 基于图像的3D生成方法更侧重于利用图像直观描述场景细节和外观的能力[65].Gao等[66]提出Bootstrap 3D, 使用扩散模型引导3D生成, 通过生成伪细节, 有效补偿在3D-GS中观察的伪影.Flash3D[67]在单幅图像上进行场景重建和新视角合成, 具有高度的普适性和高效性.World Labs团队推出3D世界生成模型, 能快速分析二维照片中的内容, 对应构建一个具有深度和立体感的三维场景.

尽管AIGC 3D取得显著进展, 但仍面临物理一致性不足、数据依赖性较高、计算资源消耗较大、动态交互能力有限等诸多难题.首先, 由于现有生成模型主要依赖2D图像监督, 缺乏对3D物理规律的显式建模, 对于复杂内容的生成可能不符合真实物理规律(如材料应力、碰撞响应、流体动力学)[68], 并且由于3D数据获取成本较高, 专业领域(如医疗、工业设计)3D数据稀缺, 导致生成模型在某些场景和长尾领域表现不佳.其次, 3D表示(如点云、体素、网格)的计算复杂度较高, 现有优化方法仍无法完全解决效率问题, 导致计算资源消耗巨大、训练成本高昂、实时交互式3D生成仍难以实现.此外, 现有方法的动态建模能力欠缺、多模态控制与3D语义理解不足也导致动态交互与可编辑性受限、复杂提示的跨模态生成失败等瓶颈.未来, 如何结合物理引擎与生成模型使3D内容具备可交互的物理属性、如何通过自监督学习减少模型对3D标注数据的依赖、如何优化模型架构实现轻量化3D生成与边缘计算、如何实现支持实时交互的动态可编辑生成与多模态控制、如何解决3D生成模型在不同领域和应用中的泛化问题, 都是值得关注的重点研究方向.

2.1.3 虚拟数字人

虚拟数字人(Digital Human)是指通过多种数字智能技术创建的具备人类外观、语言、动作甚至思维能力的虚拟形象.这些数字智能体可在大模型的支持下进行学习、生成和交互, 并根据需求衍生出多种形态的智能体.虚拟数字人根据图形资源的维度分为2D和3D, 其语音和动画生成模块基于文本生成对应的语音和动画, 音视频合成模块将这些内容整合成视频呈现.交互模块通过语音识别用户意图, 决定数字人的后续表现.

虚拟数字人可分为交互型数字人和非交互型数字人.非交互型数字人根据预设文本生成语音和动画, 而交互型数字人分为智能驱动型数字人和真人驱动型数字人.智能驱动型数字人通过AI系统读取外界输入信息, 生成相应的语音和动作进行互动, 这种模型称为TTSA(Text to Speech & Animation).真人驱动型数字人通过真人的表情和动作捕捉与用户实时交互, 展现更真实的互动体验.

目前, 虚拟数字人在游戏、电商、营销、文娱、企业服务等领域应用广泛.例如:虚拟数字人可在电商中替代真人主播进行全天候直播, 解决主播不足和人力成本较高的问题; 在营销中, 品牌常定制虚拟形象或IP; 在金融、政务、文旅等行业, 虚拟数字人可扮演大堂经理、讲解员等角色, 为用户提供个性化服务.然而, 当前技术仍面临动态真实感不足与拟人化交互能力欠缺(如光照适应性较差、表情动作僵硬、语音情感缺失)、实时渲染性能欠缺(高保真与低延迟矛盾)、专业领域知识固化与长尾问题处理僵化等难题, 在渲染技术、认知智能、人机协作方面均有待进一步探索.

AIGC在多个领域表现出颠覆性创新潜力, 从医疗、自动驾驶到内容创作和金融风险管理, 其生成式模型的能力正在推动效率与精准度的全面提升.2024年, AIGC技术迎来全新的应用浪潮, 通过结合多模态感知和复杂数据建模, 进一步突破行业的技术瓶颈, 为实现智能化变革提供有力支持.

AIGC显著提高医学影像的分析及诊断的效率和精确度.2024年, 谷歌DeepMind推出的AlphaFold 3[69], 进一步突破蛋白质结构预测的极限, 为靶点设计和药物筛选奠定坚实基础.生成式人工智能技术在单细胞多组学领域也取得重要进展, scGPT[70]高效整合和建模单细胞多组学数据, 显著提升分析细胞功能和疾病机制的能力.Wiesner等[71]提出神经隐式生成框架, 将细胞形状表示为由神经网络估计的符号距离函数水平集, 并采用全连接神经网络进行隐式建模, 在不同类型细胞上均能生成高度相似的三维动态结构, 可进一步结合图像到图像模型生成相应的显微图像, 为医学图像中的细胞分割与跟踪任务提供高质量的训练样本补充.

AIGC在自动驾驶虚拟场景生成、长尾事件模拟及多模态感知数据增强方面, 为自动驾驶技术的发展提供强大助力.Waymo Research团队发布基于生成式扩散模型的场景合成工具Gen-Drive[72], 能自动生成高度复杂的城市驾驶场景, 包括罕见的交通事故等驾驶状况, 为自动驾驶系统的鲁棒性测试提供高效手段.AccidentGPT[73]结合生成式AI技术, 每秒能生成超过1 000种的复杂交通事故模拟场景并提供实时事故预测, 车辆平均反应时间为0.2 s, 远低于人类驾驶员的1.5 s, 有效减少事故发生率, 大幅提升道路安全.

AIGC为内容创作、虚拟场景生成和个性化用户体验提供革命性的解决方案.Meta推出Avatar-Gen[74], 基于生成对抗网络, 融合语音、表情和动作数据, 自动生成与用户语音情感匹配的虚拟人表情与动作, 实现高逼真度的虚拟人图像生成与实时动画控制.华尔街数据实验室推出Market-GAN[75], 通过生成式对抗网络学习市场历史数据分布, 能模拟极端市场环境并预测潜在风险事件.

自2023年以AutoGPT为代表的技术框架发布以来, AI Agent凭借自主性和问题解决能力迅速引发关注.2024年, AI Agent迎来里程碑式的发展, 这些智能体不仅能理解和生成自然语言, 还表现出初步的推理能力和创造性思维.多模态技术的融合进一步扩展其能力边界, 使现代AI Agent能同时处理文本、语音、图像等多种信息形式, 为人机交互带来全新体验.AI Agent正以其自主决策和个性化服务能力, 成为推动智能化变革的重要力量.技术的突破不仅改变AI Agent的功能边界, 也重新定义其在实际应用中的角色.2024年发布的典型Agent框架如图7所示.如下3个方面的创新点尤其值得关注.

1)认知与自主性的飞跃.以GPT-4V[76]为代表的多模态大语言模型推动AI Agent认知能力的飞跃.这些模型具备复杂场景理解、任务规划和上下文推理的能力, 能根据视觉、文本等多模态输入, 独立制定高效的任务执行计划.与此同时, 自主决策能力也实现质的提升.Reflect-RL[77]等方法的提出使AI Agent 在无需大量监督数据的情况下, 通过两个语言模型之间的对话式交互, 自主获取任务反馈并持续优化行为策略, 表现出更强的任务理解、分解与执行能力.同时, 该机制赋予 Agent 初步的“ 反思” 能力, 动态调整决策路径, 在多轮任务执行中显著提升智能水平与完成效率.

2)工具与环境的适应性增强.现代AI Agent在工具使用和环境适应能力方面取得重要突破.一些先进Agent不再局限于调用固定的API, 通过观察学习已能掌握新的软件工具和界面操作, 这种能力大幅拓展它们的应用范围.此外, 这些Agent还能根据实时环境反馈调整操作策略, 更好地适应复杂动态的使用场景.

3)协作模式的多样化进展.多Agent协作成为2024年的技术热点.通过优化通信协议和任务分配机制, 多个AI Agent之间的协调能力显著增强.在复杂场景中, 它们能通过高效分工协作共同完成任务, 如物流规划中的路径优化和资源分配, 效率已能达到甚至超越人类团队.这种高效的协作模式为解决大规模复杂问题开辟新的可能性.

Agent技术根据执行体数量的不同, 可划分为单智能体(Single-Agent)和多智能体(Multi-Agents), 两者各有侧重, 适用于不同的应用场景和技术需求, 本节将分别针对这两类介绍2024年Agent技术.

单智能体(Single-Agent)聚焦于单一智能体的自主性和智能化水平提升, 通过增强其感知、推理、决策和执行能力, 为用户提供高度个性化的服务.这类技术通常应用于个体任务解决或需要高精度响应的场景, 如虚拟助手、嵌入式AI设备等, 强调智能体与用户的交互深度和独立任务处理能力.

2024年, Reflect-RL[77]迎来突破性进展, 设计基于语言反馈机制的自我强化范式, 集成两个语言模型, 在无需权重微调的前提下, 实现对任务过程的即时反思与策略优化.在单智能体决策系统中, Reflect-RL表现出卓越的泛化性与自适应性, 能自主总结经验、修正错误, 为复杂任务的持续执行提供强大的认知支持与行为指导.

HuggingGPT[78]在人工智能领域取得显著进展, 结合ChatGPT和Hugging Face平台专家模型的框架, 解决更复杂的AI任务.这一框架利用大型语言模型的强大能力, 特别是ChatGPT的语言处理能力, 以及Hugging Face平台上的多样化AI模型资源.其核心创新在于工作流程, 分为四个阶段:任务规划、模型选择、任务执行和响应生成.

Samantha[79]是由神经元智能科技有限公司开发的AI Agent, 核心技术体现在结合先进对话式AI技术和深度学习算法, 能精确理解用户需求并在复杂情境中展现同理心和理解能力, 从而在智能客服领域表现出创新性和领导力.该智能体利用Open- VINO[80]工具包进行优化, 在AI推理计算性能上得到显著提升.此外, Samantha采用混合专家模型(Mix- ture of Experts, MoE)技术, 整合不同领域的专家知识, 形成一个“ 超级大脑” , 大幅增强跨领域知识处理能力和问题解决效率.

目前单智能体技术在复杂任务上的处理能力仍有限(如长序列推理困难、多目标协调不足), 同时存在环境适应性与泛化瓶颈及计算与资源效率问题.如何权衡“ 深度专业化” 与“ 通用灵活性” , 在算法轻量化、跨模态交互、复杂环境与任务泛化上持续突破, 是未来值得关注的研究方向.

多智能体(Multi-Agents)致力于多个智能体之间的协同与任务编排, 通过分工合作实现复杂任务的高效执行.这种技术适用于需要大规模任务分解和资源调度的场景, 特别是在企业级应用和跨平台系统中表现突出.通过智能体之间的协作与信息共享, Multi-Agents可应对单一智能体无法胜任的复杂系统需求, 提供全局化和生态化的智能解决方案.

MetaGPT(Model Exclusive Task Arithmetic for Mer-ging GPT-Scale Models)[81]是一种创新的元编程框架, 将高效的人类工作流程作为一种元编程方法引入基于大语言模型的多智能体协作中, 从而解决复杂多智能体协作的问题.通过将标准化操作程序编码为提示内容序列, 允许具有类似人类领域专业知识的代理验证中间结果并减少错误, 这种方法在软件开发中尤为有效, 能分解任务、明确角色和使用SOP, 实现软件开发中的高效协作.MAGIS(LLM-Based Multi-agent Framework for GitHub Issue Resolution)[82]针对GitHub Issue存储库中的问题, 引入4种协作LLM智能体(Manager、Repository Custodian、Developer、Quality Assurance Engineer), 通过角色分工与协作交互, 将复杂repo级问题拆解并高效解决.在 SWEbench 基准测试中, 相比GPT-4, MAGIS解决率提升至8倍, 展现出强大的多智能体协同能力, 可处理GitHub中代码维护与项目管理的问题.

TaskWeaver[83]是由微软推出的代码优先Agent框架, 在多智能体领域实现革命性的突破, 通过将用户请求转化为可执行代码, 并采用用户定义的插件作为可调用函数, 大幅提升多智能体系统处理复杂任务的能力.TaskWeaver支持丰富的数据结构和灵活的插件使用, 结合动态插件选择和LLM编码能力, 有效处理复杂逻辑, 同时, 通过示例融入领域特定知识, 确保代码的安全执行.

2024年, AI Agent技术迎来重大飞跃, 成为推动智能化变革的重要力量.从单一智能体的自主性提升到多智能体协作的高效执行, AI Agent在认知、决策、环境适应和任务协同等方面取得突破.随着多模态技术的融合, 这些智能体在处理复杂任务、增强用户体验、提升生产力方面表现出巨大的潜力.无论是在个人助手、企业级应用, 还是在多智能体协作系统中, AI Agent的应用前景都愈加广阔.然而, 在多智能体协作效率与突发需求动态响应、系统可靠性评估与错误回溯(失败归因)、多智能体对抗性风险及隐私泄露等方面仍需进一步探索.

在当今数字化浪潮的席卷之下, Agent 作为人工智能领域的关键力量, 正以前所未有的速度渗透至各个垂直领域, 成为推动行业创新与变革的核心引擎.2024年, 交通物流、医疗、教育、消费等诸多领域更是凭借 Agent 应用的深度赋能, 形成新质生产力, 显著提升生产效率、优化服务质量, 开启智能化发展的新纪元.

2024年9月, 京东物流发布搭载感知大模型的物流无人车技术, 其第六代智能配送车将规模化布局, 采用 “ 轻地图” 技术路线, 可提高无人车适应性与灵活性, 降低运营成本, 提升物流效率.运满满将 AI 定价模型应用于拼车功能, 基于配载模型和顺路制度计算, 为司机提供精准拼货算法匹配, 优化运输资源配置.

由紫荆智康开发的 “ 紫荆 AI 医生” 系统上线内测, 首批来自21个科室的42位AI医生可对多种疾病进行诊断, 覆盖发病到康复全流程, 能依据最新权威资料提供诊疗方案, 且AI医生能力可迭代进化, 加速推动医疗服务智能[84].2024年10月, 北京发布《北京市教育领域人工智能应用指南(2024年)》[85], 明确以 “ 智” 助教、助学、助评、助育、助研、助管六大重点应用领域, 引导和规范教育领域 AI 应用[86].蚂蚁云科技集团发布以正教育大模型, 其多个 Agent 可用于教案生成、个性化教学支持和学生学习辅导, 提升教育教学智能化水平.处于测试阶段的猿编程 AI Agent 凭借其智能编程指导、评估及场景模拟等功能优势, 为编程教育带来创新与变革.

Anthropic公司于2024年10月发布的Claude 3.5模型[87]加入“ Computer Use” 功能, 使智能体能模拟人类的计算机操作, 如光标移动、按钮点击和文本输入等, 从而辅助有需要的用户使用计算机.华为在AI手机操作领域推出名为LiMAC(Lightweight Multi-modal App Control)[88]的Agent, 旨在让AI能像人类一样直接在手机上进行各种操作, 加快产品升级.微盟集团实现多个Agent在部分环节自闭环, 并深化单个场景能力, 能理解运营者需求并帮助落地, 凭借自身业务优势及AI大模型主力构建全产业链短剧生态, 助力企业迎来智能化转型新机遇.

2024 年各垂直领域借助Agent应用取得的丰硕成果, 正在深刻改变人们的生产、生活方式, 未来随着技术的不断迭代升级, 其应用潜力将得到进一步释放.

人工智能驱动的科学研究(AI for Science, AI4S)通过融合机器学习、深度学习和大模型等技术, 为科学家提供解决复杂问题的新方法, 不仅提升研究效率, 还加速科学规律的发现与跨学科创新的推进.这种方法正在重新定义传统科学研究模式, 加快科研进程, 特别是大语言模型的快速发展, 推动科学研究格局的深刻变革[89].近年来, AI4S在生物医学、化学、材料科学、数学和天文学等领域取得显著突破.2024年诺贝尔物理学奖表彰深度学习相关研究, 诺贝尔化学奖部分授予计算蛋白质设计研究方向, 进一步凸显AI4S的重要性[90].同时, AI4S正在助力产业智能化和新型生产力的可持续发展.然而, 在发展过程中, AI4S也面临技术、伦理与生态等多方面的挑战, 人工智能相关科学研究(Science for AI, S4AI)的深入探索将成为解决这些问题、推动AI4S健康发展的关键.本节总结AI4S的典型成果, 并结合S4AI的理念探讨相关问题[91].

人工智能在生物医药领域的创新应用正持续推动该领域的快速发展, 从分子机制解析到药物研发, 均表现出强大的潜力和深远的影响.谷歌DeepMind推出AlphaFold 3[69], 进一步突破蛋白质结构预测的极限, 不仅能精确预测单个蛋白质的三维结构, 还能揭示生物分子之间的相互作用, 为靶点设计和药物筛选奠定坚实基础.生成式人工智能技术也在单细胞多组学领域取得重要进展, scGPT[70]通过高效整合和建模单细胞多组学数据, 显著提升解析细胞功能和疾病机制的能力.在小分子药物研发方面, Durant等[92]提出未来以数据驱动的小分子药物发现框架, 通过高质量数据和深度学习技术优化药物筛选与设计流程.Wiesner等[71]构建基于神经隐式表示的细胞形态生成框架, 利用符号距离函数对细胞三维结构进行建模, 准确再现细胞在时空维度中的拓扑变化与复杂形变, 可合成高仿真细胞图像.Act-Found[93]结合元学习和成对学习, 解决生物活性预测中存在的化合物数量有限及标准不一致等样本问题.Prompt-MolOpt[94]基于多图注意力神经网络构建多任务属性预测模型, 利用提示学习的训练策略, 提高分子优化的成功率, 并保证药效的完整性.

尽管这些成果性能显著, AI在生物医药领域的应用仍面临一些问题与挑战.例如:模型对高质量、全面且均衡的生物数据依赖性较高, 但数据的获取和共享往往受到伦理、安全和隐私问题的限制; 模型解释充分性和预测结果的生物学可信度也需进一步提升.此外, 如何解决跨学科协作的壁垒及优化技术落地的成本与效率问题, 仍是实现AI驱动生物医药创新可持续发展的关键.

AI在材料化学领域的应用正快速推进, 为新材料的发现与优化提供革命性工具.从科学仿真、模型预测到高通量实验和自动化表征, AI显著降低新材料研发的成本并提高效率.在金属-有机框架(Me-tal-Organic Frameworks, MOFs)领域, Uni-MOF[95]基于生成式分子扩散模型, 使用收集的大规模MOF数据和共价有机框架结构中学习的纯三维表示, 进行多用途气体预测.GHP-MOFassemble[96]结合生成式人工智能, 寻找MOFs中性能最好的材料, 通过分解、生成和预测等步骤, 验证MOFs材料的唯一性、合成性、结构有效性.Wang等[97]提出基于深度学习的普适材料模型, 通过Transformer架构逼近密度泛函理论哈密顿量, 有助于解决不同元素组成和不同材料结构相关的训练任务的复杂性问题.在光学材料设计中, GNNOpt[98]设计等变图神经网络结构, 自动优化网络参数, 使用少量数据实现高质量的光学预测, 大幅提升从晶体结构中预测光学特性的研发效率.在催化剂吸附强度研究中, Li等[99]基于自动机器学习进行特征删除实验, 并且结合实例变量选择成功解析化学吸附强度, 为催化反应路径的优化和高效催化剂设计提供新思路.在材料生成方法上, FlowLLM[100]结合大语言模型和流匹配算法, 设计新的晶体材料, 实现对复杂材料的高效生成与筛选, 提升稳定材料生成的效率.

然而, AI在材料科学中的应用仍面临诸多挑战.一方面, 高质量、全面的数据仍是AI模型性能提升的关键, 但目前材料数据的多样性与质量参差不齐, 限制模型的泛化能力.另一方面, 对于复杂材料体系的模拟和预测, 现有算法对计算资源的依赖性较高, 模型的结果往往缺乏可解释性.为了解决这些问题, 推动跨学科的协作和数据共享、标准化显得尤为重要.同时, 提升模型的可解释性、增强实验验证能力, 构建完善的AI驱动材料研发闭环, 将是加速材料化学智能化发展的关键.通过强化S4AI的理论与实践融合, 可实现AI技术与材料化学的深度协同创新, 从而为材料科学的未来发展注入新的动力.

S4AI旨在解决人工智能的伦理与治理问题, 提升人工智能的安全性与可解释性.同时, 伴随着生成式大模型和扩散模型等技术在AI4S领域的广泛应用, 高效计算也是S4AI需要解决的关键问题之一.领存实验室在MRD(Maximum Rank Distance)[101]领域取得重大突破, 构建高可靠、高宽带、低延迟的网络环境, 实现在极低算力条件下的微秒级编解码性能, 从而满足AI训练过程中数据的高效传输和存储需求.同时, 通过在发送端添加冗余数据并在接收端检测和修正, 可加密数据并纠正错误, 提升AI系统的安全性和可靠性, 提升AI在生物医药等领域对于隐私数据的保护能力.为了克服集成光子电路的容量和可扩展性受到的误差限制, 进一步提升芯片计算性能, 清华大学研制基于集成衍射干涉混合设计和通用分布式计算架构的大规模光子小型芯片, 命名为太极[102].该架构使用光处理数据, 具有亿级神经元的计算能力, 为AI提供新的计算平台.此外, 清华大学研制首个类脑互补视觉芯片天眸芯[103], 采用基于视觉原语的互补双通路设计, 包含混合像素阵列和并行异构读取架构, 可高效率、高精度地采集高动态范围内的视觉信息, 提升对恶劣天气等极端场景及高动态场景的适应能力.S4AI可满足AI发展过程中对于数据安全、高算力的要求, 成为进一步推动AI4S发展的基础科学研究, 帮助AI4S形成统一框架, 应对AI4S面临的专业数据稀缺、专业领域差异较大、缺乏标准化等挑战.

在全球人工智能技术快速发展的背景下, 中国在人工智能产业的标准化建设、应用拓展及技术落地方面取得显著进展.为了推动产业健康发展和技术创新, 国家通过加速建立标准体系、深化人工智能与各行各业的融合、不断优化政策环境, 为中国人工智能产业的发展提供坚实的基础.2024年, 相关部门发布一系列标准化建设指南和政策文件, 旨在提升技术创新能力, 推动产业升级, 同时加快人工智能技术在经济社会中的应用和落地.

1)加速构建人工智能产业标准体系, 推动行业规范化发展.2024年7月, 我国四部门联合发布《国家人工智能产业综合标准化体系建设指南(2024版)》, 规划到2026年制定超过50项国家和行业标准以促进高质量发展.此外, 工信部发布《国家智能制造标准体系建设指南(2024版)》征求意见稿, 提出到2024年将修订或制定100项以上的标准, 以适应新型工业化需求[104].同样, 《轻工业数字化转型实施方案(征求意见稿)》和其它相关政策的发布为具身智能行业的创新发展创造良好的政策环境[105].

2)拓宽人工智能应用领域, 促进技术与经济社会深度融合发展.我国在人工智能体系和基础设施布局上取得进展.北京人形机器人创新中心推出全球首个全尺寸电驱动人形机器人“ 天工” , 并加速推进各地人形机器人创新中心的建设.11月, 具身智能机器人创新中心启动“ 天工开源计划” , 推动人形机器人走进日常生活.与此同时, 低空经济发展迅速, 深圳北站启动首个“ 低空+轨道” 空铁联运项目, 5G-A技术助力低空应用场景的实现, 并推动无人机在多个领域的应用[106].

3)系统推进人工智能应用实施, 确保技术落地与实效转化.在公共服务领域, 中国气象局发布《人工智能气象应用实施方案》, 重点推动气象预报大模型研发, 为人工智能在信息领域的应用奠定基础[107] .在智能基建方面, 中国电信成立TeleAI, 建设全球首个5G SA网络; 中国移动构建超大规模智算中心; 中国联通发布“ 元景” 大模型2.0[108] .在智能医疗领域, 微软亚洲研究院与上海市精神卫生中心合作开发“ 忆我” 个性化认知训练框架, 为认知障碍的预防提供新的技术手段.同时, 国内外的大型通用和行业大模型在自然语言处理、企业服务等领域取得显著成效, 如百度的文心一言、腾讯的混元、阿里云的通义千问、容联云的赤兔大模型等, 都在推动行业创新发展.

4)加强人工智能国际合作治理, 推动技术普惠与可持续发展.第78届联合国大会通过加强人工智能能力建设国际合作决议, 倡导以人为本、智能向善, 推动人工智能包容性与可持续发展, 助力实现联合国2030年目标.作为主提国, 中国积极引领全球治理合作, 与各国携手推进人工智能技术健康发展.

2024年, 中国在人工智能领域加速建立标准化体系, 为技术研发和应用提供明确的规范, 有效提升行业技术水平和产品质量, 同时通过参与国际标准制定, 加强产业的全球竞争力.我国不断拓展人工智能的应用领域, 将技术创新与经济社会深度融合, 为经济结构调整和产业升级提供强大动力.通过系统推动人工智能技术落地, 人工智能已成为推动中国经济社会发展的新引擎, 助力我国建设创新型国家和科技强国.

本文回顾2024年人工智能科学热点及主要进展, 包括大模型与具身智能、AIGC、AI智能体、AI4S与S4AI等方面的研究进展及行业应用, 并阐述2024年我国在人工智能产业的标准化建设、应用拓展、技术落地方面推出的相关政策与平台.在大模型方面结合循环神经网络、状态空间序列模型、液体神经网络等思想, 涌现出一系列优化架构, 以o1、o3为代表的推理模型范式证明Scaling Law仍有巨大潜力.具身大模型通过统一的多模态架构, 显著提升机器人感知、交互、推理与操作能力, 推动机器人技术在多个行业的应用深化.Sora的热度激发自动驾驶与机器人领域对世界模型的探索及影视媒体等领域的可落地AIGC应用.基于多模态大语言模型的智能体框架展示的自主决策和认知推理能力提升, 使Al智能体在专业领域的应用取得突破性进展, 从单纯的工具转变为能真正理解和适应复杂环境的智能助手.AI4S正在重新定义传统科学研究模式, 在生物医学、化学、材料科学、数学和天文学等领域推动科学研究格局的深刻变革, 然而, AI4S也面临计算技术、伦理与生态等多方面的挑战, S4AI将成为解决这些问题、推动AI4S健康发展的关键.伴随着日新月异的人工智能技术迭代, 相关部门发布一系列标准化建设指南和政策文件, 助力产业智能化升级和新质生产力的可持续发展.在此形势下, 中国的AI科技及产业大有可为, 将产生更多跨越和开创性的里程碑工作.

本文责任编委 张军平

Recommended by Associate Editor ZHANG Junping

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|

| [36] |

|

| [37] |

|

| [38] |

|

| [39] |

|

| [40] |

|

| [41] |

|

| [42] |

|

| [43] |

|

| [44] |

|

| [45] |

|

| [46] |

|

| [47] |

|

| [48] |

|

| [49] |

|

| [50] |

|

| [51] |

|

| [52] |

|

| [53] |

|

| [54] |

|

| [55] |

|

| [56] |

|

| [57] |

|

| [58] |

|

| [59] |

|

| [60] |

|

| [61] |

|

| [62] |

|

| [63] |

|

| [64] |

|

| [65] |

|

| [66] |

|

| [67] |

|

| [68] |

|

| [69] |

|

| [70] |

|

| [71] |

|

| [72] |

|

| [73] |

|

| [74] |

|

| [75] |

|

| [76] |

|

| [77] |

|

| [78] |

|

| [79] |

|

| [80] |

|

| [81] |

|

| [82] |

|

| [83] |

|

| [84] |

|

| [85] |

|

| [86] |

|

| [87] |

|

| [88] |

|

| [89] |

|

| [90] |

|

| [91] |

|

| [92] |

|

| [93] |

|

| [94] |

|

| [95] |

|

| [96] |

|

| [97] |

|

| [98] |

|

| [99] |

|

| [100] |

|

| [101] |

|

| [102] |

|

| [103] |

|

| [104] |

|

| [105] |

|

| [106] |

|

| [107] |

|

| [108] |

|