吕 娟,博士,副教授,主要研究方向为机器学习、深度学习.E-mail:lvjuan@tust.edu.cn.

作者简介:

孙 林,博士,教授,主要研究方向为粒计算、图机器学习、数据挖掘.E-mail:sunlin@tust.edu.cn.

薛红科,硕士研究生,主要研究方向为机器学习、深度学习.E-mail:823849734@qq.com.

皮肤病变的准确分割对诊断和治疗皮肤病至关重要.针对现有网络因皮肤病变形态多样、与周围组织相似性较高及边界模糊导致的分割结果不精准的问题,文中提出基于动态代理瓶颈与多尺度空洞注意力的Swin Transformer皮肤病分割网络.首先,针对普通卷积对全局信息捕捉能力不足的问题,构建基于Swin Transformer V2的骨干网络,通过分层结构设计和自注意力机制,实现多尺度特征融合,建立特征的长距离依赖关系,增强多形态下皮肤病变的语义特征提取能力.然后,为了增强网络的特征表达能力,设计动态代理瓶颈模块,根据输入特征自适应生成代理向量与位置偏置,自适应调整局部感受野的关注焦点,进一步解决现有网络在高相似度皮肤组织干扰下皮肤病变分割偏差的问题.最后,为了提高对皮肤病变边缘的感知能力,设计多尺度空洞注意力融合模块,构建基于多分支并行的多尺度空洞卷积特征提取架构,结合空间通道注意力机制,提升对病变边缘的敏感性.文中网络在ISIC2017、PH2、ISIC2018数据集上的实验均取得较优性能,由此验证其有效性.

LÜ Juan, Ph.D., associate professor. Her research interests include machine learning and deep learning.

About Author:

SUN Lin, Ph.D., professor. His research interests include granular computing, graph machine learning and data mining.

XUE Hongke, Master student. His research interests include machine learning and deep learning.

Accurate segmentation of skin lesion areas is critical for the diagnosis and treatment of dermatological diseases. To address the challenges posed by diverse lesion morphologies, high similarity between lesions and surrounding tissues, and blurred boundaries in existing networks, a Swin Transformer-based skin disease segmentation network via dynamic agent bottleneck and multi-scale dilated attention(STNDA) is proposed. First, a Swin Transformer-based backbone network is constructed to overcome the limitations of traditional convolutions in capturing global context. By leveraging the hierarchical architecture of the network, multi-scale feature fusion is achieved, and long-range dependencies are established to enhance the network ability to extract semantic features from skin lesions with varying morphologies. Second, to improve the feature expression ability of STNDA, a dynamic agent bottleneck module is designed. The module adaptively generates agent vectors and positional biases based on input features, allowing the network to dynamically adjust its focus on local receptive fields. Thus, the segmentation errors caused by the interference from highly similar skin tissues are further mitigated. Finally, a multi-scale dilated attention fusion module is proposed to enhance edge perception ability of the network. A multi-branch parallel architecture with multi-scale dilated convolutions is designed by integrating with spatial-channel attention mechanisms to improve the network sensitivity to lesion boundaries. Experiments on ISIC2017, PH2 and ISIC2018 datasets demonstrate STNDA achieves superior performance, thereby confirming its effectiveness.

皮肤癌的早期筛查对患者的生存具有极大影响, 在众多皮肤癌类型中, 黑色素瘤是最危险的一种皮肤癌, 五年存活率很低.根据美国癌症协会的数据, 恶性黑色素瘤的死亡率高达7.66%, 而患者被诊断为晚期后, 5年生存率将从99%降至25%[1].因此, 早期筛查对于皮肤病患者的生存率至关重要[2].然而, 由于皮肤病变通常边界模糊、对比度较低以及受蓝痣和皮痣等类似恶性黑色素瘤疾病因素的影响, 且在临床中对皮肤病变图像的准确分割受限于医生的临床经验和工作环境, 容易造成漏诊和误诊.因此, 开发针对皮肤病变的自动分割技术尤为重要.

近年来, 随着人工智能在医疗领域的发展, 深度学习技术已成为医疗图像检测和分类的重要工具[3].目前, 卷积神经网络(Convolutional Neural Network, CNN)仍是主流的皮肤病分割方式之一[4].Zhong等[5]提出PMFSNet, 通过皮肤病图像的局部上下文信息自适应分配注意力权重, 聚焦病变区域, 但对不同尺度皮肤病变的分割准确性仍有待提高.Zheng等[6]提出LW-XNet(Legendre Multi-wavelet Transform-Based Fusion XNet), 将图像划分为8个小波系数特征图像并对其进行级联处理, 有效区分和理解皮肤病图像中的复杂特征, 但对皮肤病边缘细节特征提取不充分.Liu等[7]提出Rolling-Unet, 结合皮肤病图像各方向上的远距离依赖性, 获取多个方向上的长距离依赖关系, 可融合局部特征和长程依赖关系, 但对皮肤病早期细节特征提取不充分.Li等[8]提出SMM-UNet, 通过并行视觉Mamba模块的编码层, 在皮肤病分割任务中减少模型参数量和计算复杂度, 但局部特征提取不充分.尽管上述基于CNN的皮肤病图像分割方法已取得一定成效, 但仍在捕获全局和远程语义信息上受限以及存在固有的归纳偏差.

目前, 基于CNN和Transformer结合的方法在皮肤病分割中取得较优效果[9].Liu等[10]将Trans-former与CNN结合用于皮肤病分割任务, 提出CSWin-UNet, 在水平方向和垂直方向并行计算自注意力, 扩大特征提取的感受野, 但对皮肤病变边缘上的分割准确性仍有待提高.Gao等[11]提出CoTrans-UNet, 设计协同Transformer机制和多尺度上下文提取模块, 利用归纳偏差提取图像的局部细粒度特征, 并充分提取不同尺度下的特征信息, 但分割效果受毛发与其它类似疾病的影响.Patil等[12]设计PISA(Permutation Invariant Self-Attention Module), 消除特征空间中输入元素的顺序依赖, 提升对不同形态皮肤病变的分割能力, 但训练时间较长, 对计算资源需求相对较高.Wu等[13]提出H-Vmunet(High-Order Vision Mamba UNet), 将高阶空间交互机制引入U-Net架构, 用于皮肤病变分割任务, 可提升分割精度, 但泛化能力不足.Wu等[14]提出MHorUNet, 通过递归门控卷积捕捉皮肤病图像相邻像素之间的高阶空间交互关系, 提升复杂病变的识别能力, 保留皮肤病变的边界细节, 但泛化性不足.Chen等[15]提出TrUNet, 使用由卷积块和Transformer块混合的架构构建编码器, 通过多级Transformer块充分提取皮肤病图像的全局特征, 但容易漏检皮肤病变细节特征.

尽管上述网络能有效提取皮肤病变局部细节特征与不同尺度的特征信息, 但仍存在感受野冲突与注意力分散的问题, Transformer的固定窗口划分会破坏皮肤边缘细节特征的空间连续性, 导致皮肤病变边缘轮廓分割模糊.为此, 学者们改进网络瓶颈模块与跳跃连接模块, 提升皮肤病分割的性能.Shu等[16]提出CSCA U-Net, 在瓶颈处引入通道和空间复合注意力机制, 并行处理通道信息和空间维度信息, 动态聚焦皮肤病图像中的关键特征, 但仍存在皮肤病变边界分割不准确的问题.Cai等[17]提出BVI-Net(Ultra-Lightweight Network Inspired by Bio-visual Interaction), 在跳跃连接处结合图卷积网络注意力机制, 提取不同尺度的病变特征, 但分割准确性受皮肤病变与周围组织相似性高的影响.Balraj等[18]提出MADR-Net(Multi-level Attention Dilated Residual Neural Network), 在网络瓶颈处引入空洞空间金字塔池化模块, 通过不同扩张率的空洞卷积并行提取多尺度特征, 可同时捕捉皮肤病变的全局结构和局部细节, 但在瓶颈处加权平均的融合策略无法充分捕捉病变边缘细节特征.王斯豪等[19]提出基于双路径注意力机制和多尺度信息融合的皮肤病人工分割网络, 在网络瓶颈处设计多尺度上下文关系提取模块, 采用水平平均池化及垂直平均池化建模上下文信息, 但皮肤病变边缘细节分割准确率有待提高.卢力玮等[20]提出基于多尺度通道融合注意力机制的U-Net分割网络, 但对皮肤病变定位有一定偏差.

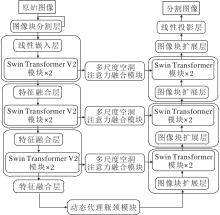

为了解决上述问题, 本文提出基于动态代理瓶颈与多尺度空洞注意力的Swin Transformer皮肤病分割网络(Swin Transformer-Based Skin Disease Segmentation Network via Dynamic Agent Bottleneck and Multi-scale Dilated Attention, STNDA).由于普通卷积的全局信息捕捉能力不足, 以U-Net为基础, 构建基于Swin Transformer V2[21]的骨干网络, 通过多阶段架构、模块堆叠操作和多尺度特征融合, 增强网络在多形态下皮肤病特征的提取能力.为了解决网络在皮肤病变与周围组织高相似度影响下的分割偏差问题, 在网络瓶颈处设计动态代理瓶颈(Dynamic Agent Bottleneck, DAB)模块, 由动态代理生成(Dynamic Agent Generation, DAG)模块根据输入特征的复杂程度自适应生成代理向量与位置偏置, 并调整局部感受野的焦点, 提升在复杂皮肤背景下的病变分割精度.为了增强对皮肤病边缘细节的感知能力, 在跳跃连接上设计多尺度空洞注意力(Multi-scale Dilated Attention, MSDA)融合模块, 采用多分支并行的多尺度特征提取架构, 捕捉图像的多尺度信息, 提取关键性的上下文信息, 增强网络对边缘的感知能力, 提升分割准确性.

由于皮肤病变形态复杂多样, 大小从微小色素点到弥漫性斑块不等, 与周围正常皮肤在颜色、纹理上相似度较高, 且皮肤病变区域与正常皮肤之间过渡较平缓, 缺乏清晰的边界界定, 导致现有网络提取病变特征不充分、分割结果不精准[22].为此, 本文提出基于动态代理瓶颈与多尺度空洞注意力的Swin Transformer皮肤病分割网络(STNDA), 总体网络结构如图1所示.

首先, 构建基于Swin Transformer V2[21]的骨干网络, 编码器中加入动态位置偏置生成模块与多头自注意力前置(Shifted Window Multi-head Self-Attention, SW-MSA)的Swin Transformer V2模块, 解码器中引入窗口多头自注意力 (Window Multi-head Self-Attention, W-MSA) 与窗口偏移多头自注意力结合的Swin Transformer[23]模块, 通过窗口自注意力机制提高网络对皮肤病变特征的提取能力, 同时增强对多形态皮肤病变的语义特征提取能力.然后, 设计动态代理瓶颈(DAB)模块, 根据输入特征的复杂程度自适应生成代理向量a, 可聚合所有键矩阵和值矩阵的信息, 生成全局特征向量, 从而提取皮肤病图像全局上下文信息, 避免因皮肤病变与周围组织相似性较高导致的皮肤病变分割偏差.最后, 在跳跃连接处设计多尺度空洞注意力(MSDA) 融合模块, 运用多分支并行架构提取皮肤病变多尺度特征, 捕捉关键上下文信息并增强对边缘的感知能力.

皮肤病具有复杂多样的形态特点, 且病变区域会向周围正常皮肤扩散和浸润, 使病变边界模糊不清, 与正常皮肤难以区分, 导致传统分割网络分割精度受限.U-Net因其对称的编码器-解码器结构、跳跃连接及对多尺度特征的融合能力, 在皮肤病分割任务中表现出强大的适应性.在基于U-Net的改进网络中, 直接引入Swin Transformer中网络的深度和跨层连接, 信息在编码器和解码器之间传递不足, 特别是对于皮肤病变图像等复杂场景, 更容易出现信息丢失及网络不断下采样造成上下文信息联系匮乏等问题[24].

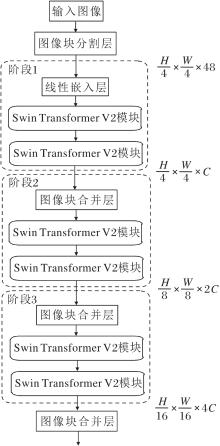

针对普通卷积全局信息捕捉能力不足、Swin Transformer归一化层前置, 直接优化位置偏置矩阵, 导致深层激活值差异过大, 在皮肤病分割时分割效果不稳定, 对皮肤病边缘细节的分割准确率较低.本文在编码器模块中采用Swin Transformer V2模块, 通过多阶段架构与模块堆叠操作, 避免传统Swin Transformer的4阶段架构与6个连续堆叠块因使网络过深导致的特征提取不充分的问题.因此, 本节构建编码器模块与解码器模块作为STNDA的主干网络, 其中基于Swin Transformer V2的编码器模块结构如图2所示.

如图2所示, 编码器模块的阶段1包含一个线性嵌入层与两个连续堆叠的Swin Transformer V2模块, 阶段2和阶段3包含一个进行下采样操作的图像块合并层与两个连续堆叠的Swin Transformer V2模块.在阶段1前存在一个图像块分割层, 图像块分割操作将输入图像分割成多个不重叠的小块(Patch).线性嵌入是线性变换操作.图2中使用4× 4的块大小, 因此每块的特征维数为4× 4× 3=48, 输入图像经过图像块分割操作, 再经过线性变化操作进行特征映射.将特征映射后的图像输入具有自注意力计算功能的Swin Transformer V2模块.阶段2和阶段3在输入Swin Transformer V2模块前需要通过图像块合并层进行下采样操作, 产生分层表示.

Swin Transformer V2模块包含两个部分:第一部分由一个窗口多头自注意力、两个归一化层与一个多层感知器组成; 第二部分由一个窗口偏移的多头自注意力、两个归一化层与一个多层感知器组成.

窗口多头自注意力具体公式如下:

$\text { Attention }(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})=\operatorname{softmax}\left(\frac{\boldsymbol{Q} \boldsymbol{K}^{\mathrm{T}}}{\sqrt{d}}\right) \boldsymbol{V} \text {, }$

其中, Q表示查询矩阵, K表示键矩阵, V表示值矩阵, softmax(·)表示归一化操作, d表示矩阵维度.

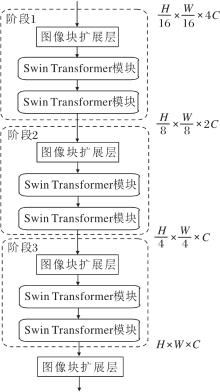

Yi等[25]指出:由于解码器主要关注空间位置重建, 而非复杂的特征交互, Swin Transformer V2模块参数冗余会导致网络在测试集上泛化能力下降.为此, 本节构建解码器模块作为STNDA的解码器, 基于Swin Transformer的解码器模块结构如图3所示.

由图3可知, 解码器与编码器对应, 包含3个上采样阶段, 每个阶段包含一个图像块扩展层与两个连续堆叠的Swin Transformer模块.图像块扩展层为上采样操作, 实现特征图的空间上采样, 将分辨率调整为原来的2倍, 通道数降为原来的1/2.在阶段1后将特征图由

Swin Transformer模块包含两个部分:第一部分由一个窗口多头自注意力、两个归一化层与一个多层感知器组成; 第二部分由一个窗口偏移的多头自注意力、两个归一化层与一个多层感知器组成.

Swin Transformer模块采用归一化层前置与直接优化位置偏置矩阵, 则Swin Transformer模块的窗口多头自注意力公式如下:

$\text { Attention }(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})=\operatorname{softmax}\left(\frac{\boldsymbol{Q} \boldsymbol{K}^{\mathrm{T}}}{\sqrt{d}}+\boldsymbol{B}\right) \boldsymbol{V} \text {, }$

其中B表示相对位置偏置矩阵.

在皮肤病分割中, 低层次特征包含丰富的边缘、纹理等细节信息, 对目标位置的描述精确, 但语义信息较少[26].高层次特征具有较强的语义信息, 但分辨率较低, 几何细节信息表征能力较弱, 目标位置相对粗略.结合不同尺度的特征可增强网络对早期皮肤病变皮损的细微特征提取能力和模糊边界的分割能力, 提升分割精度.但是, 目前网络仍无法充分将两者互补, 导致细节与语义信息不匹配[27].因此, 本节在瓶颈层引入动态代理瓶颈(DAB)模块.DAB模块通过动态代理生成(DAG)模块生成代理向量a, 结合Softmax注意力与Linear注意力, 既保留Softmax注意力的全局感知能力, 又降低整体计算复杂度, 将低层次病理边缘细节特征与高层次位置信息互补, 解决网络在高相似度皮肤组织干扰下皮肤病变分割偏差的问题.DAB模块的具体结构如图4所示.

由图4可知, 在DAB模块中, 首先, 将查询矩阵Q经过DAG模块生成代理向量:

a=Encoder(AdaptivePooling(Q)),

其中, Q表示输入的查询矩阵, Encoder(·)表示编码器.

将a与键矩阵K和值矩阵V进行Softmax注意力计算, 代理向量a聚合所有键矩阵和值矩阵的信息, 生成代理特征:

A=WV,

其中, V表示值矩阵,

W=Softmax((aKT)· scale),

表示注意力权重, K表示键矩阵, scale表示缩放因子.

A具有皮肤病图像全局上下文信息.然后, 将A作为V, a作为K与Q进行二次Softmax注意力计算, 使网络可结合皮肤病局部特征与病变全局信息.二次Softmax注意力计算后的增强特征为:

A* =GA,

其中,

G=Softmax((QaT)· scale),

表示代理权重.

上述基于代理向量进行注意力计算以融合皮肤病变图像局部特征与全局特征时, 需要提取皮肤病变图像的像素或特征点之间的空间关系, 位置偏置将这些空间关系编码到网络中, 增强网络注意力计算.然而, 传统的位置偏置是通过插值从预设的参数中得到, 无法根据输入数据的动态变化进行调整[28].皮肤病变通常边界模糊、对比度较低, 导致网络在皮肤病分割时准确率受限.

为此, 本节提出DAG模块, 使位置偏置具备动态适应能力, 能根据输入特征的复杂程度自适应调整代理标记内容.DAG模块由一个自适应池化层和两个卷积层组成, 结构如图4所示.第1个卷积层为深度可分离卷积层, 在每个输入通道上独立提取特征, 保证特征间的独立性; 第2个卷积层是标准的1× 1卷积, 调整特征维度.批量归一化和ReLU激活函数减少网络对初始化权重和学习率的敏感性, 防止过拟合, 增强网络的泛化能力和非线性表达能力.

CNN的最大池化操作尽管具有平移不变性, 但仍会出现特征图的尺寸逐渐减小的情况[29].空洞卷积可扩大网络感受野, 但相同大小的空洞率会导致特征图出现网格效应[25].由于皮肤病形态多样且边界模糊, 若其皮肤病变边缘经过多次缩小会导致边缘细节丢失, 很难准确分割.卷积块注意力模块(Convolutional Block Attention Module, CBAM)通过融合通道注意力与空间注意力, 可聚焦病变边缘模糊区域, 采用不同扩张率的空洞卷积与CBAM融合, 可解决特征图出现的网格效应的问题, 增强对病变边缘的感知能力.因此, 本文设计将不同扩张率的空洞卷积与CBAM融合的多分支并行的多尺度空洞注意力(MSDA)融合模块, 具体结构如图6所示.

在MSDA融合模块中, 输入特征经过3× 3卷积层后分为3个分支, 3个分支通过感受野的阶梯式扩大, 实现多尺度特征提取.第1个分支经过扩张率为1的3× 3卷积, 将输入特征的通道数降至1/4.第2个分支由扩张率分别为1和2的3× 3卷积串联而成, 同样将输入特征的通道数降至1/4.第3个分支由扩张率分别为1、2和4的3× 3卷积层串联而成, 将输入特征的通道数降至原始通道数的1/2.通过分支内扩张率不同的卷积串联和分支间特征互补, 实现多层次特征提取, 从低级到高级逐步提取语义信息.这3个分支都经过CBAM模块进行通道注意力和空间注意力加权, 增强皮肤病变特征的表达能力, 减少边界模糊的干扰.同时, 这3个分支的输出与经过1× 1卷积的残差连接进行拼接, 保留原始特征的信息.

MSDA融合模块使网络可以扩大感受野并捕获多尺度特征, 在皮肤病分割时充分提取病变边缘细节特征和病变全局特征, 避免分割边界模糊、不同病变大小及形态差异的影响.

空洞卷积通过在卷积核中插入空洞以扩大感受野, 然而, 当网络中连续使用相同大小的扩张率时, 会破坏特征图的空间连续性.因此, 本节采用1、2和4的梯度扩张率构建空洞卷积, 扩张卷积核和感受野的大小.扩张后卷积核大小为:

R=k+(k-1)(t-1),

其中, k表示卷积核大小, t表示扩张率.扩张卷积后第m层感受野大小为:

Dm=Dm-1+[(R-1)

其中,

MSDA融合模块旨在通过融合不同感受野下的特征图信息, 增强网络的表征能力.假设模块的输入特征图x∈ RH× W× C, 输出特征图y∈ RH× W× C, x1、x2、x3分别表示3条分支路径通过CBAM模块之前的特征图, gn(·)表示扩张率为n的3× 3 卷积层.则x1、x2、x3特征公式如下:

$\begin{array}{l} \boldsymbol{x}_{1}=g_{1}(\boldsymbol{x}), \\ \boldsymbol{x}_{2}=g_{2}\left(g_{1}(\boldsymbol{x})\right), \\ \boldsymbol{x}_{3}=g_{4}\left(g_{2}\left(g_{1}(\boldsymbol{x})\right)\right) . \end{array}$

这3个分支路径的特征图分别经过CBAM模块进行通道注意力和空间注意力计算, 则通道注意力输出特征为:

F'=MC(xi)⊗ xi,

空间注意力输出特征为:

F″=MS(F')⊗ F',

其中, xi表示第i个分支的特征图, MC(·)表示基于通道的注意力, MS(·)表示基于空间的注意力, ⊗ 表示逐元素相乘.

拼接3条路径的输出, 融合不同感受野的多尺度特征图, 最终输出特征为:

y=Concat(Conv1× 1(Concat(F″1, F″2, F″3)), Conv1× 1(x)),

其中, Concat(·)表示通道方向上的级联操作, Conv1× 1(·)表示1× 1卷积, F″n(n=1, 2, 3)表示第n个分支的输出特征.

为了评估STNDA的有效性, 选取ISIC(Interna-tional Skin Imaging Collaboration)发布的ISIC2017[30]、PH2[31]、ISIC2018[32]这3个公开可用的数据集.ISIC2017数据集包含3种皮肤疾病:黑色素瘤、脂溢性角化病和良性痣, 共2 750幅图像, 其中训练集2 000幅图像, 验证集150幅图像, 测试集600幅图像.整个样本集上每个样本大小为576× 767, 通过预处理将图像大小调整为256× 256.PH2数据集作为ISIC2017数据集的附加测试集, 包含200幅图像, 不参与网络训练过程.ISIC2018数据集包含7类皮肤疾病:光化性角化病、基底细胞癌、良性角化病、皮肤纤维瘤、黑色素瘤、黑色素细胞性痣和血管性皮肤病变, 训练集2 594幅图像, 验证集100幅图像, 测试集1 000幅图像.对3个数据集上的训练集进行翻转、调整对比度和亮度操作以增强数据.

在Ubuntu22.04.3 LTS操作系统上进行实验, CPU为13th Gen Intel® CoreTM i9-13900K, GPU为NVIDIA GeForce RTX 4090, 内存为16 GB RAM.深度学习框架为PyTorch, 编程语言为Python 3.10.0.为了增强网络泛化能力, 在ISIC2017、ISIC2018数据集的训练集上进行数据增强, 包括平移± 25、缩放比例± 20%、旋转± 20°、50%概率执行水平翻转.3个数据集的输入图像尺寸标准化为256× 256.使用Adam(Adaptive Moment Estimation)优化器, 学习率设为0.01, 训练最大迭代次数设为100.

为了评估网络病灶分割性能, 依据文献[19], 选用4个定量评价指标:精确率(Precision)、召回率(Recall)、交并比(Intersection over Union, IoU)和F1分数(F1-Score, F1).各指标公式如下:

precision=

Recall=

IoU=

F1=2(

其中:TP表示真阳性, 代表病变区域内正确分割的像素数; FP表示假阳性, 代表病变区域内被错误分割的像素数; FN表示假阴性, 代表病变区域外被错误分割的像素数.

为了验证STNDA的性能, 选用如下6种现有主流皮肤病变分割网络作为对比网络:U-Net、MHor-UNet[14]、TrUNet[15]、PSP Net (Pyramid Scene Par-sing Network)[33]、DeepLabV3+[34]、HRNet (High-Resolution Net)[35].

各网络在ISIC2017、PH2数据集上的对比结果如表1所示, 表中黑体数字表示最优值.PH2数据集作为ISIC2017数据集的附加测试集, 测试网络泛化能力, 不参与网络训练过程.

| 表1 各网络在ISIC2017、PH2数据集上的性能对比 Table 1 Performance comparison of different networks on ISIC2017 and PH2 datasets % |

由表1可知, 在ISIC2017数据集上STNDA的4个指标值均达到最优.相比次优的DeepLabV3+, STNDA的精确率提升0.39%; 相比次优的TrUNet, STNDA的召回率提升0.89%, IoU值提升1.22%, F1提升2.65%.由此可见, STNDA引入滑动窗口多头自注意力机制与动态瓶颈, 有效解决针对皮肤病变特征提取不充分以及模型分割精度较低的问题, 能精准定位皮肤病变的位置和边界.

在PH2数据集上:相比次优的U-Net, STNDA的精确率提升1.14%; 相比次优的TrUNet, STNDA的IoU值提升0.63%.STNDA的F1值为91.12%, 这里的F1指标为精确率与召回率的综合评价, 虽然STNDA的召回率为93.77%, 与最优的TrUNet相差5.04%, 但高于U-Net、Deeplabv3+和MHorUNet, 由此得出STNDA仍存在病变整体形态与局部特征结合不充分的问题.STNDA在F1指标上为次优, F1指标受召回率的影响, 相比表现最优的TrUNet, STNDA的F1值仅相差0.25%.综合来说, STNDA虽然存在对部分皮肤病变漏检的问题, 但在多形态皮肤病变下能充分提取病变特征, 识别皮肤病变.

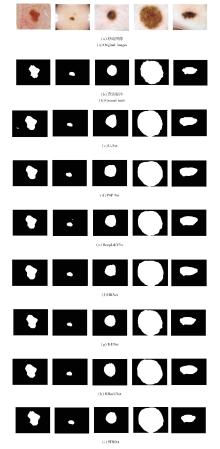

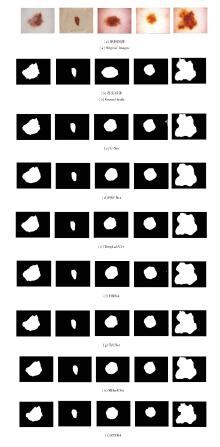

为了直观对比不同网络的分割效果, 将各网络在ISIC2017数据集上的分割结果进行可视化, 结果如图6所示, 其中PH2数据集作为独立的外部测试集, 仅通过定量指标验证网络泛化性.

由图6可知, STNDA在5个不同形态病变图像上能准确识别并分割皮肤病变, 分割边界清晰、完整, 而对比网络均存在边缘细节分割不精准的问题.在第1幅图像中, STNDA能精准分割病变轮廓中的不规则部分, 而其它网络分割结果边缘与标签过于平滑.由此可看出, STNDA使用基于Swin Transfor-mer V2模块的编码器捕捉多形态下皮肤病变的语义特征, 并通过基于多分支并行的MSDA融合模块捕捉图像的多尺度信息, 增强网络对边缘的感知能力.第1幅图像、第4幅图像和第5幅图像中皮肤病变与周围组织相似度较高, 其它网络分割时均存在病变区域与正常皮肤间边界界定不精准的问题, 导致分割定位偏差, 并存在将周围正常皮肤误检、使分割区域扩大的问题.STNDA通过DAB模块自适应调整局部感受野的关注焦点, 在高相似度皮肤组织干扰下完成皮肤病变分割的精准定位.因此, STNDA能以较高的精度分割皮肤病变边缘区域, 实现精确的病变定位和病变边界分割, 分割结果更接近真实皮肤病变区域.

STNDA在ISIC2017、PH2数据集上取得的良好分割效果表明, 基于CNN和Transformer结合的STNDA可充分发挥两者优势, 有效提取皮肤病变的局部细节特征, 并准确定位皮肤病变位置, 实现准确分割.

为了进一步测试STNDA的分割性能, 在ISIC-2018数据集上进行对比实验, 结果如表2所示, 表中黑体数字表示最优值.

| 表2 各网络在ISIC2018数据集上的性能对比 Table 2 Performance comparison of different networks on ISIC2018 dataset % |

由表2可知, STNDA在ISIC2018数据集上的4个指标值均排名靠前, 尽管在召回率上不是最优, 但在其他3个指标上均是最优.相比次优的TrUNet, STNDA的精确率提升1.42%, IoU值提升0.71%, F1值提升1.05%.STNDA的召回率为次优, 相比最优的HRNet, 仅相差0.08%, 由此表明STNDA分割效果仍受病变与周围组织相似性较高的问题干扰.总之, STNDA可有效解决分割精度较低的问题, 对边界特征较敏感, 能准确描绘目标区域.

为了更直观对比分割效果, 将各网络在ISIC- 2018数据集上的分割结果进行可视化, 结果如图7所示.

由图7可看出, STNDA在不同形态皮肤病分割上较精准, 边缘细节定位较具体, 其它网络均存在边缘分割过度平滑、分割区域不精准的问题.在第1幅图像、第2幅图像、第4幅图像中, 对比网络的分割边缘过于平滑, 未能准确定位皮肤病变边界, 而STNDA更接近标签.这表明STNDA使用多阶段架构与模块堆叠的主干网络及MSDA 融合模块, 可充分捕捉多形态下皮肤病变的语义特征, 提升对皮肤病变边缘细节的感知能力.第4幅图像和第5幅图像中皮肤病变与周围组织相似性较高, 其它网络分割时存在误检和病变边界模糊的问题, 导致分割定位偏差、分割区域扩大.STNDA的分割定位更准确且不存在误检.由此可见, STNDA通过DAB模块可动态调节局部感受野的关注焦点, 提升分割的精准定位能力.

综上所述, STNDA能以较高的精度分割皮肤病变边缘区域, 即使受病变与周围组织相似性较高的影响, 也能实现精确的病变定位和病变边界分割, 鲁棒性较强.

在ISIC2017、PH2、ISIC2018这3个皮肤病变数据集上, 定量与定性实验对比表明STNDA均能取得良好的分割效果.STNDA使用Swin Transformer V2编码器的U型结构, 增强对皮肤病变的语义特征提取能力, 聚焦于全局特征, 在其瓶颈处与跳跃连接处设计DAB模块与MSDA融合模块, 有效结合皮肤病变图像浅层病变边缘细节特征与深层丰富语义信息, 强化重要特征的表示, 并保留编码器初始图像信息, 提高对实际病变的识别能力.

STNDA主要包含3个核心模块:动态代理瓶颈(DAB)模块、多尺度空洞注意力(MSDA)融合模块、编码器与解码器.

为了验证上述3个核心模块对皮肤病分割结果的有效性, 在ISIC2017、PH2、ISIC2018数据集上, 基于基础模型U-Net添加各个模块, 进行消融实验.编码器通过其多阶段架构与模块堆叠操作, 并通过多尺度特征融合, 增强对多形态下皮肤病特征的提取能力.DAB模块由DAG模块根据输入特征的复杂程度自适应生成代理向量与位置偏置, 使网络自适应调整局部感受野的焦点, 有效结合病理图像浅层病理边缘细节特征与深层丰富语义信息, 解决因皮肤病变与周围组织相似导致的定位偏差问题.MSDA融合模块通过多分支并行的多尺度特征提取架构, 捕捉图像的多尺度信息, 增强网络对皮肤病变边缘的感知能力.

在3个数据集上的消融实验结果如表3~表5所示.由表可知, 相比U-Net, 加入编码器与解码器、DAB模块和MSDA融合模块后, 指标值均有效提升, 当3个模块结合使用时, 获得最佳的提升效果.这一结果表明, 3个核心模块之间存在相互增益的关系, 可增强在多形态皮肤病变特征上的提取能力和边缘感知能力以及皮肤病变上的定位能力, 能有效结合皮肤病变图像浅层病变边缘细节特征与深层丰富语义信息, 提升对皮肤病变的分割准确率.

| 表3 各网络在ISIC2017数据集上的消融实验结果 Table 3 Ablation experiment results of different networks on ISIC2017 dataset % |

| 表4 各网络在PH2数据集上的消融实验结果 Table 4 Ablation experiment results of different networks on PH2 dataset % |

| 表5 各网络在ISIC2018数据集上的消融实验结果 Table 5 Ablation experiment results of different networks on ISIC2018 dataset % |

针对现有网络在皮肤病变分割时因病变形态多样、与周围组织相似性较高、边界模糊等因素导致的皮肤病变特征提取不充分和分割精度较低等问题, 提出基于动态代理瓶颈与多尺度空洞注意力的Swin Transformer皮肤病分割网络(STNDA).首先, 构建基于Swin Transformer V2的骨干网络, 融合多尺度特征, 增强对多形态下皮肤病变特征的提取能力.然后, 设计动态代理瓶颈(DAB)模块, 解决网络在皮肤病变与周围组织相似性较高的影响下导致的分割定位偏差问题.最后, 在跳跃连接处设计多尺度空洞注意力(MSDA)融合模块, 提高对病变边缘的敏感性.在ISIC2017、PH2、ISIC2018数据集上的对比实验表明, STNDA在多项指标上表现较优, 同时相比Swin Transformer, 分割效果提升明显, 由此说明STNDA的有效性.今后将考虑减少参数和对网络进行轻量化处理, 在保持网络性能的同时, 降低复杂度, 实现性能与参数规模之间的最佳平衡.

本文责任编委 兰旭光

Recommended by Associate Editor LAN Xuguang

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|