通讯作者:

马 昕,博士,教授,主要研究方向为人工智能、机器视觉、移动机器人.E-mail:maxin@sdu.edu.cn.

马 昕,博士,教授,主要研究方向为人工智能、机器视觉、移动机器人.E-mail:maxin@sdu.edu.cn.

作者简介:

李政源,硕士研究生,主要研究方向为视觉感知.E-mail:lizhengyuan@mail.sdu.edu.cn.

李政源,硕士研究生,主要研究方向为视觉感知.E-mail:lizhengyuan@mail.sdu.edu.cn.

李贻斌,博士,教授,主要研究方向为机器人学、智能控制理论.E-mail:liyb@sdu.edu.cn.

李贻斌,博士,教授,主要研究方向为机器人学、智能控制理论.E-mail:liyb@sdu.edu.cn.

现有基于双目立体视觉的测量方法的测量精度依赖于标定精度,在受遮挡时测量精度不高.文中首先分析并证明在双目立体视觉系统外部参数误差存在时,投影曲线上点的立体匹配误差对点的重建精度的影响.然后基于此误差分析结论,设计立体视觉空间圆位姿测量方法,通过轮廓点筛选算法筛选投影曲线上的点,得到匹配误差较小的点并进行重建.利用重建点在深度方向上对非线性优化得到最优投影平面的投影,对空间圆进行拟合,得到空间圆的位置姿态.文中方法有效减小三维点重建误差对空间圆拟合精度的影响,提高圆形特征在受遮挡情况下的测量精度.最后通过实验验证方法的有效性.

Corresponding author:MA Xin, Ph.D., professor. Her research interests include artificial intelligence, machine vision and mobile robots.

About the Author:LI Zhengyuan, master student. His research interests include visual perception.

LI Yibin, Ph.D., professor. His research interests include robotics and intelligent control theories.

The accuracy of the existing measurement method based on binocular stereo vision depends on the accuracy of calibration, and the accuracy of measurement decreases when the spatial circle is occluded. Firstly, the reconstruction accuracy of point affected by the stereo matching error of points on projection curves is analyzed in the presence of external parameter error of the binocular stereo vision system. Then, based on the conclusion of error analysis, a new method for measuring the position and orientation of spatial circle is designed. Using the edge points selecting algorithm, the points of projection curves are selected. The circle is then reconstructed using the points with small stereo matching error. The projection of the reconstructive points on the optimal projection plane based on nonlinear optimization in the direction depth is utilized for fitting spatial circle to obtain the position and orientation. Experimental results prove the effectiveness of the proposed algorithm.

空间中的圆在工业生产环境中大量存在[1, 2, 3], 如工件上的圆形安装孔、螺栓孔等.在工业现场, 机器人需要完成大量的装配工作, 如安装螺栓、汽车轮胎的自动夹装.除上述工业环境中的应用, 关于空间圆形特征的视觉定位算法在无人系统的导航和定位中也有大量的应用[4].空间圆的位置和姿态的测量是机器视觉方向的一个重要问题[5].

一般来说, 空间圆位姿的测量方法可分为两类:1)基于结构光传感器的主动测量方法, 通过结构光传感器和相机组建立体视觉系统[6, 7, 8]; 2)基于双目立体视觉系统的被动测量方法, 利用两个相机组建立体视觉系[9, 10, 11, 12, 13, 14, 15, 16, 17, 18].相比主动测量方法[9], 被动测量方法的测量速度更快[10].相比结构光传感器, 相机的体积更小, 重量更轻, 造价更低.在工业现场中, 工业机器人的承载能力有限, 双目视觉系统的优势更突出.

目前, 基于双目立体视觉系统的空间圆位姿测量方法可分为3种.

1)基于代数射影几何的方法, 通过投影与曲面之间的几何约束, 得到空间圆位姿的闭式解.Safaee-Rad等[11]利用二次曲面的射影性质, 给出二次曲线的全局匹配和重建算法, 通过求解高阶多项式方程得到空间圆的位姿.Quan[12]基于空间圆是两视图中的二次曲线确定的二次曲面的交线的性质, 给出更简单的位姿计算方法, 可以判断两个视角中二次曲线的对应关系.Xu等[13]也通过类似的方法实现空间圆位姿的测量.此类方法具有非常严谨的数学推理, 在理想的状态下测量精度较高.但是在实际应用中, 不可避免产生图像噪声、边缘提取误差、相机标定误差, 计算方法复杂, 矩阵之间的运算导致误差进一步扩大.上述原因可能会导致测量值不精确, 甚至得不到有效解.

2)基于计算机辅助设计(Computer Aided Design, CAD)模型的先验信息和双目立体视觉系统相结合的方法, 可以准确提取孔边缘, 减少边缘提取误差, 得到更精确的测量结果[14].Malassiotis 等[15]设计基于CAD模型的汽车零件自动检测算法, 依靠双目立体视觉传感器和先验知识, 解决空间中几何孔边缘提取问题和高精度测量问题, 对光线干扰具有较强的鲁棒性.但是, 此类方法十分依赖孔的CAD模型, 在几何孔被遮挡时, 很难检测到部分孔被遮挡的情况.

3)利用双目立体视觉系统求出空间圆边缘点的三维空间坐标, 并利用三维坐标信息拟合空间圆, 求取空间圆的位姿.文献[16] 、文献[17] 设计空间圆最优拟合方法, 将拟合误差分为两部分:重建点到空间圆平面的距离, 以及重建点到拟合圆心的距离与拟合半径的差为拟合误差, 两者之和最小时得到空间圆的最优拟合结果.Chen等[18] 设计利用新的非切线约束的方法, 提高椭圆上点的立体匹配精度和空间圆位姿的测量精度.相比代数射影几何方法及基于CAD模型的先验信息和双目立体视觉系统结合的方法, 此类方法不需要过多的先验信息, 计算过程简单, 测量精度较高.但是, 当空间圆部分轮廓受遮挡时, 由于相机外参标定误差的必然存在, 重建得到的边缘点在深度方向上的误差会随匹配误差的增大而迅速增大, 大幅影响算法的测量精度.

针对上述问题, 本文分析椭圆边缘的立体匹配误差的变化规律和此误差对边缘重建精度的影响, 设计基于最优投影平面的空间圆位姿测量算法.首先设计可以反映最优投影平面位置的误差函数, 利用重建得到的空间圆边缘三维点在深度方向上对最优投影平面的投影, 减小双目立体视觉系统外部参数误差的影响.然后设计轮廓点筛选方法, 通过对轮廓点所在曲线的斜率筛选轮廓点, 可筛除重建误差较大的无参考意义的边缘点, 利用筛选后的边缘点对空间圆进行拟合, 有效提高测量精度.最后通过实验证明本文算法在空间圆受遮挡时仍具有较高的位姿测量精度.

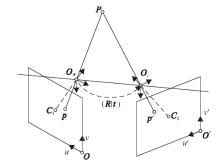

2个相机组成的双目立体视觉系统的模型和相应的空间三维点投影关系如图1所示[19].设世界坐标系为OWXWYWZW, 与左相机坐标系重合.左图像坐标系为Ouv, 焦距为f1.右相机坐标系为OrXrYrZr, 图像坐标系为O'u'v', 焦距为f2.通过对双目立体视觉系统的标定, 可得到两相机内部参数矩阵:

A1=

其中, dX1、dY1为左相机像元的物理尺寸, dX2、dY2为右相机像元的物理尺寸, (u0, v0)、(u'0, v'0)分别为左右相机图像平面上的主点坐标.

同时得到外部参数矩阵:旋转矩阵R和平移向量t.

如图1所示, 设空间中视野内有一点

P=

在左、右两相机图像平面上的投影分别为

p=

两者的关系可表示为

λ 1

λ 2

其中λ 1、λ 2为尺度因子.

在已知双目立体视觉系统内外参数和空间点在左右图像中对应的图像坐标的条件下, 通过式(1)和式(2)可以解得该点空间坐标.

通过左右图像中点的投影恢复空间中点的实际位置, 必须对左右视图上的图像点进行立体匹配.一般来说, 立体重构算法分为密集型重构算法和特征型重构算法[20].密集型重构算法对两幅图像中的所有匹配点进行重构, 一般使用基于区域的匹配方法, 在参考图像中某像素点的周围给定一个特定大小的区域, 依据一定的相似性判断准则, 在待匹配图像中寻找与参考区域最相似的子区域.该子区域对应的像素点即为对应的匹配点, 但算法对低纹理区域和重复纹理区域的匹配效果并不理想.特征型重构算法只重构某些特征的空间位置, 通过边缘检测算法对图像中的椭圆边缘进行提取和筛选, 仅对筛选的边缘进行立体匹配和重构, 可满足空间圆位姿测量的实际需要.

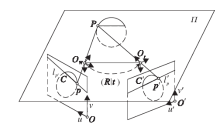

具体匹配方法如图2所示, 空间中有一圆形, 投影到左、右两图像上, 通过轮廓提取算法提取和筛选图像上的椭圆轮廓, 得到两图像上的椭圆轮廓C和C'.假设左图椭圆轮廓上存在一个像点p, 通过已知的相机内外参数可以得到极平面Π 的位置, 极平面Π 与右图像平面交于极线l'p, 极线l'p与右图椭圆轮廓相交, 根据顺序一致性约束可以得到像点p在右图上的匹配点p'.通过极线约束的特征型重构算法对左、右图像椭圆轮廓上的像点进行立体匹配, 重构空间圆边缘点的空间位置P.立体匹配算法降低匹配算法的复杂性, 提高匹配速度.相比密集型重构算法, 大幅减少匹配点的数量, 提高算法效率.

在实际应用中, 由于双目立体视觉系统外部参数误差的存在, 导致使用极线约束对椭圆轮廓进行立体匹配时, 产生立体匹配误差, 影响空间圆边缘点的重建精度, 从而影响空间圆的拟合精度.为了进一步提高空间圆位姿测量的精度, 在双目立体视觉系统外部参数误差存在时, 分析空间圆边缘重建产生的影响.

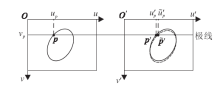

双目视觉系统经过标定之后, 为了方便进行立体匹配, 通常进行图像校正[21].经过图像校正, 可以将一般的双目模型转化到一个理想的模型, 即像平面在同一平面, 且光轴与像平面垂直, 两视图的极线相互平行.并且当空间中的一点投影到两像平面时, 两点像素在同一行, 一般称此时的两相机共面行对准.如图3所示, 在理想状态下, 空间圆在图像平面上的投影为两实线椭圆, 两视图椭圆上的点一一对应, 通过计算匹配点的视差可以得到该点的深度信息.但由于外部参数误差, 经过图像校正后, 空间中一点在两图像平面上的投影并不一定在同一行, 这使曲线上的点通过极限约束进行立体匹配时, 会产生立体匹配误差.

为了方便误差的分析, 假设两相机内部参数均不存在误差, 并且外部参数误差只对左图中曲线的位置产生影响, 如图3所示, 图中实线椭圆为理想条件下的空间圆投影, 通常在双目立体视觉系统外部参数误差存在时, 校正后的图像会产生某个方向的偏移和轻微变形, 这里将变形忽略.如图4所示.

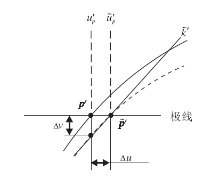

设图像发生某个方向上的偏移, 将偏移分解为横纵两个方向, 纵向偏移量为Δ v, 方向向下, 图中实曲线为理想外参数据下校正得到的边缘曲线投影, 虚曲线为实际校正后得到的边缘曲线投影, 极线与理想边缘曲线和实际边缘曲线分别交于点p'(v'p, u'p)和点

定理1 在双目立体视觉系统中, 通过极线约束对曲线上的点进行立体匹配时, 随着图像上曲线的斜率

证明 由图3所示, 点p的实际视差

视差的误差为Δ u.

由图4可知, 将斜率

其中Δ v为定值.则由上式可知, Δ u与

如图5所示, 两相机为共面行对准, 焦距为f, 坐标系位置与前文所述一致.设空间中有一点

P=

在左右摄像机图像平面上的投影分别为点p(up, vp)、 p'(v'p, u'p).

定理2 点的立体匹配误差越大, 重建的三维点坐标误差就会越大, 并且该点Z坐标的误差大于X和Y坐标的误差.

证明 假设左右相机经过标定, 焦距f、基线长度b已知, 且不存在误差, 则由三角形的相似性可得到P点的坐标为

Z=h=

X=

其中, dp=u'p-up为视差.

由2.1节可知, 在双目立体视觉系统外参误差存在时, 通过极线约束对图像上曲线进行立体匹配, 容易产生视差的误差Δ u, 即易匹配到点.如图5所示, 此时点P的Z坐标误差为

Δ Z=Z-

其中

根据式(3)、式(5)、式(6)可得,

Δ Z=Z-

由式(7)可知, 点P的Z坐标误差Δ Z与点P的深度的平方成正比, 空间点的距离越远, 空间点的深度误差越大.类似地, 基线长度和相机焦距越大, 空间点的深度误差越小.

根据几何知识和式(4)、式(7), 点P的X坐标误差为

Δ X=

不失一般性, 在实际场景中, X总是小于Z, 故由式(7)、式(8)可知, Δ X小于Δ Z.

类似地, 点P的Y坐标误差为

Δ Y=

同理, 在实际场景中, Y总是小于Z, 故由式(7)、式(9)可知, Δ Y小于Δ Z.

由式(7)~式(9)可知, 图像上点的立体匹配误差越大, 重建得到的三维点坐标误差就会越大, 并且该点Z坐标的误差要大于X、Y坐标的误差.

通过上述证明, 可知在常见的双目测量方法中, 通过极线约束对图像上曲线上的点进行立体匹配时, 点所在的曲线的斜率越小, 立体匹配的误差越大, 所得三维点坐标重建精度越低, 特别是Z坐标的重建精度, 低于X、Y坐标.

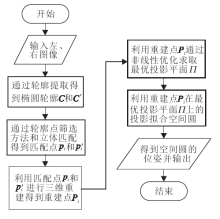

在双目立体视觉系统的外参误差必然存在的情况下, 重建得到的边缘点的Z坐标误差是影响空间圆拟合精度的关键.为了减小Z坐标误差对拟合精度的影响, 本文提出基于最优投影平面的空间圆位姿测量算法.图6为本文算法的流程图.

使用Canny边缘提取算法[22]对左、右视图中的圆形特征进行边缘检测, 利用轮廓曲率和长度等性质筛选视图中的轮廓, 筛除不是椭圆形的边缘, 通过文献[12]中的椭圆轮廓匹配算法, 可以得到两视图中来自于同一空间圆映射的两椭圆轮廓C和C'.

通过本文设计的轮廓点筛选方法, 筛选提取的图像中的椭圆轮廓.筛选后的椭圆轮廓通过极线约束建立左右图像轮廓上点的对应匹配关系, 根据三角法计算每个点的三维坐标.

由第2节分析可知, 随着曲线C在轮廓点pi处的斜率降低, 重建得到的边缘点Pi在Z方向的坐标误差Δ Z大幅增加, 与之同时, 边缘点Pi在X、Y方向的坐标误差Δ X和Δ Y也随之增加.通过筛选轮廓点可以避免重建误差较大的边缘点参与空间圆的拟合, 在提高测量精度的同时, 也减少点的重建数量, 提高计算效率.

本文提出立体轮廓点的筛选方法, 以左视图提取得到的曲线C'在轮廓点p'i处的斜率大小k'p'作为筛选条件, 可以筛除重建误差较大的无参考意义的边缘点, 留下重建精度较高的边缘点.首先对曲线C'进行求导, 得到曲线上各点的斜率k'p, 然后设定阈值K, 只有当|k'p|> K时才允许右图上的点与该点进行立体匹配.本文方法可以将边缘点的重建误差限制在某一范围内, 经过大量实验, 当阈值K=3时, 既能保证边缘点的数量不至于太少, 又能保证边缘点的重建误差不至于太大.

设通过轮廓点筛选方法得到的左图像上的点为p'j, 基于1.2节方法, 利用极线约束进行立体匹配, 可以得到右图像上与p'j相对应的匹配点pj.之后利用三角法[23]对立体匹配得到的匹配点进行三维重建, 得到空间圆上的部分点Pj的三维坐标.

设空间圆的圆心坐标为OC=

n· (ξ -OC)=0, (10)

其中, n为平面Π 的单位法向量, ξ =

对于空间圆上任意一点Xi=(xi, yi, zi), 满足如下条件:

且满足式(10).令重建后得到的边缘点为Pi(i=1, 2, …, n), 由2.2节分析可知, 当图像中曲线斜率变小时, Pi在Z方向的坐标误差显著增大.假设Pi在Z方向的误差Δ Z远大于其在X、Y方向的误差Δ X、Δ Y, 那么, 可将Δ X、Δ Y忽略, 即

Δ X≈ 0, Δ Y≈ 0, Δ Z≫0.

由于Δ Z≫0, 导致本应在平面Π 上的点Pi脱离平面Π .通过点Pi在Z方向上对平面Π 进行投影, 得到投影点P'i.P'i的X、Y坐标近似于真实值, P'i在平面Π 上, 即此时投影点P'i的Z方向的误差Δ Z'最小.

设点P'i在平面Π 上的圆形拟合误差表示为

ε =

由上述可知, 点P'i在平面Π 上的圆形拟合误差约等于0.

综上所述, 当边缘点Pi的X、Y方向的误差可以忽略时, 点Pi在深度方向对平面Π 的投影P'i的圆形拟合误差最小.将平面Π 称为最优投影平面, 根据这一特性, 本文设计求取最优投影平面的计算方法, 具体过程如下.

1)选择一个初始平面Π 0, 该平面的法向量为n0.

2)将得到的三维点Pi=

P'i=

3)通过三维点P'i在平面Π 0上拟合平面圆C0, 得到C0的圆心O0=(

4)计算误差函数

ε 0=

5)通过L-M非线性优化方法, 求得最优投影平面Π .

算法的关键在于初值选取, 本文利用筛选得到空间圆重建点, 使用最小二乘法拟合空间平面的法向量作为初值平面Π 0的法向量, 并计算右图曲线上斜率最大的轮廓点.利用该点的三维重建精度最高的特点, 使Π 0始终通过该像点重建得到的边缘点.实验验证表明, 这种初值选择方法是合理的, 可以迅速收敛到最优值.

通过3.3节中分析可知, 将空间点Pi在Z方向上对平面Π 进行投影, 得到投影点P'i.P'i的X、Y坐标近似于真实值, 且点P'i的Z方向的误差Δ Z'最小.所以此时通过投影P'i对空间圆进行拟合, 得到空间圆的几何参数的误差也最小.将三维点P'i转化成平面Π 上的二维点, 利用最小二乘法对圆形进行拟合, 得到空间圆的半径和圆心, 将二维平面上的圆心转化为三维空间中的点, 即可得到空间圆圆心的三维位置, 圆面的法向量为最优投影平面Π 的法向量.

为了验证双目立体视觉系统外参误差对空间圆边缘重建精度产生的影响和算法的有效性, 下面开展一系列的仿真实验和真实实验.

利用计算机生成一个共面行对准的双目立体视觉系统和空间圆, 其中, 世界坐标系与左相机坐标系重合, 右相机的光心在世界坐标系中的坐标为(0.5, 0, 0), 两相机内部参数相同, 内参矩阵为

A=

外部参数为

R=

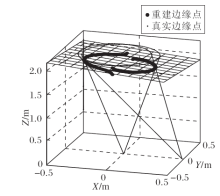

首先通过此模型验证本文误差分析的正确性.设有一空间圆半径r=0.3 m, 圆心位于OC=

图8为重建边缘点Pi的误差与图像上曲线在对应点p'i 的倾角的关系.由图可以发现, 在匹配点所在位置曲线的倾角接近90° (即曲线的斜率变大)时, 重建边缘点的各方向坐标误差Δ X、Δ Y和Δ Z逐渐趋近于0.在匹配点所在位置曲线的倾角接近0° 或180° (即曲线斜率变小)时, Δ X、Δ Y和Δ Z迅速变大, 且误差Δ Z大于Δ X、Δ Y.此次实验结果不失一般性, 多次实验结果均与第2节所分析的重建误差变化规律结论基本一致.

| 图8 重建边缘点Pi的误差与图像上曲线在对应点p’i 的倾角的关系Fig.8 The relationship between the error of point Pi and the angle of inclination |

为了验证算法的有效性, 通过空间圆位姿测量的仿真实验检验算法的有效性.在同样的环境配置下, 将空间圆位姿测量实验分为受遮挡时和不受遮挡时两组.通过最小二乘法拟合空间圆、文献[13]算法与本文算法进行对比, 对比测量值与真实值, 得到空间圆的圆心位置误差、半径误差和圆面法向量角度误差.每组进行20次实验, 计算误差的均值.

表1和表2分别给出空间圆不受遮挡和受遮挡时的实验结果.从表1可以看出, 本文算法在空间圆不受遮挡时, 虽然法向量精度提升效果不明显, 但圆形位置测量精度和半径测量精度明显优于其它对比算法.当空间圆受遮挡时, 3种算法的测量精度均有所下降, 而本文算法仍能得到较高的测量精度.

| 表1 仿真环境下不受遮挡时空间圆的实验结果 Table 1 Experimental results of the spatial circle without occlusion in simulation environment |

| 表2 受遮挡时空间圆的实验结果 Table 2 Experimental results of the spatial circle with occlusion |

为了验证本文算法的有效性, 采用两台型号为MER-200-14GC的CCD相机和两个焦距为16 mm的镜头组成一个双目立体视觉系统, 对距离为2 m左右、直径为80 cm的汽车轮胎轮毂进行测量.图9为实验场景.

在同样的实验环境下, 分为轮毂受遮挡时和不受着遮挡时两组实验.通过最小二乘法拟合空间圆、文献[13]算法与本文算法进行对比.对轮毂的中心在图像中的像点进行三维重建, 得到的坐标为轮毂圆心的真实值, 与轮毂面重合的标定板的法向量为轮毂法向量的真实值, 通过与真实值对比得到轮毂的圆心位置相对误差、半径误差和圆面法向量角度误差.每组20次实验, 计算误差的均值.表3和表4列出实验结果.

| 表3 真实环境下轮毂不受遮挡时的实验结果 Table 3 Experimental results of the hub without occlusion in real environment |

| 表4 真实环境下轮毂受遮挡时的实验结果 Table 4 Experimental results of the hub with occlusion in real environment |

实验表明, 在真实实验中, 由于相机内部参数的标定(如焦距和畸变系数等)误差的存在, 以及轮毂边缘的提取存在偏差, 相比仿真实验, 本文算法的精度略有下降.在轮毂不受遮挡时, 本文算法的精度明显高于最小二乘法和文献[13]算法.在轮毂受到遮挡时, 其它两种方法的精度均产生下降, 而本文算法仍能得到较高的测量精度.

本文提出基于最优投影平面的立体视觉空间圆位姿测量算法, 通过对提取的椭圆轮廓点进行筛选, 获得立体匹配精度较高的匹配点, 经过三维重建后使用三维点在最优投影平面上的投影对空间圆进行拟合.相比其它测量方法, 本文方法考虑双目立体系统外部参数标定误差对轮廓点重建精度的影响, 在空间圆受遮挡或不受遮挡时, 测量精度更优.未来将看重于本文算法应用到实际工厂环境中, 并进一步检验算法有效性.

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|